Per un dialogo corretto fra scienza e decisori politici: no ai convegni sul clima senza climatologi

Nonostante l’ormai schiacciante evidenza scientifica sulla rilevanza del problema dei cambiamenti climatici e sulle responsabilità umane e senza curarsi del fecondo e aperto dibattito che anima ormai da tempo le migliori università di tutto il mondo, fra cui Stanford, Princeton e Berkeley, su costi e benefici della lotta contro i cambiamenti climatici, in Italia continuano a fiorire le occasioni pubbliche e gli articoli della stampa con cui si cerca di mettere in discussione l’esistenza del riscaldamento del pianeta, il ruolo delle attività umane o la convenienza di azioni di mitigazione.

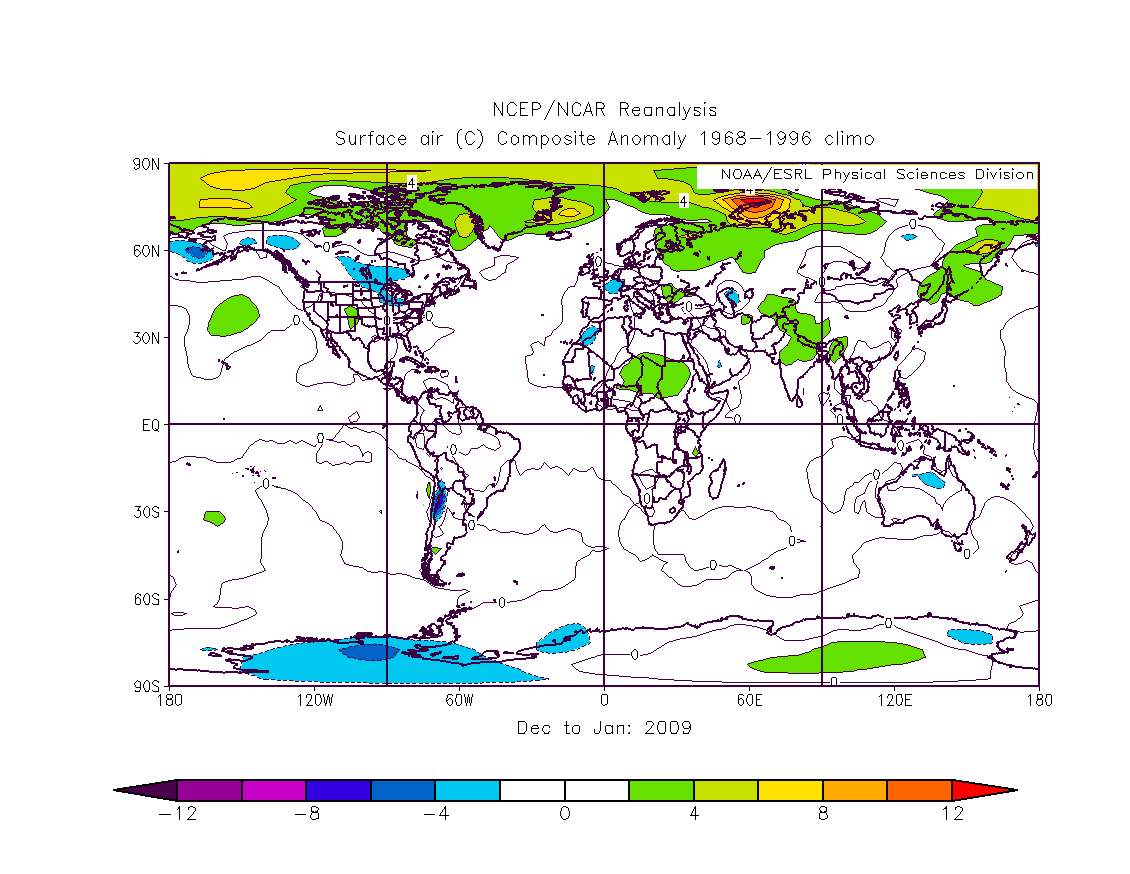

Ultima in ordine di tempo è stata la notizia (falsa), apparsa a gennaio su molti quotidiani nazionali, di una fase di forte espansione della calotta polare e dei ghiacci alpini. Nonostante l’inconsistenza di queste notizie emerga di solito dopo pochi giorni, preoccupa come queste false informazioni, così come altre posizioni non supportate da dati oggettivi e credibili, arrivino ad essere veicolate ai rappresentanti politici nazionali come se fossero la “verità scientifica” sul clima.

Sono questi i contorni dell’incontro che si terrà il 3 marzo a Roma ed al quale parteciperanno in una tavola rotonda i Presidenti ed importanti rappresentanti delle Commissioni Ambiente di Camera e Senato.

È curioso che il panel di relatori chiamati a intervenire nella “sessione scientifica” non includa veri esperti della tematica climatica ma sia caratterizzato da una assoluta e ampiamente documentata faziosità e ostinazione nel negare sistematicamente, contro ogni evidenza scientifica, l’esistenza dei cambiamenti climatici e la loro rilevante componente antropica.

Con una strategia ormai largamente sperimentata, fra i relatori, che si alterneranno nell’incontro organizzato a Roma, sono presenti sì scienziati e docenti universitari ma tutti fondamentalmente privi di una specifica competenza scientifica sulla materia dei cambiamenti climatici: come se non bastasse, salvo alcune eccezioni, i professori e gli scienziati del convegno di Roma sono sostanzialmente privi di pubblicazioni su riviste scientifiche internazionali non solo sulle tematiche climatiche ma più in generale su quelle ambientali. In quanto tali risultano niente di più che semplici opinionisti, non più autorevoli di un climatologo che pontifica sullo stato di risanamento dei conti pubblici italiani o sulla cura migliore del tumore al cervello.

Spicca, invece, l’assoluta mancanza di contraddittorio e di rappresentanza di quei pur numerosi climatologi italiani (come Filippo Giorgi, Antonio Navarra e molti altri ancora) che si sono guadagnati con serietà, dedizione e impegno, un ruolo di rilievo nella comunità scientifica internazionale e che contano decine di pubblicazioni scientifiche anche di grande importanza sul tema, nonché la collaborazione proprio con quell’IPCC del quale ora, in questo incontro, si vuole minare la credibilità.

Il documento a supporto delle tesi negazioniste, che sarà presentato come punto centrale del tavolo del 3 marzo a Roma (“La natura, non l’attività dell’uomo, governa il clima”), è già stato stroncato dalla comunità scientifica di tutto il mondo. Questo perché propone tesi non sostenute da dati affidabili ed in secondo luogo perché è stato creato con la collaborazione di scienziati non specializzati nello studio dei cambiamenti climatici.

La stroncatura del documento è da mesi disponibile su Realclimate, uno dei blog internazionali più autorevoli sulle tematiche climatiche, la cui traduzione è disponibile da dicembre sul sito Climalteranti.it. Il rapporto succitato ha otto capitoli; cinque di questi hanno titoli che sono semplicemente falsi. I rimanenti tre capitoli pongono domande fuorvianti e in malafede, se non semplicemente disoneste, cui gli autori forniscono “risposte” basate su una letteratura scadente e selezionata in modo da evitare accuratamente tutte le pubblicazioni successive che contraddicono le tesi precostituite.

Il rapporto è stato pubblicato dall’Heartland Institute, una nota organizzazione politica di stampo negazionista che in passato ha ricevuto finanziamenti dalle compagnie petrolifere, per il NIPCC (Nongovernmental International Panel on Climate Change), una sigla che richiama in modo ingannevole il panel scientifico dell’ONU e sembra essere stata creata proprio per generare confusione nell’opinione pubblica. L’NIPCC, lungi dall’essere connesso ad alcun progetto delle Nazioni Unite, è stato invece istituito includendo scienziati di scarsa competenza sulle tematiche climatiche. Nella stesura di questo rapporto non è stato previsto alcun processo di controllo e di verifica da parte del resto della comunità scientifica. Da notare che decine di scienziati inseriti nell’elenco degli estensori del rapporto hanno negato la loro partecipazione a questo gruppo e hanno espresso tesi opposte a quelle sostenute nel volume.

L’unico italiano presente nell’NIPCC, che illustrerà il volume nel convegno del 3 marzo, è un docente universitario, il Prof. Franco Battaglia, già vincitore del Premio “A qualcuno piace caldo 2007” . Costui non ha al suo attivo alcuna pubblicazione scientifica ISI (quelle riconosciute a livello internazionale) non solo nel settore delle climatologia, ma anche più in generale in quello ambientale; autore di alcune pubblicazioni di fisica-chimica teorica di scarsa rilevanza, è conosciuto solo come autore di articoli su un quotidiano nazionale, di nessun valore scientifico.

L’unico relatore indicato come “climatologo”, Guido Guidi, non è uno scienziato impegnato in ricerche sui cambiamenti climatici, bensì un maggiore dell’Aeronautica militare che si occupa di previsioni del tempo a medio termine. Guidi pubblica su un blog tesi spesso senza fondamento scientifico sul tema dei cambiamenti climatici (ad esempio, l’ultimo granchio preso si trova qui).

Come cittadini italiani e ricercatori impegnati a divulgare in modo corretto la problematica dei cambiamenti climatici intendiamo ribadire quanto segue:

• Il documento scientifico che sarà presentato nel convegno di Roma del 3 marzo nei locali della Camera dei Deputati è privo di fondamento scientifico ed è stato elaborato in modo fazioso e non trasparente;

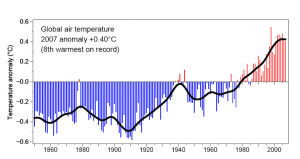

• I dati scientifici disponibili a livello internazionale sono incontrovertibili nell’individuare un preoccupante riscaldamento del pianeta e nel riconoscere in questo un ruolo centrale dell’uomo;

• Il dibattito scientifico sui cambiamenti climatici deve restare un dibattito aperto, e non deve essere portato avanti senza il coinvolgimento di chi davvero studia davvero la climatologia e si confronta in ambito scientifico a livello internazionale;

• È grave presentare al mondo politico italiano uno spaccato non rappresentativo, anzi distorto, di quello che pensa la comunità scientifica su questi temi, quando invece la comunità scientifica internazionale è fondamentalmente unanime sulla valutazione delle cause (antropiche) come sull’entità del problema e sulla necessità di intraprendere rapidamente delle drastiche misure correttive per la riduzione dei gas climalteranti.

Il Comitato Editoriale di Climalteranti.it