Il 3 marzo scorso si è svolto a Roma il convegno “Cambiamenti climatici e ambiente politico”, presentato nello scorso post a cui è seguito un acceso dibattito. Il dibattito è stato vivace anche nel blog di Antonello Pasini a seguito di un interessante e condivisibile post.

Ci sarà tutto il tempo per entrare nel merito delle tesi negazioniste riproposte anche in questa occasione romana.

Per iniziare segnaliamo l’audio dell’intervento introduttivo del Presidente della sessione scientifica, il Prof. Antonino Zichichi, che abbiamo trovato su YouTube.

Si tratta di 5 parti (link a ogni parte: Parte 1, Parte 2, Parte 3, Parte 4, Parte 5) di circa 5 minuti ognuna.

L’ascolto è divertente, e pur se alcune assurdità e frottole sono già state raccontate dallo stesso Zichichi, altre sono effettivamente originali.

Non ci sembra il caso di fare commenti se non fornire due informazioni.

La prima è che abbiamo verificato che non si tratta di una delle imitazioni del Prof. Zichichi da parte del comico Maurizio Crozza (esempio), ma proprio dell’intervento originale.

La seconda è che l’intervento è stato applaudito e nessuno dei successivi relatori ha avanzato alcuna perplessità o critica; se ne deduce che l’intervento è stato proprio preso sul serio (come si può leggere qui e qui).

Per invogliare all’ascolto abbiamo estratto alcune frasi, che di diritto vanno ad aggiungersi al catalogo delle “Zichicche” e che riproponiamo qui di seguito:

Parte 1:inizio

Grazie Presidente, io sono molto lieto di essere qui in quanto viviamo un momento che passerà nella storia del mondo: tra 2 o 3 secoli scriveranno di noi. E’ la prima volta che argomenti di natura non scientifica vengono portati come previsioni scientifiche…

Parte 1: min. 3.58

Se fosse vero quello che dicono gli specialisti dell’IPCC, io dovrei dire “Non c’e’ bisogno di fare esperimenti, sappiamo tutto, esiste il supermondo e vi spiego perché… ”

Parte 1: min. 4.24

…e infatti potrebbe darsi che al Centro Europeo di Ginevra, contrariamente a tutto quello che si dice, non venga scoperto il supermondo. E’ già successo 7 volte nella storia della scienza galileiana, l’ultima volta nel 1947, quando Enrico Fermi disse ai suoi collaboratori di Chicago: “Ragazzi forse – era molto prudente Fermi – abbiamo stavolta veramente capito tutto”.

Parte 2: min. 2.31

Questa matematica ha 2 punti di riferimento: uno è la nostra fisica, fondamentale , con la quale io sto lavorando al Cern, l’altro è invece la meteorologia.

Se noi siamo costretti a fare esperimenti per verificare se sono vere le nostre previsioni, come fanno questi signori a prevedere la fine del mondo, insomma, quasi… al punto da costringere tutti i capi di governo, incluso la più potente nazione del mondo, la più democratica e libera, gli Stati Uniti d’America, e il loro Presidente, a prendere decisioni che non sono corroborate da una struttura scientifica tale da permettere di prendere decisioni che costano miliardi di euro. Se noi scopriamo che non c’è il supermondo, questo non costa nulla alla società civile. Non c’è, e c’è un’altra cosa. Ma non abbiamo speso cento 200 3000 di miliardi di dollari, migliaia di miliardi di dollari di cui stiamo parlando. E questa è la parte matematica. Poi c’è la parte sperimentale…

Parte 3: min. 0.24

[Parlando della formazione delle nubi]… ancora oggi il fenomeno non è capito e nessuno può dire a me che lui lo sa, perché io lo incastro subito: non è vero. La NASA infatti ha lanciato 2 satelliti, adesso si chiama…[non comprensibile…] per studiare la formazione delle nuvole, come conseguenza di questo dibattito che la NASA prende seriamente. Quindi prima che l’uomo si mettesse in testa di capire come si formano le nuvole si fanno previsioni su che cosa? Sull’atmosfera!

Parte 3: min. 1.24

In un articolo di Geoscience è venuto fuori che è stato scoperto che la circolazione oceanica, io non voglio entrare in dettaglio sennò ci perdiamo, ma, l’oceano, grande quantità d’acqua, che ha quello che chiamano tapis roulant, un affare che circola e che va in superficie, a sud dell’oceano, e quindi sono acque calde. Queste acque calde, per circa 10 anni, salendo verso il nord si inabissavano, senza che nessuno ne capisse il motivo. Da dieci anni a questa parte questo inabissamento non è più avvenuto. Ecco perché la temperatura mostra segni di aumentare. Nell’ultimo inverno hanno ricominciato a precipitare dentro, ad riinabissarsi. Se questo fenomeno continua, vedete che il global warming sparisce, perché questo innalzamento di queste correnti oceaniche non è capito. Questo per dire un dettaglio dei numerosi dettagli…

Parte 3: min. 3.30

Nel motore atmosferico, qual è l’incidenza delle attività umane? E’ un tema sul quale si sono impegnate parecchie persone. Tra queste quello che io rispetto molto e’ Freeman Dayson, un grande fisico teorico, che è stato con noi in diverse occasioni. E non c’è bisogno di grandi dettagli, per scoprire che sul motore meteorologico, l’incidenza delle attività umane, è inferiore al 10%. Ma diciamo in 10, in verità è il 5-6%. E il 90 dove lo mettiamo? Io vado in banca: ho il 6 % delle azioni e comando sugli altri ?

Parte 4: min. 0.20

L’anidride carbonica non va demonizzata, è cibo per le piante, e l’effetto serra non va demonizzato. Questo è quanto Enrico Fermi chiamava Hiroshima culturale.

Parte 4: min. 2.10

L’alleanza tra scienza e forze politiche responsabili è l’unica via per uscire da questo stato di Hiroshima culturale. Siamo in piena Hiroshima culturale.

Parte 4: min. 2.40

L’IPCC è nata ad Erice, quanto era segretario generale della WMO, un nigeriano, che, per nostra fortuna era anche fisico, in gamba, professore al MIT. Ed io dissi a questo mio collega, ci conoscevamo come colleghi a Ginevra, visto che tu sei segretario generale, cerca di portare un po’ di scienza in questa attività, lui venne per 3 anni ad Erice e si entusiasmò del rigore che noi portiamo nei nostri seminari e mi invitò ad aprire il congresso mondiale della WMO, e in quella occasione, 1985…1986…, presentai dal punto di vista scientifico gli stessi argomenti di adesso… adesso sono aggiornati…

Parte 4: min. 3.52

Perché la scienza ha credibilità? Perché se dice…. come nasce la credibilità scientifica? Con Galileo e Newton, e la famosa cometa se non appariva come previsto da Newton, invece esplode l’interesse verso la scienza. La credibilità scientifica rischia di essere compromessa… ecco perché c’è bisogno di una forza politica responsabile.

Parte 4: min. 4.30

Quando si dice che ci sono 2500 scienziati del clima. Non è vero, non esistono 2500 scienziati del clima… infatti .. basta vedere i nomi di questi signori…

A cura di Stefano Caserini, Marina Vitullo, Daniele Pernigotti, Simone Casadei, Aldo Pozzoli, Cluadio Cassardo

È in corso di svolgimento a Ginevra il meeting IPCC che si concluderà il 9 agosto con il rilascio del 6° Rapporto del Primo Gruppo di lavoro, sulle basi fisiche del cambiamento climatico (Climate Change 2021: the Physical Science Basis).

È in corso di svolgimento a Ginevra il meeting IPCC che si concluderà il 9 agosto con il rilascio del 6° Rapporto del Primo Gruppo di lavoro, sulle basi fisiche del cambiamento climatico (Climate Change 2021: the Physical Science Basis). Portare ottimismo e positività nella lotta al cambiamento climatico e in generale ai diversi problemi ambientali può essere una cosa utile e benemerita. Il libro di Chicco Testa, “Elogio della crescita felice: contro l’integralismo ecologico” non raggiunge l’obiettivo, a causa di un’analisi superficiale e spesso supponente in cui il “serio riformismo ambientalista” si riduce ad una minimizzazione della gravità dei problemi stessi, in nome di una fiducia irrazionale nei poteri taumaturgici dell’innovazione tecnologica.

Portare ottimismo e positività nella lotta al cambiamento climatico e in generale ai diversi problemi ambientali può essere una cosa utile e benemerita. Il libro di Chicco Testa, “Elogio della crescita felice: contro l’integralismo ecologico” non raggiunge l’obiettivo, a causa di un’analisi superficiale e spesso supponente in cui il “serio riformismo ambientalista” si riduce ad una minimizzazione della gravità dei problemi stessi, in nome di una fiducia irrazionale nei poteri taumaturgici dell’innovazione tecnologica.

Il libro è la traduzione di un saggio di rara chiarezza e sintesi “Phaeton’s Reins. The human hand in climate change “, pubblicato su Boston Review all’inizio del 2007 (disponibile anche sul web

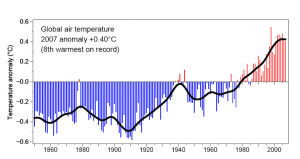

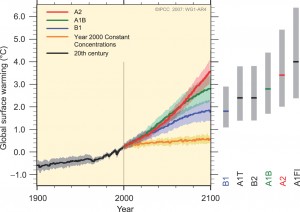

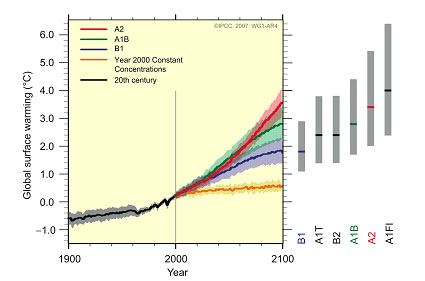

Il libro è la traduzione di un saggio di rara chiarezza e sintesi “Phaeton’s Reins. The human hand in climate change “, pubblicato su Boston Review all’inizio del 2007 (disponibile anche sul web  L’incertezza dovuta alla conoscenza del sistema clima è grande per ogni scenario, ma è molto inferiore (vedasi figura sopra): la forbice data dalla prima deviazione standard intorno alla media è circa un grado, l’intervallo più probabile (linee grigie sulla sinistra) varia da 2 gradi dello scenario B1ai 4 gradi dello scenario A2.

L’incertezza dovuta alla conoscenza del sistema clima è grande per ogni scenario, ma è molto inferiore (vedasi figura sopra): la forbice data dalla prima deviazione standard intorno alla media è circa un grado, l’intervallo più probabile (linee grigie sulla sinistra) varia da 2 gradi dello scenario B1ai 4 gradi dello scenario A2.