Con quale precisione i modelli climatici hanno previsto il riscaldamento globale?

Proponiamo la traduzione dell’articolo “Analysis: How well have climate models projected global warming?” scritto da Zeke Hausfather per Carbon Brief, che ringraziamo.

Negli ultimi quarant’anni gli scienziati hanno realizzato proiezioni del riscaldamento globale futuro usando modelli climatici di crescente complessità, basati sulla fisica dell’atmosfera e sulla biogeochimica. Sono strumenti fondamentali per capire i processi in atto nel sistema climatico terrestre e come potrà verosimilmente cambiare in futuro.

Carbon Brief ha passato in rassegna i modelli climatici che sono stati sviluppati a partire dal 1973 per confrontare le loro proiezioni della temperatura futura con le simulazioni della temperatura del passato fatte dai modelli più recenti e con i dati di temperatura globale effettivamente misurata sulla terra, come mostrato nell’animazione sottostante.

Benché alcuni modelli avessero sottostimato e altri sovrastimato il riscaldamento effettivamente avvenuto, tutti quelli presi in esame hanno riprodotto con buona approssimazione un incremento della temperatura superficiale tra il 1970 e il 2016, soprattutto se si tiene conto delle differenze nelle emissioni ipotizzate nei diversi modelli.

Come se la sono cavata i modelli climatici del passato?

Se nel cercare di riprodurre il clima degli ultimi decenni i modelli climatici beneficiano della conoscenza delle concentrazioni dei gas serra atmosferici, delle eruzioni vulcaniche e delle altre forzanti radiative che influenzano il clima terrestre, le proiezioni nel futuro sono comprensibilmente più incerte.

I modelli climatici possono essere valutati sulla base della loro capacità sia di riprodurre le temperature del passato (un approccio definito “hindcast”), sia di prevedere quelle future.

Gli hindcast, o retro-proiezioni, sono utili perché si possono controllare le forzanti radiative, che sono già note. Le proiezioni sono utili perché non possono essere implicitamente calibrate per somigliare alle osservazioni: non sono “adattate” alle temperature storiche, ma i modellisti dispongono di osservazioni in base alle quali scegliere quali parametri adottare, per esempio per descrivere i processi legati alla fisica delle nubi o gli effetti degli aerosol.

Negli esempi che seguono, le proiezioni pubblicate tra il 1973 e il 2013 sono confrontate con dati di temperatura forniti da cinque diverse organizzazioni. I modelli usati variano in complessità e vanno dai più semplici a bilancio di energia ai modelli accoppiati del Sistema Terra.

(I confronti utilizzano il periodo di riferimento 1970-1990 per “allineare” osservazioni e modelli durante i primi anni dell’analisi, e mostrare più chiaramente l’evoluzione temporale delle temperature).

Sawyer, 1973

Una delle prime proiezioni fu realizzata da John Sawyer dell’Ufficio Meteorologico Britannico (UK’s Met-Office) nel 1973. In un articolo pubblicato su Nature , Sawyer ipotizzava che il pianeta si sarebbe riscaldato di 0.6 °C tra il 1969 e il 2000 e che la CO2 atmosferica sarebbe aumentata del 25%. Sawyer considerò un valore di sensibilità climatica (ovvero l’aumento temperatura in seguito a un raddoppio della concentrazione di CO2 atmosferica) pari a 2,4 °C, che non è molto lontano dalla migliore stima di 3°C utilizzata attualmente dall’Intergovernmental Panel on Climate Change (IPCC).

Diversamente dalle altre proiezioni esaminate in questo articolo, Sawyer non stimò il riscaldamento anno per anno, ma solo un valore atteso al 2000. La stima di 0,6 °C si è rivelata quasi esatta: il riscaldamento effettivamente osservato attorno a quell’anno è stato tra 0,51 °C e 0,56 °C. Sawyer sovrastimò invece la concentrazione atmosferica di CO2 prevista per il 2000, assumendo che sarebbe stata compresa tra 375 e 400 ppm, mentre il valore reale è stato 370 ppm.

Broecker, 1975

La prima proiezione disponibile di evoluzione delle temperature in risposta al riscaldamento globale è apparsa in un articolo su Science del 1975, scritto dal Prof. Wally Broecker della Columbia University. Broecker utilizzò un semplice modello a bilancio di energia per calcolare cosa sarebbe successo alla temperatura terrestre se la CO2 atmosferica avesse continuato ad aumentare rapidamente dopo il 1975.

Le sue stime sono state abbastanza accurate fino al 2000: prevedeva una concentrazione di CO2 pari a 373 ppm, confrontabile con il valore misurato a Mauna Loa di 370 ppm. Tuttavia, per il 2016 stimò che la concentrazione di CO2 sarebbe stata pari a 424 ppm, invece dei 404 ppm osservati.

Broecker non aveva tenuto conto degli altri gas serra, ma possiamo pensare che questo non abbia portato a grandi errori visto che il riscaldamento dovuto a gas serra come metano, protossido di azoto e alocarburi può considerarsi in gran parte compensato dall’effetto di raffreddamento dovuto agli aerosol atmosferici a partire dagli anni ‘70 – anche se per gli aerosol le stime della forzante radiativa sono affette da grandi incertezze.

Broecker utilizzò una sensibilità climatica all’equilibrio di 2,4 °C per un raddoppio della CO2, come Sawyer, e un riscaldamento istantaneo della Terra in risposta al valore di CO2 atmosferica, mentre i modelli attuali tengono conto dello sfasamento tra la velocità di riscaldamento dell’atmosfera e quella degli oceani (ci si riferisce spesso al più lento immagazzinamento di calore da parte degli oceani come alla “inerzia termica” del sistema climatico). Il grafico sottostante mostra la proiezione del modello di Broecker (linea nera), confrontata con l’aumento di temperatura osservato (linee colorate).

All’epoca di questa proiezione, secondo la maggior parte degli scienziati le osservazioni indicavano un modesto raffreddamento della Terra e Broecker esordì con una frase preveggente: “ci sono valide ragioni per ritenere che l’attuale tendenza al raffreddamento lascerà spazio, entro un decennio circa, ad un pronunciato riscaldamento indotto dall’anidride carbonica”.

Hansen e altri, 1981

James Hansen e colleghi della NASA pubblicarono un articolo nel 1981 che a loro volta si basava su un semplice modello a bilancio di energia, ma tenendo anche conto dell’inerzia termica dovuta all’accumulo di calore negli oceani. Assunsero una sensibilità climatica di 2,8 °C per un raddoppio della CO2 e considerarono anche una sua forbice di 1,4 -5,6 °C.

Riscaldamento previsto da Hansen e altri, 1981 (crescita rapida: linea spessa nera; crescita lenta: linea grigia sottile). Grafico realizzato da Carbon Brief con Highcharts.

Hansen e colleghi presentarono diversi scenari, variando le emissioni future e il valore di sensibilità climatica. Nel grafico sovrastante è possibile vedere sia i risultati dello scenario “a crescita rapida” (linea spessa nera) in cui le emissioni di CO2 crescono del 4% ogni anno a partire dal 1981, sia quelli dello scenario “a crescita lenta” dove l’aumento annuale delle emissioni è del 2% (linea grigia sottile). Lo scenario “a crescita rapida” sovrastima leggermente le emissioni attuali ma, se combinato con una sensibilità climatica leggermente inferiore, fornisce una stima del riscaldamento per i primi anni del 2000 vicina ai valori osservati.

Il tasso totale di riscaldamento tra il 1970 e il 2016 nello scenario “a crescita rapida”, è stato inferiore rispetto a quello osservato di circa il 20%.

Hansen e altri, 1988

Nel 1988 Hansen e colleghi hanno presentato uno dei primi modelli climatici che possiamo definire moderni. Il pianeta era suddiviso in celle a formare una griglia tridimensionale di dimensione 8° di latitudine e 10° di longitudine e con nove livelli verticali in atmosfera. Oltre alla CO2, il modello includeva aerosol, diversi altri gas serra e la dinamica di base delle nubi.

Venivano considerati tre diversi scenari, associati a diverse emissioni future di gas serra, mostrati nel grafico sottostante: lo scenario B è rappresentato con una linea nera spessa, gli scenari A e C con linee grigie sottili. Lo scenario A descrive una crescita esponenziale delle emissioni, con concentrazioni di CO2 e di altri gas serra considerevolmente maggiori rispetto a quelle odierne.

Riscaldamento previsto da Hansen e altri, 1988 (scenario B: linea nera spessa; scenari A e C: linee sottili grigie continua e tratteggiata). Grafico realizzato da Carbon Brief con Highcharts.

Lo scenario B ipotizzava una diminuzione graduale delle emissioni di CO2, ma con una concentrazione di 401 ppm nel 2016, valore prossimo ai 404 ppm misurati in media nel 2016. Tuttavia, lo scenario B assumeva una crescita continua delle emissioni di diversi alocarburi, potenti gas a effetto serra, le cui emissioni sono state fortemente limitate con il Protocollo di Montreal del 1987. Lo scenario C prevedeva emissioni quasi nulle dopo l’anno 2000.

Tra i tre, lo scenario B è quello che fornisce una forzante radiativa più vicina a quella reale sebbene ancora sovrastimata di circa il 10%. Hansen e coautori utilizzarono inoltre un modello con una sensibilità climatica di 4,2 °C per un raddoppio della concentrazione di CO2 – il limite più alto della maggior parte dei modelli climatici moderni. A causa della combinazione di questi fattori, per il periodo 1970-2016 lo scenario B risulta in un tasso di riscaldamento superiore del 30% circa a quello osservato.

Primo rapporto di valutazione IPCC, 1990

Il primo rapporto di valutazione dell’IPCC del 1990 (First Assessment Report, FAR) ha riportato i risultati di modelli relativamente semplici di atmosfera e oceano per stimare i cambiamenti nella temperatura globale in risposta a diversi scenari emissivi. Lo scenario business-as-usual (BAU) ipotizzava una rapida crescita della CO2 atmosferica fino a 418 ppm nel 2016 (il valore effettivamente osservato è di 404 ppm). Il FAR assumeva anche una crescita continua delle concentrazioni atmosferiche degli alocarburi molto più rapida di quanto effettivamente sia accaduto.

Nel FAR la stima di sensibilità climatica è pari a 2,5 °C per un raddoppio della concentrazione di CO2 e ha una forbice di 1,5-4,5 °C. Queste stime applicate allo scenario BAU hanno fornito gli andamenti di crescita di temperatura mostrati nella figura sottostante (la linea nera spessa si riferisce al valore di 2,5 °C di sensibilità climatica e le linee nere sottili tratteggiate si riferiscono al limite inferiore e superiore della forbice).

Riscaldamento previsto dal primo rapporto di valutazione IPCC, 1990 (proiezione media linea nera spessa, con i limiti superiori e inferiori rappresentati da linee nere sottili tratteggiate). Grafico realizzato da Carbon Brief con Highcharts.

Nonostante una stima della sensibilità climatica di poco inferiore a 3 °C, valore utilizzato oggi, nello scenario BAU il FAR ha sovrastimato del 17% circa il tasso medio di riscaldamento tra il 1970 e il 2016: 1 °C rispetto ai 0,85 °C osservati. Ciò è dovuto principalmente ad una previsione delle concentrazioni di CO2 atmosferica molto più elevata di quella effettiva.

Secondo rapporto di valutazione IPCC, 1995

Il SAR (Second Assessment Report) ha pubblicato i risultati delle proiezioni disponibili dal 1990 in poi, basate su una sensibilità climatica di 2,5 °C, con una forbice di 1,5-4,5 °C. Lo scenario medio di emissioni, “IS92a”, prevedeva livelli di CO2 di 405 ppm nel 2016, quasi identico alle concentrazioni osservate. Il SAR ha incluso inoltre un trattamento molto migliore degli aerosol antropogenici, i quali hanno un effetto di raffreddamento sul clima.

Riscaldamento previsto dal secondo rapporto di valutazione IPCC, 1995 (proiezione media linea nera spessa, con i limiti superiori e inferiori rappresentati da linee nere sottili tratteggiate). Grafico realizzato da Carbon Brief con Highcharts.

Come si può notare dal grafico sovrastante, le proiezioni del SAR hanno sottostimato le osservazioni, presentando un riscaldamento più lento del 28% circa rispetto alle osservazioni nel periodo dal 1990 al 2016. Ciò è probabilmente dovuto alla combinazione di due fattori: una sensibilità climatica inferiore rispetto a quella riscontrata nelle stime attuali (2,5 °C vs 3 °C) e una sovrastima della forzante radiativa della CO2 (4,37 W/m2 rispetto a 3,7 W/m2 utilizzato nei rapporti IPCC successivi).

Terzo rapporto di valutazione IPCC, 2001

Il TAR (Third Assessment Report) è basato sui modelli accoppiati di circolazione generale atmosfera-oceano (GCMs) sviluppati da sette gruppi di modellistica climatica. È stato introdotto un nuovo insieme di scenari di emissione socioeconomici ( SRES) che comprendevano quattro possibili traiettorie di emissioni future.

Tutti gli scenari hanno traiettorie di emissioni e di riscaldamento abbastanza simili fino al 2020. Lo scenario A2 ha previsto una concentrazione di CO2 atmosferica nel 2016 di 406 ppm, quasi identica a quella osservata. I modelli hanno utilizzato le forzanti previste negli scenari SRES dall’anno 2000 in poi e le stime delle forzanti storiche per il periodo precedente.

Riscaldamento previsto dal terzo rapporto di valutazione IPCC, 2001 (proiezione media linea nera spessa, con i limiti superiori e inferiori rappresentati da linee nere sottili tratteggiate). Grafico realizzato da Carbon Brief con Highcharts.

La linea grigia tratteggiata nella figura sopra mostra il punto in cui i modelli passano dall’utilizzo delle emissioni e delle concentrazioni osservate (“Hindcast”) a quelle previste negli scenari futuri (“Forecast”).

Nel TAR la principale proiezione fu realizzata con un modello climatico semplice configurato per accordarsi alla media dei risultati di sette GCMs più sofisticati, senza pubblicare una media multi-modello specifica, e i dati delle simulazioni dei singoli modelli non sono facilmente disponibili. Il modello ha una sensibilità climatica di 2,8 °C per un raddoppio della concentrazione di CO2, variabile in una forbice di 1,5-4,5 °C. Come mostrato nel grafico sovrastante, il tasso di riscaldamento nel periodo compreso tra il 1970 e il 2016 è inferiore del 14% circa a quello osservato.

Quarto rapporto di valutazione IPCC, 2007

L’AR4 (Fourth Assessment Report) ha incluso modelli con notevoli miglioramenti nel trattamento della dinamica atmosferica e nella risoluzione. Ha fatto maggior uso di modelli del Sistema Terra (Earth System Models, ESMs), che incorporano la biogeochimica del ciclo del carbonio e una migliore rappresentazione dei processi alla superficie delle terre emerse e dei ghiacci.

AR4 ha utilizzato gli stessi scenari SRES del rapporto precedente, con emissioni e concentrazioni atmosferiche storiche fino all’anno 2000 e dopo scenari futuri. I modelli utilizzati avevano una sensibilità climatica media di 3,26 °C, in una forbice di 2,1- 4,4 °C.

Riscaldamento previsto dal quarto rapporto di valutazione IPCC, 2007 (media della previsione: linea nera spessa; i limiti superiore e inferiore della fascia due-sigma sono mostrati dalla linea nera sottile). Grafico realizzato da Carbon Brief con Highcharts.

La figura sopra mostra le simulazioni dei modelli per lo scenario A1B (l’unico scenario per cui le simulazioni sono facilmente disponibili, nonostante le concentrazioni di CO2 nel 2016 siano quasi identiche a quelle dello scenario A2). Le proiezioni di AR4 tra il 1970 e il 2016 mostrano un riscaldamento abbastanza vicino alle osservazioni, più alto soltanto dell’8%.

Quinto rapporto di valutazione IPCC, 2013

L’AR5 (Fifth Assessment Report) include i risultati di modelli climatici ulteriormente perfezionati, con un’incertezza nelle proiezioni future lievemente ridotta rispetto a quelli del rapporto precedente. I modelli climatici fanno parte del “Coupled Model Intercomparison Project 5” (CMIP5), in cui decine di gruppi di ricerca in tutto il mondo hanno fatto girare i propri modelli utilizzando lo stesso insieme di dati input in ingresso e di scenari.

Riscaldamento previsto dal quinto rapporto di valutazione IPCC, 2013 (media della proiezione: linea nera spessa; limiti superiore e inferiore della fascia due-sigma sono rappresentati con linea nera sottile). La linea nera tratteggiata mostra i campi del modello ibrido. Grafico realizzato da Carbon Brief con Highcharts.

L’AR5 ha introdotto un nuovo gruppo di scenari che descrivono l’evoluzione futura delle concentrazioni di gas serra: i “Representative Concentration Pathways” (RCPs). Si riferiscono al periodo successivo al 2006, mentre forzanti storiche vengono usate per il periodo precedente. La linea grigia tratteggiata nella figura sopra mostra dove avviene la transizione nei modelli tra l’utilizzo delle forzanti osservate e quelle ipotizzate per il futuro.

Confrontare i risultati di questi modelli con le osservazioni è un esercizio un po’ arduo. La variabile che viene più spesso presa in considerazione nei modelli è la temperatura atmosferica superficiale globale (TAS, Surface Air Temperature, mostrata nella figura sopra con la linea nera spessa) da confrontare con le temperature osservate su tutto il globo che includono le temperature dell’aria sopra alla superficie delle terre emerse e le temperature superficiali marine.

Per questo, i modelli più recenti hanno “campi” che combinano entrambe le temperature e risultano maggiormente confrontabili con ciò che è effettivamente misurato. Questi campi “misti”, rappresentati dalla linea nera tratteggiata nella figura sopra, mostrano un riscaldamento leggermente inferiore a quello delle temperature globali superficiali dell’aria.

Nei modelli CMIP5 l’aria sopra gli oceani si riscalda più velocemente di quanto faccia la superficie del mare, e le temperature globali dell’aria alla superficie aumentano del 16% circa più velocemente rispetto alle osservazioni dal 1970 in poi. Di questa differenza, il 40% circa è dovuto al fatto che nei modelli la temperatura dell’aria sopra l’oceano si scalda più velocemente di quella dell’acqua alla superficie; i campi misti mostrano un riscaldamento superiore soltanto del 9% a quello osservato (rispetto al 16% riportato sopra). In un recente articolo su Nature, Iselin Medhaug e colleghi suggeriscono che la restante differenza sia dovuta ad una combinazione, non inclusa nelle proiezioni dei modelli dal 2005 in poi, della variabilità climatica naturale a breve termine (principalmente nell’Oceano Pacifico), piccole eruzioni vulcaniche e un’attività solare inferiore a quella attesa.

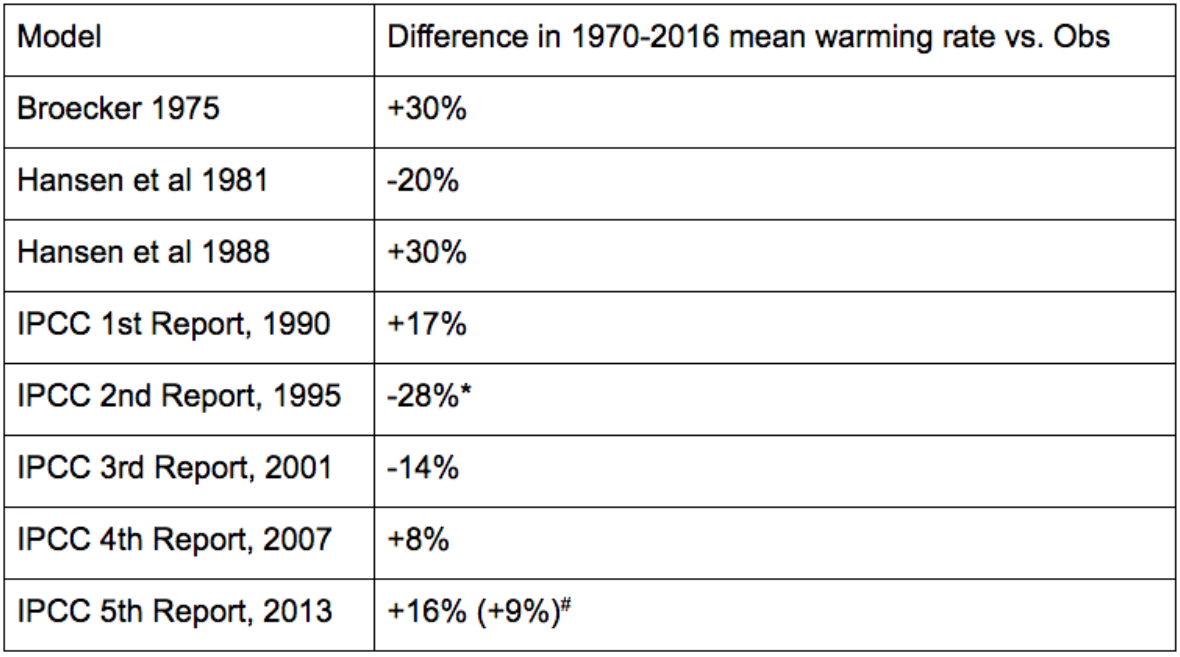

Di seguito, si riporta un riepilogo di tutti i modelli che Carbon Brief ha esaminato. La tabella mostra la differenza tra il tasso di riscaldamento che risulta da ogni modello o insieme di modelli, e le osservazioni di temperatura della NASA. Tutte le temperature derivanti dalle osservazioni sono abbastanza simili tra loro, ma la serie della NASA fa parte del gruppo che, negli ultimi anni, ha una copertura globale osservativa più completa e, di conseguenza, è più direttamente confrontabile con i dati del modello climatico.

*Per il SAR le differenze di tendenza sono calcolate nel periodo 1990-2016, perché le stime antecedenti il 1990 non sono facilmente disponibili.

# La differenza fra parentesi si riferisce ai campi misti del modello.

Conclusioni

In generale dal 1973 in poi i modelli climatici hanno previsto il riscaldamento con un buon grado di affidabilità. Se da un lato alcuni modelli hanno fornito proiezioni sottostimate ed altri sovrastimate, tutti i modelli hanno danno risposte ragionevolmente vicine a ciò che si è realmente osservato, in particolare se si tiene conto delle differenze tra le concentrazioni di CO2 e le altre forzanti climatiche previste dal modello e quelle reali.

I modelli sono tutt’altro che perfetti e continueranno a essere migliorati nel tempo. Mostrano un intervallo abbastanza ampio di riscaldamento futuro che non può essere facilmente ridotto basandosi solo sulla conoscenza dei cambiamenti climatici che abbiamo già osservato.

Ciò nonostante, la stretta correlazione tra riscaldamento previsto dai modelli e quello effettivamente osservato dal 1970 suggerisce che per il futuro le stime potrebbero risultare altrettanto accurate.

Note metodologiche

L’ecologo Dana Nuccitelli ha gentilmente fornito un’utile lista di confronti tra modelli e osservazioni passate, disponibile qui. Il software PlotDigitalizer è stato utilizzato per estrarre i valori dalle figure meno recenti quando i dati non erano disponibili altrimenti. I dati dei modelli CMIP3 e CMIP5 sono stati ottenuti con KNMI Climate Explorer [4].

Testo di Zeke Hausfather, tratto da “Analysis: How well have climate models projected global warming?”

Traduzione a cura di: Martina Daddi, Daniele Moncecchi, Federica Guerrini, Yousra Saoudi, Licia Gallazzi. Revisione di Elisa Palazzi, Sylvie Coyaud e Stefano Caserini.

37 responses so far

“Ciò nonostante, la stretta correlazione tra riscaldamento previsto dai modelli e quello effettivamente osservato dal 1970 suggerisce che per il futuro le stime potrebbero risultare altrettanto accurate.”

Accurati i modelli?

Mmmh… eppure… mi pareva… di aver sentito dire cose “leggermente” diverse… da questo signore qui:

https://www.ted.com/talks/gavin_schmidt_the_emergent_patterns_of_climate_change/transcript

Un piccolo estratto dal transcript:

“What does that mean? Okay, well if you think about how you can calculate these things, you can take what you can see, okay, I’m going to chop it up into lots of little boxes, and that’s the result of physics, right?

And if I think about a weather model, that spans about five orders of magnitude, from the planet to a few kilometers, and the time scale from a few minutes to 10 days, maybe a month. ——–

We’re interested in more than that. ——–

We’re interested in the climate. That’s years, that’s millennia, and we need to go to even smaller scales. The stuff that we can’t resolve, the sub-scale processes, we need to approximate in some way. That is a huge challenge. ———

Climate models in the 1990s took an even smaller chunk of that, only about three orders of magnitude.

Climate models in the 2010s, kind of what we’re working with now, four orders of magnitude.

We have 14 to go, and we’re increasing our capability of simulating those at about one extra order of magnitude every decade. ———-

One extra order of magnitude in space is 10,000 times more calculations. And we keep adding more things, more questions to these different models. ——— ”

Letto?

Le vostre “accurate stime” non passerebbero un esame di review per un qualsiasi articolo di fisica delle particelle.

A quelli che obiettano che “la climatologia non e’ la fisica delle particelle” posso solo rispondere che, “… infatti la fisica delle particelle e’ una scienza (praticamente) esatta, che come tale puo’ fare delle vere previsioni, mentre la climatologia e’ una scienza in costruzione, lontana anni luce dal potersi dichiarare ‘completa’, come teoria, e quindi non puo’ fare previsioni che non siano spannomentriche”.

Attribuirle poteri che non ha allo stato attuale e’ completa follia, per non usare altro termine piu’ consono.

Nel frattempo, come dice Gavin… sono 14 ordini di grandezza “to go”, ragazzi… dovrete darvi da fare.

I casi sono due: o tutto quello che Gavin dice qui sopra sono stupidaggini, ed i modelli attuali sono gia’ adeguati, oppure ha ragione, e i modelli attuali NON sono adeguati. Tertium non datur. Punto.

Saluti a tutti (… e per eventuali proteste/obiezioni pregasi scrivere a @ClimateOfGavin, naturalmente, io sono solo il messaggero)

P.S.: a chi non dovesse bastare Gavin in carne ed ossa e per iscritto durante una conferenza divulgativa TEDx posso consigliare le centinaia di articoli che trattano dei vari “problemi” e “approssimazioni” dei vari modelli climatologici, su riviste peer-reviewed come Geoscientific Model Development…

https://www.geosci-model-dev.net/10/3207/2017/

… guarda un po’ proprio un articolo di Gavin per cominciare.

@ robertok06

@Le vostre “accurate stime” non passerebbero un esame di review per un qualsiasi articolo di fisica delle particelle.

@ I casi sono due: o tutto quello che Gavin dice qui sopra sono stupidaggini, ed i modelli attuali sono gia’ adeguati, oppure ha ragione, e i modelli attuali NON sono adeguati.

Certo, liberissimo di pensare che tutti i modellisti e climatologi del mondo siano dei cialtroni, G. Schmidt compreso, che si divertano a giocare con modelli inadeguati e i numeri, e che gli unici scienziati seri siano quelli del suo settore e tutte le altre peer review sono da buttare.

Oppure può iniziare a cercare di capire il senso del lavoro che fanno i modellisti del clima.

Il senso del post è mostrare come, al di là delle singole opinioni, pur se hanno certo molte cose da migliorare i modelli usati già fino ad oggi hanno fatto proiezioni utili, con un buon grado di affidabilità.

@caserini

‘Certo, liberissimo di pensare che tutti i modellisti e climatologi del mondo siano dei cialtroni,’

Nice try, caserini…. di buttarla in caciara. Passo.

Mai detto che siano cialtroni, di cialtrona c’é solo, eventualmente, una certa interpretazione fideistica deil risultati dei modelli, che sono inadeguati come ben spiegato da GS stesso… lo ascolti con attenzione.

O lo legga sull’articolo di geosci model dev che ho linkato, come per esempio:

‘The complexity of this system is evident in the myriad processes involved (such as the microphysics of cloud nucleation, land surface heterogeneity, convective plumes, and ocean mesoscale eddies) and the dynamic views provided by remote sensing.

This complexity and wide range of scales that need to be incorporated imply that simulations will necessarily include approximations to well-understood physics and empirical formulations for unresolved effects.’

Approximations, empirical formulations for unresolved effects… è sinonimo di ‘possiamo prevedere con precisione il clima da qui al 2300′ come sostiene l’interpretazione fideistica… o forse è tirata un po’ per i capelli?

Suvvia, negare l’evidenza… mi ruba il lavoro…. non sono io il negazionista dopo tutto? 🙂

Saluti.

More-severe climate model predictions could be the most accurate

The climate models that project greater amounts of warming this century are the ones that best align with observations of the current climate, according to a new paper from Carnegie’s Patrick Brown and Ken Caldeira published by Nature. Their findings suggest that the models used by the Intergovernmental Panel on Climate Change, on average, may be underestimating future warming.

Climate model simulations are used to predict how much warming should be expected for any given increase in the atmospheric concentration of carbon dioxide and other greenhouse gases.

“There are dozens of prominent global climate models and they all project different amounts of global warming for a given change in greenhouse gas concentrations, primarily because there is not a consensus on how to best model some key aspects of the climate system,” Brown explained.

Raw climate model results for a business-as-usual scenario indicate that we can expect global temperatures to increase anywhere in the range of 5.8 and 10.6 degrees Fahrenheit (3.2 to 5.9 degrees Celsius) over preindustrial levels by the end of the century — a difference of about a factor of two between the most- and least-severe projections.

Brown and Caldeira set out to determine whether the upper or lower end of this range is more likely to prove accurate. Their strategy relied on the idea that the models that are going to be the most skillful in their projections of future warming should also be the most skillful in other contexts, such as simulating the recent past. Brown and Caldeira’s study eliminates the lower end of this range, finding that the most likely warming is about 0.9 degrees Fahrenheit (0.5 degrees Celsius) greater than what the raw model results suggest.

The researchers focused on comparing model projections and observations of the spatial and seasonal patterns of how energy flows from Earth to space. Interestingly, the models that best simulate the recent past of these energy exchanges between the planet and its surroundings tend to project greater-than-average warming in the future.

“Our results suggest that it doesn’t make sense to dismiss the most-severe global warming projections based on the fact that climate models are imperfect in their simulation of the current climate,” Brown said. “On the contrary, if anything, we are showing that model shortcomings can be used to dismiss the least-severe projections.”

The uncertainty in the range of future warming is mostly due to differences in how models simulate changes in clouds with global warming. Some models suggest that the cooling effect caused by clouds reflecting the Sun’s energy back to space could increase in the future while other models suggest that this cooling effect might decrease.

“The models that are best able to recreate current conditions are the ones that simulate a reduction in cloud cooling in the future and thus these are the models that predict the greatest future warming,” Brown explained.

“It makes sense that the models that do the best job at simulating today’s observations might be the models with the most reliable predictions,” Caldeira added. “Our study indicates that if emissions follow a commonly used business-as-usual scenario, there is a 93 percent chance that global warming will exceed 4 degrees Celsius (7.2 degrees Fahrenheit) by the end of this century. Previous studies had put this likelihood at 62 percent.”

Patrick T. Brown, Ken Caldeira. Greater future global warming inferred from Earth’s recent energy budget. Nature, 2017; 552 (7683): 45 DOI: 10.1038/nature24672

@alsy

“Patrick T. Brown, Ken Caldeira. Greater future global warming inferred from Earth’s recent energy budget. Nature, 2017; 552 (7683): 45 DOI: 10.1038/nature24672”

More of the same… non cambia nulla. Anche questo strepitoso risultato ottenuto con gli stessi modelli. Se l’hai postato per smentire quello che dice Gavin Schmidt e che io ho riportato hai fatto flop.

Basta scaricare il file excel nella sezione “Supplementary info” e leggersi la lista dei modelli utilizzati.

Fatto questo, basta andare a scavare un po’… e si trovano subito i limiti, inevitabili come dice lo stesso Gavin Schmidt, dei modelli stessi.

Esempio (uno dei mille possibili, sia chiaro): uno dei codici utilizzati per la “Ocean component” e’ ACCESS-OM.

Qui…

https://pdfs.semanticscholar.org/7a25/825ddd621928f865837f4ff8b7e7304ea626.pdf

… si trova una descrizione di tale modulo.

Ricopio dall’abstract:

“A selection of key metrics from an ACCESS-OM benchmark simulation, which has run for 500 years using the Coordinated Ocean-ice Reference Experiments normal year forcing, is presented and compared with observations to evaluate the model performance.

It shows ACCESS-OM simulates the global ocean and sea-ice climate generally comparably to the results from other ocean sea-ice models of the same class (Griffies et al. 2009). ”

Letto? Il benchmarking di questo codice “generalmente” si confronta bene con i risultati DI ALTRI modelli oceano-ghiaccio della stessa classe.

Cioe’… lo valutano “benino” rispetto ad altri modelli, non ai dati.

Quando lo fanno con i dati, l’accordo e’ meno buono… basta sfilare nel testo dove, per esempio, valutano la precisione nel calcolo di una grandezza fondamentale, il flusso di acqua oceanica delle principali correnti che determinano in maniera fondamentale lo scambio e rimescolamento delle temperature del pianeta.

Dicono…

“The maximum transport of North Atlantic overturning circulation is 18.5 Sv and the Antarctic Circumpolar Current transport through Drake Passage is 150 Sv, both in fair agreement with the observations; and the sea-ice coverage has reasonable distribution and annual cycle. ”

OK… “in fair agreement with observations”… finalmente!

Ma quanto “fair” e’ questo accordo? Vediamo… pag.224 e 225 (altri esempi prima e dopo):

“In the Southern Ocean, the AABW cell evolves with no evident variability or oscillation and has a maximum transport of about 5.5 Sv by the end of the run. This rate is comparable to other CORE results that range from 5 to 10 Sv, but small compared to observations …”

Scopriamo che ACCESS-OM calcola 5.5 sverdrups, mentre il range di altri modelli e’ fra 5 e 10…. Scusatemi???? un fattore due fra il piu’ basso e il piu’ alto?

Della serie “la velocita’ della luce e’ fra 200 mila e 400 mila km/s”. Arrivederci telecomunicazioni e GPS…. 🙂

E continuano:

“The maximum transport evolves with noticeable quasidecadal variability in the second half of the simulations and settles at around 14 Sv”

… anche qui e’ “comparable”… quindi ottimo, no?

No!… neanche un po’… perche’ il range degli altri modelli e’ da 6 a 20!… piu’ di un fattore 3!

Della serie “suo figlio da adulto sara’ alto fra 70 cm e 2m e 10”. 🙂

Stessa considerazioni si possono fare per gli altri modelli e componenti dell’atmosfera e sua composizione chimica, la parte sulle terre emerse, etc…

I modelli attuali, per quanto “state of the art” siano sono solo APPROSSIMAZIONI abbastanza grossolane della realta’,… nulla di piu’. Non e’ una mia opinione, basta informarsi opportunamente.

Affidarsi a queste per pianificare il futuro dell’umanita’ a fine secolo “and beyond” e’ DA PAZZI.

Ciao.

robertok06 e l’idiosincrasia ai modelli climatici

per una volta, devo dire che non hai proprio tutti i torti. Ma il problema, per me, è che pretendi troppo, soprattutto quando li compari con l’incomparabile (vedi la fisica delle particelle).

Fossi in te (lo so che è impossibile), mi limiterei a valutarne l’utilità partendo dal presupposto di Box.

stefano e il senso del post

si capisce benissimo il senso del post, e non c’è bisogno di un robertok06 di turno per evidenziarlo, ovviamente. Il quale, se lo vorrà, potrà anche rispondere nel merito non a te ma a Hausfather (anche se dubito che lo farà).

Veramente al di là della verbosità la comparazione impropria tra climatologia e fisica delle particelle ricorda il tentativo di Zichichi di screditare la teoria della selezione naturale darwiniana comparandola scorrettamente con la fisica galileiana. Comparazione scorretta ed inconcludente ma che appare solida alle menti obnubilate dall’ animosità verso i risultati della scienza in questo o quel campo, siano la biologia evoluzionistica, la climatologia o il big-bang.

La cosa che trovo incredibile è che pur davanti ad un post con 10 grafici in cui si vedono quali sono state le – buone – approssimazioni dei modelli del passato (modelli ovviamente molto meno solidi di quelli attuali), ci sia chi riesce ancora a scrivere che quelle dei modelli sono approssimazioni grossolane… Magari dare un’occhiata ai grafici, no?

E poi… accusare gli altri di essere negazionisti e che le proprie non sono opinioni… please…

@ Alsarago

A parer mio non è mai utile basarsi su un solo paper… 62% o 92% di superare +4 °C cambia poco per le policy.

La forza di questo post è che mostra l’evoluzione.. c’è ormai molta letteratura, c’è ormai una storia, forse solo sul tema delle calotte glaciali ci sono cose sostanziali da dire

@steph

Non mi sogno nemmeno di scrivere a Hausfather!… e’ una persona intelligente e preparata (l’ho visto in un paio di video e ho letto parecchi suoi articoli)… se fa quello che fa su Carbon Brief un motivo ci sara’.

In compenso tu non sei in grado di replicare QUI A ME sui miei ben documentati e circostanziati appunti/commenti alle affermazioni di Gavin S. e estratti di articoli scientifici. Prendo atto, comunque, di un minimo di onesta’ intellettuale quando dici che “forse non ho proprio tutti i torti”. Grazie. 🙂

P.S.: Ah… ieri sera ho verificato la consistenza e precisione di un’altro modulo dei modelli, PISCES-2, quello utilizzato per modellizzare la bio-geo chimica degli oceani… idem con patate, ne esce a pezzi!… non ho spazio sufficiente qui per riportare estratti, purtroppo…

https://www.geosci-model-dev.net/8/2465/2015/gmd-8-2465-2015.pdf

————-

@alberto

La mia non e’ verbosita’: la verbosita’ e’ altra cosa. Io ho molte cose da dire, perche’ mi documento, cosa completamente diversa.

Tu, in compenso, sembri essere capace sempre e solo di scrivere commenti inutili sui miei commenti, e vuoti di vero contenuto… quindi 100% off-topic, come questo al quale rispondo. A ciascuno il suo, in base alle capacita’ che ha, no? 🙂

Zichichi non c entra nulla, ed il mio era solo un ESEMPIO per far capire che la fisica delle particelle e’ una scienza praticamente esatta e quindi puo’ fare, con i suoi modelli, previsioni scientificamente verificabili (con precisione astronomica), cosa che NON succede in climatologia… almeno fin quando non si colmeranno i 14 ordini di grandezza di velocita’ di calcolo che mancano, come ha detto Gavin Schmidt (parole sue, ascoltalo e leggilo se non credi a me).

————

@Antonio

I 10 grafici “centrano il bersaglio” perche’ sono fatti per centrarlo. Se tu spendessi un po’ di tempo, come faccio io per hobby e cultura personale, potresti capire come funzionano queste fantastiche previsioni. Fanno girare decine o centinaia, o persino piu’ di 1000 modelli, alcuni lo stesso codice con dati iniziali diversi in parallelo ad altri codici con gli stessi dati o diversi, li lasciano “evolvere” nel tempo, e poi alla fine prendono un sotto-insieme di questo “ensemble”, la parte che assomiglia al trend di temperatura (o altra grandezza fisica d’interesse), e ne calcolano la media con bande di confidenza annesse. Una volta fatto l’hindcasting con successo (che, ti diro’, non mi impressiona molto… quando hai centinaia di parametri liberi riesci a fittare piu’ o meno bene proprio tutto) estendono il “run” dei modelli “buoni” al futuro. Voila’.

La fisica vera, pero’, e’ altra cosa.

D’altronde, se tu avessi ragione, perche’ mai oggi dovrebbero usare, come dice G. Schmidt, supercalcolatori da petaflop di velocita’ quando basterebbe, a sentire Hausfather, il modellino UNIDIMENSIONALE di Hansen?… l’hai almeno letto l’articolo linkato qui sopra, quello del 1981?

Gli stessi autori dicono “Models do not yet accurately simulate many parts of the climate system, especially the ocean, clouds, polar sea ice, and ice sheets”… eppure Hausfather INVECE sostiene, 36 anni dopo, che lo fanno!

A costo di ripetermi… delle due l’una: o quel modello di Hansen &Co era “buono” (secondo quello che dice Hausfather) e quindi Hansen stesso ha scritto una cosa sbagliata (che non era preciso), oppure Hansen aveva ragione e Hausfather torto. Tertium non datur.

Voi volete la botte piena e la moglie ubriaca.

L’ultima tua frase poi…

“E poi… accusare gli altri di essere negazionisti e che le proprie non sono opinioni… please…”

… vuol dire che non hai capito NULLA! Io non ho accusato nessuno di essere negazionista, tanto meno Caserini!… ma dai!… ma quante lucciole per lanterne riesci a prendere in una notte? Questa me la incornicio. 🙂

Le mie non sono opinioni perche’ non ho fatto altro che linkare G. Schmidt in video e testo trascritto!… sono LE SUE OPINIONI, casomai.

Ripijate.

A Robe’, dai non scaldarti, perchè t’accolori così? Vero è che post come questo dimostrano che hai torto ad avercela tanto coi modelli, ma non prendertela sul piano personale, non l’hanno pubblicato per dare fastidio a te.

Il problema per come lo vedo io è solo che ti mancano i fondamentali e cerchi di supplire con la presunzione. Senza acrimonia, se non riesci a capire la differenza fra il modello di Hansen e quelli moderni, le tante informazioni che forniscono in più.. nonostante che sulle T medie globali anche il modello di Hansen se l’è cavata bene… io non ce l’ho il tempo di spiegarti tutto.

Visto che fai l’hobbysta del clima, fatti un giro a qualche convegno di modellisti del clima, ce ne sono di validi, se ti servono suggerimenti dimmi pure; se poi non capisci quando fanno le presentazioni, magari nel coffee break puoi fare le domande e magari mangi la foglia.

Good luck!

“Se l’hai postato per smentire quello che dice Gavin Schmidt e che io ho riportato hai fatto flop.”

No, RobertoK (e mi tocca rifar notare ai moderatori che il mio nickname non è il derogatorio “Alsy”, ma Alsarago58), non tutto ruota intorno a te, anche se ormai questo blog pare lo faccia.

Ho segnalato quella ricerca per indicare che i modelli hanno margini che vanno nei due sensi, e che quindi non è detto che siccome sono “incerti”, il futuro sarà sicuramente più roseo, potrebbe anche essere più plumbeo di quanto la linea mediana dei modelli indichi.

Secondo Caldeira & C, quello è anzi l’outcome più probabile.

Bene quindi perseguire la transizione energetica verso un mondo senza fossili, come ragionevole misura precauzionale, che diventa ancora più razionale se si considerano tutti gli altri vantaggi aggiuntivi che questa mossa (da minore inquinamento e acidificazione dei mari alle minori tensioni geopolitiche) comporta.

PS: un giorno forse ci spiegherai come studieresti te il clima, costruendo la famosa Terra 2 per farci esperimenti? O ne vieteresti lo studio fino a che non si ottengano risultati al 9 sigma?

Robertok06 sembra essere un frequentatore di Climatemonitor

http://www.climatemonitor.it/?p=46689

,noto sito negazionista per eccellenza che è arrivato a scrivere “perle” come questa:

http://www.climatemonitor.it/?p=44241

Non mi sorprende che se la prenda tanto cercando di screditare questi grafici.

robertok06

“Non mi sogno nemmeno di scrivere a Hausfather!”

Però nel primo commento che fai al post di Hausfather metti in dubbio la conclusione del suo articolo. Devo dedurre che hai paura a confrontarti direttamente con lui?

“In compenso tu non sei in grado di replicare QUI A ME sui miei ben documentati e circostanziati appunti/commenti”

Ma non si era partiti (cioè, TU sei partito) mettendo in dubbio la conclusione dell’articolo di Hausfather? Critichi la conclusione di un articolo senza nemmeno sognarti di farlo direttamente all’autore dello stesso articolo e poi pretendi che un altro (cioè ill sottoscritto) replichi alle tue critiche? Logica, questa sconosciuta.

PS: sei tu che affermi che la climatologia sia una scienza esatta. E poi pretendi che – siccome per te lo è – sia possibile compararla con la fisica delle particelle.

Sono solo io a vederci un perfetto esempio di straw man fallacy?

E con questo, se passa, concludo…

————-

@antonio

Non mi scaldo per nulla, non preoccuparti. Sono e resto on-topic, io. 🙂

Non ci vogliono dei fondamentali molto sofisticati per rendersi conto delle lacune profonde di tutti i modelli climatologici attuali.

Ovviamente i modelli di oggi sono un notevole passo in avanti rispetto ai modellini di 30 e piu’ anni fa… ci mancherebbe!… hanno codici dell’ordine di 1 milione di righe… sarebbe ben strano il contrario. Cio’ non toglie che restano ancora lacunosi, imprecisi, approssimati, etc… Lo dicono loro stessi, gli autori dei vari moduli… vedi qui sotto per PISCES-v2 e CLM4, dopo quello che ho scritto ieri per altri moduli.

Io sono e restero’ un climatologo wannabe per hobby, ma noto CON DISPIACERE come nessuno dei climatologi di professione, come te, qui presenti sia in grado di smentire quanto riporto “verbatim”, come si dice, pubblicato su letteratura peer-reviewed, rimanendo on-topic con la discussione.

Solo attacchi personali al sottoscritto, completamente off-topic.

Non sembri avere altri argomenti, non fai una bella figura.

———-

@alsarago58

Non essere ridicolo, alessandro: non c’e’ nessuna derogazione nel mio usare “alsy”. E’ affettivo, noi ci conosciamo dal 2010. Stai cercando di rifarti una verginita’ qui, dove non ti conoscono ancora… facendo finta di sentirti ferito da questo… mentre su altri blog chiami il sottoscritto “trumpino”, “negazionista”, “amico della lobby dei fossili”, e mi dai dell’alcolizzato, e altro. E’ vero o no?

L’articolo che hai linkato, che purtroppo non riesci a capire, e’ basato sugli stessi modelli degli altri, che come ho dimostrato sono altamente imprecisi. Quindi e’ anche lui affetto dagli stessi notevoli limiti, non e’ ne’ piu’ giusto ne’ piu’ sbagliato. Uguale. Inaffidabile.

Tanto per dire qualcosa ON-TOPIC, l’articolo peer-reviewed del 2015 che descrive PISCES, il modulo per la bio-geochimica degli oceani… “PISCES-v2: an ocean biogeochemical model for carbon and ecosystem studies”, utilizzato dalla gran parte dei modelli citati nel tuo articolo, dice questo:

“PISCES is still in a phase of active development despite the fact that its development started more than 10 years ago. AVENUES FOR FUTURE IMPROVEMENTS ARE LARGE AND NUMEROUS AND CONCERN ALL ASPECTS OF THE MODEL.

…

Setting priorities in a long list of potential NECESSARY MODIFICATIONS is a rather DIFFICULT TASK which relies not only on the diagnostic of the MAJOR DEFICIENCIES OF THE CURRENT MODEL but also on the FUTURE RESEARCH SCOPE envisioned for the model.”

Ha “major deficiencies”… e “necessita modifiche”… e altro, lo dicono i suoi autori, non io! Ovviamente tu, dall’alto del tuo diploma di scuola media superiore, queste cose non riesci a capirle. Sono anni che ti dico che devi studiare un bel po’, ma non mi ascolti.

Ad ogni modo non mi sorprendi piu’: sono 7 anni che tu, diplomato di liceo o istituto tecnico, cerchi di insegnare a me, che sono fisico e faccio ricerca scientifica da 30 anni, in materia di energia nucleare, tanto per fare un esempio. E’ un mondo alla rovescia, il tuo.

——–

@jerry

Mi mancava lo stalker!… 🙂

Se puo’ risollevarti il morale ed evitare altre ricerche su di me posso dirti che vado piu’ o meno regolarmente a leggere e postare anche sul blog di steph, qui presente, su quello di Euan Mearns, su quello di antonio cianciullo su Repubblica (dove ho conosciuto alsy), e su qualenergia. Ah… anche su quello di ocasapiens, e un paio di volte quello di Tamino e di Ugo Bardi. In passato ho anche scritto, come alsarago58, su alcuni blog del Fatto Quotidiano, in materia di energia. Il blog di Judith Curry, invece, lo leggo ma posto molto di rado: occhio che Judith e’ una vera negazionista… purtroppo per te/voi ha anche un CV lungo un chilometro, in materie di interesse in climatologia. 🙂

Ora… se hai qualcosa da dire on-topic sui modelli climatologici dilla, senno’ ti consiglio di applicare la celebre “un bel tacer non fu mai scritto”. Ciao.

——–

@steph

“PS: sei tu che affermi che la climatologia sia una scienza esatta. ”

???

Hai bisogno di ferie, steph?

Ho scritto esattamente IL CONTRARIO di quanto tu mi attribuisci.

Cerca almeno tu di non trasformarti in troll, per favore. Grazie.

On-topic!… On-topic!… prima che ti bannino. 🙂

Il topic qui e’ l’accuratezza dei modelli, non la tua/vostra opinione sul sottoscritto.

Per esempio, per restare on-topic, CLM4, il modulo che si occupa in molti dei modelli utilizzati nello studio linkato da alsarago58, viene giudicato cosi’ su Geosci Model Dev:

https://www.geosci-model-dev.net/10/3499/2017/

“D-CLM4.5 generally overestimated gross primary production (GPP) and ecosystem respiration, and underestimated net ecosystem exchange (NEE).

In D-CLM4.5, initial above ground biomass in 1980 was largely overestimated (between 10 527 and 12 897 g C m−2) for deciduous forests, whereas above ground biomass accumulation through time (between 1980 and 2011) was highly underestimated (between 1222 and 7557 g C m−2) for both evergreen and deciduous sites due to a lower stem turnover rate in the sites than the one used in the model.”

Un po’ sovrastima un altro po’ sottostima… qui ha cannato di parecchio (“largely overestimated”) su un periodo di soli 31 anni, 1980-2011… secondo te si puo’ concludere che sia accurato e affidabile su scale di secoli? Ma dai!

Steph… non devi mai dimenticare le profetiche parole di Richard!

“It doesn’t matter how beautiful your theory is, it doesn’t matter how smart you are.

If it doesn’t agree with experiment, it’s wrong.”

Ciao.

RobertoK

1) Certo che ti ho chiamato in quel modo, e anche peggio, quando su altri blog ti scatenavi in girandole di insulti verso quelli che non la pensavano come te (fortunatamente,visto che, fra l’altro, prima del referendum 2011 volevi a tutti i costi che l’Italia acquistasse gli Epr-sòla…). Purtroppo non li ho conservati quei tuopi forbityi interventi, magari, ora che sei diventato “buono” (altrimenti ti bannano…), ti saresti rinfrescato la memoria e capiresti perchè io non provi alcun “affetto” verso di te e pretendo che tu rispetti gli altri secondo le regole del blog dove ti trovi.

2) Io non sono un fisico, ma non pretendo di dare lezioni ai fisici, che fra l’altro in gran parte appoggiano il mainstream climatico. Mi limito a fidarmi, citandoli, di quelli che la climatologia o le energie rinnovabili le conoscono bene, avendole studiate per decenni, e che, ormai a livello planetario, ci spiegano i pericoli legati al cambiamento climatico e le strategie per cercare di limitare i danni. Del resto non è che da una parte ci sei tu, paladino della scienza, e dall’altra una pletora di stregoni. Diciamo che da una parte ci sei tu, pochi ricercatori, e una pletora di ciarlatani e burattini delle lobby fossili, Trump in testa, e dall’altra il mondo scientifico quasi al completo. Fra l’altro, che io sappia, tu ti occupi di sistemi a vuoto e a basse temperature, sei un supertecnico, non il mancato premio Nobel che, a sentirti, sembri essere.

Quando dovrò costruire un sistema di raffreddamento ad elio liquido per il mio frigorifero, non ti preoccupare, penderò dalle tue labbra.

Sui sistemi climatici e sul mondo dell’energia, se permetti, mi fido di più dei veri esperti, che di uno che della crociata antimainstream climatico/energetico, pur non avendo nulla da dire che i veri ricercatori del settore non sappiano già, ha fatto una ragione esistenziale, imperturbabile alle cantonate, gli errori e le dichiarazioni ridicole, fatte in questi anni.

@robertok06

Dici a tutti che di scienza non capiamo nulla, ma cosa dire di te che sottoscrivi idiozie come quell’ articolo di Climatemonitor “Eppure la pausa c’è”, che non nega solo l’effetto antropico del GW,ma persino che il GW esiste. Roba da ripetere la terza elementare per mancanza di basi di aritmetica.

Comunque che stia zitto me lo dovrà semmai dire un moderatore di CA non tu che sei semplice ospite. Sui modelli direi che il post e i dati parlano da soli,non c’è niente da aggiungere da quanto detto sopra.

Molto interessante questo articolo e che si contrappone in maniera direi eloquente e convincente a tutta una serie di critiche, più o meno serie, che provengono con una certa insistenza dagli ambiti scettici e negazionisti. L’ho già detto e lo ripeto, affermare in continuazione che i modelli climatici non possono essere perfetti e che sono soltanto delle approssimazioni, così come se si fosse scopritori di chissà quale verità, è cosa assolutamente banale e completamente inutile e sterile dal punto di vista della scienza e della ricerca, in quanto gli scienziati sono già perfettamente consapevoli di questo aspetto critico. La frase chiave in questo senso è scritta peraltro chiaramente anche in questo articolo, nelle conclusioni: “I modelli sono tutt’altro che perfetti e continueranno a essere migliorati nel tempo “. Detto questo, rimane però il fatto che i modelli climatici sono tutto quello che abbiamo per tentare di fare delle predizioni per il futuro e comunque stanno dimostrando, e lo si evince anche da quanto riportato nell’articolo, una discreta conformità con quanto osservato e soprattutto una coerenza di scenari proposti. Il problema piuttosto è, che se qualcuno invece pensa ancora che da questi modelli debba saltare fuori quale sarà l’esatta temperatura globale dell’anno 2034, per esempio, alla stregua di come si prevede un’eclissi di Sole, probabilmente ha capito ancora poco di come funziona la scienza dei sistemi complessi e della differenza che esiste tra meteorologia e climatologia. Ho provato a definire che cosa sia e come debba essere affrontato epistemologicamente un sistema complesso in un un intervento di qualche tempo fa, nonostante le soggettive, vaghe e fuorvianti critiche apportate dall’utente Robertok06, che si è limitato a definire quanto da me detto “stupidaggini”, senza argomentare minimamente.

E mentre c’è chi, stravolto dal suo bias, ci continua a riportare in discussioni inutili su caratteristiche e limiti dei modelli climatici conosciuti da tutti, climatologi in testa, la realtà va nella direzione che, purtroppo, indicano i modelli.

These weather events turned extreme thanks to human-driven climate change

NEW ORLEANS — For the first time, scientists have definitively linked human-caused climate change to extreme weather events.

A handful of extreme events that occurred in 2016 — including a deadly heat wave that swept across Asia — simply could not have happened due to natural climate variability alone, three new studies find. The studies were part of a special issue of the Bulletin of the American Meteorological Society, also known as BAMS, released December 13.

These findings are a game changer — or should at least be a conversation changer, Jeff Rosenfeld, editor in chief of BAMS, said at a news conference that coincided with the studies’ release at the American Geophysical Union’s annual meeting. “We can no longer be shy about talking about the connection between human causes of climate change and weather,” he said.

For the last six years, BAMS has published a December issue containing research on extreme weather events from the previous year that seeks to disentangle the role of anthropogenic climate change from natural variability. The goal from the start has been to find ways to improve the science of such attribution, said Stephanie Herring of the National Oceanic and Atmospheric Administration’s National Centers for Environmental Information in Boulder, Colo., who was lead editor of the latest issue.

To date, BAMS has published 137 attribution studies. But this is the first time that any study has found that a weather event was so extreme that it was outside the bounds of natural variability — let alone three such events, Herring said.

In addition to the Asia heat wave, those events were the record global heat in 2016 and the growth and persistence of a large swath of high ocean temperatures, nicknamed “the Blob,” in the Bering Sea off the coast of Alaska. The unusually warm waters, which lingered for about a year and a half, have been linked to mass die-offs of birds, collapsed codfish populations in the Gulf of Alaska and altered weather patterns that brought drought to California.

Many of the other 24 studies in the new issue found a strong likelihood of human influence on extreme weather events, but stopped short of saying they were completely out of the realm of natural variability. One study found that an already strong El Niño in 2016 was probably enhanced by human influence, contributing to drought and famine conditions in southern Africa. Another reported that greenhouse gas–driven warming of sea surface temperatures in the Coral Sea was the main factor driving an increase in coral bleaching risk along the Great Barrier Reef. But not all of the studies linked 2016’s extreme events to human activity. Record-breaking rainfall in southeastern Australia between July and September, for example, was due to natural variability, one study found.

With hurricanes, wildfires and drought, 2017 is chock-full of extreme event candidates for next year’s crop of BAMS attribution studies. Already, the likelihood of human influence on the extreme rainfall from Hurricane Harvey is the subject of three independent studies, two of which were also presented at the American Geophysical Union meeting. The storm dropped about 1.3 meters of water on Houston and its surrounding areas in August. The three studies, discussed in a separate news conference December 13, found that human influence probably increased the hurricane’s total rainfall, by anywhere from at least 15 percent to at least 19 percent.

“I think [the BAMS studies] speak to the profound nature of the impacts we’re now seeing,” says Michael Mann, a climate scientist at Penn State who was not involved in any of the studies. But Mann says he’s concerned that many researchers are too focused on quantifying how much human influence was responsible for a particular event, rather than how human influence affects various processes on the planet. One example, he notes, is the established link between rising temperatures and increased moisture in the atmosphere that is also implicated in Hurricane Harvey’s extreme rainfall.

Another possible issue with attribution science, he says, is that the current generation of simulations simply may not be capable of capturing some of the subtle changes in the climate and oceans — a particular danger when it comes to studies that find no link to human activities. It’s a point that climate scientist Andrew King of the University of Melbourne in Australia, who authored the paper on Australia’s rainfall, also noted at the news conference.

“When we find no clear signal for climate change, there might not have been a human influence on the event, or [it might be that] the particular factors of the event that were investigated were not influenced by climate change,” he said. “It’s also possible that the given tools we have today can’t find this climate change signal.”

Rosenfeld noted that people tend to talk about the long odds of an extreme weather event happening. But with studies now saying that climate change was a necessary condition for some extreme events, discussions about long odds no longer apply, he said. “These are new weather extremes made possible by a new climate.”

Citations

S.C. Herring et al, eds. Explaining extreme events from a climate perspective. Bulletin of the American Meteorological Society. December 2017.

@ vomiero

“Detto questo, rimane però il fatto che i modelli climatici sono tutto quello che abbiamo per tentare di fare delle predizioni per il futuro”

il suo intervento è condivisibile, ma la frase che ho ricopiato no.

In realtà anche se non disponessimo dei modelli basterebbero delle considerazioni relativamente semplici sul bilancio energetico globale (look at the big picture! scriveva qualcuno) per ottenere delle stime ragionevoli sul riscaldamento che ci attende; stime che infatti furono redatte dai pionieri di questa scienza e che alla prova dei fatti hanno dimostrato la loro validità.

Incidentalmente, questo è il motivo dell’accanimento dei deniers sui modelli e sulle loro imperfezioni (particolarmente evidenti sulle piccole scale spaziali e temporali): distrarre l’attenzione dalla big picture che è chiarissima da almeno un secolo a questa parte.

robertok06

Ma se anche per te la climatologia non è scienza esatta, perché allora pretendi di comparare previsioni di una scienza non esatta con quelle di una “scienza (praticamente) esatta” come la fisica delle particelle? O lo è e allora va bene comparare o non lo è e allora non ha alcun senso. Delle due l’una, non si scappa.

homoereticus

Sono totalmente d’accordo con te. Anche senza tornare al 19esimo secolo, basterebbe anche solo riesumare il Manabe e Wetherald 1967. Mi sono ricordato che ci voglio scrivere un post in omaggio al cinquantesimo di quello splendido e seminale lavoro.

Concordo Homoereticus con la sua precisazione.

A proposito di modelli climatici, forse può interessare anche questo recente lavoro apparso su Nature: http://www.nature.com/articles/nature24672

Certe volte, però, bisogna dire che i climatologi se le vanno a cercare le critiche riguardo al fatto che i loro modelli climatici sono dei voli di fantasia….questi scienziati inglesi li hanno usati per simulare il clima nel mondo del Trono di Spade….

Scientists simulate the climate of Game of Thrones

Some even have their own theories for what causes the strange extended seasons in that world of dragons, kings, queens, and magic.

But scientists from the Universities of Bristol, Cardiff, and Southampton have gone one stage further, by using a Climate Model to simulate and explore the climate of the world of Game of Thrones.

The results show that The Wall, where the land of Westeros is guarded from the White Walkers, has a climate in winter similar to that of Lapland, whereas Casterly Rock, the stronghold of the scheming Lannisters, has a climate similar to that of Houston, Texas, and Changsha in China.

The wind speeds and directions predicted by the climate model explain phenomena such as the dominance of the seas by the Iron Fleet, the likely attack plans of invading dragon hordes from Essos, and the trading routes between Westeros and the Free cities across the Narrow Sea.

The temperatures predicted by the climate model indicate the likely hibernation zones of White Walkers in summer.

The full results are published in a mock journal article (also available in Dothraki and High Valyrian), written by Samwell Tarly, who is studying to become a “Maester” in the Citadel in Oldtown in Westeros.

Samwell shows that the extended seasons can be explained by a ‘tumbling’ of the tilt of the spinning axis of the planet as it orbits the Sun, in such a way that that the same Hemisphere always tilts towards the Sun.

He also models the global warming that would occur if concentrations of greenhouse gases in the atmosphere were to be doubled (due to increases in carbon dioxide and methane emissions from dragons and the excessive use of wildfire).

His estimate of 2.1oC global warming for a doubling of carbon dioxide (the “Climate Sensitivity” of the world of Game of Thrones) is within the range predicted by the Intergovernmental Panel on Climate Change for the ‘real’ Earth, of 1.5 to 4.5oC.

Professor Dan Lunt, from the School of Geographical Sciences and Cabot Institute at the University of Bristol said: “Because climate models are based on fundamental scientific processes, they are able not only to simulate the climate of the modern Earth, but can also be easily adapted to simulate any planet, real or imagined, so long as the underlying continental positions and heights, and ocean depths are known.”

Professor Carrie Lear from Cardiff University added: “This work is a bit of fun, but it does have a serious side. Climate models simulate real physical processes which operate in both cooling and warming climates. Scientists working on the SWEET projectt are using exciting novel techniques to reconstruct the climate of super-warm states of Earth’s past.

“They are using this information to test state-of-the-art climate models under conditions of high atmospheric carbon dioxide concentrations, similar to those expected by the end of this century.”

Professor Gavin Foster, from the University of Southampton, said: “The Intergovernmental Panel on Climate Change have shown that climate models can successfully simulate climates from the freezing world of the last Ice Age, to the intense warmth of the ‘Eocene greenhouse’, 50 million years ago. These same models are then used to simulate the future climate of our planet.”

Articolo interessante.

Due considerazioni/domande:

1. Perché la sensibilità climatica è un parametro di input del modello? Mi aspetterei che i modelli siano utilizzati proprio per stimarla.

2. Esiste uno studio focalizzato esclusivamente sulle forecast? Ho fiducia nei vari esperti di modelli, sono confidente che riusciranno a regolare i parametri dei modelli in modo da produrre ottime hindcast, ma quello che conta secondo me sono le forecast.

agrimensore g

1- lo è solo nei modelli più semplici, come nei modelli a bilancio di energia utilizzati per es. da Broecker 1975. Nei più complessi e moderni modelli che accoppiano oceano e atmosfera molte grandezze come la sensibilità climatica sono proprietà emergenti che caratterizzano il modello stesso.

http://www.euanmearns.com/wp-content/uploads/2014/06/CMIP5-90-models-global-Tsfc-vs-obs-thru-2013.png

Gentile Aldo, se il suo obiettivo è quello di “dimostrare” che i modelli hanno fallito clamorosamente, questo è il solito trucchetto di considerare i grafici fino all’anno 2013, anno durante il quale è terminata la fase di apparente riduzione del rateo di crescita delle temperature globali, che si protraeva dall’anno 2002, grossomodo. Provi un pò a inserire anche gli ultimi tre anni allora, 2014-2015-2016 e anche il dato del 2017, quando sarà disponibile, e vediamo poi cosa succede… Si accorgerà che le cose cambiano decisamente.

Si potrebbe fare il gioco del “trova le differenze” fra il grafico mostrato da Aldo e quello mostrato in questo post.

[…] si sbaglia. Abbiamo già trattato più volte questo tema, ad esempio in questo post approfondito: Con quale precisione i modelli climatici hanno previsto il riscaldamento globale? L’articolo citato in fondo alla slide, “Assessing atmospheric temperature data sets for climate […]

Grazie per l’articolo, molto esauriente. È fondamentale tenere bene a mente che il clima è in continuo cambiamento, e lo è per colpa nostra. Speriamo che i governi si mettano finalmente in carreggiata e attuino politiche ambientali strutturate!

Buongiorno a tutti,

mi rendo conto che la discussione data alcuni anni, ma i temi mi paiono ancora decisamente attuali.

Vorrei chiedere, a chi sapesse rispondere, senza alcuna pretesa di affermare concetti o mie idee, ma solo cercando di capire meglio, se qualcuno sa come viene fattorizzato l’elemento CO2 all’interno dei modelli climatici predittivi (scusate la probabile imprecisione del termine).

Ho infatti reperito questo interessante studio/tutorial che, semplificando, mostra come le concentrazioni di CO2 diventerebbero via via ininfluenti sulla capacità di bloccare i raggi infrarossi, e dunque come in sostanza influenzerebbero marginalmente l’effetto serra e quindi il riscaldamento globale.

Ovviamente immagino questo sia solo un aspetto della questione, ma siccome oggi tutto il pensiero è orientato a puntare il dito sulla CO2 quale fattore scatenante e prevalente dei cambiamenti climatici, sarebbe interessante provare a capire meglio se e come queste considerazioni – supposto che abbiano basi scientifiche solide (cosa che nn so verificare) – siano fattorizzate nei modelli o meno.

http://www.energyadvocate.com/co2_clim.pdf?fbclid=IwAR1gXGOnmp7tgS9wfMFKi4k64XwjtdR4gqzjqoCWTXVQn7wSy8H3WBHcFII

grazie in anticipo a chi potrà fornire dei chiarimenti a riguardo

Grazie antus77 per l’importante contributo all’accrescimento della Montagna di M. [1].

Autore dello “interessante studio/tutorial” Howard Hayden = Heartland institute = spudorato negazionismo.

Altre lodi sperticate su http://whatsupwiththatwatts.blogspot.com/2014/03/hayden-disproves-global-warming-claims.html

Saluti.

R

——-

1: https://aguarax.tumblr.com/post/617091316380254208/ogni-tanto-va-riproposto-la-teoria-della-montagna * ;

—

—

*: la TdMdM è quantificata nella Legge di Brandolini: “The bullshit asimmetry: the amount of energy needed to refute bullshit is an order of magnitude bigger than to produce it”. (da wikipedia)

Gentile Sig.R (visto che non usa neppure un nickname),

al di là del sarcasmo e della montagna di M. che mi attribuirebbe di alimentare, ho solo chiesto da profano in materia di capire come i modelli climatologi fattorizzino gli effetti della CO2 in termini di radiazioni IR bloccate e dunque di effettivo indotto effetto serra.

Il documento che ho linkato, di cui non conosco origine o veridicità, mi sembra fornisca delle spiegazioni interessanti (sempre che siano vere) sul meccanismo di funzionamento della CO2 in quanto a effetto serra. Lasciamo da parte un attimo da parte le etichette che classificano tutti come negazionisti o viceversa.

La mia domanda è semplice (forse la risposta meno): in che modo i modelli climatologici più accreditati prendono in considerazione la CO2 e la sua concentrazione in atmosfera? tutto qui.

Non ho pretesa di fare la lezione a nessuno, ma solo di capire meglio.

Grazie a chi saprà contribuire.

@antus77

“La mia domanda è semplice (forse la risposta meno): in che modo i modelli climatologici più accreditati prendono in considerazione la CO2 e la sua concentrazione in atmosfera? tutto qui.”

buongiorno,

non faccio il modellista (qualcuno potrebbe certo fornirle spiegazioni più accurate delle mie) e intendo entrare nella polemica sul famigerato Heartland Institute.

Una risposta sintetica potrebbe essere: i modelli fisico-matematici simulano il comportamento dell’atmosfera (in ogni sua parte: dinamica, termodinamica, fisica delle nubi e delle precipitazioni, scambi con la superficie ecc e ancora ecc.) attraverso le leggi che ci sono note della fisica. La matematica entra in gioco nel risolvere le equazioni che derivano da queste leggi.

Una parte del modello, detta anche “radiation package” naturalmente è dedicata a tutto ciò che attiene l’interazione della radiazione (solare, terrestre, radiazione emessa dalla stessa atmosfera…) con il sistema terrestre e atmosferico, l’interazione con le nubi.

Grandissima è complessità di questi schemi (le indico un link, il primo che mi è uscito da google, solo per darle un’idea: https://www.ecmwf.int/sites/default/files/elibrary/2007/17533-new-radiation-package-mcrad.pdf).

Volendo tentare di semplificare al massimo, lei può immaginare che nei modelli l’atmosfera sia rappresentata da tanti strati “discreti” di atmosfera sovrapposti: ciascuno strato interagisce con gli altri e con la superficie assorbendo, riflettendo, o emettendo radiazione in dipendenza delle caratteristiche dello strato stesso (Temperatura, contenuto e proprietà radiative dei vari gas, compresa certo la CO2, contenuto di goccioline o di ghiaccio ecc) e in funzione di tutte le lunghezza d’onda della radiazione.

Spero di essere stato chiaro. Aggiungo però una considerazione importante: prima ancora che venissero messi a punto i complessi modelli di oggi (richiedenti enormi risorse di capacità di calcolo) la sensibilità climatica era già stata stimata in modo ragionevole sulla base di considerazioni fisiche.

Buongiorno “Antus77” (di solito non rispondo a chi non mette nome e cognome, ma faccio un’eccezione).

In generale suggerisco di non perdere tempo a leggere testi messi assieme da chi si occupa di tutt’altro, vale per questo esperto di accelerazione di particelle subatomiche che scrive di fisica dell’atmosfera come per un dentista che scrivesse un saggio sui vaccini.

Risposte valide alle questioni sollevate le trova qui:

https://www.realclimate.org/index.php/archives/2007/06/a-saturated-gassy-argument/

https://www.realclimate.org/index.php/archives/2007/06/a-saturated-gassy-argument-part-ii/

In Italiano un testo divulgativo sul tema l’aveva scritto Ugo Bardi http://aspoitalia.blogspot.com/2007/12/leffetto-coperta-gi-effetto-serra.html

Per approfondire, il top è ovviamente il cap. 7 dell’AR6-IPCC-WG1

https://www.ipcc.ch/report/ar6/wg1/downloads/report/IPCC_AR6_WGI_Chapter_07.pdf

Antus77

Oltre ai contributi di Stefano, le consiglio anche questo fondamentale testo: troverà tutte le risposte ai suoi dubbi.

https://www.cambridge.org/gb/academic/subjects/earth-and-environmental-science/climatology-and-climate-change/principles-planetary-climate?format=HB&isbn=9780521865562

Concordo col suggerimento di Steph. Chi vuole iniziare ad approfondire seriamente è consigliabile che inizi a usare meno il web e più qualche buon volume sull’argomento.