2017: il riscaldamento prosegue senza sosta

La rituale disamina della stima delle temperature medie globali dell’anno appena terminato mediante l’analisi dei dati grezzi e grigliati NCEP/NCAR mostra come il 2017 non abbia battuto il record stabilito un anno fa dal 2016, ma ci sia andato comunque molto vicino. Infatti, nella classifica degli anni più caldi, il 2017 si colloca al secondo posto, sopra il 2015, e il valore di anomalia , +0,51 °C rispetto al periodo 1981-2010, supera ancora +1°C rispetto all’inizio del secolo. Le considerazioni finali purtroppo confermano quanto già affermato negli anni precedenti.

Da tre anni questo articolo, che ormai tradizionalmente prepariamo commentando l’anno appena trascorso sulla base delle temperature del database NCEP/NCAR, iniziava sottolineando come l’anno appena passato fosse risultato “il più caldo dall’inizio delle misure”, battendo il record di temperatura media globale dell’anno precedente (vedi qui, qui e qui). E, diciamolo, cominciava ormai a diventare un fatto noioso e scontato.

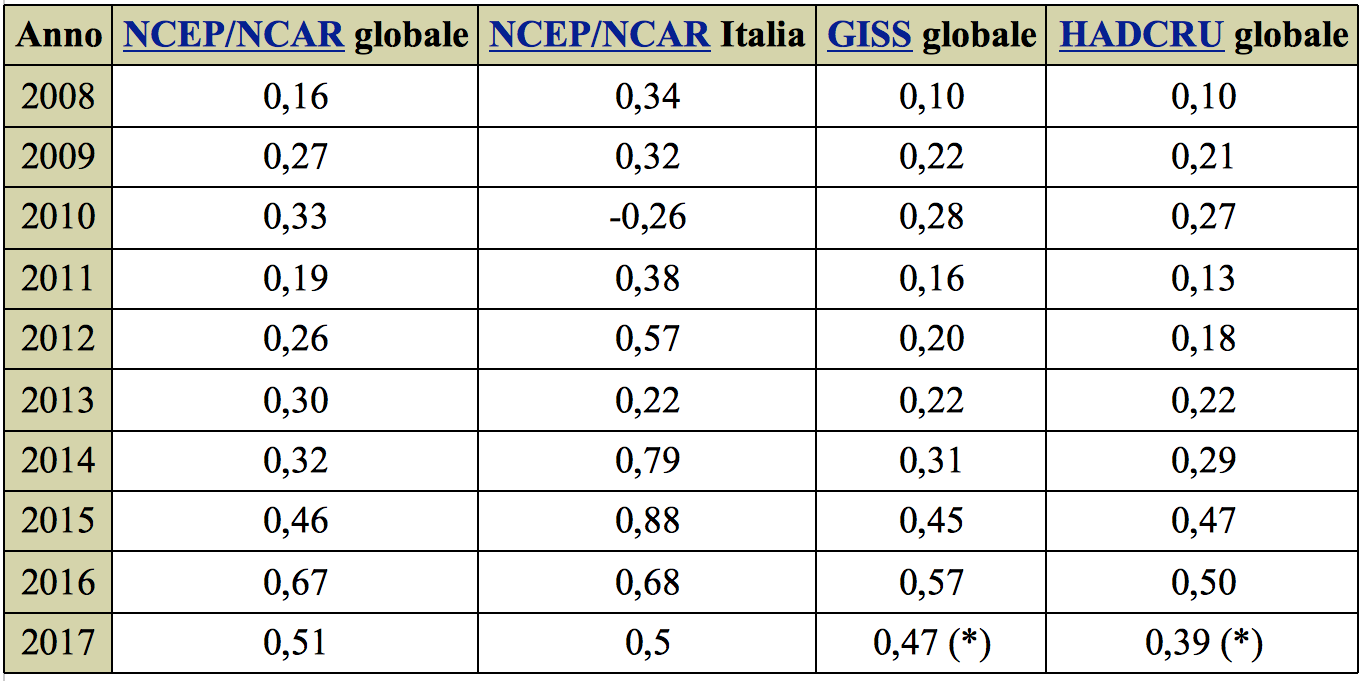

Salutiamo, quindi, come una novità il fatto che il 2017 non abbia battuto per la quarta volta consecutiva il record dell’anomalia di temperatura media globale! Ma non c’è da esultare troppo, tuttavia. Perché, nella speciale classifica degli anni più caldi (tabella 1), il 2017 si piazza al… secondo posto! E considerando che la prima metà dell’anno ha visto un indice ENSO sostanzialmente neutrale o debolmente positivo (fase El Niño), e la seconda metà dell’anno un valore nettamente negativo (fase La Niña), come evidenziato dettagliatamente in questa disamina (ma si vedano anche i nostri articoli al riguardo, qui e qui), questa volta non si può dare la colpa a questa teleconnessione tra oceano e atmosfera.

Notiamo anche come la proiezione ottenuta usando i dati ufficiali dei due database GISS e HADCRU (nei quali, onde ottenere la media annua, è stato usato il valore di dicembre 2016 per sopperire al dato ancora mancante di dicembre 2017) confermino sostanzialmente i valori di anomalia (anche se l’ultimo fornisce un valore inferiore che posizionerebbe il 2017 al terzo posto, dopo il 2016 e il 2015).

Tabella 1: Anomalie di temperatura media globale (in °C) riferite al periodo 1981-2010 per i database NCEP/NCAR (seconda colonna), GISS (quarta colonna) e HADCRU (ultima colonna). Per questi ultimi due database, il valore riportato contiene la media annua calcolata usando l’anomalia di dicembre 2016. Per confronto, la terza colonna riporta le anomalie di temperatura media globale riferite ad un “rettangolo” di globo terrestre contenente l’Italia.

Tabella 1: Anomalie di temperatura media globale (in °C) riferite al periodo 1981-2010 per i database NCEP/NCAR (seconda colonna), GISS (quarta colonna) e HADCRU (ultima colonna). Per questi ultimi due database, il valore riportato contiene la media annua calcolata usando l’anomalia di dicembre 2016. Per confronto, la terza colonna riporta le anomalie di temperatura media globale riferite ad un “rettangolo” di globo terrestre contenente l’Italia.

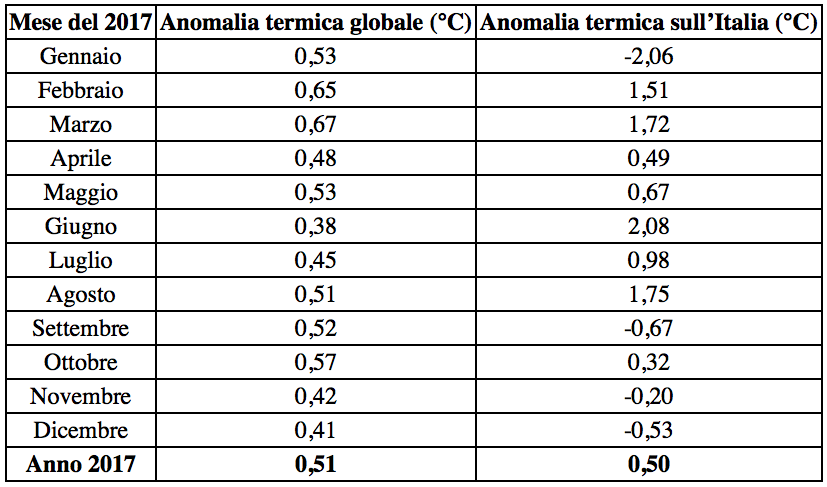

L’analisi delle anomalie termiche globali del 2017 mese per mese (tabella 2, tutte espresse rispetto al periodo di riferimento 1981-2010) mostra come tutti i mesi dell’anno siano risultati più caldi rispetto alla media globale. In particolare, marzo si è distinto come il mese con l’anomalia maggiore e giugno con quella minore, mentre a livello stagionale la parte finale dell’inverno e il periodo agosto-ottobre sono stati quelli con le anomalie maggiori.

Tabella 2: Anomalie di temperatura media (in °C) riferite al periodo 1981-2010 (database NCEP/NCAR) e relative all’intero globo terrestre (seconda colonna) e al “rettangolo” contenente l’Italia (terza colonna).

Tabella 2: Anomalie di temperatura media (in °C) riferite al periodo 1981-2010 (database NCEP/NCAR) e relative all’intero globo terrestre (seconda colonna) e al “rettangolo” contenente l’Italia (terza colonna).

A livello globale l’anomalia del 2017 nel suo complesso (Figura 1) si è manifestata con i massimi più pronunciati, tanto per cambiare, alle latitudini altissime del mar glaciale artico, sopra l’Europa e sopra l’Asia nordorientale, dove si sono superati i +5 °C; anche Europa meridionale, nord America e Asia hanno fatto registrare anomalie positive con isolinee superiori a 1 °C.

Figura 1: anomalie termiche dell’anno 2017 a scala globale (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

Figura 1: anomalie termiche dell’anno 2017 a scala globale (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

L’Italia

Nella tabella 2, a titolo di paragone, sono state riportate le anomalie mensili relative all’Italia (al fine di derivare l’anomalia media sull’Italia, dal momento che i dati usati hanno una risoluzione di 2.5° in latitudine e longitudine, è stato considerato il rettangolo di mondo compreso tra le latitudini 35°N e 47,5°N e le longitudini 7,5°E e 17,5°E). Tali anomalie sono (o dovrebbero essere) quelle che guidano le nostre sensazioni, ed evidenziano come, a differenza di quanto sia avvenuto a livello globale, in quattro mesi (gennaio, settembre, novembre e dicembre) si siano registrate anomalie negative, in quattro mesi anomalie positive ma inferiori a 1°C, e negli altri quattro mesi anomalie positive e superiori a 1°C. In questi mesi, giugno (il mese con l’anomalia minore a livello globale) è stato in Italia il mese più caldo rispetto alla media (tutte le anomalie sono espresse rispetto al periodo di riferimento 1981-2010).

Su un territorio estremamente più ristretto rispetto al globo terrestre, è assolutamente normale che le oscillazioni di temperatura appaiano più marcate rispetto alle medie globali, e non vi è da stupirsi neppure se, in alcuni mesi, esse appaiano anche in controtendenza rispetto alle medie globali. Lo stesso discorso vale anche prendendo in considerazione le medie annue (tabella 1): anche in questo caso si evidenzia come ciò che abbiamo vissuto non sia rappresentativo della media globale, ma rifletta fenomeni ed accadimenti a carattere più locale e regionale.

Vediamo comunque alcuni di questi mesi con le anomalie maggiori che hanno caratterizzato il 2017 in Italia ed Europa (sempre ricordando che il database contiene dati su punti griglia equispaziati di 2,5° in latitudine e longitudine, in linea di massima assimilabili a 250 km circa).

Nel mese di giugno (Figura 2) si è registrata l’anomalia maggiore, con +2,08 °C; dalla figura si può notare come essa abbia coinvolto praticamente l’intero territorio nazionale, con il nord ed il centro Italia, oltre alla Francia ed alla penisola iberica, avvolti dall’isoterma 2°C, e con valori soltanto leggermente inferiori al sud Italia.

Figura 2: anomalie termiche del mese di giugno 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

Per quanto riguarda agosto (Figura 3, anomalia di 1,75 °C), l’Italia centrale ha fatto registrare un’anomalia di oltre 3°C, mentre il resto del territorio ha fatto registrare valori superiori a 2°C, e solo le isole e le Alpi valori inferiori.

Figura 3: anomalie termiche del mese di agosto 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

A marzo, invece, (Figura 4, anomalia di 1,72 °C), il nord Italia, e segnatamente il nordovest, hanno mostrato anomalie superiori a 2,5°C, mentre in Sicilia è stata inferiore a 1°C.

Da notare come, nei tre casi, solo a marzo l’anomalia positiva ha coinvolto praticamente l’intera Europa, mentre negli altri due casi le latitudini più settentrionali hanno fatto registrare anomalie negative anche vistose.

Figura 4: anomalie termiche del mese di marzo 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

Gennaio è invece stato il mese che ha mostrato l’anomalia minore (Figura 5, valore di -2,06 °C); in tale mese, i versanti orientali ed il nord sono stati i più freddi, mentre l’isoterma -2 °C ha diviso l’Italia. Da notare come il nord Europa, in tale mese, abbia sperimentato una vistosa anomalia positiva.

Figura 5: anomalie termiche del mese di gennaio 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

A dicembre (Figura 6, anomalia di -0,53 °C), mese appena conclusosi, tutto il territorio nazionale ha fatto registrare un’anomalia negativa. Anche in questo caso, si possono notare, oltre alle anomalie molto positive alle alte latitudini, i valori superiori a +4 °C in Europa orientale.

Figura 6: anomalie termiche del mese di dicembre 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

Anche settembre (Figura 7, anomalia di -0,67 °C) ha fatto registrare un’anomalia negativa, ma in questo caso con una forte asimmetria sul territorio nazionale, tagliato da molte isolinee. I minimi hanno riguardato l’estremo nordorientale (inferiori a -1 °C), mentre la Sicilia ha mostrato anomalie lievemente positive. A settembre, inoltre, come già accaduto negli altri casi, solo una limitata porzione dell’Europa, quella sudoccidentale (con l’esclusione della Spagna e con una lingua fin sulla Tunisia), ha mostrato anomalie negative.

Figura 7: anomalie termiche del mese di settembre 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

L’Europa

Per quanto riguarda l’anomalia del 2017 nel suo complesso sull’Europa, la situazione è descritta molto bene nella mappa (Figura 8): praticamente tutta l’Europa si è trovata in anomalia positiva, con valori di oltre 1 °C alle alte latitudini, sulla parte sudorientale, e sulla penisola iberica, e poche zone con anomalia inferiore a 0,5 °C.

Figura 8: anomalie del 2017 in Europa (dati NCEP/NCAR, valori in °C riferiti al periodo 1981-2010).

Le precipitazioni

È interessante notare come esista una buona correlazione con la piovosità. Va però notato che la mappa di questa grandezza, mostrata in Figura 9, registrata in questo database come intensità di precipitazione (in mm al giorno), risente ovviamente della risoluzione molto bassa del grigliato e non è in grado di evidenziare gli effetti orografici locali, come nel caso delle Prealpi, per cui va interpretata come segnale a grande scala.

In particolare, si nota come le aree con precipitazioni più abbondanti della norma (Europa centrale e – in parte – settentrionale, Mediterraneo orientale) siano anche state quelle con le anomalie termiche minori. Questo non è dovuto soltanto alla mancata insolazione, ma anche al feedback con l’umidità del terreno (si veda qui per una discussione più approfondita). Si noti che, al fine di interpretare correttamente il segnale della precipitazione, un’anomalia di 0,3 mm/giorno (quale quella, negativa, presente sul mar Tirreno) corrisponde, in un anno, ad un’anomalia complessiva di 120 mm. Inoltre, va detto che una mappa di questo tipo non tiene in conto l’informazione relativa alla tipologia e frequenza delle precipitazioni (come noto, un singolo temporale violento che scarichi decine di mm non compensa mesi di siccità pregressa), e sarebbe più utile analizzare l’umidità del suolo, che tuttavia non è presente su queste mappe (o meglio, la variabile c’è ma il grigliato troppo poco risoluto la penalizza).

Figura 9: anomalie di precipitazione del 2017 in Europa (dati NCEP/NCAR, valori in mm/giorno riferiti al periodo 1981-2010).

Conclusione

In definitiva, la disamina generale di quanto accaduto nell’anno appena terminato, al di là di qualche peculiarità geografica, conferma le tendenze già viste in quasi tutti gli ultimi anni: il riscaldamento globale prosegue senza sosta, specialmente nell’emisfero settentrionale, e le aree prossime al circolo polare artico mostrano le anomalie positive più vistose. La spirale termica (si veda qui) continua ad allargarsi…

Testo di Claudio Cassardo

59 responses so far

Secondo il Nooa a novembre il 2017 era terzo dietro il 2016 e poco sotto al 2015.

Non so se dicembre sia stato così caldo da cambiare questa posizione, a giudicare dalla tabella che avete messo sembrerebbe di no, avendo la minore anomalia positiva dell’anno.

Quindi mi sa che il loro responso finale risulterà diverso dal vostro e più in linea con la situazione effettiva dell’Enso durante l’anno.

Certo, è una questione di centesimi di grado, ma mi chiedo il perchè di questa differenza fra le vostre conclusioni e le loro.

@alsarago58

Il motivo, secondo me, è dovuto all’insieme diverso di stazioni prese in considerazione. Perché, ovviamente, ogni centro sceglie, sulla base di metodologie statistiche complesse, un dato insieme di valori tra le migliaia di stazioni meteorologiche esistenti sul globo terrestre. Tale sottoinsieme deve avere un numero sufficiente di stazioni affinchè il valore medio sia rappresentativo della media globale, ma nello stesso tempo esiguo per non sovrarappresentare le aree con più stazioni.

Per lo stesso motivo, come si vede in tabella 1, i dati HADCRU pongono il 2017 (o meglio il periodo dic 2016-nov 2017, l’ultimo disponibile) al terzo posto, mentre i dati GISS al secondo, come quelli da me considerati. E’ quindi probabile che l’insieme dei dati NOAA sia più compatibile con quelli dei dati HADCRU che con i “nostri” e quelli GISS.

Inoltre, questi sono dati “grigliati”: significa che c’è un’elaborazione sui dati grezzi che risostruisce, su un grigliato regolare ed equispaziato in latitudine e longitudine, i valori delle grandezze, e che tiene anche conto delle uscite dei modelli (specialmente per alcune variabili, non misurate di routine). Il vantaggio di questi dati è che l’elaborazione può minimizzare gli effetti di un eventuale dato erroneo; lo svantaggio è che, trattandosi di dati grezzi (almeno quelli più recenti – i vecchi vengono rielaborati e il database aggiornato in continuo), eventuali errori non sono eliminati.

E’ da una decina di anni che faccio questo tipo di analisi “in anteprima” usando i dati grezzi NCEP/NCAR (disponibili a brevissima distanza temporale) e, fino ad oggi, ho notato che, malgrado qualche differenza rispetto ai valori cosiddetti “ufficiali” di GISS e HADCRU, i responsi non differiscono molto dai report ufficiali (che, richiedendo la verifica dei dati, ovviamente escono più avanti nel tempo).

E’ altresì ovvio che, quando diverse annate hanno anomalie di temperaturea molto ravvicinate tra loro, le “posizioni in classifica” possono essere diverse, così come avviene anche nello sport.

Quello che però è importante non è tanto quale posizione esatta in classifica occupi una determinata annata, quanto il fatto che, sistematicamente, ogni annata vada a posizionarsi sempre ai primi posti. Questo normalmente accade nelle gare di sci, quando i primi a scendere sono i meno bravi: ogni nuova discesa usualmente avviene in un tempo inferiore a quello dell’atleta precedente (salvo errori, sempre possibili, o gare della vita… ma in genere è così).

Pertanto, trasponendo il discorso nelle serie di temperatura, ogni anno nella sequenza risulta “più bravo” dei precedenti a risultare più caldo… Chiediamocene il perché!

Grazie della risposta, sospettavo qualcosa di simile.

Vedremo fra una decina di giorni quale sarà il responso definitivo del Noaa

[…] … continua a leggere su Climalteranti.it […]

Leggo sul blog dell’oca sapiens che questo straordinario risultato sarebbe stato ottenuto così’:

“The method used to produce the datasets is to combine millions of meteorological and marine observations, including from satellites, with models to produce a complete reanalysis of the atmosphere.”

…. cioè una volta di più appoggiandosi ai modellini farlocchi… senza i quali non andate da nessuna parte, per “rianalizzare” l’atmosfera.

Vabbe’, dai.. buon anno a tutti.

Io mi chiedo com’è possibile fare un raffronto con il passato su tolleranze di decimo di grado tra le migliaia di osservazioni digitali terrestri e satellitari attuali e quelle poche decine a mercurio trascritte manualmente del passato …..bah.

macio

si può fare a patto di accettare che l’errore che si commette sulle stime di un secolo fa è ovviamente maggiore.

Figurarsi se il negazionista Robertok06 non doveva intervenire citando la solita cantilena dei modelli farlocchi sempre osannata in quel blog Climatemonitor.

Ormai annoiate con le vostre teorie cospirative.

Bell’articolo!

In accordo il comunicato stampa del C3S di Copernicus per WMO il 2017 continua nell’eccezione calda che é chiaro sintomo di un trend allarmante:

https://climate.copernicus.eu/news-and-media/press-room/press-releases/2017-extends-period-exceptionally-warm-years-first-complete

[…] primi posti consecutivi per il 2014, 2015 e 2016 e un secondo posto per il 2017. La classifica degli anni più caldi offre sempre meno sorprese. Non solo tutti gli […]

@Jerry

Come ho gia’ DIMOSTRATO qui piu’ volte, citando/linkando numerosissimi studi peer-reviewed disponibili in letteratura (ma, occhio!… bisogna riuscire a capirli, quindi ritieniti esentato) sono i modellisti stessi a mettere in luce i notevoli, numerosissimi, a volte insormontabili anche in un futuro remoto LIMITI dei modelli stessi.

Tutti, non ce n’e’ uno che non ne abbia: basta, ripeto, ascoltare e leggere quello che dice Gavino il Modellista, qui… se non credi a me credi a lui, almeno, no?

https://www.ted.com/talks/gavin_schmidt_the_emergent_patterns_of_climate_change/transcript

“The different scales that give you these kinds of patterns range over an enormous range of magnitude, roughly 14 orders of magnitude, from the small microscopic particles that seed clouds to the size of the planet itself, from 10 to the minus six to 10 to the eight, 14 orders of spatial magnitude. In time, from milliseconds to millennia, again around 14 orders of magnitude.

…

The stuff that we can’t resolve, the sub-scale processes, we need to approximate in some way. That is a huge challenge.

Climate models in the 1990s took an even smaller chunk of that, only about three orders of magnitude.

Climate models in the 2010s, kind of what we’re working with now, four orders of magnitude.

We have 14 to go, and we’re increasing our capability of simulating those at about one extra order of magnitude every decade.

One extra order of magnitude in space is 10,000 times more calculations.

And we keep adding more things, more questions to these different models.”

14 ordini di grandezza “to go” e UN ordine di grandezza in piu’ di velocita’ di calcolo acquisito ogni DIECI ANNI: e’ una ri-definizione del concetto di “mission impossible”.

Ovviamente nel campo dell’ideologia tutto e’ possibile, ma in campo scientifico e’ diverso, credimi.

Ciao.

@riccardo reitano

“macio

si può fare a patto di accettare che l’errore che si commette sulle stime di un secolo fa è ovviamente maggiore.”

E lo fanno? Dove e come?

@Jerry

Caro Jerry, io penso invece che tu sia in grado di comprendere la critica alla modellistica climatica, per quanto poggi su concezioni estremamente raffinate; cercherò di presentartela nella forma più divulgativa possibile.

L’assioma fondamentale ovviamente è

“i modelli (detti anche modellini) climatici sono farlocchi”

quindi non ci prendono mai per definizione. E nel caso si rivelassero per qualche assurda ragione verosimili? Niente paura, c’è una soluzione a tutto.

In questo post https://www.climalteranti.it/2017/11/12/tutti-sulla-stessa-canoa/, in risposta a Stefano Carnevali che faceva notare la sostanziale correttezza di alcuni modelli climatici degli anni Ottanta, scrive Robertok06:

“E quindi? Anche un orologio a lancette fermo segna l’ora giusta due volte al giorno”

Di conseguenza l’assioma fondamentale va così ridefinito:

“i modelli (detti anche modellini) climatici sono farlocchi e se ci prendono è per pura casualità stile orologio rotto”

(commento mio personale: è noto che il clima agisce in base a poche variabili dal comportamento ripetitivo e prevedibile e non tramite molteplici anelli di feedback e retroazione, quindi è un gioco da ragazzi darci a caso e creare un modello climatico verosimile, altro che IPCC e teste d’uovo varie della climatologia)

Come ciascuno di voi può facilmente constatare, siamo in presenza di quella che in logica formale si chiama tautologia, ossia un’affermazione sempre vera (con buona pace del falsificazionismo scientifico e popperate varie) quindi il continuo tentativo di smentire la critica del Robertok06 (nonché di Climatemonitor e tutta la compagna cantante) risulta vana e patetica.

Spero Jerry di esserti stato di aiuto e di averti fatto capire che (come dice Zichichi) “questa è scIenza” (mica ideologia!)

robertok06

ti sorprende che l’abbiano fatto? Forse sono un po’ “meno pessimi” di quanto credi 😉

Igor Giussani

“è noto che il clima agisce in base a poche variabili dal comportamento ripetitivo e prevedibile e non tramite molteplici anelli di feedback e retroazione”.

Trovo questa affermazione davvero sorprendente. Forse nemmeno robertok06 arriva a tanto.

@Igor Giussani

Sì, ricordo perfettamente le trollate di Robertok06 sull’orologio rotto.

In realtà qui il margine di errore è abbastanza contenuto, abbiamo dati di 11 mesi e stiamo smussando il dodicesimo, il fatto che il 2015 e il 2017 siano molto vicini come temperatura media annuale non cambia molto la sostanza, è praticamente un pari tecnico dentro il margine di errore.

Il fatto che Roberto come i suoi compari di Climatemonitor deve sempre strumentalizzare tutto con il solo scopo di far apparire il GW falso e vedendo continuamente cospirazioni dietro ai dati globali.

Qui invece non c’è il minimo dubbio che il 2017 sarà l’anno più caldo in assoluto fra quelli senza Nino,il che conferma il trend ben descritto nel titolo dell’articolo.

Non vedo spazio per le solite polemiche,ma tant’è ,i tipi di Climatemonitor di questo vivono….

@Riccardo Reitano

Sì, forse ho esagerato, devo darne atto. Allora ridefiniamo così l’assioma fondamentale: “siccome il clima è composto da troppi feedback e retroazioni per essere formalizzati in un modello matematico, allora la climatologia è inutile” (si può accusare di tante cose la critica alla scienza del clima ma non certo di scarsa versatilità nelle argomentazioni! 🙂 )

@Jerry

Cercando di tornare serio: in realtà credo che la critica alla modellistica (e per critica non intendo una onesta analisi mirante al perfezionamento ma semplicemente quella che parte aprioristicamente dall’idea che bisogna dimostrarne la farlecchitudine) rappresenti una serie vittoria (a suo modo) per la scienza del clima. Nel senso che ancora 20-30 anni fa si sentiva dire che “non è dimostrata l’influenza antropica” oggi invece il senso è “l’influenza antropica non si riesce a dimostrare in modo affidabile ->quindi la climatologia è inutile -> quindi è inutile intraprendere azioni contro le emissioni di gas serra”. Una sorta di cambiamento concettuale c’è stato.

@igor giussani, @jerry

Noto, senza alcuna sorpresa, che una volta di piu’ siete incapaci di produrre un commento on topic. L’unica cosa che vi preme e’ di scrivere stupidaggini sul mio conto… ma quanti anni avete? Lo sa, vostra madre, che passate tutto questo tempo su internet? 🙂

Non ho riportato nulla di nulla da Climatemonitor… ho semplicemente riproposto un video con testo trascritto verbatim dove Gavin Schmidt, uno dei massimi modellisti del pianeta, dice che i modelli sono approssimati, anni luce dal poter avere la precisione necessaria a simulare correttamente atmosfera, oceani, litosfera, fenomeni bio-chimici e antropici, per non parlare della semplice variabilita’ naturale tipo ENSO, che e’ sotto- o sovra-stimata a seconda del modellino farlocco utilizzato… e voi dite che sarebbe “scientifico” fare la media di due cose sbagliate, come fanno quando considerano gli “ensembles” di modelli? Ma dai! Ma in quale circo?

Il fatto e’ che nelle 3-4 volte che ho proposto qui il link al TEDx di G Schmidt, solo UNO dei presenti qui ha avuto il coraggio di commentare qualcosa, steph… tutti gli altri o partiti per la tangente oppure con degli ad hominem come fate voi due.

Ripeto: prendetevela con Gavino, io sono il messaggero…

———–

@riccardo reitano

Tutto quello che hai da dire? Io, ovviamente, so benissimo dove cercare l’informazione sul quanto e come gli errori del passato e del presente siano calcolati, quando e’ la temperatura media globale a essere in causa…. speravo solamente che uno che di climatologia chiaramente ne capisce piu’ di me, sei membro del comitato scientifico qui e collabori con skepticalpseudoscience pure, no?… potesse buttar giu’ per macio una risposta un pelino monosillabica, chesso’?… un link ad uno studio scientifico per esempio?… giusto per rompere la monotonia degli interventi ad hominem fissati sul sottoscritto del duo qui sopra?…

Noto, per esempio, che le tabelle di questo articolo riportano valori di anomalia con due cifre decimali… quindi l’errore del calcolo della T media globale sui 510 milioni di km2 del pianeta e’ inferiore al centesimo di grado? Vado bene? Non dirlo a me, dillo a macio che l’ha chiesto… senno’ il blog qui a cosa serve?… a darvi ragione fra di voi?

In attesa di una risposta seria da parte tua, sorprendimi, ti prego… buona serata.

R.

P.S.: tu hai chiesto a aigor prof. di lettere giussani:

“Trovo questa affermazione davvero sorprendente. Forse nemmeno robertok06 arriva a tanto.”

Grazie della stima… che ricambio, ovviamente… ma ti informo che igor, per quanto ignorante in materia di scienza, stava parlando in maniera ipotetica… nemmeno lui puo’ pensare una stupidaggine del genere. Dai!… come fai a non capirlo? 🙂

@Robertok06

Chiedo sommessamente scusa al Dr.Kersevan per aver osato fare dell’ironia spiccia (e soprattuto, come giustamente da lui osservato, alquanto prevedibile) nei suoi confronti, dimostrando immaturità nonché facendo vergognare la mia povera madre. Prometto che mi redimerò e che anzi prenderò a modello le caratteristiche che denotano maggiormente la serietà, la maturità e la caratura accademica del Kersevan, in particolare storpiare i nomi propri degli interlocutori (Aigor, Alsy, Gavino, ecc) ma anche di alcuni nomi comuni (globball uarming, ecc). Devo dire che svariati miei compagni di scuola materna ed elementare evidenziavano i medesimi comportamenti, evidentemente mostravano una maturità ben maggiore della loro giovane età (quelle stupide di maestre invece li accusavano di infantilismo, pensa un po’ te!).

Potrei provare poi nel tentativo di emularti – anche se so di chiedere forse troppo alle mie capacità – di perfezionare le mie qualità nel cherry picking. In ogni caso, spero che tu possa accettare le mie scuse e i miei più sentiti auguri di felice anno.

robertok06

“solo UNO dei presenti qui ha avuto il coraggio di commentare qualcosa, steph”

Visto che mi citi, dirò di più (anche se, per correttezza con il topic, andrebbe detto nell’altro post).

È fuor di dubbio che i modelli abbiano molti seri problemi a simulare parecchie componenti del sistema climatico globale e soprattutto fanno ancora tremendamente fatica a simulare la principale sorgente di variabilità interna, ovvero l’ENSO.

Tuttavia io ribalterei la questione. E, per ri-citare per la zillesima volta Box, guarderei alla loro utilità. Come diceva Caserini nell’altro post (lo cito): “pur se hanno certo molte cose da migliorare i modelli usati già fino ad oggi hanno fatto proiezioni utili, con un buon grado di affidabilità.”

E aggiungo: questo a me interessa. Come mai hanno fatto proiezioni utili? Attraverso quale processo ci sono riusciti (ergo: quali parametri sono stati soppesati meglio e quali meno?) Perché taluni modelli sono più utili di altri?

Non mi interessano le scuse che uno come te potrebbe accampare (come hai già fatto: il caso, la manipolazione dei dati, il gomblotto delle stazioni meteo, etc etc etc).

Ci avevo anche scritto un post , il senso è prettamente euristico.

Igor Giussani

“si può accusare di tante cose la critica alla scienza del clima ma non certo di scarsa versatilità nelle argomentazioni!”

Questa è stupenda, me la segno a futura memoria 🙂

@Riccardo Reitano

Va riconosciuto… non potrò mai scordarmi un lungo scambio di commenti che ebbi con Rinaldo Sorgenti riguardo a un articolo contro le centrali a carbone. E’ stato capace di menzionare a sostegno delle sue tesi dei contenuti di vari blog che sostenevano che: a) non esiste alcun global warming b) il global warming esiste ma la responsabilità è del sole e/o dei raggi cosmici c) il global warming esiste e sono responsabili CO2 e gas serra ma invece di demonizzarlo va incentivato altrimenti rischiamo una nuova era glaciale (un’idea di Patrick Moore); non ricordo se tirò in ballo i modelli, ma sono sicuro che rientrano nel suo armamentario. A parte incoerenza e contraddizione, non è facile fare del debunking in circostanze simili, è come giocare a poker con qualcuno con tanti assi (truccati) nel mazzo.

@ Robertok06

@ Solo UNO dei presenti qui ha avuto il coraggio di commentare qualcosa…

Le assicuro che se non le rispondiamo non è per mancanza di coraggio, ma perché non lo riteniamo utile; in passato le ho risposto diverse volte, e alla fine mi è sempre sembrato che avrei potuto usare meglio il mio tempo.

Potrei certo ad esempio spiegarle, quando chiede “l’errore del calcolo della T media globale sui 510 milioni di km2 del pianeta è inferiore al centesimo di grado?” che non si sta parlando di T assolute, ma di anomalie (variazioni) delle temperature, e linkarle un paio di articoli di esperti del settore che 15-20 anni fa hanno affrontato questi problemi, pubblicato i risultati sulle riviste con sistemi di peer review, ecc.

Ma lascio perdere semplicemente perché sono arrivato alla conclusione che Lei non sia interessato a capire laicamente la sostanza delle cose; e così moti come me.

Le assicuro che ho ricevuto molte richieste dai membri del Comitato Scientifico e di altri lettori del blog, infastiditi dai toni livorosi/offensivi/vittimistici dei suoi commenti (più che dai contenuti scientifici dei suoi argomenti) di escluderla dal blog, o di applicare la regola 7 della netiquette viste le continue violazioni delle regole.

A questo blog le dispute personali non interessano, e pure non è un nostro obiettivo massimizzare i commenti.

Trovo che la risposta del dott.Caserini a Roberto06K sia molto saggia e condivisibile. Il problema è che il dr Kersevan, come molti altri sedicenti scettici e/o negazionisti, crede di aver scoperto l’America quando dice giustamente, anche se in maniera un po’ enfatizzata, che i modelli climatici sono tutti approssimati. E’ ovvio che è così, e la ragione è semplicemente che il clima è un sistema complesso e di conseguenza ogni approccio modellistico non riuscirà mai a cogliere tutti gli aspetti del sistema stesso. Spero sia chiara la differenza che c’è tra un sistema reale complesso (sistema biologico, processo cognitivo, clima ecc.) e i sistemi ideali generalmente studiati dalla fisica classica. Una volta stabilito che i climatologi questo ovviamente lo sanno benissimo, ecco che questa critica diviene di fatto inutile. Tuttavia l’articolo mostra come, nonostante i limiti noti, i modelli servono eccome e i risultati sono anche già abbastanza confortanti. Se poi si vuole fare il cherry picking della letteratura, come ama fare il dr Kersevan, volendo si può mostrare (e mai dimostrare) qualsiasi cosa, anche che il GW dipende dal Sole e dai raggi cosmici (vedi Svensmark) oppure dai moti planetari (vedi Scafetta). Ecco perché esistono le review e le metanalisi.

Scusate, io non sono un fisico dell’atmosfera o un climatologo, ma mi pare di capire che forse il povero RobertoK, impressionato dai “14 ordini di grandezza” necessari a rendere il modelli climatici perfettamente accurati, non si sia ben reso conto che i modelli climatici, in pratica devono, appunto, informarci sul clima futuro (dopo essere stati testati su quello passato), non prevedere il meteo da qui ai prossimi 100 anni, in luoghi specifici della Terra.

Cioè: se volessi sapere la temperatura davanti a casa mia alle 10 del mattino del 4 dicembre 2037, avrei bisogno di modelli che tengano in effetti conto del cambiamento di tutte le variabili comprese fra il singolo nucleo di condensazione presente nell’atmosfera fino all’attività solare, fra oggi e 20 anni nel futuro.

Quello sì che richiederebbe un aumento di accuratezza rispetto ai modelli attuali pari ai famosi 14 ordini di grandezza.

Ma per prevedere quale sarà la probabilità di avere temperature e precipitazioni medie più o meno alte rispetto alle attuali, nel decennio 2030-2040, in un’area grande come tutta la città dove abito, non c’è bisogno di partire dal singolo nucleo di condensazione, e i modelli attuali, per questo livello di risoluzione, sono già più che sufficientemente accurati.

Come del resto si può capire alzando la testa dallo schermo o dalle carte, e guardando cosa sta accadendo nel mondo reale….

@caserini

“A questo blog le dispute personali non interessano, ”

Non lo non dica a me!… Io non ho iniziato nessuna disputa personale, mi sono limitato a citare le parole di uno dei più famosi climatologi e modellisti del pianeta. Rilegga con calma e senza prevenzioni la serie di messaggi.

L’astio e gli insulti… o dare del “negazionista” a qualcuno è un complimento adesso?… vengono dagli altri, io sono nella “receiving end” del processo.

Lo dica a Igor Giussani, e all’utente Jerry, en passant per Riccardo Reitano, magari? Eh? Onestamente, li ha letti i loro commenti esclusivamente su di me, e completamente off-topic?

Se poi voi del comitato pensate che bannarmi sia la soluzione… beh… fatelo, non c’e problema… vi qualifichera’ come contrari alla liberta’ di espressione basata su dati e fatti scientificamente accurati. L’ideale per un blog scientifico, no?

“che non si sta parlando di T assolute, ma di anomalie (variazioni)”

WOW!… e sarei io a fare il cherry picking??? Anomalie=differenze di temperatura rispetto ad un certo valore di riferimento… non cambia nulla… sia serio, Caserini!

Riformulo la domanda: “l’errore del calcolo delle anomalie sui 510 milioni di km2 del pianeta è inferiore al centesimo di grado?”

Si? No? Dipende?

Ad ogni modo, passo e chiudo con questo thread, sono a 5… vorremo mica infrangere le regole ferree del blog, no?

———

@steph

“Tuttavia io ribalterei la questione. E, per ri-citare per la zillesima volta Box, guarderei alla loro utilità.”

A parte che Box si riferiva ad altro, l’utilita’ dei modelli e’ indiscussa… quello che e’ discutibile, e sono in molti a farlo (vedi un n-esimo esempio qui sotto, F. Vomiero) e’ che non e’ scientificamente corretto —- ne’ etico —– attribuire ai modelli suddetti proprieta’ quasi magiche come fate voi: le anomalie di temperatura interpolate su griglie di centinaia di km di lato con precisioni di centesimo di grado. Tutto li.

I modelli, imprecisi, li scrivo/programmo anch’io da 30 anni, so come vanno le cose…. ma non vendo Fiat Panda spacciandole per Ferrari.

———

@fabio vomiero

“Se poi si vuole fare il cherry picking della letteratura, come ama fare il dr Kersevan, volendo si può mostrare (e mai dimostrare) qualsiasi cosa, anche che il GW dipende dal Sole e dai raggi cosmici (vedi Svensmark) oppure dai moti planetari (vedi Scafetta). Ecco perché esistono le review e le metanalisi.”

Hai ragione, non ci sono studi che dimostrano che il sole regola il clima della terra, e che i modelli attuali non riescono a simulare i dati storici e quindi la realta’:

Toh! … vediamo cosa dice questo?

“The primacy of multidecadal to centennial variability over late-Holocene forced change of the Asian Monsoon on the southern Tibetan Plateau”, Earth and Planet Sci Lett 458 2017 p337-348

“20th century precipitation variability in southern Tibet falls within the range of natural variability in the last 4100 yr, and does not show a clear trend of increasing precipitation as projected by models.

Instead, it appears that poorly understood multidecadal to centennial internal modes of monsoon variability remained influential throughout the last 4100 yr.

Thus, substantial multidecadal to centennial-scale hydroclimatic variability will complicate our ability to project and prepare for anthropogenic changes in the region’s monsoon precipitation.”

Fatti sta’ ciliegia, amico. 🙂

———-

@alsarago58

“Ma per prevedere quale sarà la probabilità di avere temperature e precipitazioni medie più o meno alte rispetto alle attuali, nel decennio 2030-2040, in un’area grande come tutta la città dove abito, non c’è bisogno di partire dal singolo nucleo di condensazione, e i modelli attuali, per questo livello di risoluzione, sono già più che sufficientemente accurati.”

Il tuo commento e’ dunning-krugheresco: meteo e clima si basano sulla dimostrazione di Lorenz, che tu dall’alto delle tue NON conoscenze scientifiche non sai neanche chi sia:

“Edward Lorenz’s work placed the concept of instability of the earth’s atmosphere onto a quantitative base and linked the concept of instability to the properties of large classes of dynamic systems which are undergoing nonlinear dynamics and deterministic chaos.”

http://eaps4.mit.edu/research/Lorenz/Predictability_hydrodynamic_flow_1963.pdf

Non a caso Lorenz parlo’ di clima e possibilita’ di prevederlo numericamente… parte finale di questo suo lavoro linkato sopra… fine pag.427 e seguente:

“Can we, for example, predict annual average temperatures many years in advance? Any such function may be appended to the system as an additional variable, and if this new variable is not periodic, it too cannot be predicted at very long range.”

Se sei al corrente di dimostrazioni che provino che Lorenz ha sbagliato fammele sapere, al contrario di te potrei cambiare la mia opinione.

Lo studio e’ unica via d’uscita dall’ignoranza, ricordalo. L’ideologia e’ solo un placebo.

Ciao.

Roberto06k

1)Lorentz 1963? Non le sembra un po’ datato Roberto06K? Eppure lei ci dovrebbe insegnare che la scienza di 50 anni fa non è nemmeno paragonabile a quella di oggi. In ogni caso Lorentz ha gettato le basi per la comprensione e la gestione del caos deterministico e quindi dell’estrema sensibilità alle condizioni iniziali di un modello meteorologico deterministico, non climatico.

2)Mi dispiace Roberto06k ma tempo e clima non sono la stessa cosa e richiedono approcci conoscitivi diversi e modellistica diversa, in quanto gli elementi stessi del sistema sono diversi. Il clima peraltro è un concetto prevalentemente statistico, il meteo prevalentemente deterministico.

3)Non riesco proprio a capire cosa c’entrino i modelli a scala regionale, in questo caso di previsione dell’andamento delle precipitazioni in Tibet, con le mie affermazioni che ha riportato e che quindi avrebbe dovuto commentare coerentemente e invece non ha fatto (Svensmark, Scafetta, raggi cosmici, sole, moti planetari ecc.).

4)Qui mi sembra si stesse parlando di modelli climatici globali (GCM), nonché della loro capacità o meno di simulare l’andamento del parametro “temperatura globale” e quindi di prevederne la dinamica di crescita che peraltro è al momento confermata dalle misurazioni. Quindi qual’è il problema di “farlocchità” di questi modelli? Non le sembra che tutto sommato, ad oggi, stiano già facendo il loro dovere, nonostante i noti margini di incertezza e l’ampio, ma comunque non infinito, margine di miglioramento? Capirei tutta la sua preoccupazione se i modelli andassero da una parte e la temperatura dall’altra…

E gli animali “bollono e friggono”, purtroppo in senso abbastanza letterale:

http://www.newsweek.com/bat-brains-are-frying-sydney-australia-how-much-heat-can-animals-take-775736

Valentino, forse é questa la motivazione….

http://dailycaller.com/2017/07/31/australia-weather-bureau-caught-tampering-with-climate-numbers/

“che non si sta parlando di T assolute, ma di anomalie (variazioni)”

WOW!… e sarei io a fare il cherry picking??? Anomalie=differenze di temperatura rispetto ad un certo valore di riferimento… non cambia nulla…

Provo a dare una spiegazione (magari può interessare a qualcuno che legge questo blog per imparare e/o cercare di capire meglio le faccende climatiche).

L’uso delle anomalie rispetto al valore misurato di una variabile cambia eccome le cose, non è per divertimento che si preferisce spesso il loro utilizzo.

L’esempio più stupido che mi viene in mente è quello di un termometro starato, che magari non misura la temperatura “reale” dell’aria ma che invece può venirmi utile per stabilire se oggi fa più o meno caldo di ieri. La variazione è meno sensibile alla taratura dello strumento.

Con riferimento ai modelli l’uso delle anomalie è ancora più importante. Ciascuno modello del clima globale, se fatto evolvere sufficientemente a lungo genera il suo “clima”, ad esempio la sua temperatura media globale, la sua circolazione generale, la sua distribuzione media delle piogge ecc. Che corrisponda esattamente alla temperatura misurata sulla Terra è relativamente poco importante. Mi interessa invece, e qui diviene utile il mio modello, vedere come risponde al cambiamento delle condizioni al contorno, quali possono essere radiazione,gas serra, polveri, aerosols ecc. Di qui l’importanza di ragionare in termine di anomalie.

Ma quando affermate che i modelli sul clima sono stati utili cosa intendete esattamente? Per me l’efficacia di un modello, inclusi quelli sul clima, si valuta sulla sua capacità predittiva. Una volta che sia stata verificata la sua buona capacità predittiva allora può cominciare ad essere utile.

Se il modello climatico non si può valutare anno dopo anno, a causa di variabilità o altro, allora andrà valutato dopo un tempo pluriennale congruo a partire dal momento in cui è stata effettuata la previsione, o meglio, dal momento in cui è stato congelato il modello (nonchè il sw relativo), nel senso che, volendo, un modello climatico sviluppato (e non più modificato) dal 1987 potrà essere fatto girare oggi, con le relative forzanti già note (effettivi livelli CO2, eruzioni vulcaniche) anche oggi per testarne la capacità predittiva. L’articolo precedente di questo blog, trattava l’argomento, peccato che mescolasse hindcast e forecast. Nel caso dei modelli sul clima, buone performance delle hindcast, testimoniano, al più, il buon lavoro di chi si occupa dei modelli del clima. Se poi c’è qualche fenomeno ancora non noto, qualche feedback che ancora non è stato rilevato, che può compromettere la capacità predittiva del modello, beh, non è colpa di chi ha implementato il modello a partire da paper e studi scientifici vari. A meno che il numero di parametri liberi del modello fosse così basso e le performance delle hindcast talmente eccezionali da rendere quasi non strettamente necessaria la verifica con le previsioni. Ad esempio, se l’unico parametro libero fosse la pdf utilizzata per simulare la formazioni delle nubi e le hindcast riproducessero la temperatura anno per anno e regione per regione al decimo di grado, beh, allora già si può cominciare a pensare che il modello funzioni bene. Però bisognerebbe almeno conoscere il numero dei parametri liberi, che è proprio la domanda posta da Zichichi, il quale, per tal motivo, è stato deriso su questo blog. Con questo non voglio dire che mi attendo che il modello ragioni scomponendo il sistema Terra molecola per molecola, ma solo che va valutato in base alla sua capacità predittiva.

Ciò detto, non penso sia indispensabile attendere l’output sui modelli per intraprendere politiche di contenimento emissioni gas serra, ci sono altri studi nonché leggi della fisica che possono aiutarci a capire (con un certo livello di incertezza) gli effetti della CO2 sul global warming.

P.S.: tutto quello che ho scritto sopra è, ovviamente, una mia opinione

Scendendo dall’empireo dei modelli alla dura realtà ecco il rapporto del Noaa su clima e disastri meteo-climatici negli Usa 2017

http://www.noaa.gov/news/2017-was-3rd-warmest-year-on-record-for-us

negli Usa è stato il 3° più caldo (in Italia il 6°) con tutti i primi cinque anni più caldi arrivati dopo il 2006.

Ma soprattutto è stato l’anno dei disastri meteo estremi (>1 mld di danni): 16 contro una media di 5,6, che hanno causato in tutto 306 miliardi di danni +50% rispetto al 2005 di Katrina.

I morti che hanno causato sarebbero stati 346, ma in realtà ci sono seri dubbi sul numero di morti causati a Portorico dall’uragano Maria: ufficialmente sono stati 64, ma confrontando la mortalità di quel periodo fra 2016 e 2017, i morti, indirettamente attribuibili all’uragano (per esempio per l’impossibilità di usare i condizionatori o le apparecchiature medicali, a causa dall’interruzione di elettricità che interessa ancora metà dei portoricani) sarebbero stati oltre 1000.

Roberto06K

Io ho detto che il meteo, rispetto al clima, è un concetto prevalentemente deterministico, nel senso che l’obiettivo di tale disciplina è certamente quello di fare previsioni deterministiche sul breve termine, risolvendo precise equazioni dello stato dell’atmosfera per simularne l’evoluzione nel tempo. Ho usato peraltro l’avverbio “prevalentemente” proprio perché poi di fatto, soprattutto per migliorare le performance sul medio periodo, vengono usati anche gli ensamble passando quindi ad un approccio più probabilistico. E’ anche vero che poi l’obiettivo di fatto fallisce oltre un certo limite di tempo proprio per l’intervento del citato “butterfy effect” di Lorenz e di altri fattori. Magari può interessarle per esempio questo documento dove potrà anche vedere che, come le dicevo, tutti conoscono i limiti dei modelli: http://www.lamma.rete.toscana.it/meteo/modellistica-numerica-meteorologica

Per favore, Roberto, non faccia passare per stupidi tutti i suoi interlocutori, altrimenti diventa poi difficile discutere con lei.

Ma secondo lei, perché poi si chiamerebbe “caos deterministico” se non avesse a che fare con i modelli deterministici?

http://matematica.unibocconi.it/caos/home.htm

La saluto

Se c’è qualcuno che qui va continuamente off topic quello è proprio Robertok06, io ho espressato le seguenti frasi perfettamente on topic

“In realtà qui il margine di errore è abbastanza contenuto, abbiamo dati di 11 mesi e stiamo smussando il dodicesimo, il fatto che il 2015 e il 2017 siano molto vicini come temperatura media annuale non cambia molto la sostanza, è praticamente un pari tecnico dentro il margine di errore”

e ancora

“Qui invece non c’è il minimo dubbio che il 2017 sarà l’anno più caldo in assoluto fra quelli senza Nino,il che conferma il trend ben descritto nel titolo dell’articolo”

@Robertok06 sei tu che vai off topic poi ci vai dentro con gli attacchi personali.

Qui il discorso sui modelli è abbastanza futile, perchè abbiamo 11 mesi di dati e si tratta solo di approssimarne il dodicesimo dentro un piccolo margine di errore.

In questo articolo si sta facendo un riassunto sul 2017 ,non una previsione del GW nei prossimi anni quindi quello che sta andando off topic caro Roberto sei proprio tu,con la tua minestra riscaldata che ormai conosciamo tutti. Vedi di darti una calmata che qui non siamo su CM dove spadroneggi insultando gli altri utenti a piacimento.

RobertoK, di solito non rispondo ai tuoi deliri, ma questa è troppo bella per passare inosservata

” I modelli non sono in grado di spiegare l’ASSENZA di uragani di categoria sopra alla 3 che fanno landfall sul territorio USA per 11 anni consecutivi… 2005-2016″

(Ti grazio dell’errore di indicare il 2005 nell’intervallo, visto che è stato l’anno di Katrina…).

Gli uragani di massima categoria sono ovviamente sempre rari, e lo sono stati particolarmente in quel decennio.

Quelli di categoria 4 nel 2006-15 sono stati 13, di categoria 5 2, quindi poco più di uno all’anno di media.

Ora, la direzione di un uragano è determinata da eventi meteo casuali ed estemporanei, come la posizione della aree di alta e bassa pressione o la intensità e direzione del jet stream: nessun modello climatico può prevedere dove gli uragani finiranno, ma al massimo tentare di stabilire un numero medio su un lungo lasso di tempo nell’intero bacino oceanico.

E anche questo è complicato, perchè i fattori in gioco nella formazione di uragani sono vari e difficili da prevedere nel loro cambiamento, spesso contraddittorio, legato al clima.

Gli Usa sono una parte consistente delle sponde oceaniche, ma non l’unica dove possono approdare gli uragani e con poco più di un uragano l’anno, non ci sarebbe niente di strano se non ce ne fosse arrivato neanche uno in quel periodo (cosa peraltro non vera, perchè due, Gustave e Ike, sono finiti sugli Usa).

In compenso alcuni di quegli uragani hanno devastato i Caraibi e l’America Centrale in quel periodo: capisco che per te quelle terre e quei popoli non contino nulla, ma erano violenti uragani atlantici pure quelli.

Questa storia degli “uragani che non colpiscono gli Usa”, un tuo evergreen, ricorda tanto quella della “pausa” nel cambiamento climatico: si scelgono le condizioni temporali, di intensità e di direzione in modo opportuno fino a dimostrare la propria, bislacca, tesi.

Intanto un dato certo c’è: nel 2017 3 uragani di massima potenza hanno colpito i Caraibi e poi gli Usa, e questo, in effetti, non si era mai visto da quando si seguono scientificamente questi fenomeni. Sarà legato al cambiamento climatico? O è una vendetta divina contro Trump? Chi lo sa…

Però secondo i climatologi, quelli veri, le piogge causate da Harvey con ogni probabilità non ci sarebbero state senza il cambiamento climatico

https://www.nytimes.com/2017/12/13/climate/hurricane-harvey-climate-change.html

robertok06

“A parte che Box si riferiva ad altro”

Box si sarà anche riferito ad altro ma non credo che questo altro sia così lontano dal contesto di riferimento di cui si sta discutendo.

“l’utilita’ dei modelli e’ indiscussa… quello che e’ discutibile, e sono in molti a farlo (vedi un n-esimo esempio qui sotto, F. Vomiero) e’ che non e’ scientificamente corretto —- ne’ etico —– attribuire ai modelli suddetti proprieta’ quasi magiche come fate voi:”

Ecco, visto che citi sempre il TEDTalk di Schmidt . Non fermarti solo ai primi 3 minuti, vai oltre. Ascolta bene cosa dice lo stesso Gavin a partire più o meno dal minuto 5 quando parla di “kicking the system”.

A proposito: poco dopo il minuto 6 dice testualmente quello che riporto e che mi sembra il succo centrale di tutto il discorso: “models are always wrong, are always approximations. The question you have to ask is whether a model tells you more information than you would have had otherwise. If it does, it’s skillful. A model result is skillful if it gives better predictions than a simpler alternative”.

Come fai a non vederci l’aforisma di Box?

“I modelli, imprecisi, li scrivo/programmo anch’io da 30 anni, so come vanno le cose”

Ecco, se lo sai evita allora argomentazioni da straw man, come il tuo n-esimo esempio.

agrimensore g

“Ma quando affermate che i modelli sul clima sono stati utili cosa intendete esattamente? ”

Io intendo esattamente quello che dice Gavin Schmidt qui sopra. E che con altre parole si diceva anche prima: “pur se hanno certo molte cose da migliorare i modelli usati già fino ad oggi hanno fatto proiezioni utili, con un buon grado di affidabilità.”

@steph

“mi sembra il succo centrale di tutto il discorso: “models are always wrong, are always approximations. The question you have to ask is whether a model tells you more information than you would have had otherwise. If it does, it’s skillful. A model result is skillful if it gives better predictions than a simpler alternative”. ”

Sembra anche a me il punto centrale, giustissimo!!!!! Ad essere puntiglioso, aggiungerei che le “information” devono essere anche corrette, ma evidentemente ciò è implicito nella frase seguente quando parla di “better predictions”.

Allora chiedo (in fondo la stessa domanda che ho posto nel mio intervento precedente): cos’è che hanno previsto i modelli, e che poi si è rivelato corretto, che non avremmo potuto conoscere tramite una “simpler alternative”? Ad esempio, qualche modello ha previsto l’espansione per lungo tempo dei ghiacci marini antartici? In particolare, abbiamo avuto, con ragionevole certezza, una migliore approssimazione della sensibilità?

Ad esempio, dall’articolo precedente, a me pare che i risultati ottenuti da Hansen con un modello a semplice bilancio di energia, siano persino migliori di quelli ottenuti dallo stesso Hansen con un modello climatico di tipo “moderno”.

Al limite, mi pare che il maggior progresso dovuto ai modelli climatici moderni sia proprio quello di aiutare a censire quanto fosse poca conosciuta l’influenza di certi fenomeni sul clima.

Il catastrofismo climatico contagia le roccaforti dell’alta finanza:

http://www.repubblica.it/economia/finanza/2018/01/14/news/climate_change_bofa_merril_lynch-186069812/?ref=RHPPBT-VE-I0-C6-P10-S1.6-T1

“Nel 2016 il clima ha segnato il passo storico: le temperature medie sono risultate di 1 grado più alte rispetto al periodo antecedente l’industrializzazione. Non è solo una questione simbolica: significa che il pianeta è a metà strada verso quella soglia di due gradi di surriscaldamento entro il 2100 che sono visti come livello indicatore di una catastrofe per quanto attiene il cambiamento climatico ….”

“….gli economisti di BofA Merrill Lynch spiegano perché dalla tematica ambientale sarà impossibile scappare. In un report pubblicato a metà dicembre, la grande banca d’affari sostiene che le catastrofi ambientali e in ultima analisi il ‘climate change’ siano il rischio numero uno al mondo. …”

“… la transizione verso la riduzione delle emissioni richiederà 70mila miliardi di investimenti, entro il 2040…

agrimensore g

“Ad esempio, qualche modello ha previsto l’espansione per lungo tempo dei ghiacci marini antartici?”

1) Sappiamo da parecchio tempo che la sensibilità di un modello climatico globale a un aumento del contenuto di CO2 nell’atmosfera ha significative variazioni stagionali e latitudinali. Sappiamo che l’amplificazione delle T di superficie delle zone polari è disomogenea: il riscaldamento del continente antartico è significativamente inferiore rispetto al riscaldamento del mar glaciale artico —> Manabe e Stouffer, 1980.

2) Sappiamo che la riduzione dell’ozono stratosferico, a causa delle interazioni chimico-radiative fra perdita di ozono e risposta dinamica atmosferica, ha portato ad un rafforzamento dei venti occidentali che cingono l’Antartide, in particolare durante la stagione estiva australe. Meno ozono durante la stagione estiva australe implica un minor assorbimento di radiazione UV e dunque un raffreddamento della bassa stratosfera, con conseguente rinforzo del vortice polare e aumento del modo di circolazione anulare —> Thompson e Solomon 2002, Gillett e Thompson 2003

3) Sappiamo che una maggior convergenza dei venti verso il continente antartico favorisce un accumulo verticale dei ghiacci, “impilandoli” e portando una maggior propensione a creare promontori; e un’intensificazione dei venti occidentali li deforma rafforzando questo fenomeno —> Zhang 2003

4) Inserendo queste “condizioni al contorno” nei modelli di simulazione, si arriva a prevedere una parte dell’espansione dei ghiacci marini antartici osservati. E quello che *alcuni* modelli avevano fatto, pur con tutti i limiti di tale proiezione.

5) Perché in realtà la cosa è più complessa di quel potrebbe sembrare. Anche il forcing radiativo dei gas serra porta ad un afforzamento dei venti occidentali che cingono l’Antartide, anche se in questo caso senza specificità stagionali —> Son et al. 2010

D’altra parte questa è una zona con molta variabilità interna rispetto al trend di lungo termine, per cui una parte dell’espansione dei ghiacci marini antartici potrebbe ancora rientrare nell’intervallo della variabilità naturale interna del sistema climatico —> Turner et al. 2009

“Al limite, mi pare che il maggior progresso dovuto ai modelli climatici moderni sia proprio quello di aiutare a censire quanto fosse poca conosciuta l’influenza di certi fenomeni sul clima.”

Questo lo penso anche io. Non so se sia il maggiore di progresso, ma lo è stato di sicuro.

[…] I dati relativi alla temperature medie globali raccolti dai National Centers for Environmental Protection e dal National Center for Atmospheric Research, due agenzie statunitensi, mostrano che il 2017, pur non avendo battuto il 2016, ci è andato molto vicino. La differenza di temperatura rispetto al periodo 1981-2010 si è infatti attestata a 0,46℃ contro lo 0,51℃ del 2016. [Climalteranti; Claudio Cassardo] […]

@Steph

Fermo restando che il tema dell’espansione dei ghiacci marini antartici è solo un esempio, la questione è: quale delle affermazioni riportate nei punti (1), (2), (3), (4), (5) è stata possibile grazie all’uso dei GCM? O meglio, quale previsione dei GCM si è poi rivelata esatta? Quando tu dici che *alcuni* modelli avevano previsto, puoi essere più specifico?

I dati definitivi sono usciti per tutte le agenzie sia per i dati terrestri che quelli satellitari.

Potete vedere un breve sunto qui, grazie al lavoro del Dr. Bob Henson e di Maximiliano Herrera per i dati globali e relativi records del 2017.

https://www.wunderground.com/cat6/noaa-earth-had-its-third-warmest-year-record-2017

Quindi per ora possiamo accantonare il discorso modelli e non andare off topic come fa continuamente Robertok06 per fare polemica.

I dati ci sono completi.

agrimensore g

“Fermo restando…”

Sì , lo avevo capito ma è lei che ha proposto questo esempio, non io.

“la questione è…”

Può tranquillamente trovare la sua risposta nei papers che le ho citato.

“*alcuni* modelli avevano previsto, puoi essere più specifico?”

Vuoi il nome dei modelli? Ha senso? In ogni caso: quelli che giravano tenendo conto dei punti che ho elencato. Credo che può trovare qualche esempio nel compendio che ne fa l’IPCC, nella fattispecie nell’AR4. Ma adesso non ho il tempo di andare a verificare.

Confermato, per il Noaa il 2017 è stato il terzo anno più caldo, per la NASA il secondo

Long-term warming trend continued in 2017: NASA, NOAA

January 18, 2018

Continuing the planet’s long-term warming trend, globally averaged temperatures in 2017 were 1.62 degrees Fahrenheit (0.90 degrees Celsius) warmer than the 1951 to 1980 mean, according to scientists at NASA’s Goddard Institute for Space Studies (GISS) in New York. That is second only to global temperatures in 2016.

In a separate, independent analysis, scientists at the National Oceanic and Atmospheric Administration (NOAA) concluded that 2017 was the third-warmest year in their record. The minor difference in rankings is due to the different methods used by the two agencies to analyze global temperatures, although over the long-term the agencies’ records remain in strong agreement. Both analyses show that the five warmest years on record all have taken place since 2010.

Because weather station locations and measurement practices change over time, there are uncertainties in the interpretation of specific year-to-year global mean temperature differences. Taking this into account, NASA estimates that 2017’s global mean change is accurate to within 0.1 degree Fahrenheit, with a 95 percent certainty level.

“Despite colder than average temperatures in any one part of the world, temperatures over the planet as a whole continue the rapid warming trend we’ve seen over the last 40 years,” said GISS Director Gavin Schmidt.

The planet’s average surface temperature has risen about 2 degrees Fahrenheit (a little more than 1 degree Celsius) during the last century or so, a change driven largely by increased carbon dioxide and other human-made emissions into the atmosphere. Last year was the third consecutive year in which global temperatures were more than 1.8 degrees Fahrenheit (1 degree Celsius) above late nineteenth-century levels.

Phenomena such as El Niño or La Niña, which warm or cool the upper tropical Pacific Ocean and cause corresponding variations in global wind and weather patterns, contribute to short-term variations in global average temperature. A warming El Niño event was in effect for most of 2015 and the first third of 2016. Even without an El Niño event — and with a La Niña starting in the later months of 2017 — last year’s temperatures ranked between 2015 and 2016 in NASA’s records.

In an analysis where the effects of the recent El Niño and La Niña patterns were statistically removed from the record, 2017 would have been the warmest year on record.

Weather dynamics often affect regional temperatures, so not every region on Earth experienced similar amounts of warming. NOAA found the 2017 annual mean temperature for the contiguous 48 United States was the third warmest on record.

Warming trends are strongest in the Arctic regions, where 2017 saw the continued loss of sea ice.

NASA’s temperature analyses incorporate surface temperature measurements from 6,300 weather stations, ship- and buoy-based observations of sea surface temperatures, and temperature measurements from Antarctic research stations.

These raw measurements are analyzed using an algorithm that considers the varied spacing of temperature stations around the globe and urban heating effects that could skew the conclusions. These calculations produce the global average temperature deviations from the baseline period of 1951 to 1980.

NOAA scientists used much of the same raw temperature data, but with a different baseline period, and different methods to analyze Earth’s polar regions and global temperatures.

The full 2017 surface temperature data set and the complete methodology used to make the temperature calculation are available at: https://data.giss.nasa.gov/gistemp

GISS is a laboratory within the Earth Sciences Division of NASA’s Goddard Space Flight Center in Greenbelt, Maryland. The laboratory is affiliated with Columbia University’s Earth Institute and School of Engineering and Applied Science in New York.

Per la NOAA è il terzo, per la NASA il secondo, per UKMO il terzo, per la JMA il terzo e per UAH dati satellitari il secondo.

Per tutti, di gran lunga IL PRIMO fra gli anni senza Nino,il quale dimostra inequivocabilmente il titolo dell’ articolo: il riscaldamento continua senza sosta.

Tamino ha fatto i conti sottraendo le tre principali cause di variabilità a breve termine (ENSO, attività solare e attività vulcanica). Così è ancora più chiaro che il riscaldamento globale prosegue senza sosta. Notevole che in tutti e sette (inclus due satellitari) i dataset mostrati il 2017 risulta essere il più caldo.

E qui http://www.columbia.edu/~jeh1/mailings/2018/20180118_Temperature2017.pdf l’analisi di Jim Hansen & co. sulle temperature del 2017

@reitano

Tamino, ultima frase del suo blog, dice che…

“Second, the “odd man out” is clearly the data from UAH.”

… e a credere a questo recentissimo studio…

https://www.atmos-chem-phys-discuss.net/acp-2017-1236/acp-2017-1236.pdf

… forse misurare la temperatura globale NON a terra o sui mari ha molto piu’ senso che farlo, quindi non mi sentirei proprio di scartare UAH a priori, solo perche’ non e’ d’accordo con gli altri:

“We find that assumption is not well supported over the historical temperature record in the model ensemble or more recent satellite observations.

We find that framing energy balance in terms of 500-hPa tropical temperature better describes the planet’s energy balance.”

robertokO6

qui non si tratta di scartarla perché satellitare, nel grafico c’è anche RSS.

A parte questo, l’articolo che citi parla d’altro, come si evince anche solo dalle frasi che riporti. Risulta anche strano che proprio tu citi articoli basati sull’output di modelli … 😉

@reitano

No, non parla d’altro.

E lo cito perche’, per una volta, confronta l’output di modelli con i dati, e non con altri modelli. 😉

21 aprile, Day Zero a Città del Capo

https://www.wunderground.com/cat6/its-true-cape-towns-water-supply-three-months-away-shutdown

Siccità in Iran, con un pattern di interazioni ambiente/società sempre più frequente, proprio nelle aree in cui era previsto si verificasse

https://robertscribbler.com/2018/01/20/how-climate-change-is-fueling-irans-political-instability/

[…] l’incremento della temperatura media globale terrestre è già superiore a 1°C, (scrivendo 0,8°C il Prof. Battaglia ha sottostimato del 20%); una variazione di 1 °C media su […]

Non si era mai visto dal 1900 in poi un salto di temperatura ampio come quello avvenuto fra 2014 e 2016.

Record jump in 2014-2016 global temperatures largest since 1900

Global surface temperatures surged by a record amount from 2014 to 2016, boosting the total amount of warming since the start of the last century by more than 25 percent in just three years, according to new University of Arizona-led research.

“Our paper is the first one to quantify this jump and identify the fundamental reason for this jump,” said lead author Jianjun Yin, a UA associate professor of geosciences.

The Earth’s average surface temperature climbed about 1.6 degrees F (0.9 C) from 1900 to 2013.

By analyzing global temperature records, Yin and his colleagues found that by the end of 2016, the global surface temperature had climbed an additional 0.43 degrees F (0.24 C).

Co-author Jonathan Overpeck said, “As a climate scientist, it was just remarkable to think that the atmosphere of the planet could warm that much that fast.”

The spike in warming from 2014 to 2016 coincided with extreme weather events worldwide, including heat waves, droughts, floods, extensive melting of polar ice and global coral bleaching.

The new research shows that natural variability in the climate system is not sufficient to explain the 2014-2016 temperature increase, said co-author Cheryl Peyser, a UA doctoral candidate in geosciences.

In the current paper, the researchers also projected how frequent such big temperature spikes would be under four different greenhouse emission scenarios. Record-breaking temperature jumps and the accompanying extreme weather events will become more frequent unless greenhouse gas emissions decline, the team found.

Figuring out the mechanism for the temperature spike built on previous work by Peyser, Yin and others.

The earlier work showed that although the Earth’s surface warming had slowed from 1998 to 2013, heat from additional atmospheric greenhouse gases was being sequestered in the Pacific Ocean. The strong 2015-2016 El Niño roiled the ocean and released all the stored heat, causing a big jump in the Earth’s surface temperatures.

“Our research shows global warming is accelerating,” Yin said.

The research paper, “Big Jump of Record Warm Global Mean Surface Temperature in 2014-2016 Related to Unusually Large Oceanic Heat Releases,” by Yin, Overpeck, Peyser and Ronald Stouffer, a UA adjunct instructor in geosciences, is online in the journal Geophysical Research Letters. Overpeck is dean of the School for Environment and Sustainability at the University of Michigan in Ann Arbor.

The Visiting Scientist Program of Princeton University, the National Oceanic and Atmospheric Administration and the National Science Foundation funded the research.

In early 2017, Yin and Overpeck were having lunch at Wilko, a restaurant near the University of Arizona campus, and Yin mentioned how fast the globe was warming.

Overpeck said, “I knew it was warming a lot, but I was surprised at how much it warmed and surprised at his insight into the probable mechanism.”

The two scientists began brainstorming about expanding on Peyser and Yin’s previous work.

The researchers analyzed observations of global mean surface temperatures from 1850 to 2016, ocean heat content from 1955 to 2016, sea level records from 1948 to 2016 and records of the El Niño climate cycle and a longer climate cycle called the Pacific Decadal Oscillation — 15 different datasets in all.

The analysis showed the 0.43 F (0.24 C) global temperature increase from 2014 to 2016 was unprecedented in the 20th and 21st centuries.

Although some release of heat from the Pacific Ocean is normal during an El Niño, the researchers found much of the heat released in 2014-2015 was due to additional warming from increases in the amount of greenhouse gases in the atmosphere.

Yin said, “The result indicates the fundamental cause of the large record-breaking events of global temperature was greenhouse-gas forcing rather than internal climate variability alone.”

The researchers also projected how often a 0.43 F (0.24 C) global temperature increase might occur in the 21st century depending on the amount of greenhouse gases emitted worldwide between now and 2100. The team used four representative concentration pathway, or RCP, models that project future climate change between 2006 and 2100.

For the low-emission RCP scenario in which greenhouse gas emissions peak by 2020 and decline thereafter, temperature jumps of at least 0.43 F (0.24 C) might occur from zero to one time in the 21st century, the team found.

For the highest-emission RCP scenario in which greenhouse gas emissions rise unabated throughout the 21st century, spikes of record warm temperatures would occur three to nine times by 2100. Under this scenario, such events would likely be warmer and longer than the 2014-2016 spike and have more severe impacts. The world is on track for one of the higher emission scenarios, Peyser said. Adapting to the increases in the frequency, magnitude and duration of rapid warming events projected by the higher emission scenario will be difficult, the scientists write.

Yin said, “If we can reduce greenhouse gas emissions, we can reduce the number of large record-breaking events in the 21st century — and also we can reduce the risk.”

L’intensità delle ondate di calore nelle città cresce più della media delle temperature massime.

Rise in severity of hottest days outpaces global average temperature increase

While our planet’s average annual temperature has increased at a steady pace in recent decades, there has been an alarming jump in the severity of the hottest days of the year during that same period, with the most lethal effects in the world’s largest cities.

Engineers at the University of California, Irvine have learned that urban centers with more than 5 million inhabitants and parts of Eurasia and Australia have been hardest hit by the accelerated growth in short-term, extreme-heat events, resulting in lost lives, reduced agricultural productivity and damage to infrastructure.

In a paper appearing in the American Geophysical Union journal Earth’s Future, the researchers report that their analysis of temperature readings from the most recent 50- and 30-year periods rules out the possibility that natural climate variability is to blame for the mercury rising.

“The global average annual temperature has increased over the past three decades at a rate of 0.20 degrees Celsius per decade, but we have found that the maximum temperature of the year has climbed at a much faster rate — two to three times higher in such regions as Eurasia and parts of Australia and more than three times higher in some megacities,” said Efi Foufoula-Georgiou, UCI Distinguished Professor of civil & environmental engineering and senior author on the study. “These results are alarming and yet more evidence of the harsh impact of global warming being felt by people around the world today.”

The research team analyzed data on the hottest day of the year from 8,848 land surface weather stations around the world. Looking at thermometer readings for the 50-year period ending in 2015, they saw an average international increase in short-term highest temperatures of 0.19 degrees Celsius per decade; the growth accelerated to 0.25 degrees per decade in the 30 years from 1986 to 2015.

Hottest-day-of-the-year measurements for major cities such as Paris, Moscow and Tokyo climbed precipitously by as much as 0.60 degrees per decade during the period studied. More than just temperature readings on a map, these events have taken a severe human toll: A heat wave in Europe in 2003 caused roughly 70,000 deaths, and another in Russia in 2010 killed nearly 55,000 people. In the United States, an average of 658 deaths due to excessive heat were reported per year between 1999 and 2009.

The researchers, from UCI’s Henry Samueli School of Engineering, highlighted an urban phenomenon known as the “heat island effect.” In human-made environments dominated by asphalt, concrete, glass and steel, hot air lingers and the sun’s scorching rays scatter and reflect off hard surfaces. While expanses of green vegetation and water in nature help to absorb or dissipate heat, cities amplify it.

“Our priority in this study was to maintain strict data quality control and to investigate if changes accelerated over the recent 30-year period,” said lead author Simon Michael Papalexiou, a postdoctoral scholar in the Department of Civil & Environmental Engineering. “We chose to drill down into conditions in megacities, where temperature extremes matter the most. Our question now is: Will this acceleration continue into the future? Because if it does, adverse effects for human societies are inevitable.”

Journal Reference:

1. Simon Michael Papalexiou, Amir AghaKouchak, Kevin E. Trenberth, Efi Foufoula-Georgiou. Global, Regional, and Megacity Trends in the Highest Temperature of the Year: Diagnostics and Evidence for Accelerating Trends.

Earth’s Future, 2018; DOI: 10.1002/2017EF000709

@Giovanni Pracanica

Quello di Lake Forest NON E un record del giorno, è solo la temperatura più alta registrata negli USA l’altro ieri.

I record del giorno che non esistono nelle statistiche italiane ne canadesi ne tedesche ne della maggior parte dei paesi del mondo, sono statistiche climaticamente IRRILEVANTI sul giorno del calendario più freddo in tot anni.

Per esempio questo 31 gennaio è stato il 31 gennaio piu freddo in tal stazione, il passato 27 dicembre è stato il 27 dicembre più freddo in tal stazione.

Orbene, essendoci 365 giorni in un’ anno e essendo le serie storiche di 50-70-100 anni anche lei capirà che mediamente OGNUNA delle decine di migliaia di stazioni mediamente batte vari record del giorno ogni anno, senza che debba esserci necessariamente un’ondata di caldo o di freddo eccezionale.

A noi climatologi seri non importano questi record del giorno dato che si battono a decine sempre e comunque, però un record del mese (record assoluto mensile di temperatura) o assoluto (temperatura più alta o bassa mai registrata nella storia climatica) capirà anche lei che si già hanno un significato climatico più alto e sono molto più difficili da battere.

Per questo ho postato sopra il link per accedere alle serie storiche e ho postato i record assoluti delle stazioni che il falso scienziato dice che hanno battuto il loro record di freddo (falso). Hanno battuto qualche record DEL GIORNO, il che di per sè non è nessun sintomo di eccezionalità, mentre sopra ho postato record MENSILI di caldo , che climaticamente sono molto piu rappresentativi e difficili da battere.

Spero di aver chiarito la differenza fra record del giorno e record mensile e assoluto.

Negli USA parlano molto di questi fottuti daily records ma sono piuù per far statistica che climatologia,purtroppo molti media e molte persone in male fede li prendono e spacciano per record assoluti per dare un contorno di eccezionalità a un’ evento non eccezionale.

Come ho scritto nel mio terzultimo messaggio il record MENSILE dell Alaska è stato registrato il 14 gennaio, sopra ho elencato tutte le stazioni che sono andate sopra il precedente record mensile statale.

Saluti

Dott. Herrera, la ringrazio per le spiegazioni ed i chiarimenti.

Cordiali saluti

[…] generale degli andamenti termici conferma le tendenze già viste in quasi tutti gli ultimi anni (2017, 2016, 2015, 2014, 2013, 2012, 2011, 2010, ecc), ed i commenti rischiano di diventare purtroppo […]

El mundo vive una emergencia climática sin precedentes y el tiempo se agota. Entre las principales causas del problema se encuentra el calentamiento global. Así es como llamamos al aumento de la temperatura debido a las emisiones de gases de efecto invernadero provocadas por la actividad humana. Y, si tenemos gran parte de la culpa, también es tarea nuestra poner soluciones.

[…] Nuccitelli sul Guardian ha battuto sul tempo Claudio Cassardo su Climalteranti (agg.: che analizza anche i dati sia della temperatura che delle precipitazioni per l’Italia […]

[…] In realtà, guardando i post analoghi degli ultimi anni (2023, 2022, 2021, 2020, 2019, 2018, 2017, 2016, …), si vede come si potrebbero utilizzare molti dei commenti già fatti, cambiando (in […]