Sull’affidabilità dei modelli /1: GCM e modelli statistici

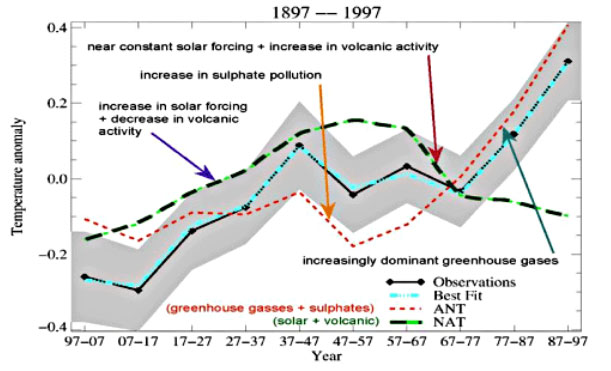

La polemica incentrata sulla presunta incapacità dei modelli di circolazione generale dell’atmosfera (GCM o, se accoppiati atmosfera-oceano, AOGCM) di simulare il clima non accenna a smorzarsi, stando almeno a quanto si legge in diversi forum e blog a tema climatico. Anche Climalteranti ha riportato in due post di poco tempo fa commenti ad alcune posizione espresse, da esempio, dal prof. Nicola Scafetta sul tema. Ritornano tra l’altro vecchie discussioni, ad esempio sul ruolo del forcing solare quale causa principale o quasi del riscaldamento globale (GW); discussioni che parevano superate già da diverso tempo. Non entrerò assolutamente nei dettagli di questa discussione in quanto mi sembra sia abbastanza consolidato il fatto (dare un occhio alla figura 34 riportata qui sotto, estratta dall’articolo di Joanna D. Haigh: “The Sun and the Earth’s Climate”), che il riscaldamento della prima metà del secolo 20mo possa essere in qualche modo collegabile all’aumento del forcing solare, mentre non si comprende come il forcing solare possa spiegare l’aumento dall’inizio degli anni ’80, dove invece l’unico segnale avente la stessa tendenza è appunto il trend dei gas serra (si confronti la riga tratteggiata rossa che mostra le emissioni di gas serra con la fascia grigia che rappresenta l’andamento dell’anomalia della temperatura media del pianeta).

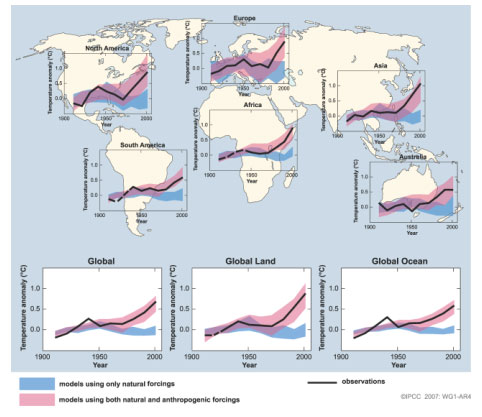

Alla luce di tale evidenza osservativa, non mi sembra sia cosa da poco rilevare che la stragrande maggioranza dei GCM siano in grado di simulare il trend di lungo periodo solo inserendo all’interno di essi anche i forcing di tipo antropogenico e non solo le emissioni naturali come ad esempio le eruzioni vulcaniche (si guardi ad esempio la figura SPM.4, del Summary for Policimakers di IPCC Ar4 WG1; in realtà anche il terzo report IPCC del 2001 mostrava risultati analoghi, usando le versioni dei GCMs in uso alla fine degli anni 90).

Ma le critiche non si limitano solo a questo. Sembra che sia ancora “in auge” la vecchia critica ai modelli GCM che vengono accusati di contenere molti parametri di “tuning”, o quando addirittura li si paragona a puri (o impuri) modelli statistici multiparametrici pieni di parametri liberi aggiustando ad arte i quali si può ottenere più o meno quello che si vuole.

E’ ancora forte il sospetto che il sistema climatico globale, nonostante la sua enorme complessità (o magari proprio a causa della sua complessità, non mi è dato di capirlo) si possa, o forse meglio, si debba simulare usando sistemi più semplici (fenomenologici ?) basati su tecniche essenzialmente statistiche che tengano nel dovuto conto alcune ciclicità naturali rilevate in molti fenomeni naturali astronomici, che in qualche maniera possano essere correlati e spiegare le ciclicità di uguale periodo rilevate dall’analisi dei trend termici osservati. In un tale approccio “riduzionista” viene da chiedersi dove sia finito lo sforzo di interpretare “fisicamente” e matematicamente i processi, usando le note equazioni differenziali che li descrive, allorchè si tenta di spiegarli in maniera quantomeno euristica mediante analisi statistiche dei dati rilevati.

E poi, a dirla proprio tutta e pur dichiarando la mia ignoranza in materia che comunque non mi vieta di sottoporre il problema alla discussione, non mi è dato di capire quali poi siano questi processi “fisici” ricorrenti che spiegano certe ciclicità. E men che meno riescono a soddisfarmi affermazioni del tipo “ ...Giove e Saturno col loro movimento intorno al Sole producono onde gravitazionali e magnetiche, che investono tutto il sistema solare e fanno letteralmente “ballare” anche il Sole e la Terra…” riportate in uno dei post sopra citati.

In fondo in fondo poi non comprendo neppure perchè si possa pensare di poter paragonare un GCM ad un modello statistico multiparametrico, dove basta ottimizzare i parametri con delle tecnica ad hoc per far tornare i conti. La stessa procedura è proposta per modellare il clima usando le serie storiche osservate, come nella seguente dichiarazione del prof. Scafetta: ”….oppure potrei fare diversamente: studiare i suoi effettivi movimenti degli ultimi 100 giorni, analizzarli statisticamente in modo da enucleare gli elementi di ripetibilità che mi consentano di “prevedere” i suoi movimenti degli ultimi 1.000 giorni. Poi, se la “previsione” eseguita sul passato riproduce accuratamente questo stesso passato, ecco che allora posso usare il modello per avanzare una previsione vera sul futuro.”.

Brutalizzando, se l’evoluzione dei sistemi fisici si potesse comprendere solo con le equazioni di regressione, allora saremmo rimasti assai indietro nell’evoluzione della conoscenza.

E magari gente tipo Newton avrebbe potuto evitare di fare la fatica di scoprire i principi della dinamica (ad esempio la F = ma). Avrebbe fatto meglio a fare un po’ di esperimenti misurando forze ed accelerazioni dei gravi e poi inventarsi una bella equazione di regressione che legasse tra loro queste quantità, facendo un appropriato “tuning” della costante di accoppiamento senza neppure proporre di chiamare “massa” del grave tale parametro…

Tutto questo per dire che, al contrario, i GCM sono modelli “fisici” e non statistici in quanto descrivono delle leggi della “fisica” e contengono “anche”, ma non solo, dei parametri, necessari essenzialmente per legare molti processi fisici operanti a piccola scala spaziale (detti anche “subgrid scale processes”) con le grandezze prognostiche dei GCM (le componenti della velocità del vento, la pressione atmosferica, l’umidità specifica, la temperatura) che sono le uniche che si fanno evolvere nel tempo. Queste operazioni di “legame” si chiamano “parametrizzazioni” in gergo tecnico modellistico.

E’ evidente che per ottimizzare queste parametrizzazioni bisogna fare un bel po’ di “tuning” ai parametri, che per altro non sostituiscono le leggi fisiche di base che li descrive. L’ottimizzazione avviene facendo “girare” i GCMs per un periodo di controllo (ad esempio dal 1900 al 2000) simulando il clima attuale e poi, se i risultati delle simulazioni lo riproducono adeguatamente grazie al confronto con dati indipendenti, solo allora vengono usati nelle simulazioni di climate change con uno o più scenari di emissione. Faccio fatica a capire dove sia l’inghippo in un processo logico del genere. Dove sia il “trucco”, per usare una provocazione.

La cosa poi ancora più interessante, ed anche innovativa, è poi che cambiando ad esempio alcuni di questi parametri di tuning (la famosa climate sensitivity) si possono avere degli ensemble di simulazioni dalle quali estrarre delle informazioni “probabilistiche” del clima futuro, informazioni essenziali per valutare la conseguente probabilità di occorrenza dei possibili impatti.

La valutazione delle potenzialità di un uso di “ensemble” dei GCMs è stato l’oggetto di un importante progetto europeo, denominato appunto ENSEMBLES (il sito del progetto è: http://ensembles-eu.metoffice.com), un importante IP project finanziato dalla Commissione Europea nell’ambito della sub-priorità “Global Change and Ecosystems del sesto programma Quadro di ricerca e sviluppo. All’interno di ENSEMBLES è stata sviluppata ed utilizzata una aggiornata serie di strumenti modellistici. Le nuove simulazioni globali prodotte sono state poi opportunamente regionalizzate e infine utilizzate come input di molteplici studi e valutazioni di impatto, anch’essi sviluppati all’interno del progetto. Nella seconda parte di questo post mi addentrerò un po’ nei dettagli del progetto ENSEMBLES per descrivere cosa è stato prodotto di nuovo…

La valutazione delle potenzialità di un uso di “ensemble” dei GCMs è stato l’oggetto di un importante progetto europeo, denominato appunto ENSEMBLES (il sito del progetto è: http://ensembles-eu.metoffice.com), un importante IP project finanziato dalla Commissione Europea nell’ambito della sub-priorità “Global Change and Ecosystems del sesto programma Quadro di ricerca e sviluppo. All’interno di ENSEMBLES è stata sviluppata ed utilizzata una aggiornata serie di strumenti modellistici. Le nuove simulazioni globali prodotte sono state poi opportunamente regionalizzate e infine utilizzate come input di molteplici studi e valutazioni di impatto, anch’essi sviluppati all’interno del progetto. Nella seconda parte di questo post mi addentrerò un po’ nei dettagli del progetto ENSEMBLES per descrivere cosa è stato prodotto di nuovo…

.

Testo di: Carlo Cacciamani

35 responses so far

Anche l’articolo di ieri di Real Climate affronta la questione dei modelli climatici:

http://www.realclimate.org/index.php/archives/2009/12/updates-to-model-data-comparisons/

Paolo C.

bella coincidenza – nel senso che coincidono modelli e misure sia qui che là

Ma non servirà a convincere questi a smetterla di denigrarli:

http://www.commondreams.org/headline/2009/12/23-2

Buon anno lo stesso, s.

[…] stato il decennio più caldo da metà Ottocento in qua, confronti tra modelli e misure da Tamino, Climalteranti e Real Climate. Nei panni del POTUS licenzierei Larry Summers e assumerei Michael Mann, […]

Mi sembra fin troppo chiaro dal post che anche sul tema dei modelli Scafetta parla di cose che non conosce.

Ma questo ci sta.

La cosa grave è che viene massacrato anche nel settore in cui pensavo se ne intendeva di più.

Seguendo il link del retrovisore di Oca Sapiens (grazie) ho appena letto un massacro di Scafetta su Rabett Run http://rabett.blogspot.com/2009/12/dissed.html.

Una stroncatura in piena regola, peggio di così non gli poteva andare…

Chissà cosa diranno ora quelli di Climate Monitor che lo prendevano come nuovo faro… l’anno si chiude molto male per gli scettici… un motivo in piu’ per festeggiare…

Beh su Scafetta c’era già stato il post di Realclimate in cui gli hanno chiesto il codice che ha usato, perché i conti che ha fatto non tornano.. e lui si è guardato bene dal rispondere nei commenti, come aveva fatto in passato su Realclimate.

http://www.realclimate.org/index.php/archives/2009/12/please-show-us-your-code/

Se il codice non l’avesse dato Jim Hansen, Guidi avrebbe fatto 5 post per stracciarsi le vesti, ora sembra non esserne accorto…

Qualunque esperimento deve essere replicato altrimenti non e’ scienza, qualunque risultato produca. Il problema e’ troppo importante, sia che l’attribuzione antropica sia giusta o sbagliata, per considerare dei dati o dei codici come personali. Ecco, un bel protocollo per la scienza sarebbe quello che tutti gli scienziati che operano su tematiche climatiche si impegnino e rendere comunque pubblici dati, codici e algoritmi.

Grazie Georgiadis

Comunque il comportamento di Scafetta non mi sorprende

Se uno va a leggersi i commenti al post fatto da Climalteranti qualche mese fa https://www.climalteranti.it/2009/11/12/purtroppo-i-negazionisti-climatici-continuano-ad-avere-torto-1/

si capisce chiaramente che non voleva confrontarsi. Voleva fare quello che fa le domande agli altri; ma è lui che dovrebbe dare delle risposte, spiegare perchè dice quelle cose sui modelli…

[…] anticipato nel precedente post, il “core” del progetto ENSEMBLES è consistito nell’individuare metodologie per un uso […]

Buon articolo, mi ha risolto alcuni dubbi… Me ne permane 1: ma questi modelli che fanno il trend del riscaldamento in base ai forzanti antropici dei gas serra, dove inseriscono il punto in cui finisce il petrolio? Voglio dire, se dal 2050 l’uomo produrrà energia soltanto attraverso fonti rinnovabili e nucleare, qual’è il suo impatto previsto da tali modelli? È una domanda che non sono riuscito a comprendere guardando i grafici…

Ho sempre ritenuto interessante che RealClimate rinfacci a Scafetta di non rilasciare il suo codice, mentre proprio su RealClimate si legge che in fin dei conti, non è necessario rilasciare il codice sorgente poiché l’articolo scientifico da esso derivato è più che sufficiente per comprendere la metodologia utilizzata. 8 pesi e 24 misure insomma, ognuna secondo la propria convenienza… È come Lambert che rinfaccia a McIntyre di non aver analizzato il codice della IEA, ma poi non mi risulta che nessun climalterante lo abbia chiesto alla IEA stessa o che proprio Lambert abbia liberamente rilasciato il suo… Idem con patate…

Sui modelli mi sembra il problema sia semplice, imho: non hanno previsto questa stasi climatica che oramai dura da diversi anni, e se non l’hanno prevista come possiamo dire che effetti avrà sul clima nei prossimi anni? È possibile dire che nei modelli mancano parametri che avrebbero potuto prevedere questa stasi climatica (leggi Pielke)? La crisi economica globale che ha fortemente ridotto i consumi, che effetti potrebbe avere? Secondo poi, mi pare che un altro problema dei modelli è che non riproducano il clima del passato, ma si limitano soltanto a riprodurre quello recente: il che significa che siamo ben di là da venire dal comprendere le implicazioni scientifiche sul clima, e che dunque parlare di “fisicità” dei modelli ha senso fino ad un certo punto. Tanto più che recentemente il forzante del soil effect è stato portato a 0,4 a 0,9, quindi l’impressione è che questi calcoli siano già da buttare. Quanti forzanti dovremo rivedere in futuro? Allora si vede che ha ragione Teodoro quando dice che questa è teoria e non scienza…

Va bene che tra trend e variabilità climatica c’è differenza, però non mi pare che questi modelli siano il vangelo… Poi ognuno legge i vangeli che vuole… 😀

Ottimo articolo, davvero illuminante.

Un amico, fervente scettico ma per il resto brava persona, mi ha segnalato un articolo di Stephen E. Schwartz et al. su Journal of Climate dal titolo “Why Hasn’t Earth Warmed as Much as Expected?” che secondo lui sarebbe una confutazione popperiana del valore dei modelli climatici, praticamente una pietra tombale.

L’nizio dell’abstract mi è parso inquietante: “The observed increase in global mean surface temperature (GMST) over the industrial era is less than 40% of that expected from observed increases in long-lived greenhouse gases together with the best-estimate equilibrium climate sensitivity given by the 2007 Assessment Report of the Intergovernmental Panel on Climate Change.”

Secondo gli autori, se ho capito bene, le principali cause di tale discrepanza sarebbero una sovrastima da parte dell’IPCC della sensibilità del clima e/o gli aerosol a effetto raffreddante.

Sapevo che il ruolo degli aerosol è ancora piuttosto ambiguo e sfuggente ma tutto sommato non mi sembra una confutazione così distruttiva dei modelli climatici.

Qualcuno sarebbe così gentile da spiegarmi? Grazie.

Gianfranco,

una prima osservazione di carattere generale rivolta agli amici scettici. Sarebbe ora che la smettessero di cercare singoli lavori che siano le pietre tombali dell’AGW. La visione di una scienza fatta da singoli ed illuminanti articoli e’ sostanzialmente a-scientifica; non e’ cosi’ che la scienza funziona, fatta salva qualche rarissima eccezione.

In particolare sull’articolo di Schwartz et al. (mi riferisco al preprint fornito da Schwartz stesso), esso si presta ancor meno ad avere il ruolo di pietra tombale. L’analisi che viene fatta e’ basata sul solo forcing dei gas serra che (sorpresa!) e’ troppo alto per spiegare il relativamente modesto aumento di temperatura osservato nell’ultimo secolo. Alla differenza, ci dice, bisogna senz’altro scontare la variabilita’ climatica naturale, il contenuto termico oceanico e l’inevitabile lag. Anche cosi’, sempre seguendo Schwartz et al., rimane ancora qualcosa da spiegare. Per usare le loro stesse parole, la restante discrepanza “is attributed mainly to uncertainty in climate sensitivity and/or cooling forcing by anthropogenic aerosols”. Nota, o meglio fai notare all’amico scettico, and/or. Il forcing negativo degli aerosol, sia pur con grandi incertezze sul valore, e’ negativo e nell’articolo stesso (pag. 6 del preprint) si dice che “countervailing aerosol forcing could account for much or all of the discrepancy between the expected and observed increase in GMST over the industrial period.”. Se per gli scettici questa e’ una pietra tombale credo che abbiamo scoperto l’immortalita’ … 😀

Una nota piu’ di colore che scientifica. Schwartz e’ noto per aver cercato di rivedere al ribasso la sensibilita’ climatica. Nel 2007 aveva stimato (qui il preprint) una sensibilita’ climatica di 0.3 K/(W/m2) che corrisponde a circa 1.1 °C per raddoppio di CO2. Gli fu subito fatto notare (Foster et al.2008) un errore che portava ad una costante di tempo (essenzialmente la risposta oceanica) di soli 5 anni. Troppo bassa, e poco dopo Schwartz rivide al rialzo la sua stima, portandola a 1.8 °C per raddoppio di CO2. La costante di tempo e’ salita a 8,5 anni, ancora un valore poco accettabile; alziamolo un po’ e i conti tornano. Infine l’ultimo articolo, quello di cui si parla qui, che ci dice che se mettiamo in conto anche i forcing negativi si spiega anche il riscaldamento dell’ultimo secolo. Non c’e’ che dire, un bel percorso.

tag non chiuso ed enfasi che resta all’infinito. sorry.

Su modelli: mi sembra che le proiezioni azzurre, nel grafico seguano la ricostruzione di Lean 2003 e la PMOD ma sembra che entrambe non siano corrette perchè costruite con il numero delle macchie solari che non rappresenta il flusso magnetico solare poloidale.

Su Scafetta: io invece trovo la stroncatura del coniglio che corre vergognosa, sia nei modi, sia nei contenuti. Per me non sanno di cosa stanno parlando.

Perchè se è vero che Satire era stato costruito da Krikova per dati di lungo periodo e forse il Satire che ha usato Scafetta Willson 2009 non era adatto per i dati Acrim ( ma aspetterei a giudicare la replica di Scafetta)

Krikova 2009 utilizza sempre e comunque il modello Satire anche con i dati Acrim(diciamo modificato e adattato per i brevi periodi) ma ottiene una ricostruzione molto diversa rispetto a Scafetta West e Scafetta Willson.

Perchè?

La differenza non può essere solo nel modello usato, quella veramente sostanziale ( secondo me) è nel magnetogramma usato perchè Krikova 2009 usa il magnetogramma della NASA che dà (come Lean) l’attività magnetica solare in calo dagli anni 50

Scafetta invece cita Mckraken 2007 che stima l’attività magnetica solare in crescita fino a metà degli anni 90.

Trovate link e riflessioni qui

http://www.wpsmeteo.it/index.php?ind=news&op=news_show_single&ide=1183

@ Gianfranco

Ho citato anch’io, in qualche commento su questo blog, il lavoro di Scwartz (indirittemante, giacchè le coordinate precise le ha fornite oca sapiens).

Il problema sui GCM che derivano da questo e altri lavori, per quanto mi riguarda, è semplice: che valore (o che range di valori in caso di scenari) deve assumere nel modello la parametrizzazione relativa alla sensibilità del clima? Potrei citare dei lavori che sulla sensibilità del clima pongono dei valori di aumento delle T globali per raddoppio di concentrazione di co2 che vanno da 0.01C a 7C e più. Dato che il dibattito è quanto meno aperto, come fa il modello a scegliere la strada giusta? A tal proposito, bisogna tener presente che questo tipo di modelli (predizione di variabili statistiche su clino trentennale circa) in pratica non permette una fase sperimentale classica. Suppongo da qui il riferimento del suo amico a Popper.

Questo tipo di osservazioni propongono come corollario un altro quesito. Immaginiamo pure che il modello abbia degli skill elevatissimi nei confronti dei dati climatici passati, che riesca a riprodurre perfettamente il clima dell’ultimo secolo. Come si fa ad essere ragionevolmente certi che il valore assegnato alla sensitività del clima rispetto alla co2 non includa altri fattori, altri processi fisici, che il modello non comprende?

@claudio

“Scafetta invece cita Mckraken 2007 che stima l’attività magnetica solare in crescita fino a metà degli anni 90.”

poi Svalgaard e Cliver, invece, …..

http://img692.imageshack.us/img692/6819/apindex.png

Solo un piccolo commento su Satire e le ricostruzioni dell’irradianza totale del sole.

Come al solito si cerca di girare la frittata senza cercare di capire i fatti.

Ci sono due ricostruzioni dell’irradianza totale del sole ottenute con i dati satellitari sin dal 1978: ACRIM e PMOD. ACRIM mostra una crescita dal 1980 al 2000 e una diminuzione sin dal 2000; PMOD mostra una piccola diminuzione sin dal 1978.

La differenza tra le due ricostruzioni e’ fondamentale per capire se il trend di riscaldamento dal 1980 al 2000 e’ parzialmente dovuto al sole oppure no.

IPCC usa PMOD. Tuttavia, il fatto e’ che PMOD altera i dati satellitari pubblicati dai rispettivi gruppi sperimentali per ottenere il suo risultato. ACRIM invece usa i dati sperimentali cosi come sono pubblicati.

Riguardo alle alterazioni dei dati sperimentali da parte di PMOD, in Scafetta and Willson 2009 c’e’ la seguente dichiarazione del ricercatore principale dei dati Nimbus7 che sono stati alteati da PMOD. Questa dice

“Concerning the supposed increase in Nimbus7 sensitivity at the end of

September 1989 and other matters as proposed by Frohlich’s PMOD TSI

composite: 1. There is no known physical change in the electrically calibrated Nimbus7

radiometer or its electronics that could have caused it to become more

sensitive. At least neither Lee Kyle nor I could never imagine how such

a thing could happen and no one else has ever come up with a physical

theory for the instrument that could cause it to become more sensitive.

2. The Nimbus7 radiometer was calibrated electrically every 12 days. The

calibrations before and after the September shutdown gave no indication

of any change in the sensitivity of the radiometer. Thus, when Bob Lee

of the ERBS team originally claimed there was a change in Nimbus7

sensitivity, we examined the issue and concluded there was no internal

evidence in the Nimbus7 records to warrant the correction that he was

proposing. Since the result was a null one, no publication was thought

necessary. 3. Thus, Frohlich’s PMOD TSI composite is not consistent with the

internal data or physics of the Nimbus7 cavity radiometer.

4. The correction of the Nimbus7 TSI values for 1979-1980 proposed by

Fr\”ohlich is also puzzling. The raw data was run through the same

algorithm for these early years and the subsequent years and there is no

justification for Frohlich’s adjustment in my opinion.”

Quindi, come si vede, PMOD non e’ supportata da dati sperimentali. ACRIM invece e’ basata sugli esperimenti. In scienza questo e’ quello che conta. Quindi, da un punto di vista puramente sperimentale ACRIM e’ corretto e l’irradianza solare totale e’ cresciuta dal 1980 al 2000.

Poi ci sono diverse ricostruzioni fatte con in proxi e una di queste e’ Satire da parte di Krikova et al nel 2007. Se vi andate a leggere l’articolo di Krikova 2007, vi accorgete che sono loro che ritengono che la loro ricostruzione “prova” la correttezza di PMOD.

In Scafetta e Willson 2009 si prova che questo non e’ vero. Questo proxy contraddice le altrazioni dei dati satellitari operata da PMOD. Quindi, al massimo si deve ritenere il modello proxy incapace di “provare” che PMOD e’ corretto.

Krikova 2009 ritiene che Krikova 2007 e’ sbagliato e ritiene che noi avremmo dovuto usare un’altra ricostruzione di Solanki. Tuttavia, Krikova 2009 hanno commesso un errore piuttosto grossolano e infatti anche la seconda ricostruzione di Solanki supporta ACRIM, ma questo e’ un argomento di un nuovo articolo che non e’ ancora pubblicato.

In conclusione, il succo della storia e’ che ACRIM e’ basato sui dati sperimentali, mentre PMOD altera questi dati dicendo che ci sono alcuni proxy, tra cui Satire, che lo supportano. Noi proviamo che i modelli proxy sono troppo incerti per contraddirre le misure sperimentali. Quindi, la tesi che PMOD e’ corretta e’ basata sul nulla.

Purtroppo i promotori del AGW hanno bisogno di PMOD e dei modelli proxy che non mostrano nessuna crescita dell’attivita’ solare dal 1980 al 2000 per sostenere le loro tesi, quindi per ragioni ideologiche si rifiutano di accettare ACRIM. Ma ACRIM e’ basata sugli dati sperimentali, non sui modelli proxy.

Riguardo alla figura di sopra notate che si ferma al 1997 e usa PMOD. Dopo il 1997 il GHGs continuano a salire, ma la temperatura non sale, anzi scende. Quindi la correlazione tra i modelli e la temperature si ferma li.

nicola scafetta

@ Steph

Ti giro le conclusioni della Haigh

Conclusions

Radiation from the Sun ultimately provides the only energy source for the Earth’s atmosphere and changes in solar activity clearly have the potential to affect climate. There is statistical evidence for solar influence on various meteorological parameters on all timescales, although extracting the signal from the noise in a naturally highly variable system remains a key problem. Changes in total solar irradiance undoubtedly impact the Earth’s energy balance but uncertainties in the historical record of TSI mean that the magnitude of even this direct influence is not well known. Variations in solar UV radiation impact the thermal structure and composition of the middle atmosphere but details of the responses in both temperature and ozone concentrations are not well established. Various theories are now being developed for coupling mechanisms whereby direct solar impacts on the middle atmosphere might influence the troposphere but the influences are complex and non-linear and many questions remain concerning the detailed mechanisms which determine to what extent, where and when the solar influence is felt. Variations in cosmic radiation, modulated by solar activity, are manifest in changes in atmospheric ionisation but it is not yet clear whether these have the potential to significantly affect the atmosphere in a way that will impact climate.

Further advances in this field require work on a number of fronts. One important issue is to establish the magnitude of any secular trends in total solar irradiance (TSI). This may be achieved by careful analysis and understanding of the satellite instruments involved in collecting data over the past two-and-a-half solar cycles, and must be continued through analysis of data from current and new satellites. For longer periods it requires a more fundamental understanding of how solar magnetic activity relates to TSI. This would not only facilitate more reliable centennial-scale reconstructions of TSI, from e.g. sunspot records, but also advance understanding of how cosmogenic isotope records may be interpreted as historical TSI.

With regard to the climate, further data-mining and analysis are required to firmly establish the magnitude, geographical distribution and seasonality of its response to various forms of solar activity. Understanding the mechanisms involved in the response then becomes the overriding objective. Current ideas suggest three main avenues where further research is needed. Firstly, the means whereby solar radiative heating of the upper and middle atmosphere may influence the lower atmosphere through dynamical coupling needs to be better understood. Secondly, it needs to be established whether or not variations in direct solar heating of the tropical oceans can be of sufficient magnitude to produce apparently observed effects. Thirdly, more work is needed on the microphysical processes involved in ion-induced nucleation, and, probably more importantly, the growth rates of the condensation nuclei produced.

Perhaps when these questions are answered we will be confident that we really understand how changes in the Sun affect the climate on Earth

Quindi ammette, nel libro linkato dal Caserini, molte incertezze sulla ricostruzione della TSI, in particolare sull’attività magnetica solare.

Io l’ho vista in un documentario su Discovery dove senza mezzi termini affermava che è il sole a guidare le variazioni climatiche (senza specificare però: anche negli ultimi 30 anni)

Poi sempre della Haigh tra gli autori, c’è questo rapportone che già conosci.

http://www.space.dtu.dk/upload/institutter/space/research/reports/scientific%20reports/isac_final_report.pdf

Siccome è lunghino, a chi non lo conosce consiglio di leggere almeno le conclusioni.

Grazie NoWayOut e agrimensore g.

Sono un po’ a disagio rivolgendomi ai fantasmi dietro i nickname, fatico ad abituarmi (sarà l’età?) ma devo farmene una ragione visto che è una prassi ormai universalmente diffusa.

Dopo aver letto l’articolo, non solo l’abstract, sono più rilassato. Dopo tutto SS non dice che “i GCM non funzionano affatto”. Dice, molto più ragionevolmente, che bisogna conoscere meglio la fisica dei vari tipi di aerosol, pesarne i forzanti negativi e positivi e determinare il valore del forzante netto che sembra debba essere un po’ più negativo di quanto stimato finora. Del resto il ruolo ambiguo degli aerosol era già noto come un certo grado di incertezza nella sensibilità climatica.

Quanto a Popper, i modelli di simulazione (climatica e non) sono venuti dopo di lui; e comunque dubito che fosse in grado di condurre un tradizionale esperimento, o di scrivere un sistema anche semplice di equazioni differenziali per non parlare di risolverlo.

Continuerò a discutere con l’amico scettico, pur senza la minima speranza di convertirlo.

@ Nicola Scafetta

Grazie per il commento. Il discorso ACRIM vs PMOD e’ stato trattato anche qui:

https://www.climalteranti.it/realclimate-ita/#ACRIMPMOD

e le conclusioni sono sostanzialmente differenti.

@ Scafetta

“Riguardo alla figura di sopra notate che si ferma al 1997 e usa PMOD. Dopo il 1997 il GHGs continuano a salire, ma la temperatura non sale, anzi scende. Quindi la correlazione tra i modelli e la temperature si ferma li.

Ancora con ‘sta storia? Ma se i record della temperatura globale è stato il 1998 e/o il 2005, non sarebbe meglio dire che le temperature non salgono dal 1998 o dal 2005?

Comunque il bello di queste cosa è che basterà aspettare qualche anno, cosi’ vedremo se la temperatura sale oppure no. L’unica cosa che puo’ aiutare Scafetta & co. è una bella eruzione vulcanica…

@Paolo Gabrielli

Riporto un paragrafo dell’articolo da lei citato:

“LF08 sostiene che se il trend dei minimi di ACRIM fosse corretto, significherebbe che le precedenti ricostruzioni della TSI basate su, ad esempio, le macchie solari non sono corrette, e molti studi sulle variazioni climatiche passate sarebbero errati.”

Beh, non mi sembra un argomento forte se si vuole dedurre da quanto sopra che ACRIM non sia corretto. Oltre tutto le sunspots sono comunque proxy affidabili fino a un certo punto. Basti vedere quello che sta succedendo proprio in queste ultime settimane: i valori di SSN e sunpots area sono aumentati notevolmente ma gli indici Kp, Ap sono rimasti bassi. Senza contare, se si considera l’SSN, i problemi di omogeneità col passato derivanti dal k-factor.

@ Paolo Gabrielli

http://spaceweb.oulu.fi/spaceclimate/Program_and_Abstracts.pdf

Katia Georgieva a pg 20 ci dice che l’attività solare che influenza la Terra può essere scomposta in due parti:

quella relativa al campo solare toroidale che è proporzionale al numero delle macchie solari (ST), e quello relativo al campo solare poloidale che non è collegato al numero delle macchie solari (SP).

Studi precedenti hanno dimostrato che le variazioni nei fenomeni terrestri, incluso le variazioni del campo geomagnetico e del clima, sono meglio correlati alla SP che a ST.

Vuol dire che la ricostruzione dell’attività solare fatta da Lean e inserita nell’ultimo rapporto IPCC:

è sbagliata perché si basa essenzialmente sulle macchie solari.

Scafetta Willson nel fare la ricostruzione dell’attività solare hanno usato i dati satellitari Acrim, elaborati con il modello di Satire. Scafetta non usa i dati satellitari PDOM perché questa elaborazione segue un “binario” già segnato che è la ricostruzione di Lean fatta sulle macchie solari. Quindi anche la PDOM è sbagliata e porta alla stazione voluta, (è lo stesso meccanismo del trucco di Mann per incernierare i dati dei proxy a quelli strumentali)

Krikova dice che il modello di Satire (fatto dallo stesso Krikova e usato da Scafetta) sia stato tarato in due modi diversi e Scafetta ha usato quello inadatto, cioè quello tarato sulle misure di lungo periodo.

Ma la differenza di risultato tra Scafetta 2009 e Krikova 2009 non può essere solo nel modello, è troppo marcata. Krikova usa magnetogrammi di Wenzler. Cioè i dati del National Solar Observatory (NSO) NASA / spectromagnetograph.

Che sono molto diversi dal magnetogramma di McCraken citato da Scafetta che dà il campo magnetico in aumento costante da 400 anni con il massimo picco nel 1992.

Wenzler 2006 ma anche Wenzler 2009 concludono tutti dicendo che la TSI ricostruita coi magnetogrammi della Nasa, collimano meglio con la PDOM rispetto ad ACRIM ed IRBM…potrebbe essere proprio perché in entrambi c’è lo stesso errore.

Su le critiche di realclimate a Scafetta: qui c’è una replica di Scafetta, e Schmidt non fa una bella figura.

http://pielkeclimatesci.wordpress.com/2009/08/03/nicola-scafetta-comments-on-solar-trends-and-global-warming-by-benestad-and-schmidt/

Nicola Scafetta Comments on “Solar Trends And Global Warming” by Benestad and Schmidt

@agrimensore

“i valori di SSN e sunpots area sono aumentati notevolmente ma gli indici Kp, Ap sono rimasti bassi“

Nulla di nuovo, sotto il sole. Come si sa gli indici dell’attività geomagnetica del sole sono piuttosto sfasati, rispetto a quello delle macchie/della TSI/del SF. Ci sono sostanziali ragioni fisiche che lo spiegano.

http://www.leif.org/research/Ap-Index-1932-now.png

@claudio

che ti devo dire? S&C 2008 vs McC 2007…

http://www.leif.org/research/HMF-McCracken.png

@nicola scafetta

buongiorno Dott. Scafetta, è un piacere leggere e scrivere su un blog dove intervengono anche autori importanti di lavori che, solitamente, ci si limita a discutere. In questo senso, ne approffitto per porle alcune domande:

1) perché sostiene che “Dopo il 1997 il GHGs continuano a salire, ma la temperatura non sale, anzi scende”? Potrebbe indicare quale dataset usa per sostenere che la T scende e specificare a quale/i GHG si riferisce?

http://img693.imageshack.us/img693/6748/1594temperaturen2009.jpg

2) perché ritiene così importante affidarsi ai dati satellitari ACRIM per “capire se il trend di riscaldamento dal 1980 al 2000 e’ parzialmente dovuto al sole oppure no”, considerato come, in ossequio ai fatti da lei auspicati ad inizio post, la TSI nel XX secolo non mostra un trend specifico e la T globale invece sì?

3) perché – sempre per “capire se il trend di riscaldamento dal 1980 al 2000 e’ parzialmente dovuto al sole oppure no” – ritiene così importante affidarsi principalmente ad una variazione della TSI con un’ampiezza del segnale periodico associato al ciclo undecennale di circa ±1 Wm^-2 quando sappiamo che:

– la variazione annua della TSI è circa 100 volte superiore rispetto a quella ciclica undecennale (eccentricità dell’orbita terrestre) il che, in sé, tenderebbe a ridimensionare eventuali effetti ritardati nel tempo causati dal forcing solare supposto;

– la variazione decennale della radiazione globale superficiale è di almeno un ordine di magnitudo superiore rispetto a quella della TSI?

La ringrazio anticipatamente delle risposte che – ne sono sicuro – sapranno chiarire alcuni dubbi non solo miei.

@steph

Quando dice sfasati intende dire che c’è un lag ben determinato o che non sono strettamente correlati? Dal grafico che lei linka pare vera la seconda ipotesi. In realtà nel grafico c’è solo l’Ap, manca il confronto con SSN. Ma, andando a memoria si nota che SSN ha un andamento un pochino diverso, e in quel senso dicevo che le sunspots sono “proxy affidabili fino a un certo punto”.

@ Paolo Gabrielli

io non prenderei come oro colato quello che realclimate scrive. Gli articoli che scrivono sono sempre inaccurati. Sopra ho mostrato le opinioni dei gruppi sperimentali. Queste sono quelle che contano.

@ steph

1) le temperature vs. CO2 (in verde) degli ultimi anni sono qui

http://icecap.us/images/uploads/MSUCRUTEMPSvsCO2May09_thumb.jpg

Chiaramente le une scendono e l’altro sale.

2) i trend del TSI sono molto simili ai trend della temperatura nel’ultimo secolo, secoli precedenti e ultimi decenni se ACRIM e’ usato. Vedi i miei studi.

http://www.fel.duke.edu/~scafetta/pdf/Scafetta-JASP_1_2009.pdf

anche questa figura chiarisce l’argomento. La temperatura e’ in accordo con l’attivita’ solare ma non con il CO2

http://www.flickr.com/photos/43864496@N03/4055639552/

3) l’eccentricità dell’orbita terrestre e la variazione annuale non centra nulla.

NS

@ Nicola Scafetta

Guardi, io non prendo nulla per oro colato ma, mi perdoni, neppure quello che dice Lei e che, cosa forse piu’ grave, non ritiene neppure di smentire

https://www.climalteranti.it/2009/11/12/purtroppo-i-negazionisti-climatici-continuano-ad-avere-torto-1/

@scafetta

grazie di non aver risposto. Le riformulo le domande:

1) perché sostiene che *dopo il 1997* (ergo: timeframe 1998-2009) il GHGs continuano a salire, ma la temperatura non sale, anzi scende? Mentre mi pare di capire che lei – a differenza dei modelli di cui si parla nel post – considera solo la CO2 come forzante antropogenica, linkando quel grafico non risponde alla domanda che le ho fatto e che mi è sorta a partire dalle sue considerazioni finali del suo primo intervento.

2) perché ritiene così importante affidarsi ai dati satellitari ACRIM per “capire se il trend di riscaldamento dal 1980 al 2000 e’ parzialmente dovuto al sole oppure no”, considerato come la TSI nel XX secolo non mostra un trend specifico e la T globale invece sì? Come vede, siamo oggi su valori di irradianza simili a quelli che avevamo nei primi anni del XX secolo (al minimo fra i cicli 13 e 14), mentre non direi che le T globali siano simili.

Consideri, se le va, la più recente ricostruzione della TSI (Svalgaard, primo grafico) o, in alternativa (secondo grafico), la forza magnetica solare:

http://www.leif.org/research/TSI%201900-now.png

http://www.leif.org/research/Heliospheric-Magnetic-Field-Since-1835.png

3) perché una variazione annua della TSI superiore di 2 ordini di grandezza rispetto alla variazione undecennale o a quella di più lungo periodo non dovrebbe c’entrare nulla? O meglio: in che modo una variazione di un forcing solare molto molto più piccolo rispetto a quello che ogni anno la Terra riceve dovrebbe importare così tanto? Stiamo sempre parlando di aggiunte di energia al sistema, no?

E quindi: in termini di energia assorbita dal sistema terrestre, non ritiene importante il fatto che la variazione decennale della SSR sia molto più grande rispetto a quella della TSI?

@agrimensore

sì, l’attività geomagnetica non sembrerebbe essere strettamente correlata perché presenta diversi cicli e sottocicli (22, 11, 1.3 y i meno corti), anche quello che si correla maggiormente alle SSN (11y) tende ad essere diviso in 3 peaks. Forse trova molto di quel che cerca nel sito linkato sotto, pur se non è molto aggiornato (le consiglio, se lo ritiene opportuno, una sbirciatina alla homepage di Leif Svalgaard, trova moltissimo materiale e soprattutto update…;)

http://www.oulu.fi/~spaceweb/textbook/ga.html

@ Steph

Mi sarebbe piaciuto molto che il tuo confronto con Scafetta continuasse perchè era molto interessante.

detto questo c’è un ragionamento che fai, e che si allaccia all’ultima discussione cioè qui

https://www.climalteranti.it/2010/02/15/diffidare-di-chi-usa-il-mattone-della-vita/

che non mi è chiaro per nulla

Scrivi infatti a Scafetta:

“Come vede, siamo oggi su valori di irradianza simili a quelli che avevamo nei primi anni del XX secolo (al minimo fra i cicli 13 e 14), mentre non direi che le T globali siano simili.”

E’ una cosa che non capisco: perchè mai dovrebbero essere uguali le temperature?

– Anche se ci fossero le stesse forzanti solari lo stato climatico della terra è cambiato, quindi a parità di forzanti abbiamo temperature diverse perchè è diverso lo stato climatico su cui le stesse forzanto agiscono.

– Scafetta non esclude affatto le forzanti antropiche, dice solo che quelle solari sono di molto sottovalutate, e che le antropich enon sono le dominanti, non che non esistono.

Quindi a parità di forzanti solari, cambiano lo stato climatico di partenza della terra come già detto, ma anche e le forzanti antropiche e poi ci sono anche tutte le altre: vulcaniche albedo ecc

– McCracken 2007 comunque dice che l’attività magnetica solare attuale è più alta di quella dei primi del 900,

lo so, mi citerai Svalgaard a confronto che non è dello stesso parere, ma saprai anche, come ti ho già risposto altre volte, che mentre la ricostruzione di mcCracken 2007 giustifica gran parte dei cambiamenti climatici dell’Holocene, Svalgaard non le giustifica, e si ripara dietro la frase che ha scritto su cliamteaudit:

” è ipotizzabile che la terra abbia una ipersensibilità alle variazioni solari anche piccole”

Benissimo!

Ma se questa ipersensibilità vale per il periodo caldo miceneo, quello romano e quello medioevale, vale per forza di cose anche per quello attuale.

@steph

E’ proprio per quello che ho scritto che la macchie solari sono proxy affidabili solo in parte (supponenndo indici Ap importanti per il clima)

Grazie per i vari link.

[…] all’affidabilità dei AOGCMs , è un dato di fatto invece che gli strumenti di simulazione del clima dell’ultima generazione […]

[…] Se il problema del riscaldamento globale non fosse serio e le azioni da intraprendere per mitigarne gli effetti assai urgenti, ci sarebbe da sorridere di fronte a critiche del genere. L’evidente assurdità di tali critiche nasce dal fatto che, anche volendolo, è praticamente impossibile truccare i modelli per farli tornare come si desidera, vista la loro enorme complicazione, connessa in larga parte alla non linearità delle equazioni che li caratterizza, e che discende dalla natura stessa dei processi fisici che vengono descritti. Magari sarebbe tutto un po’ più facile se i processi fisici fossero spiegabili attraverso connessioni semplici causa-effetto e se non ci fosse una quantità innumerevole di feedback da descrivere e che rendono tali approcci “euristici” del tutto impraticabili. Un approccio riduzionista del genere non è praticabile, cosa per altro già accennata nel precedente post. […]

[…] per far aggiornare i modelli considerando variabilita’ fin ora non considerata. Questo articolo: Climalteranti.it

[…] per far aggiornare i modelli considerando variabilita’ fin ora non considerata. Questo articolo: Climalteranti.it