Pubblichiamo questa traduzione di post comparso su Realclimate, per ricordare uno degli articoli scientifici più lungimiranti della scienza del clima.

.

Il riscaldamento globale è arrivato ai 35 anni. Non solo l’attuale evidente fase di riscaldamento globale dura da circa 35 anni, ma anche il termine “riscaldamento globale” vedrà il suo 35esimo anniversario la settimana prossima. L’8 Agosto 1975 Wally Broecker pubblicò sulla rivista Science l’articolo “Are we on the brink of a pronounced global warming?”. Questa sembra sia la prima volta in cui il termine “riscaldamento globale” è stato usato nella letteratura scientifica (almeno è il primo su oltre 10,000 articoli con questo termine di ricerca nel database ISI degli articoli scientifici).

In questo articolo Broecker predisse correttamente che “l’attuale tendenza al raffreddamento lascerà il posto, entro circa un decennio, ad un significativo riscaldamento indotto dall’anidride carbonica”, e che “entro i primi anni del prossimo secolo [l’anidride carbonica] avrà portato la temperatura media planetaria oltre i limiti raggiunti durante gli ultimi 1000 anni”. Broecker predisse un riscaldamento globale complessivo per il 20esimo secolo causato dalla CO2 di 0.8 °C e si preoccupò per le conseguenze sull’agricoltura e sul livello del mare.

Temperature globali fino al Giugno 2010 secondo i dati GISS della NASA. La linea grigia è la media mobile sui 12 mesi, i punti rossi i valori medi annuali. La linea spessa rossa rappresenta un trend non lineare. Ovviamente Broecker non aveva questi dati a disposizione, nemmeno quelli fino al 1975, perchè la raccolta globale dei dati è stata realizzata non prima dei tardi anni ’70 (Hansen et al. 1981). Si è dovuto basare su dati metereologici più limitati.

Per quelli che ancora oggi sostengono che il riscaldamento globale non si possa prevedere, l’anniversario dell’articolo di Broecker serve da promemoria che il riscaldamento globale fu effettivamente previsto prima che diventase evidente nei dati di temperatura globale oltre un decennio dopo (quando nel 1988 Jim Hansen fece la famosa dichiarazione che “il riscaldamento globale è in atto”).

.

Broecker è uno dei grandi climatologi del ventesimo secolo: pochi eguaglieranno il suo primato di 400 articoli scientifici, una sessantina abbondante dei quali hanno più di 100 citazioni ciascuno! Curiosamente, il suo articolo sul “riscaldamento globale” non è fra i più citati con ad oggi “solo” 79 citazioni. Broecker è meglio conosciuto per il suo vasto lavoro sul paleoclima e sulla geochimica degli oceani.

E’ molto istruttivo seguire il modo in cui Broecker è arrivato alla sua previsioni nel 1975 – non ultimo perchè ancora oggi molti profani assumono, sbagliando, che noi attribuiamo il riscaldamento globale ai livelli di CO2 essenzialmente perchè temperatura e livelli di CO2 sono aumentati entrambi e quindi sono correlati. Broecker è arrivato alla sua previsione in un momento in cui la CO2 era in crescita ma le temperature era in decrescita da qualche decennio – ma Broecker (così come molti altri scienziati al tempo e ancora oggi) aveva compreso le basi fisiche del problema.

Essenzialmente la sua previsione coinvolse tre semplici passi, fondamentalmente gli stessi usati ancor oggi.

.

Step 1: Predict future emissions

Broecker ha semplicemente presunto una crescita delle emissioni di CO2 da combustibili fossili pari al 3% annuo dal 1975 in poi. Con ciò è stato in grado di calcolare un valore cumulato di emissioni di CO2 di origine fossile pari a 1670 miliardi di tonnellate all’anno 2010 (si veda la sua tabella n°1). Non male: il valore che abbiamo appena superato è di circa 1300 miliardi di tonnellate (Canadell et al, PNAS 2007 – stima da me estesa al 2010).

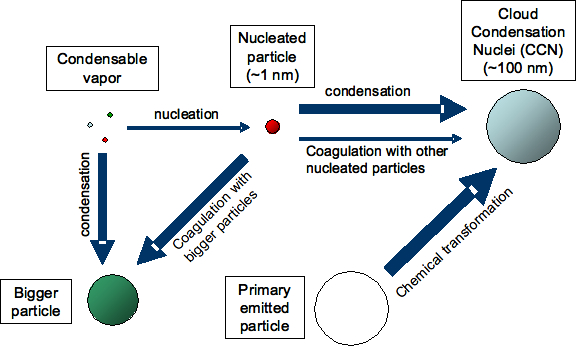

Una lacuna, dal punto di vista moderno, è che Broecker non ha incluso nei suoi calcoli gli altri gas serra antropogenici o le particelle degli aerosol. In un certo senso considera gli aerosol chiamandoli “polveri”. Infatti, la prima frase dell’abstract (citato sopra) inizia subito con un “se”:

“Se le polveri prodotte dall’uomo sono irrilevanti come causa importante per il cambiamento climatico, allora si può ragionevolmente ritenere che il trend di raffreddamento attuale, in una decina d’anni o giù di li, lascerà il passo ad un marcato riscaldamento indotto dall’anidride carbonica”.

Questo è un assenso alla discussione relativa al raffreddamento dovuto poveri agli aerosol dei primi anni ‘70. Broecker giustamente scrive:

“È difficile determinare la rilevanza del secondo più importante effetto climatico indotto dall’uomo, “le polveri”, per l’incertezza dovuta alla quantità, alle proprietà ottiche e alla distribuzione delle particelle di origine antropica”,

citando una serie di articoli di Steve Schneider e altri. Siccome non è stato in grado di quantificare questo effetto, non lo ha considerato. Però in questo caso la fortuna aiutato era dalla parte di Broecker: il riscaldamento dovuto ad altri gas serra e il raffreddamento dovuto agli aerosol si sono esattamente compensati ad oggi, quindi considerare solo la CO2 porta a quasi la stessa forzante radiativa che considerare tutti gli effetti antropogenici sul clima (vedi IPCC AR4, fig. SPM.2 ).

Table 1 of Broecker (1975)

.

Step 2: Prevedere le concentrazioni future

Per passare dalla quantità di CO2 emessa all’effettivo aumento in atmosfera, è necessario conoscere quale sia la frazione delle emissioni che resta in aria: la “frazione aerea” Broecker, basandosi sui dati del passato delle emissioni e delle concentrazioni di CO2 (la curva di Keeling di Mauna Loa), assunse semplicemente che la frazione in atmosfera fosse costante e pari al 50%. Cioè, circa la metà delle nostre emissioni da combustibili fossili si accumula in atmosfera. Questa assunzione resta valida ancora oggi, quando si guarda all’aumento di CO2 osservato come frazione delle emissioni da combustibili fossili. Broecker calcolò che circa il 35% delle emissioni fosse assorbito in oceano e il restante 15% dalla biosfera (di nuovo, non lontanto dai valori attuali, vedi Canadell et al.). Su questa base egli sostenne che se l’oceano è il pozzo principale, la frazione aerea sarebbe rimasta approssimativamente costante per i decenni a venire (i suoi calcoli arrivavano al 2010).

Quindi, con un aumento del 3% l’anno delle emissioni e una frazione aerea rimanente pari al 50%, è facile calcolare l’aumento della concentrazione di CO2. Egli ottenne un aumento da 295 a 403 ppm dal 1900 al 2010. Il valore reale al 2010 è 390 ppm, un po’ meno della stima di Broecker a causa del fatto che la sua previsione di emissioni cumulative era leggermente troppo elevata.

.

Step 3: Calcolo della risposta della temperatura globale

A questo proposito, Broecker scrive:

“La risposta della temperatura globale all’aumento del contenuto atmosferico di CO2 non è lineare. Man mano che il contenuto di CO2 nell’atmosfera aumenta, l’assorbimento di radiazione infrarossa “saturerà” su una parte sempre più ampia della banda. Rasool and Schneider fanno notare che la temperatura aumenta come il logaritmo della concentrazione atmosferica di CO2”.

Basandosi su questa relazione logaritmica (valida ancora oggi) Broecker assume una sensitività climatica di 0.3 °C di riscaldamento per ogni aumento del 10% della concentrazione di CO2, che significa 2.2 °C di riscaldamento per un raddoppio della CO2. Questo numero si basa sui precedenti calcoli di Manabe e Wetherald. Broecker scrive:

“Sebbene potremmo ancora avere sorprese quando computer più potenti e una migliore conoscenza della fisica delle nubi permetteranno di fare il passo successivo nella modellistica, la dimensione dell’effetto della CO2 è probabilmente racchiuso all’interno di un fattore fra 2 e 4“.

L’AR4 riporta l’intervallo di incertezza della sensitività climatica come 2-4.5 °C di riscaldamento per il raddoppio di CO2, quindi c’è ancora un’incertezza di un fattore 2 e Broecker ha usato un valore vicino all’estremo inferiore di questo intervallo di incertezza. Le stime recenti non sono solo basate sui calcoli modellistici ma anche su dati paleoclimatici e moderni; l’AR4 elenca 13 studi che limitano la sensitività climatica nella tabella 9.3.

Nell’articolo di Broecker il riscaldamento calcolato con l’ausilio della sensitività climatica avviene istantaneamente. Oggi sappiamo che il sistema climatico risponde con un ritardo dovuto all’inerzia termica dell’oceano. Trascurandolo, Broecker ha sovrastimato il riscaldamento per ogni tempo futuro riferimento temporale; tenere in conto l’inerzia termica avrebbe ridotto la sua stima del riscaldamento di circa un terzo (vedi fig. SPM.5 dell’AR4). Ma di nuovo fu fortunato: considerare una sensitività climatica di ~2ºC invece dei più probabili ~3ºC circa compensa questo effetto, quindi il suo riscaldamento di 0.8 °C nel 20esimo secolo risulta quasi esattamente azzeccato (la stima reale è vicina agli 0.7 °C, vedi la figura sopra). (Una versione aggiornata di questi calcoli “a spanne” si può trovare ad esempio nel nostro libro Our Threatened Oceans, p.82.)

.

Variabilità naturale

Broecker non è stato il primo a prevedere il riscaldamento dovuto alla CO2. Un rapporto di esperti al Presidente degli USA Lyndon B. Johnson del 1965 avvertiva: “Entro il 2000 l’aumento dell’anidride carbonica sarà vicino al 25%. Questo potrebbe essere sufficiente a produrre un cambiamento del clima misurabile e forse marcato”. E nel 1972 una previsione più specifica e simile a quella di Broecker fu pubblicata su Nature dall’illustre scienziato dell’atmosfera J.S. Sawyer (per la storia in pillole, si veda il mio articolo qui).

La novità dell’articolo di Broecker – a parte l’aver introdotto il termine “riscaldamento globale” – fu il combinare le stime del riscaldamento da CO2 con la variabilità naturale. La sua tesi principale era che un raffreddamento climatico naturale

“ha, negli ultimi tre decenni, più che compensato l’effetto riscaldante prodotto dalla CO2 […] Tuttavia, l’attuale raffreddamento naturale raggiungerà il minimo più o meno nel prossimo decennio. Quando accadrà, l’effetto della CO2 tenderà a diventare un fattore significativo e nel primo decennio del prossimo secolo potremmo avere una temperatura globale maggiore degli ultimi 1000 anni.”

Quest’ultima previsione si è dimostrata essere corretta. L’idea che il lieve raffreddamento dagli anni ’40 agli anni ’70 sia dovuta alla variabilità naturale non può ancora essere esclusa, sebbene più probabilmente rappresenta solo una piccola parte della spiegazione e il raffreddamento è principalmente dovuto alle “polveri”, trascurate da Broecker, cioè all’aumento dell’inquinamento da aerosol antropogenico (Taylor and Penner, 1994). Tuttavia, il modo in cui Broecker ha stimato e anche previsto la variabilità naturale non ha resistito alla prova del tempo. Broecker usò i dati della carota di ghiaccio di Camp Century in Groenlandia, sostenendo che essi “potrebbero fornire un quadro delle fluttuazioni naturali della temperatura globale nel corso degli ultimi 1000 anni”. Ironicamente, fu proprio un lavoro successivo di Broecker sui cambiamenti della circolazione oceanica in Atlantico a mostrare che la Groenlandia è probabilmente il luogo meno rappresentativo dei cambiamenti della temperatura globale rispetto alla maggior parte degli altri luoghi sulla Terra, essendo troppo influenzato dalla variabilità nel trasporto oceanico del calore (vedi il nostro post recente sullo Younger Dryas, o l’ultimo libro di Broecker The Great Ocean Conveyor). Tuttavia, Broecker ebbe ragione nel sostenere che l’accumulo di CO2 prima o poi avrebbe superato queste variazioni climatiche naturali.

.

In definitiva, l’articolo di Broecker (insieme a quello di Sawyer) mostra che previsioni valide sul riscaldamento globale furono pubblicate negli anni ’70 in due fra le piu’ importanti riviste, Science e Nature, e che il riscaldamento si è verificato quasi esattamente come previsto almeno 35 anni fa. Alcuni importanti aspetti non erano ancora compresi a quel tempo, come il ruolo degli altri gas serra a parte la CO2, delle particelle di aerosol e del contenuto termico oceanico. Che le previsioni furono così precise ha avuto anche un elemento di fortuna, in quanto non tutti i processi trascurati influenzano i risultati nella stessa direzioni ma si compensano in parte. Ciononostante, l’aspetto principale che l’aumento di CO2 avrebbe causato, secondo le parole di Broecker, un “significativo riscaldamento globale”, era ben compreso negli anni ’70. In una intervista televisiva nel 1979 Steve Schneider lo descrisse giustamente come un consenso fra gli esperti, rimanendo controversie solo sull’esatta dimensione e gli effetti.

.

Referenze

BROECKER WS, 1975: CLIMATIC CHANGE – ARE WE ON BRINK OF A PRONOUNCED GLOBAL WARMING? SCIENCE Volume 189, Pages 460-463.

.

Traduzione di Riccardo Reitano e Riccardo Mancioli

Revisione di Simone Casadei

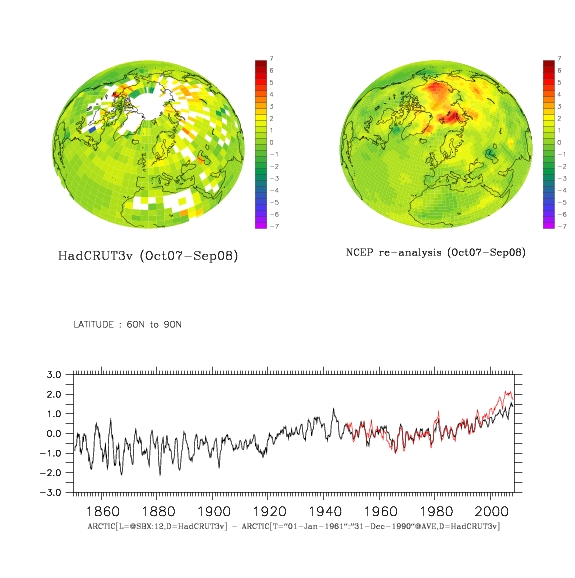

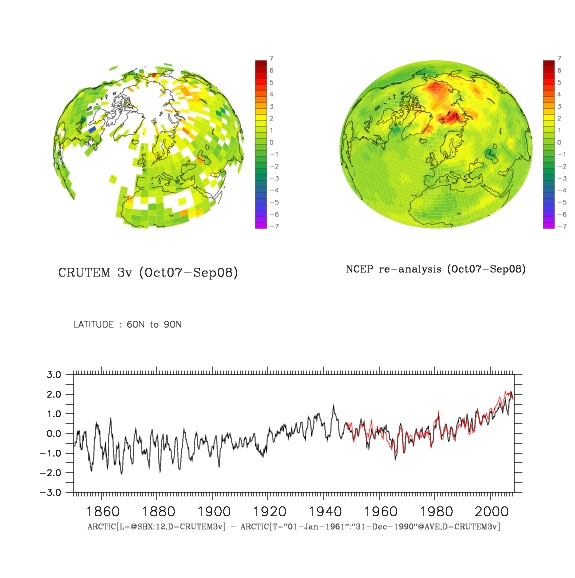

34 – A conclusione del 4° Anno Polare Internazionale

Questa settimana si è tenuta a Lillestrøm, appena fuori Oslo, la “Oslo Science Conference” la più grande conferenza di sempre, dicono gli organizzatori, sulle scienze polari. Vale la pena guardare alcune delle registrazioni online, e personalmente ho trovato la presentazione di David Barber (“On Thin Ice: The Arctic and Climate Change”, qui il link al video) affascinante ma anche un po’ allarmante.

Le tempeste e la neve influenzano la crescita del ghiaccio marino poiché uno strato di neve su di esso lo isola dall’atmosfera, più fredda, e ne impedisce la crescita. I venti e la massa aggiunta possono portarlo alla rottura, cosicché la quantità di ghiaccio pluriennale è minore di quanto ci si aspetti; il ghiaccio si è degradato e frantumato. Una missione su un rompighiaccio canadese sembra sia riuscita a rompere lastre di ghiaccio molto più spesse di quanto si pensasse grazie alla maggior debolezza del ghiaccio. Fanno anche parte di questa storia le più recenti inversioni del Beaufort Gyre, l’insolita risacca, e il ghiaccio recente sopra i blocchi di ghiaccio più vecchio che ha fatto credere ai satelliti che ci sia più ghiaccio pluriennale che nella realtà. Nel frattempo al NSIDC danno un ghiaccio marino stagionale sotto tono.

Il messaggio principale che ho portato a casa dalla Conferenza è che il ghiaccio marino è più importante di quanto credessi in precedenza. Sembra più chiaro ora che gioca un ruolo nell’amplificazione artica, cosa che ormai sta davvero emergendo.

Il messaggio principale che ho portato a casa dalla Conferenza è che il ghiaccio marino è più importante di quanto credessi in precedenza. Sembra più chiaro ora che gioca un ruolo nell’amplificazione artica, cosa che ormai sta davvero emergendo.

C’è chi sostiene che la riduzione del ghiaccio marino possa spiegare gli inverni freddi nell’emisfero nord, ma non ne sono ancora convinto. Gli inverni freddi sono dovuti ad una Oscillazione Artica debole, e quindi allo spostamento di masse d’aria che portano aria fredda polare verso sud, e nelle regioni polari questa aria viene sostituita da aria più mite. Quindi, un cambiamento del regime dei venti e temperature più miti possono favorire la riduzione del ghiaccio marino.

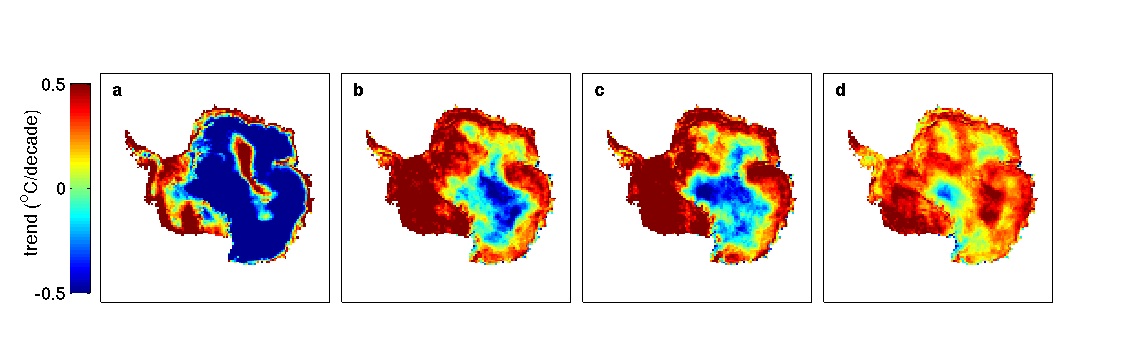

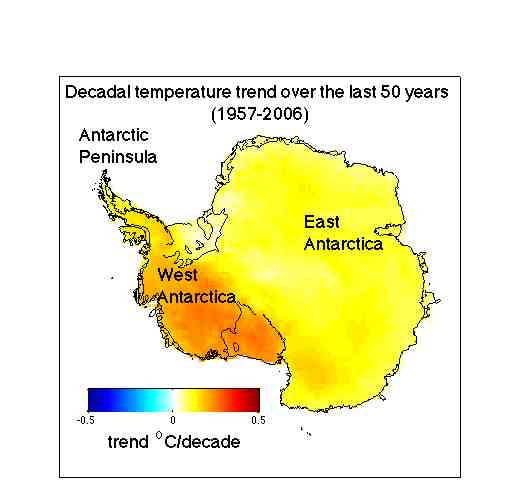

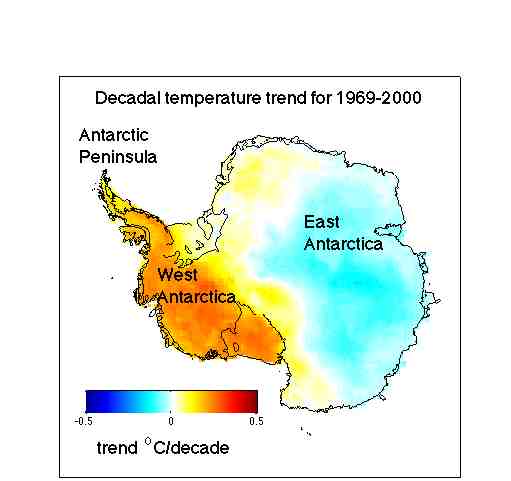

Il ghiaccio marino antartico è in media aumentato negli ultimi 30 anni, ma non dappertutto. Sia il generale aumento in Antartico orientale che la cospicua diminuzione in Antartico occidentale vengono attribuite al buco dell’ozono e ai corrispondenti cambiamenti nell’Oscillazione Antartica, sebbene ciò probabilmente non spiega cosa stia succedendo in inverno. In Antartico non è stato osservato alcun chiaro segno di amplificazione polare, tipo quello visto in Artico, e una spiegazione per questo potrebbe essere che il continente Antartico possiede una copertura di ghiaccio con una enorme inerzia termica. Ma i dati dalle carote di ghiaccio mostrano che in passato l’amplificazione polare e’ stata presente pure lì. Ciononostante, nell’emisfero nord l’Artico è caratterizzato da un oceano polare con ghiaccio marino in diminuzione. In entrambi i casi, i cambiamenti nelle masse d’aria e nei venti sono importanti a livello di variabilità interannuale e interdecadale, e per spiegare gli inverni freddi in Eurasia e il ghiaccio marino intorno all’Antartide.

.

Articolo originale su Realclimate.org

Traduzione di Riccardo Reitano, revisione di Simone Casadei.

Pubblicato su Climalteranti il 23/06/2010.

–

–

–

–

–

–

–

–

33 – Aggiornamenti sull’accumulo di calore negli oceani

E’ uscito un nuovo articolo su Nature di questa settimana sul trend recente del contenuto termico oceanico scritto da un numeroso gruppo di oceanografi guidati da John Lyman del PMEL. Il loro obiettivo è l’incertezza che circonda i vari tentativi di creare un insieme di dati omogeneizzati sul contenuto termico oceanico che affronti opportunamente i vari cambiamenti di strumenti e i bias di copertura che hanno afflitto i tentativi precedenti.

Abbiamo discusso questo tema diverse volte per l’importanza che riveste nel diagnosticare lo squilibrio radiativo a lungo termine dell’atmosfera. Essenzialmente, se c’è stata più energia in arrivo al limite dell’atmosfera di quella in uscita, deve essere andata da qualche parte – e questo “qualche parte” è essenzialmente l’oceano. (Altri serbatoi per questa energia, come la superficie della terra o lo scioglimento del ghiacci sono molto più piccoli e possono in gran parte essere trascurati).

Il problema principale è stato che nel tempo la rete di sonde XBT e i lanci di CTD sono stati sostituiti dalla rete di sonde flottanti ARGO che ha una migliore copertura e una strumentazione più omogenea. Tuttavia, mettere assieme la vecchia e la nuova rete e trattare i bias specifici delle sonde XBT è difficile. Una XBT (eXpendable Bathy-Thermograph) è una sonda che viene lanciata dalle navi le cui letture delle temperature in funzione del tempo vengono trasformate in un profilo in profondità sulla base della conoscenza su quanto velocemente la sonda affonda. Sfortunatamente, questa relazione è complicata e dipende dalla temperatura dell’acqua, dalla profondità, dal produttore della sonda, etc. Diversi gruppi – lavorando sugli stessi dati grezzi – che nelle XBT erano presenti bias associati ad una scorretta calibrazione e hanno tentato di fare correzioni migliori.

L’ultimo articolo è un tentativo per far convergere il consenso di molte delle persone coinvolte nel lavoro precedente e mostra quanto sia stato intenso il riscaldamento dell’oceano degli ultimi decenni. Infatti, la ‘miglior stima’ dei cambiamenti nei primi 700m sembra consistere in un riscaldamento maggiore di quello previsto dai dati NODC e persino maggiore di quello che i modelli stavano suggerendo:

E’ interessante notare che la variabilità interannuale – in particolare nella fase di transizione tra i due sistemi di osservazione (diciamo 1995-2005) – dipende molto dal modo esatto in cui si fanno le correzioni, mentre il trend a più lungo termine è solido.

Tutto ciò si lega direttamente ai commenti di Kevin Trenberth in questo recente articolo e in un commento di accompagnamento all’articolo di Lyman che, mentre i cambiamenti del bilancio energetico nel lungo termine sono spiegabili, i cambiamenti di breve periodo sono ancora estremamente difficili da quantificare.

Come sempre, è improbabile che questa sia l’ultima parola sull’argomento, ma è un’ulteriore prova che il pianeta fondamentalmente si sta comportando proprio secondo quanto pensano gli scienziati. Il che non è necessariamente una buona notizia.

.

Articolo originale su Realclimate.org

Traduzione di Riccardo Reitano e Daniela Zecca, revisione di Simone Casadei.

Pubblicato su Climalteranti il 16/06/2010.

—

–

–

–

–

32 – Il metano artico in movimento?

Il metano è come l’ala radicale del ciclo del carbonio, nell’atmosfera di oggi è un gas serra più potente, per molecola, della CO2, e ha una concentrazione atmosferica che può cambiare più rapidamente di quanto possa quella della CO2. E’ stato dato un copertura notevole risalto sui giornali ad un nuovo articolo pubblicato su Science questa settimana dal titolo “Estesa fuoriuscita di metano in atmosfera dai sedimenti della piattaforma artica Siberiana orientale“, che arriva sulla scia di una manciata di articoli correlati tra loro sul metano nell’ultimo anno o giù di lì. E’ giunto il momento di aver paura?

No. C’è abbastanza CO2 di cui aver paura, mentre il metano è la ciliegina sulla torta. Immagina di essere in autostrada su un auto a 60 miglia l’ora e ti stai avvicinando al traffico bloccato, e ti accorgi che il pedale del freno è rotto. Questa è la CO2. Poi ti accorgi che anche l’acceleratore è bloccato, così che quando urter5ai il camion davanti a te starai andando a 90 miglia l’ora invece che a 60. Questo è il metano. E’ questo il momento di preoccuparsi? No, ti saresti già da preoccupare per ill pedale del freno rotto. Il metano fa vendere giornali, ma non è il grosso della storia, nè sembra in grado di cambiare le regole del gioco della questione più grossa, che è la CO2.

[Le velocità riportate dell’auto riflettono le forzanti radiative relative di metano e CO2 antropogenici. David]

Per un quadro generale sugli idrati di metano vi rimandiamo a questo riferimento. L’articolo su Science di questa settimana è di Shakhova et al., il seguito di un articolo del 2005 su GRL. L’osservazione del 2005 una consisteva in elevate concentrazioni di metano nelle acque dell’oceano della piattaforma Siberiana, presumibilmente causate dalla emissione di gas dai sedimenti causava causa a sua volta di un eccesso di metano in atmosfera. Il nuovo articolo aggiunge le osservazioni di picchi di metano in aria sopra l’acqua, confermando la fuoriuscita di metano dalla colonna d’acqua, invece di essere ossidato in CO2 in acqua, ad esempio. I nuovi dati consentono di quantificare il flusso di metano in atmosfera da questa regione, a trovano che questa regione compete con il flusso di metano da tutto il resto degli oceani.

Ciò che manca in questi stessi studi è una prova che il rilascio di gas dalla piattaforma siberiana sia un fenomeno nuovo, un feedback climatico, piuttosto che semplicemente un fenomeno “nature-as-usual”, determinato dalla ritirata di permafrost sommerso residuo, rimasto dall’ultima era glaciale. Comunque, altri articoli recenti domanda affrontano l’argomento.

Westbrook et al 2009 hanno pubblicato immagini sonar sbalorditive di pennacchi diffusivi di bolle provenienti da sedimenti al largo delle Spitzbergen, in Norvegia. Le bolle stanno salendo da una linea sul fondo marino che corrisponde al limite della stabilità dell’idrato di metano, un limite che in una colonna d’acqua in via di riscaldamento ritirerebbe tenderebbe ad alzarsi verso la superficie dell’acqua. Uno studio modellistico di Reagan e Moridis del 2009 supporta l’idea che le bolle osservate possano essere una risposta al riscaldamento osservato della colonna d’acqua, determinato dal riscaldamento antropogenico del clima.

Un altro articolo recente, di Dlugokencky et al. 2009, descrive un incremento nella concentrazione di metano nell’aria nel 2007, e cerca di capire da cosa sia originato. Le concentrazioni atmosferiche di metano sono aumentate dal livello preantropogenico fino a circa l’anno 1993, a quel punto si sono improvvisamente stabilizzate. Il metano è un gas dal tempo di residenza in atmosfera basso, quindi dovrebbe stabilizzarsi se il flusso emissivo fosse costante, ma la forma della curva di concentrazione suggeriva una repentina diminuzione del tasso di emissione, derivante dal collasso dell’attività economica nell’ex blocco sovietico, o dal prosciugamento delle zone umide, o qualsiasi delle diverse spiegazioni proposte e irrisolte.

(Forse nel Sud Dakota dovrebbe passare una legge che affermi che il metano è influenzato dall’astrologia!). Un precedente incremento della concentrazione di metano nel 1998 potrebbe essere spiegato tramite l’effetto di El Nino sulle zone umide, ma l’incremento nel 2007 non è così semplice da spiegare. La concentrazione è rimasta stabile nel 2008, il che significa almeno che la variabilità interannuale è importante nel ciclo del metano e rende difficile poter dire se il tasso emissivo medio di lungo periodo stia aumentando in un modo che possa essere in accordo con una nuova retroazione del carbonio.

In ogni caso, fino ad ora è al massimo un feedback molto piccolo. Il Margine Siberiano è del confrontabile con il resto del mondo per importanza come sorgente di metano, ma la sorgente oceanica è complessivamente molto più piccola della sorgente terrestre. La gran parte del metano in atmosfera proviene dalle zone umide, naturali e artificiali associate all’agricoltura del riso. L’oceano è la patata piccola, e c’è sufficiente incertezza nel bilancio del metano per far rientrare degli aggiustamenti nelle sorgenti senza stravolgere granchè i carri delle mele.

Potrebbe essere questo solo l’inizio di ciò che diventerà un enorme feedback di carbonio in futuro? E’ possibile, ma è necessario tenere due cose a mente. Una è che non c’è ragione di fissarsi con il metano in particolare. Il metano è un gas dal basso tempo di residenza in atmosfera , mentre la CO2 essenzialmente si accumula nel ciclo del carbonio atmosfera/oceano, cosicchè alla fine la forzante climatica per l’accumulo della CO2 formata dall’ossidazione del metano può essere altrettanto importante della concentrazione “transitoria” dello stesso metano. L’altra cosa da ricordare è che non c’e’ ragione di fissarsi con gli idrati di metano in particolare, in contrasto al carbonio immagazzinato nelle torbe del permafrost Artico ad esempio. Ci vuole tempo affinchè le torbe si degradino ma pure per gli idrati ci vuole tempo per sciogliersi, essendo limitati dal trasporto di calore. In genere non esplodono improvvisamente.

Per cambiare le carte in tavola nel futuro del clima terrestre, il metano dovrebbe degassare in atmosfera in modo catastrofico, in una scala dei tempi che sia più rapida della vita media decennale del metano in aria. Fino ad ora nessuno ha mai visto o proposto un meccanismo che possa fare in modo che ciò accada.

References

Dlugokencky et al., Observational constraints on recent increases in the atmospheric CH4 burden. GEOPHYSICAL RESEARCH LETTERS, VOL. 36, L18803, doi:10.1029/2009GL039780, 2009

Reagan, M. and G. Moridis, Large-scale simulation of methane hydrate dissociation along the West Spitsbergen Margin, GEOPHYSICAL RESEARCH LETTERS, VOL. 36, L23612, doi:10.1029/2009GL041332, 2009

Shakhova et al., Extensive Methane Venting to the Atmosphere from Sediments of the East Siberian Arctic Shelf, Science 237: 1246-1250, 2010

Shakhova et al., The distribution of methane on the Siberian Arctic shelves: Implications for the marine methane cycle, GEOPHYSICAL RESEARCH LETTERS, VOL. 32, L09601, doi:10.1029/2005GL022751, 2005

Westbrook, G., et al, Escape of methane gas from the seabed along the West Spitsbergen continental margin, GEOPHYSICAL RESEARCH LETTERS, VOL. 36, L15608, doi:10.1029/2009GL039191, 2009

.

Articolo originale su Realclimate.org

Traduzione di: Tania Molteni e Riccardo Reitano.

Pubblicato su Climalteranti il 16/03/2010.

–

31 – SEALEVELGATE

Immaginate la situazione seguente. Nell’ultimo report dell’IPCC vengono previsti fino a 3 metri di innalzamento del livello dei mari entro la fine del secolo. Ma i siti web degli scettici mettono in luce alcune incongruenze (o “trucchi”, per usare le loro stesse parole).

Per prima cosa, sebbene le proiezioni dell’ IPCC sulle temperature forniscano un riscaldamento massimo di 6.4 °C (Tab. SPM3), il limite superiore dell’innalzamento dei mari e’ stato calcolato assumendo un riscaldamento di 7.6 °C.

In secondo luogo, l’IPCC ha scelto di calcolare l’andamento del sea-level fino all’anno 2105, invece del 2100 – tanto per aggiungere un po’ piu’ di allarmismo. Peggio ancora, il report IPCC mostra che negli ultimi 40 anni il livello dei mari si e’ innalzato di circa il 50% in meno rispetto a quanto previsto dai suoi modelli – cionondimeno, quegli stessi stessi modelli vengono utilizzati per fare delle proiezioni sul futuro!

Infine, le medesime proiezioni assumono un massiccio decremento della copertura dei ghiacci, in contrasto con quanto osservato nel passato.

Nonostante alcuni scienziati all’interno dell’IPCC abbiano segnalato per tempo come tutto questo possa condurre ad un problema di credibilita’, l’IPCC ha deciso di andare avanti in ogni caso.

Adesso la blogosfera ed i suoi megafoni mediatici stanno affilando le lame: teste dovranno cadere!

Impensabile? Gia’. Sono certo che l’IPCC non farebbe mai nulla di simile.

Ecco come sono andate le cose, in realta’.

Nell’ultimo report, l’IPCC ha previsto fino ad un massimo di 59 cm di innalzamento del livello dei mari, entro la fine del secolo. Ma RC ha subito evidenziato alcuni problemi nel merito.

Per prima cosa, sebbene le proiezioni dell’ IPCC sulle temperature forniscano un riscaldamento massimo di 6.4 oC, il limite superiore dell’innalzamento dei mari e’ stato calcolato assumendo un riscaldamento di soli 5.2 oC. – con una conseguente riduzione della stima finale di circa 15 cm.

In secondo luogo, l’IPCC ha scelto di calcolare l’andamento del sea-level fino all’anno 2095, invece del 2100 – tanto per tagliare via altri 5 cm. Ma la cosa peggiore e’ che il report dell’IPCC

mostra come negli ultimi 40 anni il livello dei mari sia in realta’ aumentato del 50% in piu’ rispetto a quanto stimato dai suoi stessi modelli – ciononostante, quegli stessi modelli vengono utlizzati per fare proiezioni sul futuro! E inine, tali proiezioni assumono che la copertura del ghiaccio antartico sia aumentata, determinando quindi un abbassamento del livello del mare, in contrasto con quanto osservato per il passato. (**)

Nonostante alcuni scienziati all’interno dell’IPCC abbiano segnalato per tempo come tutto questo possa condurre ad un problema di credibilita’, l’IPCC ha deciso di andare avanti in ogni caso.

Non se ne e’ accorto nessuno.

Il motivo per il quale faccio menzione di tutto questo è che c’è una lezione da apprendere.

L’IPCC non avrebbe mai pubblicato un limite superiore tanto poco plausibile come quello di 3 metri, e tuttavia non ha esitato a riportare un limite altrettanto poco plausibile, per quanto è basso, di 59 cm. E questo perche’ all’interno della cultura dell’IPCC, essere “allarmisti” è male, mentre essere “conservatori” (ovvero, sottostimare la potenziale severita’ degli eventi) è bene.

Va notato che questa cultura e’ l’esatto contrario dello “sbagliare nella direzione meno dannosa” (assumere che sia meglio avere sovrastimato il problema determinando l’ingresso in una low-carbon society un po’ prima del necessario, piuttosto che averlo sottostimato, inondando citta’ costiere e intere Isole-nazione).

Tanto per sgomberare il campo da ogni possibile fraintendimento: sono nella maniera piu’ assoluta contrario all’esagerazione dei cambiamenti climatici finalizzata a “sbagliare nella direzione meno dannosa”. Sono profondamente convinto del fatto che gli scienziati debbano evitare di sbagliare in qualsiasi direzione, mentre devono sempre fornire la stima piu’ equilibrata di cui siano capaci (motivo per il quale spesso mi sono espresso contro l’esagerazione “allarmista” nella scienza del clima; vedi ad esempio qui e qui).

Perchè penso che questo problema dell’IPCC sia di gran lunga peggiore dell’errore sull’Himalaya? Perchè non è una svista sfuggita ad un autore del Working Group 2 che ha mancato di seguire correttamente le procedure e ha citato un fonte inaffidabile. Piuttosto, è il risultato di combattute delibere degli esperti climatici del Working Group 1. Contrariamente all’errore sull’Himalaya, questa è una delle previsioni centrali dell’IPCC, discussa in modo prominente nel Summary for Policy Makers.

Cosa è andato storto in questo caso deve essere verificato attentamente mentre si considerano i miglioramenti futuri da apportare alla procedura dell’IPCC.

E vediamo se ora abbiamo imparato la lezione, questa volta sulla società e i media. Questa evidenza di una sottostima di un problema climatico dell’IPCC, presentata da uno dei principali autori dell’IPCC che studia il livello del mare, sarà altrettanto largamente riportata e discussa quanto, per dire, le affermazioni errate di un blogger sull’ “Amazongate”.

P.S. Risultati recenti sul livello del mare.

Un certo numero di valutazioni di ampio respiro sono venute fuori dall’ultimo rapporto dell’IPCC, tutte che concludono che l’innalzamento globale del livello del mare potrebbere essere oltre un metro:

la valutazione del Dutch Delta Commission, il Rapporto di Sintesi del Congresso sul Clima di Copenhagen, il rapporto del Copenhagen Diagnosis così come il Rapporto dello SCAR sui Cambiamenti Climatici in Antartide.

Questa è anche la conclusione di un certo numero di pubblicazioni peer-review recenti:

Rahmstorf 2007, Horton et al. 2008, Pfeffer et al. 2008, Grinsted et al. 2009, Vermeer and Rahmstorf 2009, Jevrejeva et al. 2010 (in stampa su GRL). L’eccezione significativa – Siddall et al. 2009 – è stata ritirata dagli autori dopo che abbiamo abbiamo mostrato alcuni errori numerici su RealClimate. Questo è un buon esempio di auto-correzione nella scienza (in palese contrasto con la pratica degli scettici del clima di perpetuare all’infinito false informazioni). Piuttosto stranamente, Fox News è riuscita a rigirare questa storia nel titolo “More Questions About Validity of Global Warming Theory“.

** Sui numeri mostrati prima.

Riguardo i numeri attuali nell’IPCC AR4, bisogna modificare la stima superiore di 59 cm aggiungendo 15 cm per renderla applicabile ai 6.2 °C di riscaldamento (non solo 5.2 °C) e 5 cm per farla arrivare al 2100 (non solo fino al 2095). Così risulta essere 79 cm. Bisogna aggiungere il 50% per correggere per la sottostima dell’innalzamento del livello del mare passato e si ottiene 119 cm.

Per il caso ipotetico all’inizio del post, basta introdurre errori simili nell’altra direzione. Aggiungiamo 31 cm per arrivar fino a 7.6 °C e all’anno 2105 (questa è una stima conservativa ma risulta in un numero tondo, 150 cm). Assumiamo ora di avere un modello che in confronto con i dati reali del livello del mare sale il 50% in meno (piuttosto che il 50% in più): così si arriva ai 3 metri citati prima. Per i dettagli, guardate i numeri sul livello del mare dell’IPCC.

.

Articolo originale su Realclimate.org

Traduzione di: Riccardo Reitano e Alessio Bellucci.

Pubblicato su Climalteranti il 16/03/2010.

–

30 – L’IPCC non è infallibile (incredibile!)

Come tutte le iniziative umane, anche l’IPCC non è perfetto. Nonostante gli enormi sforzi volti a produrre i suoi report con molteplici livelli di “peer review”, verranno alla luce alcuni errori. La maggior parte di questi saranno di minor rilievo e senza conseguenze, ma qualche volta potrebbero essere più sostanziali. Come molte persone sono a conoscenza (e come John Nieslen-Gammon ha sottolineato in un post lo scorso mese e come Rick Piltz oggi ripropone oggi), è presente un’affermazione nel secondo volume dell’IPCC (Working Group 2, WG2), riguardo il tasso di regressione dei ghiacciai dell’Himalaya che non è corretto e non adeguatamente documentato.

L’affermazione, contenuta nel capitolo sugli impatti climatici in Asia, è quella secondo cui la probabilità della “scomparsa entro l’anno 2035” dei ghiacciai dell’Himalaya è “molto alta” se la Terra continua a surriscaldarsi con la stessa velocità (WG 2, Capitolo 10, pag. 493), e viene riferita come fonte un rapporto del World Wildlife Fund del 2005. Esaminando le bozze e i commenti (disponibili qui), si segnala che l’affermazione è stata scarsamente commentata nelle revisioni, e che il riferimento al WWF (2005) sembra essere stata un’aggiunta dell’ultimo minuto (non compare nella prima e nella seconda bozza). Questa asserzione non è fatta né all’interno del riassunto per i decisori politici, né nel rapporto di sintesi globale, e cosi non può essere descritta come una “asserzione centrale” dell’IPCC. Comunque, l’affermazione ha alcune ricevuto l’attenzione della stampa fin dalla pubblicazione, in particolar modo di quella Indiana, quanto meno secondo quanto riportato da Google News, sebbene non fosse da noi ben nota prima del mese scorso.

E’ quindi ovvio che questo errore dovrebbe essere corretto (tramite un qualche tipo di rettifica alla relazione WG2 forse), ma è importante rendersi conto che questo non significa che i ghiacciai himalayani godano di ottima salute. Non è cosiì, e ci potranno essere gravi conseguenze per le risorse idriche se il ritiro continua. Si veda anche questo documento di revisione (Ren et al, 2006) su un sottoinsieme di questi ghiacciai.

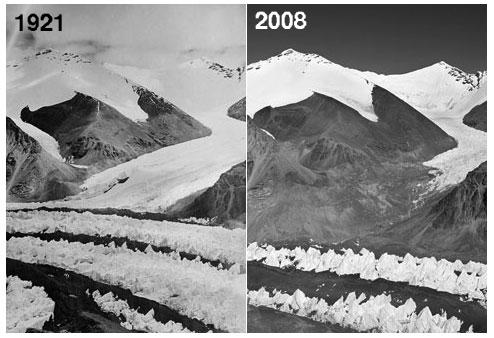

Didascalia: il ghiacciaio di East Rongbuk, ai piedi del monte Everest, ha perso 90-120 m di ghiaccio in quest’area dal 1921.

Più in generale, il sistema peer-review funziona bene per rendere i report dell’IPCC credibili, perché molti occhi diversi, con diversi punti di vista e conoscenza controllano lo stesso testo. Questo fa sì che il prodotto risultante rifletta più del solo parere di un singolo autore. In questo caso, sembra che non lo abbiano letto abbastanza persone con un’esperienza importante, o se lo hanno fatto, non lo hanno commentato pubblicamente. Questo potrebbe essere correlato al fatto che questo testo è contenuto nella relazione sugli impatti del Secodo Gruppo di Lavoro , che non riceve la stessa attenzione da parte della comunità dei fisici e degli scienziati rispetto a quanta ne riceva la relazione del Primo Gruppo di Lavoro (che è quella che generalmente guardano le persone che leggono Realclimate). Nel Primo Gruppo di Lavoro, le dichiarazioni sul ritiro continuo dei ghiacciai sono molto più generali e le norme sulle citazioni di letteratura non soggetta allapeer-review sono state rispettate molto di più.

Tuttavia, in generale, la scienza degli impatti climatici è meno chiara delle basi fisiche disponibili per il cambiamento climatico, e la letteratura è quantitativamente inferiore, quindi c’è inevitabilmente una maggiore ambiguità nelle dichiarazioni del Secondo Gruppo di Lavoro.

Nei rapporti futuri (ed è attualmente in corso l’organizzazione dell’AR5 per il 2013), saranno necessari ulteriori sforzi per garantire che i legami fra il Primo Gruppo di Lavoro e gli altri due rapporti siano più stretti, e che la comunità delle scienze fisiche sia incoraggiata ad essere più attiva negli altri gruppi.

In sintesi, il metro di giudizio di una organizzazione non è determinato dalla semplice presenza di errori, ma da come li affronta quando vengono evidenziati. L’attuale discussione sui ghiacciai Himalayani è quindi per l’IPCC una buona opportunità per migliorare ulteriormente le proprie procedure e concentrarsi di più su cosa l’IPCC dovrebbe fare nei periodi compresi fra le pubblicazioni dei principali rapporti.

Aggiornamento: questa comunicazione presentata all’AGU lo scorso dicembre da Karkel et al. è il miglior riassunto dello stato attuale dei ghiacciai dell’Himalaya e delle varie fonti di disinformazione che stanno girando a riguardo. Tratta di questo argomento, del rapporto Raina e dell’articolo recente di Lau et al..

Traduzione di Federico Antognazza, Lighea Speziale, Riccardo Reitano

Revisione di Simone Casadei

Pubblicato su Climalteranti il 04/02/2010.

–

29 – Aggiornamenti dei confronti tra i dati modellistici

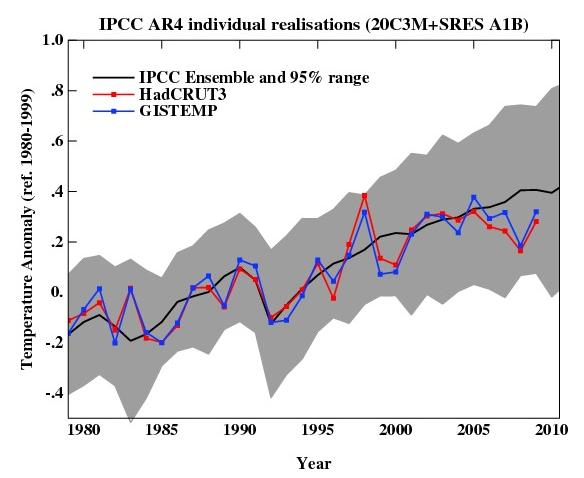

Vale la pena ogni tanto guardare indietro per vedere come si comportano le proiezioni fatte. Visto che stiamo arrivando alla fine di un altro anno, possiamo aggiornare tutti i grafici delle medie annuali con un altro singolo dato. Statisticamente non è che sia così importante, ma le persone sembrano interessate, quindi perchè no?

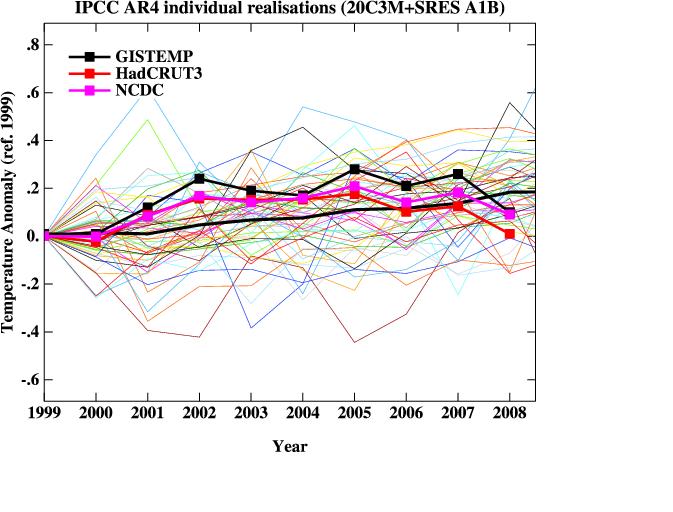

Ad esempio, eccovi l’aggiornamento del grafico che mostra le anomalie medie annue dai modelli IPCC AR4 rappresentate in confrontoalle temperature superficiali misurate tramite elaborazione HadCRUT3v e GISTEMP (non ha importanza quale). Tutti sono stati riferiti al periodo di base 1980-1999 (come nel report 2007 dell’IPCC) e la regione in grigio racchiude il 95% delle corse dei modelli. Il numero per il 2009 è la media Gennaio-Novembre.

Come si può notare, ora che siamo usciti dal recente calodovuto a La Niña, le temperature sono di nuovo nel mezzo del range stimato dai modelli. Se l’attuale fase di El Niño continua in primavera, possiamo aspettarci un 2010 ancora più caldo. Ma è da tener presente, come sempre, che i trend a breve termine (15 anni o meno) non possono essere previsti in maniera attendibile in funzione delle forzanti. Vale anche la pena rilevare che le simulazione dei modelli dell’AR4 sono un “insieme di possibilità” e variano in modo sostanziale fra loro in funzione delle forzanti imposte, della dimensione della variabilità interna e ovviamente della sensitività. Quindi, benchè coprano un grande intervallo di situazioni possibili, la media di queste simulazioni non è la “verità”.

C’è in giro chi sostiene che nessun modello riesce a spiegare le recenti variazioni della temperatura media globali (George Will ha sostenuto questo il mese scorso ad esempio). Naturalmente, presa letteralmente l’affermazione è vera per forza. Nessuna simulazione di un modello climatico può corrispondere alla esatta tempistica della variabilità interna del clima anni dopo. Ma qualcos’altro è coinvolto, specificatamente, che nessun modello ha prodotto alcuna realizzazione della variabilità interna che abbia dato un trend di breve periodo simili a quelli che abbiamo osservato. E questo è semplicemente non vero.

Possiamo vederlo nel dettaglio in modo un po’ più chiaro. Il trend dei dati della media annua HadCRUT3v nel periodo 1998-2009 (assumendo che l’anno fino ad oggi sia una buona stima del valore finale) è 0.06+/-0.14 °C/decade (notare che questo è positivo!). Se volete un trend negativo (sebbene non significativo), allora potete scegliere il periodo 2002-2009 del record GISSTEMP che è -0.04+/-0.23 °C/decade. L’intervallo dei trend nelle simulazioni modellistiche per questi due periodi temporali sono [-0.08,0.51] e [-0.14,0.55], e in ciascun caso ci sono molteplici corse del modello che hanno un trend inferiore a quello osservato (5 simulazioni in entrambi i casi). Quindi “un modello” ha mostrato un trend consistente con la “pausa” attuale. Comunque, che questi modelli l’abbiano mostrata è solo una coincidenza e non bisognerebbe assumere che questi modelli siano migliori degli altri. Se la “pausa” nel mondo reale fosse avvenuta in un altro momento, altri modelli avrebbero avuto un accordo migliore.

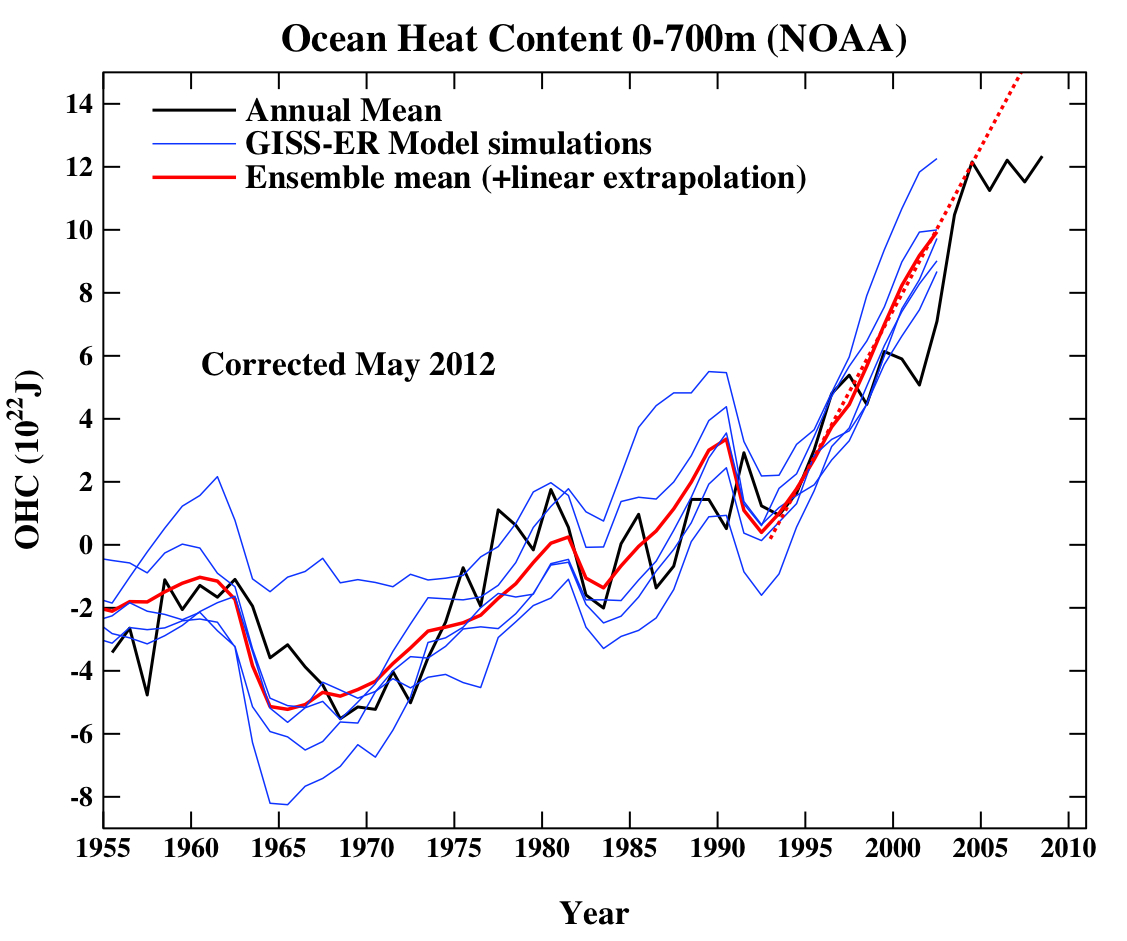

Un’altra figura che vale la pena di aggiornare è il confronto dei cambiamenti del contenuto termico oceanico dei modelli con gli ultimi dati dal NODC. Purtroppo, non ho a portata di mano i risultati del modello oltre il 2003, ma il confronto fra i dati trimestrali (fino alla fine di Settembre) e i dati annuali con il risultato del modello è ancora utile.

(Nota, non sono proprio sicuro su quale linea di riferimento considerare per questo confronto. I modelli sono semplicemente la differenza dal controllo, mentre le osservazioni sono prese così come sono dal NOAA). Ho esteso linearmente i valori del modello della media ensemble per il periodo successivo al 2003 (usando una regressione dal periodo 1993-2002) per avere una grossolana idea di dove quelle realizzazioni sarebbero potute andare.

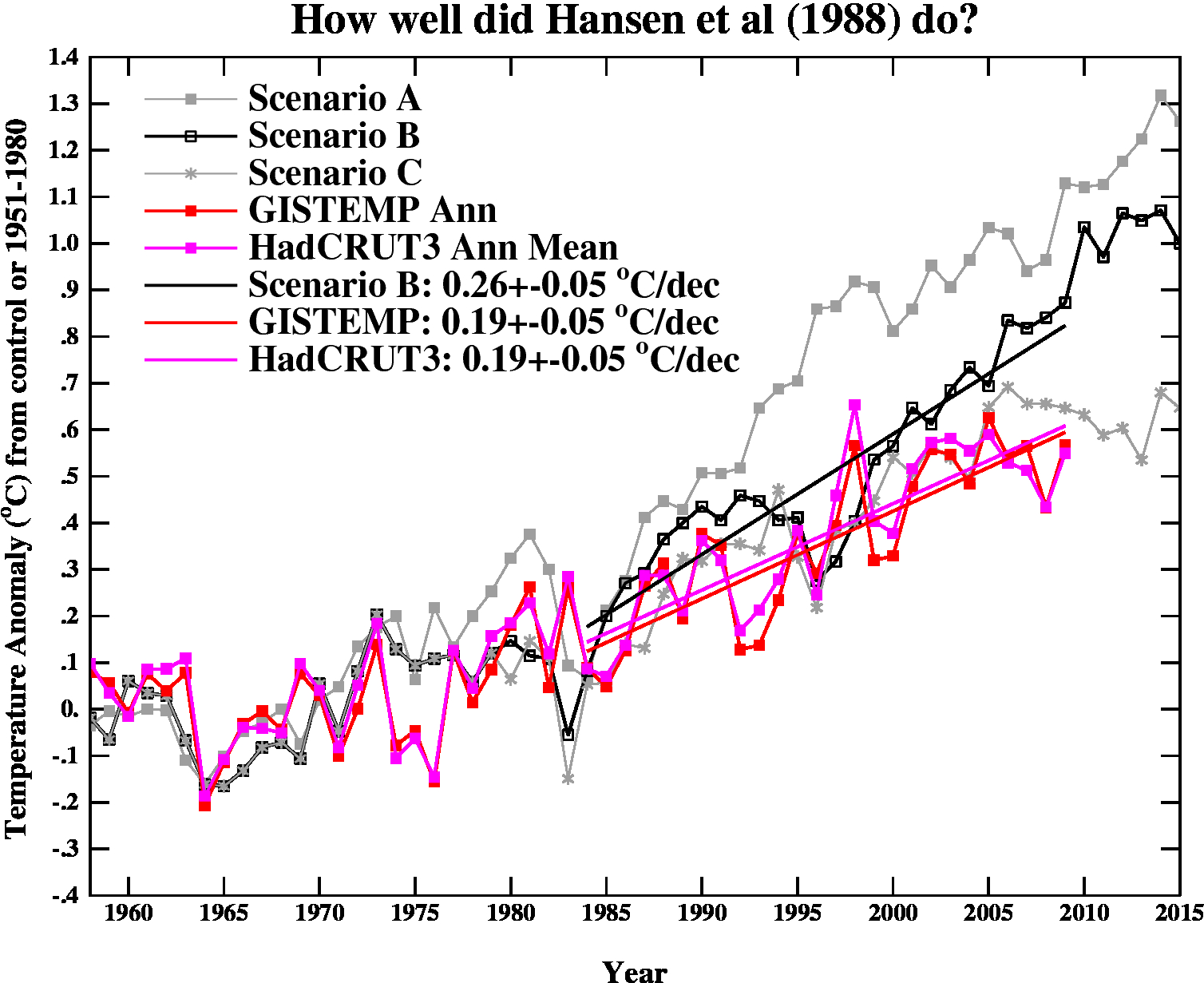

Infine, rivediamo la proiezione GCM più vecchia di tutte, Hansen et al (1988). Lo scenario B in quell’articolo risulta un pochino alto rispetto alla reale crescita delle forzanti (di circa il 10%), e il vecchio modello GISS aveva una sensibilità climatica che era un po’ più alta (4.2 °C per il raddoppio della CO2) dell’attuale miglior stima (~3ºC).

E’ più utile probabilmente pensare ai trend, e per il periodo dal 1984 al 2009 (la data del 1984 è stata scelta poichè è quando queste proiezioni sono iniziate), lo scenario B ha un trend di 0.26+/-0.05 °C/decade (incertezza al 95%, nessuna correzione per l’autocorrelazione). Secondo i dati GISTEMP e HadCRUT3 (assumendo che la stima per il 2009 sia corretta), i trend sono 0.19+/-0.05 °C/decade (da notare che l’indice delle stazioni meteorologiche di GISTEMP riporta 0.21+/-0.06 °C/decade). Correzioni per l’autocorrelazione renderebbero le incertezze maggiori, ma per come sono, la differenza fra i trend è appena significativa.

Sembra quindi che la proiezione “B” di Hansen et al sia probabilmente un po’ più calda rispetto al mondo reale, ma assumendo (un po’ incautamente) che il trend di 26 anni scali linearmente con la sensitività e con il forcing, potremmo usare questo disaccordo per stimare la sensitività del mondo reale. Questo ci darebbe 4.2/(0.26*0.9)*0.19=~ 3.4 ºC. Ovviamente, le barre di errore sono alquanto larghe (le stimo circa +/-1ºC per l’incertezza nei veri trend sottostanti e nelle forzanti reali), ma e’ interessante notare che la migliore sensitività stimata dedotta da questa proiezione è molto vicina a ciò che in ogni caso pensiamo. Come referenza, i trend nei modelli dell’AR4 per lo stesso periodo hanno un intervallo 0.21+/-0.16 °C/decade (95%). Da notare inoltre che la proiezione di Hansen et al. aveva una chiara capacità predittiva rispetto all’ipotesi nulla di nessun ulteriore riscaldamento.

Quelli di voi con l’occhio acuto avranno notato un paio di differenze fra la varianza nei modelli dell’AR4 nel primo paragrafo e il modello di Hansen et al. nell’ultimo. Questa è una caratteristica reale. Il modello usato a metà degli anni ’80 aveva una rappresentazione molto semplice dell’oceano – consentiva semplicemente alle temperature nello strato rimescolato di cambiare a seconda del cambiamento dei flussi alla superficie. Non conteneva nessuna variabilità dinamica dell’oceano, nessun evento El Niño, nessuna variabilità Atlantica multidecennale, etc. e quindi la varianza di anno in anno era inferiore a quella che ci si aspetterebbe. I modelli odierni hanno componenti dinamiche oceaniche e una maggiore variabilità oceanica di vario tipo, e credo che sia nettamente più vicina alla realtà dei modelli antiquati degli anni ’80, ma la grande differenza nella variabilità simulata implica che c’e’ ancora strada da fare.

Per concludere, nonostante il fatto che queste sono metriche relativamente rozze rispetto alle quali giudicare i modelli, e c’è un sostanziale livello di variabilità non forzata, gli accordi con le osservazioni sono alquanto buoni, e stiamo arrivando al punto in cui una migliore selezione dei modelli a seconda della loro capacità potrebbe presto essere possibile. Ma ci sarà dell’altro su questo punto nel nuovo anno.

Traduzione di Riccardo Reitano

Revisione di Simone Casadei

Pubblicato su Climalteranti il 20/01/2010.

–

28 – Hey Ya! (mal)

Notizie interessanti questo week-end. Apparentemente tutto ciò che abbiamo fatto durante le nostre carriere e’ una “ENORME menzogna” (sic) perchè tutta la fisica radiativa, la storia climatica, le misure strumentali, i modelli e le osservazioni satellitari risultano essere basate su 12 alberi in una oscura parte della Siberia. Chi lo sapeva?

Infatti, secondo sia il National Review che il Daily Telegraph (e chi non darebbe fiducia a queste fonti?), persino l’uso di un elevatore da parte di Al Gore in “Un Inconvinient Truth” fu fatto per mettere in risalto gli anelli di alcuni alberi selezionati ad arte, invece che l’aumento delle concentrazioni della CO2 negli ultimi 200 anni come tutti pensavano.

A chi dovremmo prestare fede? Ad Al Gore con i suoi “fatti” e “scienza soggetta a peer review” o ai praticanti di “Scienza dei blog”? Sicuramente, la scelta è chiara …

Seriamente, molti di voi avranno notato questa settimana ancora altra “blogorrea” sugli anelli degli alberi. L’obiettivo del giorno è una particolare serie di alberi (definita “una cronologia in dendroclimatologia) che è stata messa insieme per la prima volta da due russi, Hantemirov and Shiyatov, nei tardi ’90 (e pubblicata nel 2002). Questa cronologia pluri-millenaria proveniente da Yamal (in Siberia nordoccidentale) è stata minuziosamente messa insieme da centinaia di alberi sub-fossili seppelliti nei sedimenti dei delta dei fiumi. Essi hanno usato un sottoinsieme dei 224 alberi che gli è risultato essere sufficientemente lungo e sensibile (basato sulla variabilità inter-annuale) integrato con i dati di 17 alberi vivi per creare una registrazione climatica di “Yamal”.

Seriamente, molti di voi avranno notato questa settimana ancora altra “blogorrea” sugli anelli degli alberi. L’obiettivo del giorno è una particolare serie di alberi (definita “una cronologia in dendroclimatologia) che è stata messa insieme per la prima volta da due russi, Hantemirov and Shiyatov, nei tardi ’90 (e pubblicata nel 2002). Questa cronologia pluri-millenaria proveniente da Yamal (in Siberia nordoccidentale) è stata minuziosamente messa insieme da centinaia di alberi sub-fossili seppelliti nei sedimenti dei delta dei fiumi. Essi hanno usato un sottoinsieme dei 224 alberi che gli è risultato essere sufficientemente lungo e sensibile (basato sulla variabilità inter-annuale) integrato con i dati di 17 alberi vivi per creare una registrazione climatica di “Yamal”.

Una parte preliminare di questi dati è stata usata anche da Keith Briffa nel 2000 (processato usando un diverso algoritmo da quello usato da H&S per renderlo consistente con altre due serie delle alte latitudini settentrionali), per creare un’altra registrazione “Yamal” pensata per migliorare la rappresentazione della variabilità climatica di lungo periodo.

Dato che le registrazioni climatiche lunghe sono poche e mal distribuite non è sorprendente che vengano usate nelle ricostruzioni del clima. Le diverse ricostruzioni hanno usato metodi diversi e hanno fatto selezioni diverse dei dati originari a seconda di quali fossero gli scopi di studio. Gli studi migliori tendono a verificare la robustezza delle loro conclusioni togliendo diverse sotto-parti dei dati o escludendone intere classi (come gli anelli degli alberi) per verificare quale differenza se ne ottiene cosicchè in genere non ci sono molte discussioni su nessuna particolare registrazione proxy (nonostante quello che si può leggere altrove).

*****

A questo punto arriva Steve McIntyre, auto-proclamatosi assassino degli hockey sticks, che dichiara senza alcuna evidenza di qualunque genere che Briffa non solo ha ri-processato i dati dei Russi, ma li ha anche apparentemente selezionati per ottenerne il segnale voluto. Queste accuse sono state fatte senza una qualsivoglia evidenza.

McIntyre ha basato la sua “critica” su un test condotto aggiungendo casualmente un set di dati trovato su internet proveniente da un’altra località in Yamal. C’è stata gente che ha scritto intere tesi su come costruire le cronologie con gli anelli degli alberi in modo da evitare effetti da dati terminali e preservare il maggior segnale climatico possibile. Stranamente nessuno ha mai suggerito di prendere semplicemente un set di dati, togliere gli alberi verso i quali si abbiano delle obiezioni politiche e sostituirli con un altro set trovato in giro sul web.

La dichiarazione di Keith Briffa descrive chiaramente lo sfondo sul quale si sono svolti questi studi e rifiuta categoricamente le accuse di McIntyre. Significa questo che la cronologia di Yamal esistente è sacrosanta? Assolutamente no – tutti questi proxy records sono soggetti a revisione con l’aggiunta di nuovi (rilevanti) dati e se le registrazioni cambiano significativamente in funzione di queste aggiunte non è chiaro finchè questa operazione non viene fatta.

Quello che è chiaro, comunque, e’ che c’è un modello caratteristico facilmente predicibile per le reazioni a questi post sui blog che è stato discusso molto volte. Come abbiamo detto l’ultima volta in cui c’è stata una polemica di questo tipo:

“Comunque, in alcuni settori c’è chiaramente un desiderio latente e profondamente sentito di ridurre l’intero problema del riscaldamento globale ad una fantasia statistica o ad un errore. Questo ha portato a dei veri e propi salti mortali alle conclusioni quando questo argomento ha raggiunto la blosfera.”

Plus ça change…

La tempistica di queste mini-tempeste dei blog e’ sempre la stessa. Viene fatta un’accusa non verificata di illecito basata sul nulla, e viene istantaneamente “telegrafata” nella sfera dei negazionisti mentre viene abbellita strada facendo per essere applicata a qualunque cosa abbia la forma dell’hokey-stick e a chiunque e a tutti gli scienziati, anche a quelli nemmeno lontanamente correlati. I soliti sospetti diventano isterici per la gioia che finalmente “l’imbroglio” e’ stato scoperto e ci si scambia congratulazioni. Dopo poco ci si accorge che nessuna costruzione scientifica è crollata e la ricerca continua sul problema “reale” che senza dubbio deve solo essere trovato. Fin troppo spesso la storia torna a spuntare nuovamente perchè qualche opinionista o blogger non vuole, o non gli interessa, fare i compiti a casa. L’effetto netto sulla gente comune? Confusione. L’effetto netto sulla scienza? Zero.

Detto questo, sembra che McIntyre non abbia investigato direttamente nessuna delle ridicole estrapolazioni dei suoi supposti risultati evidenziati prima, sebbene abbia chiaramente messo in movimento il gioco. Senza alcun dubbio avra’ scritto al National Review, al Telegraph e ad Antony Watts per chiarire i loro errori e confidiamo nel fatto che le correzioni appariranno al più presto … Si, certo.

Ma può essere vero che tutte le Hockey sticks siano fatte in Siberia? Di seguito un’inchiesta esclusiva di RealClimate.

Cominciamo con l’originale “MBH [Michael E. Mann, Raymond S. Bradley , NdT] hockey stick” così come replicata da Wahl and Ammann:

Hmmm… nessuna traccia delle cronologie di Yamal qui. E che dire della mazza da hockey ottenuta da Oerlemans dalla ritirata dei ghiacciai dal 1600?

Eh no, nemmeno lì, nessuna serie di Yamal. E i risultati di Osborn and Briffa, robusti anche quando vengono rimossi tre qualunque dei record?,

Forse la mazza da hockey dalle ricostruzioni delle temperature dei fori geodetici?

No. Cosa dire allora delle mazze da hockey delle concentrazioni di CO2 dalle carote di ghiaccio e dalle misure dirette?

Ma neanche pressappoco… Cosa dobbiamo pensare sull’impatto della ricostruzione artica di Kaufman et al 2009 quando si esclude Yamal?

Oh. E la mazza da hockey che si ottiene quando non si usano per niente gli anelli degli alberi (curva blu)?

No. Bene, allora che dire della lama della mazza da hockey dalle registrazioni strumentali stesse?

No, ancora no. Ma un momento, forse c’è una novità: (idea originale di Lucia):

Macché….

Si potrebbe pensare che alcune cose si spieghino da sole, ma apparentemente c’è chi le cose non le capisce per niente, dunque vediamo di essere estremamente chiari. La scienza procede per confutazioni di assunzioni e di risultati di altri, con il desiderio comune di avvicinarsi alla “verità”. Non c’è niente di male quando la gente costruisce nuove dendrocronologie o testa la robustezza di risultati precedenti su dati aggiornati o con nuovi metodi. E non c’è niente di male nemmeno a pensare a cosa succederebbe se fosse tutto sbagliato. Ciò che invece è opinabile è sommare criticismo tecnico con accuse di scorrettezza scientifica non documentate, ingiustificate e non verificate. Steve McIntyre insiste a dire che dovrebbe essere trattato da professionista. Ma è professionale continuare a diffamare scienziati con vaghe insinuazioni e perfide storielle inventate di sana pianta fuori contesto, invece di sottoporre a peer review il suo lavoro? Il nostro continua a non assumersi alcuna responsabilità per le ridicole fantasie e le esagerazioni diffuse dai suoi sostenitori, e sembra anzi felice di crogiolarsi nel plauso di questi, piuttosto che rettificare le cattive interpretazioni da lui suscitate. Se davvero vuole cambiare, si trova davanti ad una chiara possibilità: o continuare a recitare la parte del Don Chisciotte per la platea, o produrre qualcosa di costruttivo che sia davvero meritevole di pubblicazione.

Il processo di peer-review non è niente di sinistro e non prende parte ad alcun complotto globale; piuttosto, esso è il procedimento mediante il quale si è forzati a vincolare la propria retorica ai loro veri risultati. In generale, non è possibile spacciare suggerimenti imprecisi su qualcosa che potrebbe essere importante per il quadro generale senza davvero mostrare che lo è. E’ importante davvero se qualcosa “conta”, altrimenti, per quel che varrà, ci si potrebbe limitare a correggere gli errori di ortografia.

E allora vai, Steve, sorprendici.

Aggiornamento: Briffa e colleghi hanno risposto con un’estesa (e, a mio avvisto, convincente) rigetto dell’articolo di McIntyre.

.

Articolo originale su Realclimate.org

Traduzione di: Emanuele Eccel e Riccardo Reitano.

Revisione di: Simone Casadei.

Pubblicato su Climalteranti il 03/11/2009.

–

27 – Servizi climatici

Ho di recente partecipato alla Terza Conferenza Mondiale sul Clima (WCC-3), ospitata dall’Organizzazione Mondiale Meteorologica (WMO) a Ginevra. La maggior parte degli interventi era volta a fornire i “servizi climatici” (CS) e a coordinarli in modo globale. Ma cosa sono i servizi climatici, e quanto di quello che è stato previsto è scientificamente fattibile?

Climate services è piuttosto un nuovo termine che implica la fornitura di informazioni climatiche rilevanti sull’adattamento ai cambiamenti e alle deviazioni climatiche, la pianificazione di lungo periodo e lo sviluppo di sistemi semplici di prima attenzione (EW).

CS riguardano sia i dati riguardanti il clima passato che quello futuro, e di solito coinvolgono le procedure di disaggregazione per fornire informazioni su scala regionale e locale. Questo può essere riassunto dai contenuti del sito http://www.climateservices.gov/ (si veda inoltre questo link a un articolo relativo i servizi climatici nazionali degli Stati Uniti).

Durante la WCC-3 si è sottolineato il fatto che CS debbano non solo comunicare informazioni rilevanti, ma che queste informazioni debbano anche essere “tradotte” ai non esperti in modo che possano agire in tempo.

Una preoccupazione espressa durante la WCC-3 riguarda il fatto che i modelli climatici globali non forniscono ancora una descrizione sufficientemente accurata degli aspetti regionali e locali del clima. I modelli hanno inoltre serie limitazioni quando sono utilizzati per previsioni stagionali o decennali. I modelli climatici erano in origine progettati per fornire un’ampia immagine del nostro sistema climatico, e il fatto che ENSO, i cicloni, vari fenomeni ondosi (osservati nel mondo reale) appaiano negli output dei modelli, sebbene con differenze nei dettagli, ci da una maggior confidenza che essi possano fotografare i reali processi fisici. Per le previsioni climatiche, questi dettagli, spesso rappresentati dai modelli, devono essere più accurati.

Sebbene gli aspetti dinamici e le scale regionali siano importanti, occorre tenere a mente che i modelli atmosferici che simulanoil trasferimento radiativi atmosferico rappresentano il cuore della teoria che sta alle spalle dell’AGW, e che l’AGW coinvolge le scale temporali più lunghe. Alcuni scienziati dubitano fortemente di questi modelli di trasferimento radiativo, che sono strettamente correlati agli algoritmi utilizzati per l’analisi remota per il calcolo delle temperature (es: nei satelliti). Se qualcuno interpreta il Nuovo report degli scienziati della WCC-3 come se la situazione non sia più così tremenda come precedentemente pensato, questi è incorso in una grossa delusione. Piuttosto l’opinione è che i cambiamenti climatici siano inevitabili, e che dobbiamo stabilire gli strumenti per pianificare e affrontare i problemi.

Esistono comunque alcuni segnali che incertezze ed errori sistematici nei modelli climatici globali (GCMs) possano essere ridotti aumentando la risoluzione spaziale (e temporale), o includendo una rappresentazione realistica della stratosfera. I problemi associati alla descrizione del clima a livello locale e regionale non può essere corretta semplicemente attraverso la disaggregazione.

Una preoccupazione consisteva nel fatto che una parte di codice chiamata “parametrizzazione” (impiegata nei modelli per descrivere l’effetto principale dei processi fisici che avvengono ad una scala spaziale troppo piccola per la griglia del modello) può non essere sufficientemente buona per il lavoro di simulazione di tutti gli aspetti climatici locali. Per questo motivo è stato richiesto uno sforzo coordinato a livello globale per provvedere alle risorse di calcolo e alla simulazione climatica.

Alcuni relatori hanno sottolineato l’importanza di un reale set globale di osservazioni climatiche. In questo contesto è altresì cruciale la condivisione dei dati senza restrizioni, e inoltre è cruciale aiutare i paesi poveri affinchè riescano a fare misure di elevata qualità.

Sebbene durante la WCC-3 l’attenzione sia stata posta sull’adattamento, si è anche sottolineato come la mitigazione sia ancora un obbligo se si vogliono evitare serie calamità climatiche. Si è concluso che occorre passare da una strategia di “gestione delle catastrofi” a una politica di “gestione del rischio”.

Un triste esempio che mostra che non ci siamo ancora arrivati sono state le alluvioni previste sull’Africa centroccidentale di Giugno – Agosto 2008. È successo per la prima volta nella storia che la Croce Rossa ha inviato un allarme preventivo basato su una previsione. Sfortunatamente, si verifcò una mancanza di volontà di donare fondi prima che il disastro si fosse verificato e, tristemente, la previsione risultò essere estremamente accurata. La domanda è se stiamo facendo lo stesso errore quando analogamente verrà il turno dei cambiamenti climatici.

Le relazioni della conferenza sono state postate sul sito della WMO WCC-3. Oltre alle tematiche scientifiche, un certo numero di relatori ha discusso di politica. Esiste anche un nuovo libro – Climate Senses – che è stato pubblicato di recente per la WCC-3, che tratta delle previsioni sul clima e delle informazioni per i decisori.

.

Articolo originale su Realclimate.org

Traduzione di: Federico Antognazza

Revisione di: Simone Casadei.

Pubblicato su Climalteranti il 20/09/2009.

–

26 – La soluzione delle dispute tecniche in ambito scientifico

Uno dei punti di forza della scienza è la sua capacità di risolvere le controversie attraverso procedure e standard generalmente accettati. Molte questioni scientifiche (in modo particolare quelle più tecniche) non sono oggetto di opinioni ma hanno risposte precise.

Gli scienziati documentano le loro procedure e scoperte nella letteratura scientifica soggetta al processo di peer-review in modo tale che queste possano essere sottoposte a verifica da parte di altri. La maniera corretta di verificare i risultati è, naturalmente, anche attraverso la letteratura soggetta a peer-review in modo tale che il controllo stesso segua gli stessi standard della documentazione come è stato fatto per arrivare alla scoperta originale.

Questa verifica può essere in forma di un nuovo documento indipendente oppure sottoforma di un commento relativo ad un documento già pubblicato. Quest’ultima è la via appropriata se la verifica non è basata su nuovi dati (ed è quindi un pezzo di ricerca a sé stante), ma è una critica dei metodi utilizzati in una pubblicazione.

Tali commenti tecnici sono costantemente pubblicati sui giornali e gli autori di Realclimate sono stati naturalmente coinvolti nella scrittura o oggetto di tali commenti. Un esempio significativo è stato un commento a Science che mostrava che una verifica di Von Storch et al. (2004) riguardo alla ricostruzione climatica denominata “bastone da hockey” di Mann et al. (1998) “ era basata su una scorretta implementazione della procedura di ricostruzione”. Abbiamo discusso le implicazioni su Realclimate una volta apparso il commento. Un altro esempio recente è un commento di Schmith et al. su un articolo di Stefan apparso su Science, relativo all’aumento del livello del mare, si nota che ha sbagliato a considerare l’effetto di livellamento sull’autocorrelazione dei dati che ha usato. Nella sua risposta, Stefan ha riconosciuto questo errore ma ha dimostrato che non ha effetto sulle sue conclusioni principali.

Che agli autori originali sia consentito di rispondere ad un commento nello stesso numero della rivista, e che gli autori del commento arrivino ad esaminare questa risposta prima di decidere se mandare avanti il proprio commento, sono chiari segni di garanzia di una procedura imparziale, in aggiunta alla neutralità dell’editore della rivista e al fatto che revisori indipendenti supervisionino il processo. Anche se gli autori del ‘commento e replica’ continuano a restare per certi versi in disaccordo, questo processo di successivi commenti nella maggior parte dei casi risolve la questione fino alla soddisfazione della comunità scientifica. Questo sistema espone i fatti in una maniera imparziale e trasparente e fornisce agli esterni una buona base per giudicare chi abbia ragione. In questo modo esso fa progredire la scienza.

C’è tuttavia un modo diverso di criticare gli articoli scientifici, che è prevalente in blog come ClimateAudit. Questo modo implica di verificare, “con tutti i mezzi necessari”, qualsiasi articolo le cui conclusioni non siano gradite. Ciò può essere basato su semplici errori di stampa, fraintendimenti di base sui vari argomenti e “colpevolezza per associazione”, sebbene a volte venga avanzata occasionalmente un’argomentazione interessante. Dal momento che queste affermazioni vengono raramente verificate per vedere se ci sia un qualsiasi reale effetto sul risultato principale, l’esito è una serie di critiche fuorvianti, a prescindere dal fatto che alcune di queste critiche siano in realtà valide o salienti, il che dà l’impressione che ognuno di questi articoli sia senza valore e che tutti i loro autori siano nel migliore dei casi incompetenti, nel peggiore disonesti. E’ l’equivalente di sostenere di aver trovato degli errori ortografici in un articolo di giornale. Divertente per un po’, ma fondamentalmente irrilevante per comprendere un argomento o giudicare il valore del giornalista.

Mentre il fatto che vengano pubblicati commenti – anche piuttosto negativi – degli articoli nei blog è assolutamente ragionevole (dopo tutto, lo facciamo anche qui alle volte), affermazioni sul fatto che un particolare articolo sia stato “screditato” o “falsificato”, senza che sia stato (come minimo) sottoposto ad un processo di “peer-review”, dovrebbero essere considerate con estremo scetticismo. Allo stesso modo dovrebbero essere considerate le accuse di disonestà o cattiva condotta che non siano già state definitivamente ed inequivocabilmente dimostrate.

Ciò ci porta ad una recente osservazione di Hu McCulloch che un post su ClimateAudit.org dettagliatocce descrive in dettaglio un errore nell’articolo di Steig et al. su Nature sul cambiamento di temperatura in Antartico, non ha ricevuto da Steig et al. il credito dovuto quando hanno pubblicato un Corrigendum all’inizio di questo mese. In questo caso, il commento di McCulloch sull’articolo era pienamente valido, ma lui ha scelto di evitare il contesto del normale scambio scientifico – scrivendo invece i suoi commenti su ClimateAudit.org – e giocando al gioco del ‘ti ho beccato’ accusando di plagio quando non è stato citato.

McCulloch accusa Steig et al. di aver fatto propria la sua scoperta ovvero che Steig et al. stessi non avevano tenuto in conto l’autocorrelazione quando hanno calcolato la significatività dei trends. Mentre la versione dell’articolo pubblicata non includeva questa correzione, è evidente che gli autori erano a conoscenza dell’esigenza di farla, in quanto nel testo dell’articolo si afferma che la correzione era stata fatta. I calcoli corretti erano stati eseguiti usando metodi ben conosciuti, i cui dettagli sono disponibili in una miriade di libri di testo di statistica e articoli su rivista. Non ci può quindi essere nessuna pretesa di originalità da parte del Dr. McCulloch nè per l’idea di applicare una tal correzione nè per i metodi con cui farlo, tutte cose discusse nell’articolo originale. Se McCulloch fosse stato la prima persona a far notare a Steig et al. l’errore nell’articolo, o se avesse scritto direttamente a Nature prima che il Corrigendum fosse presentato, sarebbe stato appropriato riconoscerlo e gli autori sarebbero stati felici di farlo. Nel caso ci fosse confusione su questo, facciamo notare che, come discusso nel Corrigendum, l’errore non ha alcun impatto sulle principali conclusioni nell’articolo.

Non c’è nulla di sbagliato nelle critiche costruttive, e mettere in luce errori – anche quelli meno significativi – è importante e utile. La differenza, però, fra persone che cercano di trovare informazioni sul mondo reale e persone che vogliono solo segnare punti politicamente, consta nel cosa venga fatto di quegli errori. Questo è il test per un dialogo scientifico costruttivo. Accuse speciose di frode, plagio e simili non passano questo test; al contrario, queste cose semplicemente avvelenano l’atmosfera con una perdita per tutti.

.

Articolo originale su Realclimate.org

Traduzione di: Riccardo Mancioli, Tania Molteni e Riccardo Reitano

Revisione di: Simone Casadei.

Pubblicato su Climalteranti il 17/09/2009.

–

25 – Altre leggerezze

Roger Piellke Sr. in un recente post su un blog ha sollevato accuse molto forti contro RealClimate. Poichè provengono da un collega scienziato, riteniamo che sia il caso di rispondere direttamente.

L’affermazione che Pielke considera “disinformazione” è una singola frase da un post recente:

“Alcuni aspetti del cambiamento climatico stanno progredendo più velocemente di quanto non ci si aspettasse qualche anno fa – come l’aumento dei livelli del mare, l’aumento del calore immagazzinato nell’oceano e il restringimento del ghiaccio marino Artico.”

Prima di tutto, siamo sorpresi che Pielke abbia lanciato queste forti accuse contro RealClimate, poichè l’afffermazione di cui sopra semplicemente riassume alcuni risultati chiave del Rapporto di Sintesi del Congresso sul Clima di Copenhagen, di cui abbiamo discusso il mese scorso. Esso è un documento “peer-reviewed” scritto da 12 eminenti scienziati e “basato sui 16 interventi plenari al Congresso ed anche sui suggerimenti di più di 80 presidenti e co-presidenti delle 58 sessioni parallele tenute al Congresso”. Se Pielke fosse in disaccordo con i risultati di questi scienziati, sarebbe più logico rivolgersi a loro piuttosto che rivolgere a noi accuse insistenti. Ma ad ogni modo diamo un’occhiata ai tre punti della supposta disinformazione:

.

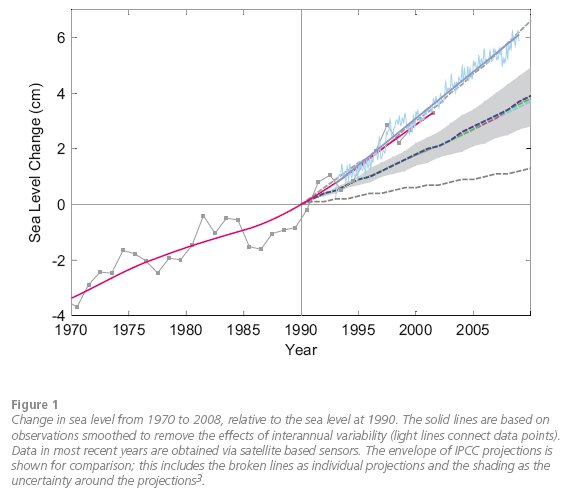

1. Livello del mare. Il rapporto di Sintesi mostra il grafico qui sotto e conclude:

“Dal 2007, lavori di comparazione delle proiezioni dell’IPCC del 1990 con le osservazioni mostrano che alcuni indicatori climatici stanno cambiando vicino al limite superiore dell’intervallo indicato dalle proiezioni o, come nel caso dell’aumento del livello del mare (fig. 1), a tassi ancora più elevati di quelli indicati dalle proiezioni del’IPCC”.

Questo grafico è un aggiornamento di Rahmstorf et al., Science 2007, con dati fino alla fine del 2008. (Notare che il confronto è con le proiezioni del TAR dell’IPCC, ma essendo le proiezioni dell’AR4 entro il 10% di quelle dei modelli del TAR non fa molta differenza)

Pielke sostiene che questo “NON È VERO” (maiuscolo e grassetto sono suoi), affermando che “l’andamento del livello del mare si è invece appiattito dal 2006” e mostrando questo grafico. Il grafico mostra un andamento del livello del mare durante tutto il periodo dei rilevamenti satellitari (dal 1993) di 3.2 +/- 0.4 mm/anno ed è molto simile ad un’analisi francese indipendente degli stessi dati satellitari mostrati nel rapporto di sintesi (linee blu sopra). La migliore stima dei modelli dell’IPCC per lo stesso periodo è 1.9 mm/anno (linee tratteggiate colorate all’interno dell’intervello di incertezza in grigio). Quindi la conclusione del Rapporto di Sintesi e del tutto corretta.

“L’appiattimento del livello del mare dal 2006” a cui si riferisce Pielke è non pertinente ed ingannevole per diverse ragioni (notare pure che Anthony Watts è andato anche oltre e ha dichiarato che il livello del mare dal 2006 ad oggi è in realtà “piatto”!). Innanzitutto, i trend su un così breve sotto-intervallo di qualche anno è estremamente variabile a causa delle variazioni naturali di breve periodo, e può dare qualunque risultato si voglia selezionando ad hoc un intervallo appropriato (come Pielke e Lomborg fanno entrambi). L’assurdita’ di questo approccio si può vedere prendendo un trend ancora piu’ recente, diciamo a partire dal Giugno 2007, che dà 5.3 +/- 2.2 mm/anno! Secondo punto, questo trend di breve periodo (1.6 +/- 0.9 mm/anno) non è nemmeno robusto fra i vari set di dati – l’analisi dei francesi mostrata sopra ha un trend dall’inizio del 2006 di 2.9 mm/anno, molto simile all’andamento di lungo periodo. Terzo punto, l’immagine riportata da Pielke per mostrare i dati senza correzione barometrica inversa – il breve e marcato picco a fine 2005, che rende l’andamento visivo (sempre una scelta infelice di metodologia statistica) quasi piatto da allora, scompare quando questo effetto viene considerato. Cio’ significa che il picco del 2005 era semplicemente dovuto alle fluttuazioni della pressione dell’aria e non ha nulla a che vedere con i cambiamenti climatici del volume oceanico. L’andamento nei dati dal 2006 con la correzione barometrica inversa è 2.1 +/- 0.8 mm/anno.

.

2. Contenuto di calore degli oceani. Il Rapporto di Sintesi afferma:

Le stime attuali indicano che il riscaldamento degli oceani è circa il 50% superiore a quanto affermato precedentemente dall’IPCC.

Si tratta di una conclusione di una nuova analisi dei dati di contenuto di calore degli oceani pubblicata da Domingues et al., Nature 2008, applicata al periodo 1961-2003, lo stesso periodo analizzato nel rapporto IPCC. Pielke sostiene che questo “NON È VERO” e replica affermando: “Non c’è stato alcun riscaldamento statisticamente significativo della superficie degli oceani dal 2003”. Ebbene, ancora un volta questo non è rilevante ai fini di quanto effettivamente scritto nel Rapporto di Sintesi e, ancora una volta, Pielke fa riferimento ad un periodo di 5 anni, troppo breve per ricavarne trend statisticamente robusti in presenza di variabilità di breve termine e di problemi di accuratezza dei dati (la variabilità interannuale ad esempio cambia molto nei diversi data-sets relativi al contenuto di calore degli oceani):

Per buone ragioni, il Rapporto di Sintesi considera un intervallo temporale sufficientemente lungo da permettere confronti significativi. Ma in ogni caso, il trend dal 2003 al 2008 nei dati di Levitus (i dati di Domingues et al. non vanno oltre il 2003) è ancora positivo, ma con una incertezza (sia nel calcolo del trend sia sistematica) che rende impossibile affermare se ci sia stato un cambiamento significativo.

.

3. Ghiaccio nel mare Artico. Il Rapporto di Sintesi afferma:

Uno dei più impressionanti sviluppi avvenuti in seguito alla pubblicazione dell’ultimo report dell’IPCC è la rapida riduzione dell’area estiva del ghiaccio nel mare Artico. Nel 2007, l’area minima ricoperta è diminuita di circa 2 milioni di chilometri quadrati rispetto agli anni precedenti. Nel 2008, si è verificata una riduzione quasi altrettanto drammatica.

Questo declino sta chiaramente avvenendo più velocemente di quanto previsto dai modelli, come il grafico seguente mostra.

La dichiarazione di Pielke secondo cui questo “NON È VERO” è semplicemente basata sull’affermazione che “dal 2008 le anomalie sono realmente diminuite.”

Ebbene sì, è ancora la stessa cosa: il ragionamento di Pielke non è pertinente perché il Rapporto di Sintesi parla esplicitamente della estensione estiva minima del ghiaccio marino, raggiunta ogni settembre nel mare Artico, e noi non possiamo ancora sapere quale valore raggiungerà nel 2009. Inoltre, Pielke fa ancora riferimento ad un intervallo temporale (“dal 2008”!) che è troppo corto per avere qualcosa a che fare con i trend climatici.

Dobbiamo dunque concludere che non ci sono le basi per alcuna delle rozze affermazioni di Pielke contro di noi e, implicitamente, contro gli autori del Rapporto di Sintesi. La frase finale del suo post è, ironicamente, eloquente:

I media e i decisori politici che ciecamente accettano queste affermazioni o sono ingenui o stanno deliberatamente modificando i risultati scientifici per promuovere la loro particolare posizione difensiva.

Certamente.

.

Articolo originale su Realclimate.org

Traduzione di: Giulia Fiorese, Riccardo Reitano

Revisione di: Simone Casadei.

Pubblicato su Climalteranti il 17/07/2009.

–

24 – Un avvertimento da Copenhagen

A Marzo ha avuto luogo a Copenhagen la più grande conferenza sul clima dell’anno: 2500 partecipanti da 80 paesi, 1400 presentazioni scientifiche. La scorsa settimana, il Rapporto di Sintesi del Congresso di Copenhagen è stato consegnato al Primo Ministro danese Rasmussen a Bruxelles. La Danimarca ospiterà il round decisivo delle negoziazioni sul nuovo trattato di protezione del clima il prossimo dicembre.

A Marzo ha avuto luogo a Copenhagen la più grande conferenza sul clima dell’anno: 2500 partecipanti da 80 paesi, 1400 presentazioni scientifiche. La scorsa settimana, il Rapporto di Sintesi del Congresso di Copenhagen è stato consegnato al Primo Ministro danese Rasmussen a Bruxelles. La Danimarca ospiterà il round decisivo delle negoziazioni sul nuovo trattato di protezione del clima il prossimo dicembre.

Il congresso sul clima è stato organizzato da un’“Alleanza stellare” di università di ricerca: Copenhagen, Yale, Berkeley, Oxford, Cambridge, Tokyo, Pechino, per nominarne alcune. Il Rapporto di Sintesi è il più importante aggiornamento sulla scienza climatica dalla pubblicazione del rapporto IPCC 2007.