Temperature globali del 2012, ancora in zona medaglia

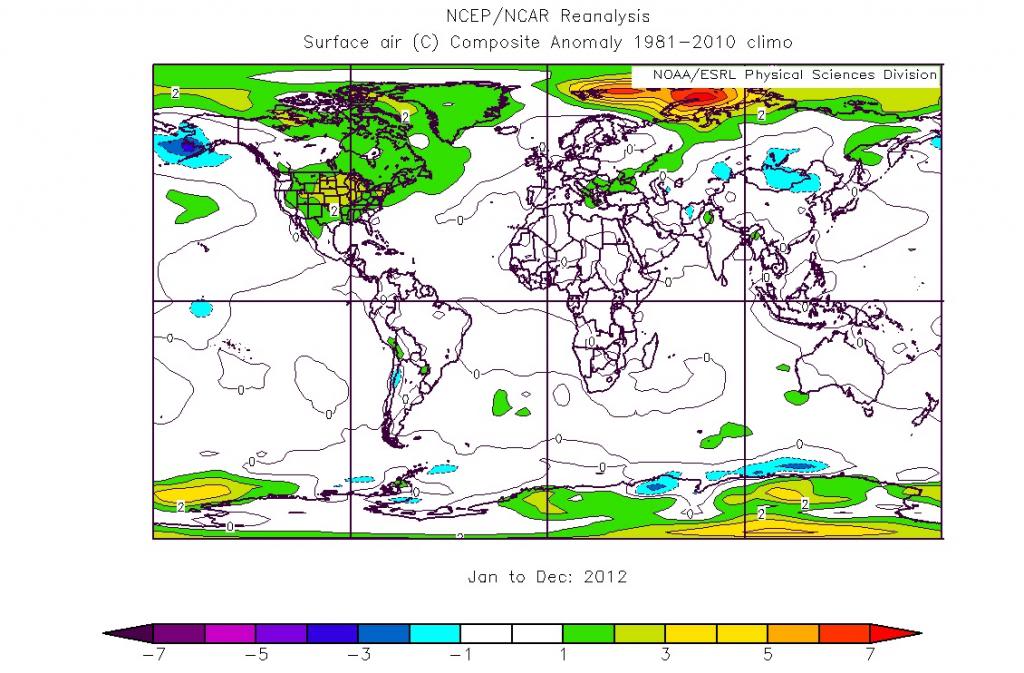

Il 2012 appena passato ci ha lasciato in eredità una ricca messe di situazioni meteorologiche interessanti ed estreme e il record della minore estensione mai vista di ghiacci marini artici....

Le metriche degli eventi estremi

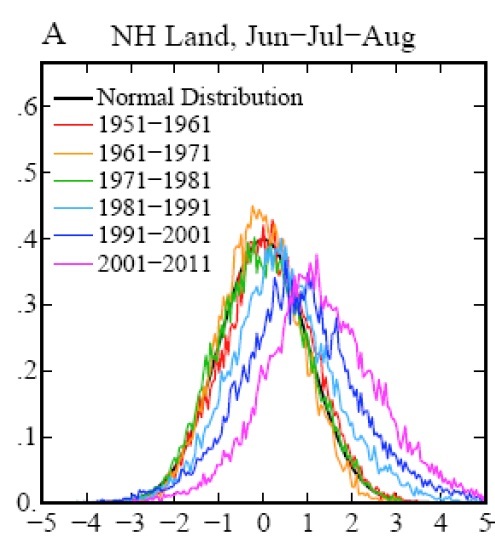

Si sono viste molte discussioni sull’articolo Hansen et al. (2012, PNAS) e l’editoriale di accompagnamento sul Washington Post nei primi giorni di agosto. Ma in questo post, cercherò di sostenere che la...

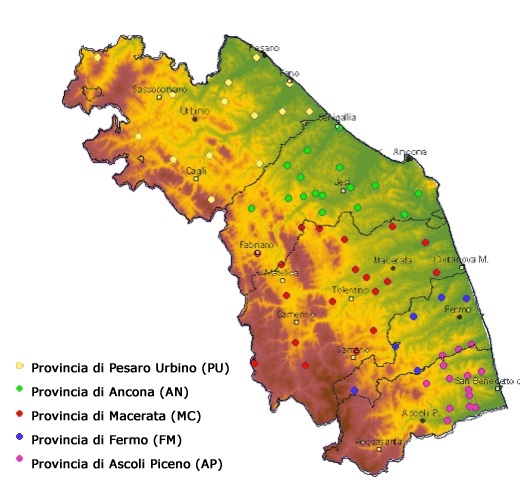

Anche nelle Marche il caldo dell’estate 2012 è stato da record

Ora che questa torrida estate (meteorologica, da giugno a agosto) è alle spalle e i dati rilevati dalle stazioni di rilevamento meteo dell’ASSAM sono completi e validati, possiamo permetterci...

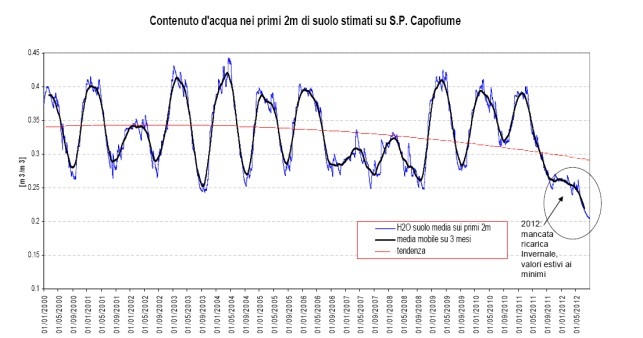

Dal suolo arido al grande caldo

I dati dell’estate 2012 mostrano come esista un intreccio fra la scarsità di precipitazione e il ripetersi di ondate di calore, ma anche una sorta di reazione a catena che...

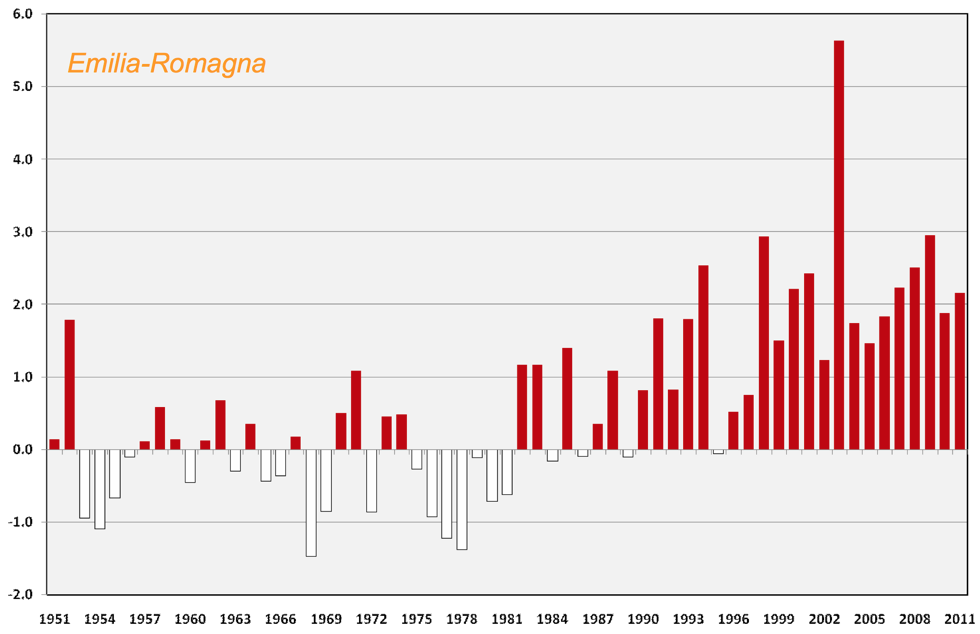

Un’altra estate rovente e siccitosa sull’Emilia-Romagna

Dopo l’estate del 2003, attribuita all’eccezionale persistenza di un promontorio anticiclonico sul Mediterraneo, siamo oggi di nuovo alle prese con condizioni simili e del tutto anomale rispetto al clima del...

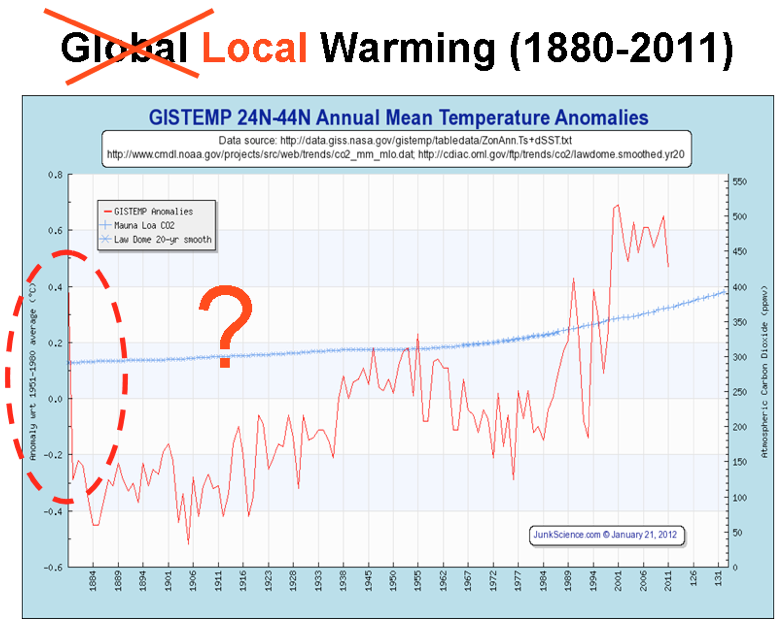

Quando il meteorologo sbaglia sul riscaldamento globale

Il 6 giugno 2012, nell’ambito del Convegno “Difesa del suolo-Irrigazione Territorio- Ambiente – Paesaggio” che ha avuto luogo nel Palazzo Lombardia di Milano, il meteorologo Mario Giuliacci ha trattato...

2015, nessun picco di riscaldamento previsto

Un articolo di Repubblica contiene in un box redazionale due errori di segno opposto sul futuro del clima del pianeta. Su Repubblica di venerdì 4 maggio 2012 è stato...

Caldo estremo

In un post su Realclimate, Stefan Rahmstorf e Dim Coumou mostrano perché il dibattito sugli estremi delle temperature è spesso viziato da domande mal poste. A proposito delle ondate...

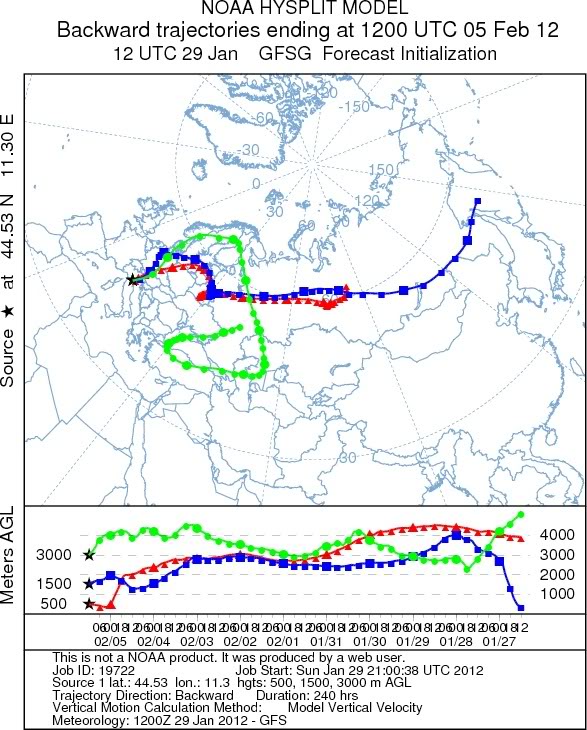

In inverno può fare molto freddo

Ancora un volta, è meglio ribadire che il freddo e la neve di questi e dei prossimi giorni non sono in alcun modo in contraddizione con il riscaldamento globale in...

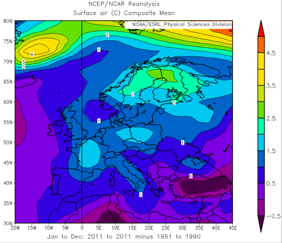

2011: un’altra conferma del caldo anomalo

Dopo il record del caldo sfiorato dal 2010, le prime statistiche mostrano che il 2011 ha fatto registrare “soltanto” una moderata anomalia positiva rispetto alle medie 1961-90. Ancora una volta,...