Riassunto

Riassunto

Si discute in questo post dell’utilità dei modelli di simulazione del clima. Pur con le incertezze che caratterizzano le simulazioni climatiche, alcuni risultati prodotti dai GCM hanno una chiara e dimostrabile solidità. Hanno quindi un “valore”, nel senso che potrebbero permettere, da subito, di proporre azioni di adattamento per mitigare alcuni degli impatti negativi del cambiamento climatico, almeno in quelle aree del pianeta dove i risultati delle simulazioni sembrano essere più certi.

L’intervista di Giuliano Ferrara a Franco Prodi e Fulco Pratesi recentemente trasmessa da Radio 24 offre lo spunto per qualche riflessione su alcuni dei temi affrontati, che vanno dalla affidabilità degli strumenti in uso per la modellazione del Clima sino al ruolo degli scienziati nel contesto del dibattito sui cambiamenti climatici. Userò in questo post le tesi espresse durante l’intervista solo come pretesto per approfondire la discussione, senza alcuna intenzione di alimentare polemiche che a mio avviso non servono molto per la crescita delle conoscenze. Il tema centrale è quello di capire come debbano essere gestite le incertezze proprie degli strumenti della modellistica del clima al fine di fornire delle simulazioni Utili e di “Valore” (nel seguito svilupperò tale concetto) e che permettano ai policy-makers di scegliere ottimali azioni di adattamento e di mitigazione agli impatti del cambiamento climatico.

In sostanza nell’intervista Franco Prodi afferma che i General Circulation Model (GCM) sono ancora indietro ed incapaci di rappresentare le complessità del sistema integrato Atmosfera, Biosfera, Idrosfera. E quindi le simulazioni climatiche che ne derivano sono incerte e insicure e quindi con questi strumenti è molto difficile prendere decisioni. Sto sicuramente schematizzando ma mi sembra che il succo del discorso sia più o meno questo.

Alcune contestazioni possono essere fatte a queste tesi. Innanzi tutto non rappresentano bene la realtà attuale dei GCM e sembrano essere anche un po’ datate, nel senso che non fanno giustizia del grande processo di miglioramento percorso nel campo della modellistica climatica in questi ultimi 15-20 anni (si guardi ad esempio ai risultati del progetto Ensembles finanziato dalla Unione Europea). In seconda battuta viene anche da chiedersi come ci si potrebbe muovere in questo settore senza utilizzare i GCM, pur con tutte le loro incertezze, nonché con tutti i sistemi di regionalizzazione del clima, siano essi di natura deterministica (i modelli regionali del clima, RCM, vedasi la home page del progetto UE-Prudence: http://prudence.dmi.dk/) piuttosto che dinamico-statistica (vedasi la homepage del progetto EU Stardex: http://www.cru.uea.ac.uk/cru/projects/stardex/).

Per di più, frenando l’uso della modellistica globale in quanto ancora “acerba” nel suo livello di descrizione delle complessità del sistema Atmosfera-idrosfera-biosfera, viene da chiedersi come si possa allo stesso tempo sperare di poter disporre in un qualche futuro di quell’ “earth model” a cui si fa riferimento nell’intervista, in grado di fornire quelle “certezze” che oggi non abbiamo. Sempre schematizzando, se comprendo bene le argomentazioni di FP, un modello del clima, per poter essere usato, dovrebbe essere sostanzialmente “perfetto”, nel senso che dovrebbe rappresentare “tutti” i processi fisici presenti in atmosfera, “tutti” i feedback, “tutte” le non linearità, “tutte” le scale di moto. Se così stanno i termini del problema, c’è qualche speranza di successo in questa pretesa di perfezione ?

Intanto la prima cosa da chiedersi è perché si usano i modelli e se si potrebbe farne a meno.

Per sviluppare il ragionamento devo fare una piccola digressione, tornando un attimo all’abc della fisica dell’atmosfera. Come noto, il sistema atmosfera non è un laboratorio galileiano in senso stretto, in quanto è impossibile soddisfare l’esigenza di ripetibilità di un esperimento all’interno di un laboratorio “per definizione” non riproducibile. E’ solo merito della modellistica se è possibile oggi, in senso più ampio, compiere degli “esperimenti”, in genere chiamati “esperimenti numerici” all’interno di un “laboratorio virtuale” che simula l’atmosfera reale. E’ oggi possibile, grazie ai modelli di atmosfera trascritti su codici di calcolo e mediante l’uso di supercomputer, usare l’atmosfera del modello al posto della realtà ed eseguire al suo interno studi di sensitivity, valutando scenari diversi al variare di qualche parametro: possiamo alzare o abbassare montagne, modificare tipi di suolo e crearne diversi scenari di umidità, proporre forcing esterni diversi (ad esempio di gas serra), mutare l’input radiativo da parte del sole. E’ possibile con i modelli ri-creare artificialmente quel “laboratorio” che ogni scienza che si rispetti deve avere per il solo stesso fatto di essere classificata come scienza. Va da se che essendo una riproduzione della realtà, il laboratorio “modello GCM” non è la realtà. E quindi contiene delle inevitabili approssimazioni e, talvolta, anche gravi inesattezze. La domanda che ci si pone relativa alla legittimità di un loro uso è quindi fondata e merita una risposta non frettolosa.

Per rispondere è utile fare un parallelismo con i modelli che permettono ai previsori meteo di fare le previsioni del tempo e che sono parenti stretti dei GCM che si usano per il clima, almeno per quanto riguarda la forma dell’apparato matematico che li caratterizza (set di equazioni differenziali che descrivono i processi di conservazione di energia, momento, acqua e che caratterizzano la meccanica e termodinamica dell’atmosfera e degli oceani). Anche in questo caso i modelli numerici di previsione sono inesatti (Numerical Weather Prediction models, NWP, per saperne di più, ottimo è il link alle lecture notes di ECMWF).

Sussistono dei problemi di sensibilità ai valori iniziali a causa della non linearità delle equazioni che caratterizzano modelli del genere. La loro parte “adiabatica” (che descrive ad esempio le avvezioni di temperatura o di quantità di moto) è in genere meglio descritta dai processi “fisici”, quali ad esempio quelli che descrivono il trasporto di calore verso o dal suolo, la microfisica delle nubi, i processi radiativi, i fenomeni convettivi ecc.. Il risultato di queste incertezze descrittive si traduce in errori di previsione: capita quindi che tali modelli facciano piovere troppo o troppo poco oppure presentino errori di localizzazione, nello spazio e nel tempo, dei massimi di pioggia o di altre idrometeore come la neve, così come di anomalie del campo termico o anemologico. Certi fallimenti di previsione siano più frequenti in concomitanza di certe tipologie di configurazioni “bariche”, mentre in altre gli errori sono inferiori. Così come pure la qualità delle previsioni dipende in buona parte anche dalle stagioni.

C’è allora da chiedersi: ma i modelli NWP rappresentano bene la realtà ?

La risposta è, ineluttabilmente: talvolta si, talvolta no. E, con tale consapevolezza, è bene usare questi strumenti per fare le previsioni meteo? La risposta può essere, a mio parere, solo positiva. Oggi nessun previsore meteo al mondo può fare a meno di usare questi strumenti se si pone l’obiettivo di cercare di prevedere il tempo in maniera “quantitativa” su un orizzonte temporale di 2-10 giorni. A tal riguardo c’è anche da chiedersi cosa ne sarebbe della Scienza della Previsione del tempo se all’inizio degli anni ’50 Fjörtoft, Charney e von Neumann (Numerical integration of the barotropic vorticity equation; 1950, Tellus, 2, 237-254) non avessero proposto di usare la loro semplificata modellistica meteorologica usando un modello barotropico dell’atmosfera, che è un lontano antenato dei modelli a equazioni primitive che si usano oggi. Magari, se così non fosse stato, oggi saremmo ancora qui a parlare di…“presagi” e non invece, ad esempio, di previsioni quantitative di occorrenza di piogge in una data area e in un dato istante temporale. (Il materiale sulla storia della previsione numerica è praticamente infinito, suggerisco questa presentazione di Adrian Simmons, scaricabile dal sito di ECMWF: http://www.ecmwf.int/publications/unpublished/2006/temperton/pdf/simmons.pdf)

In ogni caso, pur con tutte le incertezze del caso su cui ho detto poco fa, con questi modelli “incerti” si possono fare, almeno in media, decorose previsioni meteo, in grado di permettere ai decisori…di decidere. E’ infatti grazie a questi “incerti” modelli che si producono le allerte per il sistema di Protezione Civile, ad esempio. E sono le previsioni di questi modelli che forniscono l’input ai modelli idrologici per la previsione delle piene fluviali, oppure a quelli della qualità dell’aria oppure dello stato del mare. La possibilità di prendere decisioni corrette è particolarmente rilevante, a mio parere, in questo contesto.

Con il nuovo approccio del “valore economico” delle previsioni meteo o delle simulazioni climatiche (Katz e Murphy, 2000: “Economic Value of Weather and Climate Forecasts”, Climate Change, volume 45, 1573-1480) il “focus” non è più solo dato tanto alla “Qualità” di una previsione (o di una simulazione climatica) ma anche (e forse più) al suo “Valore” o “Utilità”, che si traduce nella capacità di quella previsione (o di quella simulazione climatica) di far prendere ad un policymaker decisioni più corrette di quanto potrebbe fare senza ricorrere a questi supporti modellistici. In questa ottica e a parità di qualità, una previsione può essere di più alto o basso valore a seconda dell’utente a cui è diretta. Per chiarire il punto, ogni policymaker che deve assumere delle decisioni applica sempre un ragionamento di tipo costo/beneficio nel quale confronta i costi di un’azione mitigatrice di un danno potenziale causato, ad esempio, da un evento meteo pericoloso, con il costo del danno che potrebbe avere se non decidesse di applicare alcuna azione mitigatrice a contrasto di quell’evento meteo pericoloso previsto. Pertanto, la probabilità di occorrenza di un evento meteo pericoloso si compone con il rapporto tra il “Costo” dell’azione mitigatrice e il “Danno” causato dalla non azione e permette di ottimizzare la scelta.

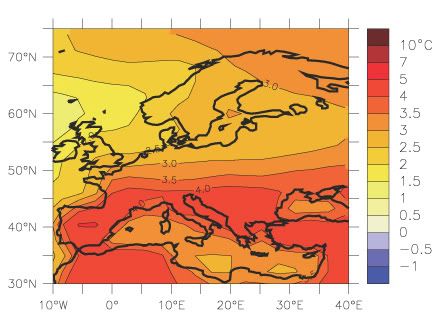

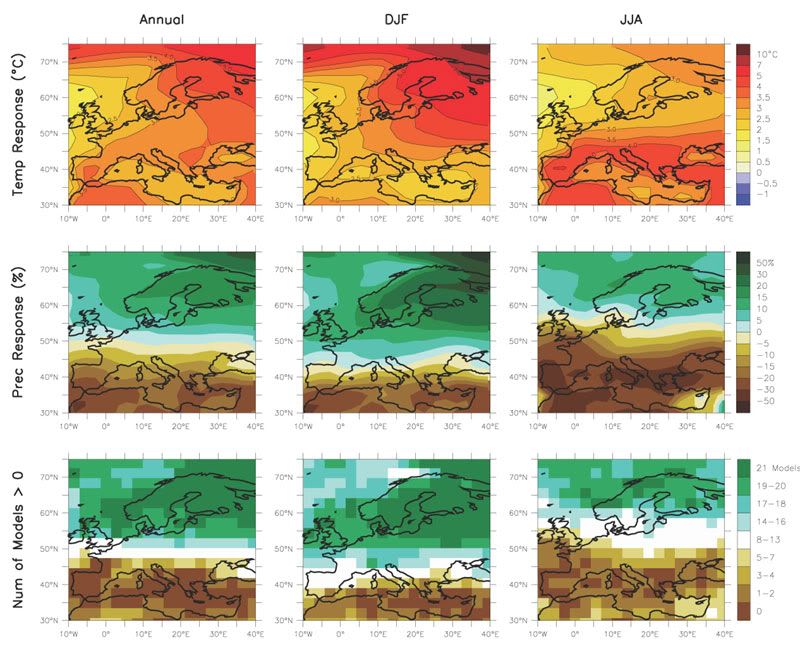

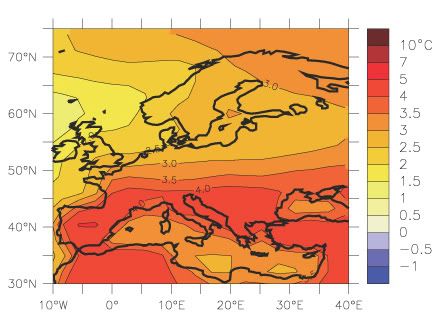

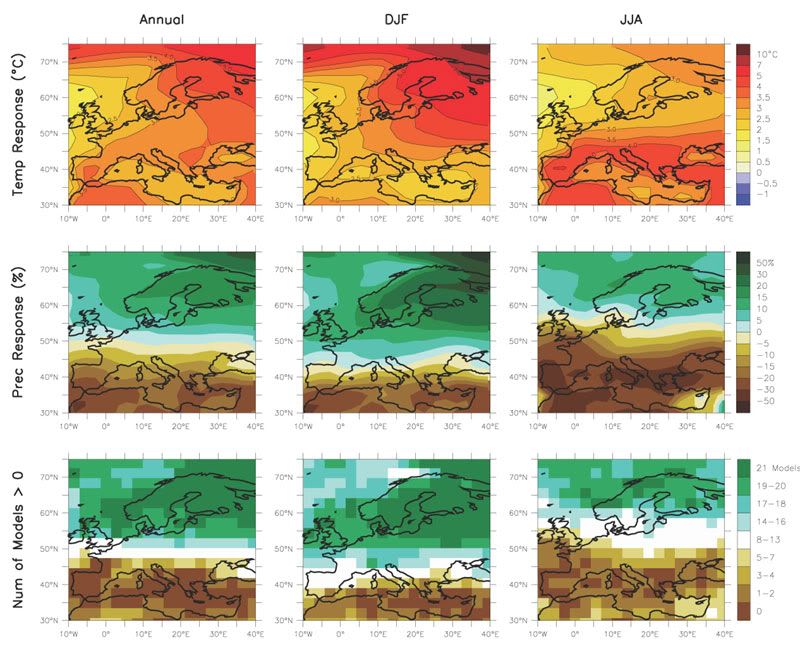

Tornando ai modelli GCM del clima, al giorno d’oggi sappiamo abbastanza quali siano i loro limiti, gli errori sistematici, dove si collocano arealmente. In sostanza conosciamo abbastanza bene i limiti di utilizzo di questi strumenti. E sappiamo anche che con tutte le diversità e le incertezze che caratterizzano questi strumenti, accade lo stesso che per certi indicatori del clima molti GCM offrano scenari concordi e possano offrire simulazioni di accettabile “Valore”, e possono essere quindi già in grado di far prendere decisioni corrette. Ad esempio tutti i GCM prevedono globalmente un aumento considerevole di temperatura, nei prossimi decenni. Dovremmo tenerne conto in qualche modo? Si potrebbe obiettare che quello che è forse vero a scala globale è meno vero a scala regionale. Questa asserzione è abbastanza vera; tuttavia accade che su certe sotto-aree del pianeta (per non fare un esempio che ci tocchi: il Mediterraneo) gli stessi sistemi di modellazione globale dicano lo stesso cose analoghe. Ad esempio risulta incontrovertibile che il bacino del Mediterraneo avrà in futuro delle estati più calde e, parallelamente, una diminuzione delle piogge (si veda la figura sottostante, tratta dal cap. 11 dell’IPCC-AR4-WG1.

(Fonte: Figura 11.5 IPCC AR4-WG1-cap.11, pag.875)

Cambiamenti di temperatura e precipitazione in Europa da simulazioni di 21 Modelli Globali con scenario A1B. Riga in alto, da sinistra a destra: cambiamenti della temperatura (°C) media annuale, in Inverno (DJF) ed Estate tra il 1980-1999 e il 2080-2099, mediata sui 21 modelli. Riga in mezzo: come la riga in alto ma per il rapporto tra le precipitazioni (%) del 2080-2099 e quelle del periodo 1980-1999. Riga in basso: numero di modelli (sul totale di 21) in cui si prevede un aumento di precipitazione.

E quindi, stante l’informazione di possibili estati più calde e meno piovose, non si potrebbe iniziare a fare qualcosa di più per diminuire il rischio desertificazione in aree del sud-Italia ? Oppure, non abbiamo già sufficienti conoscenze per iniziare a proporre politiche di miglioramento nell’uso delle risorse idriche che potrebbero calare in uno scenario del genere? Oppure ancora non potremmo accelerare quelle azioni di salvaguardia del territorio finalizzate a minimizzare il rischio di alluvioni sui piccoli bacini idrografici italiani, visto che potremmo avere in futuro, con “buona probabilità”, delle piogge di più breve durata e di più elevata intensità? Sicuramente siamo già in grado di quantificare il rapporto costo/perdita di possibili azioni di adattamento o mitigazione alternative; è allora necessario comporre questa conoscenza con le probabilità di occorrenza, ancorché incerte, degli scenari climatici, per avere uno spettro di azioni da adottare che siano le più efficaci e utili possibile.

Tornando all’altro aspetto connesso al ruolo dello scienziato che viene toccato nell’intervista, che non è disgiunto dalle argomentazioni fatte sino ad ora, anche qui è necessario un approfondimento. Nell’intervista si afferma che se per un politico l’uso del principio di prudenza può anche essere cosa saggia, per uno scienziato così non dovrebbe essere. Egli deve basare le sue tesi solo su fatti certi e non su supposizioni incerte. Sulla base di questa asserzione mi riesce difficile capire a pieno quale sia il ruolo di uno scienziato oggi. E ancora, nel contesto delle problematiche aperte dal problema dei cambiamenti climatici, è bene che uno scienziato non usi un principio di precauzione nei suggerimenti che fornisce ai politici? E’ divenuta veramente così neutrale la scienza? Più ragionevolmente, io penserei invece che un principio di precauzione si debba sempre usare e debba basarsi su una concreta analisi di quel rapporto costo/danno di cui ho parlato prima. E quindi, ritornando alla discussione sull’uso dei modelli, anche tenendo conto delle incertezze che i sistemi di previsione oggi hanno, risulta prudente affermare che, pur essendo plausibile che qualcosa potrebbe accadere al sistema climatico ma non avendo adesso delle certezze, è corretto non fare nulla per mitigare gli impatti del Climate Change?

Ma avremo mai delle certezze?

Credo sia fuori discussione che l’intera storia della scienza abbia ormai sentenziato che non esistono delle certezze, ma che nel tempo la conoscenza evolve ed è possibile solo proporre delle migliori approssimazioni della realtà. Con Newton e la sua teoria della gravitazione universale si pensava ci fosse la spiegazione “di tutto”, poi è venuto Einstein e la relatività generale ha rimesso in discussione non poche di quelle certezze. E lo stesso si potrebbe dire della rivoluzione della meccanica quantica rispetto alle conoscenze classiche che sino all’inizio del novecento hanno dominato il pensiero scientifico globale.

In conclusione, può oggi uno scienziato dissociarsi dall’obbligo di entrare nel vivo delle decisioni su un tema come il Climate Change? E come potrebbe decidere un policymaker cosa fare se lo scienziato su cui si appoggia non prende posizione perché logorato dalla mancanza di certezze?

Testo di Carlo Cacciamani

In questo post si narra di un’altra teoria del Prof. Zichichi priva di alcun fondamento scientifico, apparsa recentemente in prima pagina su un quotidiano nazionale pur essendo stata riciclata da un articolo di 4 anni prima. Chi non fosse al corrente dell’

In questo post si narra di un’altra teoria del Prof. Zichichi priva di alcun fondamento scientifico, apparsa recentemente in prima pagina su un quotidiano nazionale pur essendo stata riciclata da un articolo di 4 anni prima. Chi non fosse al corrente dell’ Riassunto

Riassunto

A volte capita di sentire qualcuno che sostiene la necessità di azioni urgenti contro i cambiamenti climatici, usando però argomenti poco fondati. È il caso del Principe Carlo d’Inghilterra, che nella sua recente visita in Italia ha tenuto un discorso di 30 minuti nella Sala della Lupa della Camera dei Deputati, in cui ha sostenuto in modo deciso la necessità della lotta ai cambiamenti climatici e di un futuro accordo nella prossima Conferenza sul clima di Copenaghen a dicembre.

A volte capita di sentire qualcuno che sostiene la necessità di azioni urgenti contro i cambiamenti climatici, usando però argomenti poco fondati. È il caso del Principe Carlo d’Inghilterra, che nella sua recente visita in Italia ha tenuto un discorso di 30 minuti nella Sala della Lupa della Camera dei Deputati, in cui ha sostenuto in modo deciso la necessità della lotta ai cambiamenti climatici e di un futuro accordo nella prossima Conferenza sul clima di Copenaghen a dicembre.

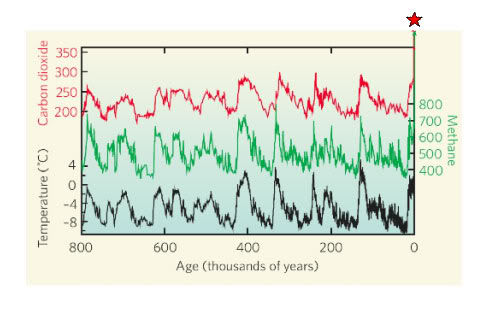

Per chi non vuole riconoscere il ruolo preponderante dei gas serra di origine antropica nell’influenzare le temperature del recente passato e del futuro, si presenta il problema di trovare candidati alternativi.

Per chi non vuole riconoscere il ruolo preponderante dei gas serra di origine antropica nell’influenzare le temperature del recente passato e del futuro, si presenta il problema di trovare candidati alternativi. Il libro è la traduzione di un saggio di rara chiarezza e sintesi “Phaeton’s Reins. The human hand in climate change “, pubblicato su Boston Review all’inizio del 2007 (disponibile anche sul web

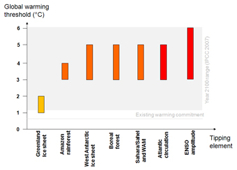

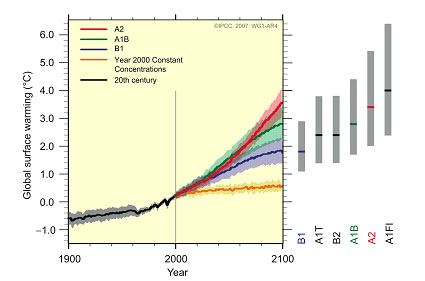

Il libro è la traduzione di un saggio di rara chiarezza e sintesi “Phaeton’s Reins. The human hand in climate change “, pubblicato su Boston Review all’inizio del 2007 (disponibile anche sul web  L’incertezza dovuta alla conoscenza del sistema clima è grande per ogni scenario, ma è molto inferiore (vedasi figura sopra): la forbice data dalla prima deviazione standard intorno alla media è circa un grado, l’intervallo più probabile (linee grigie sulla sinistra) varia da 2 gradi dello scenario B1ai 4 gradi dello scenario A2.

L’incertezza dovuta alla conoscenza del sistema clima è grande per ogni scenario, ma è molto inferiore (vedasi figura sopra): la forbice data dalla prima deviazione standard intorno alla media è circa un grado, l’intervallo più probabile (linee grigie sulla sinistra) varia da 2 gradi dello scenario B1ai 4 gradi dello scenario A2.