Le risposte degli scienziati – seconda parte: l’affidabilità dei modelli climatici

Pubblichiamo la seconda parte della traduzione del post di Climate Feedback con le risposte degli scienziati ad alcune affermazioni avvenute nell’audizione presso lo presso lo U.S. House Committee on Science, Space, and Technology, che si è tenuta lo scorso 29 marzo, sul tema Climate Science: Assumptions, Policy Implications, and the Scientific Method.

Le citazioni tratte dall’audizione sono indicate in corsivo fra parentesi quadre, e per ognuna è indicato l’autore. Seguono le risposte rilasciate da scienziati. L’elenco completo dei commenti è disponibile qui.

[…Dimostro che il consenso dei modelli è ben lontano da superare il test del confronto con il mondo reale.]

John Christy

Victor Venema, Scientist, University of Bonn, Germany:

Victor Venema, Scientist, University of Bonn, Germany:

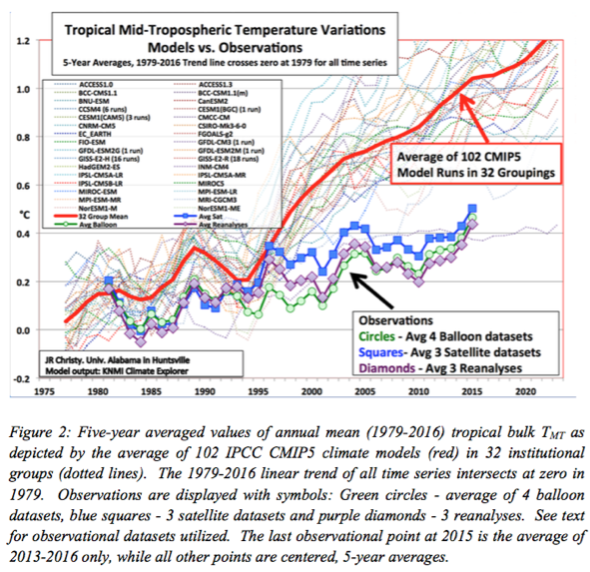

Da anni, Christy mostra questo grafico (riportato qui a fianco, ndr) sul suo blog e durante audizioni al Congresso. Se fosse un risultato valido, sarebbe scientificamente interessante. Tuttavia, in tutti questi anni Christy non ha mai pubblicato un articolo scientifico basato sulle sue affermazioni, e diversi scienziati hanno dovuto analizzare attentamente il grafico per capire come è stato generato.

Una cosa chiara è che, a causa della media sui 5 anni, il forte riscaldamento degli ultimi tre anni non compare. Inoltre, la media tra i dataset dei palloni sonda e quelli satellitari azzera le ampie incertezze delle osservazioni. Non è molto corretto allineare misurazioni e modelli scegliendo un solo anno particolarmente caldo; per ridurre l’influenza di queste scelte arbitrarie, gli scienziati di solito usano periodi più lunghi. Questo post di RealClimate discute parecchi di questi problemi, ma sfortunatamente Christy non ne ha tenuto conto e non ha corretto il grafico.

I modelli ci danno proiezioni sul riscaldamento di lungo periodo, e non sono stati sviluppati per fornire previsioni a breve termine. Queste ultime sono influenzate da fluttuazioni come, per esempio, El Niño. La tempistica del Niño non è prevedibile con più di un anno di anticipo, e questo vale ancora di più sia per le temperature della stratosfera, mostrate da Christy, che per quelle di superficie. Si ritiene che sul breve periodo il margine di incertezza dei modelli sia circa doppio dell’incertezza dei risultati dei modelli CMIP.

Gavin Schmidt, Director, NASA Goddard Institute for Space Studies:

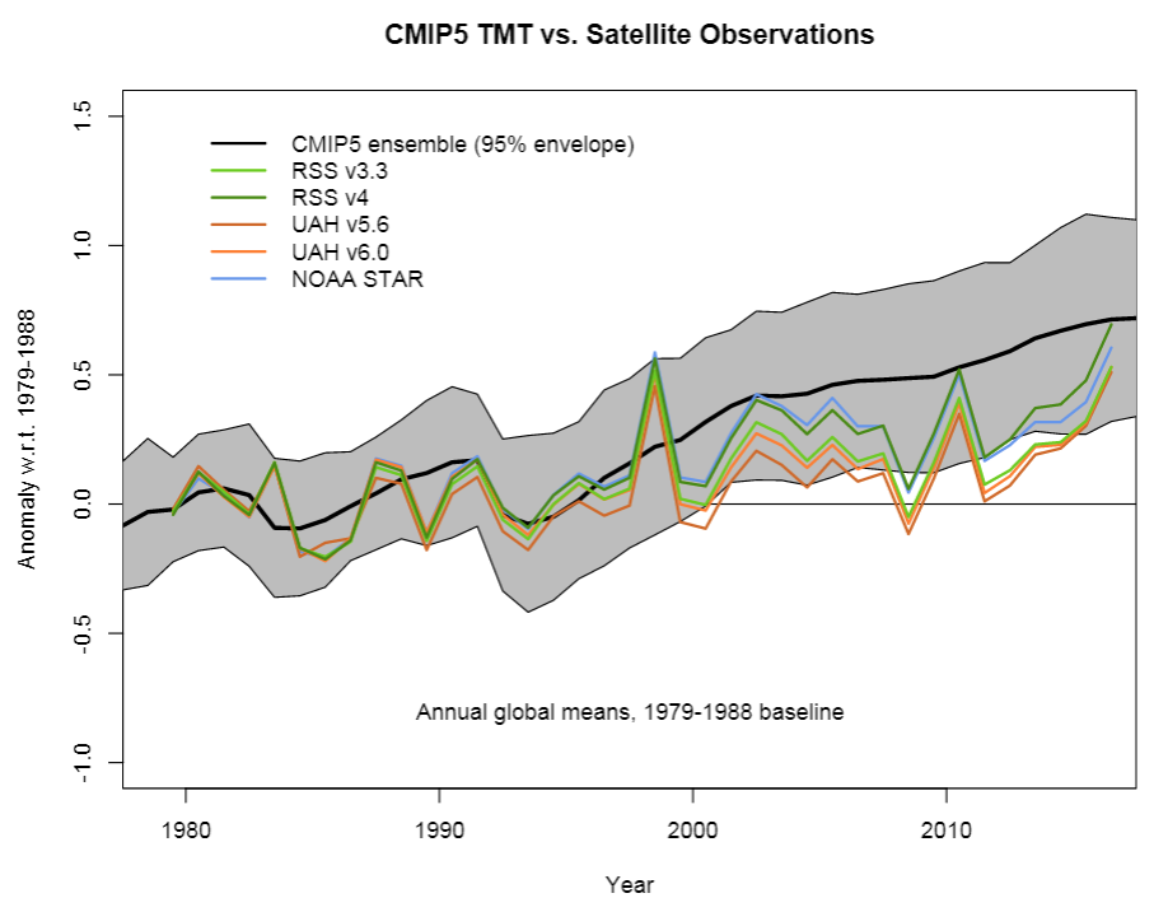

Come ho spiegato su RealClimate, nel suo grafico Christy fa diverse scelte minori e una rilevante che si combinano per esagerare la discrepanza tra i modelli e le osservazioni dei cambiamenti nella media troposfera. La cosa più importante è che Christy non mostra gli errori strutturali nelle osservazioni, e nemmeno li confronta con l’incertezza dei risultati dei modelli. Sono disponibili dei grafici migliori che non si basano su scelte parziali come quelle di Christy, ad esempio il seguente:

Questo non per dire che non ci siano discrepanze – ce ne sono, solo che non sono così plateali come vorrebbe Christy. La maggior parte dei trend dei modelli per questo valore è superiore a quanto registrato, ma come per qualsiasi altra discrepanza ci sono diverse cause potenziali da considerare.

1) Le osservazioni potrebbero essere sbagliate;

2) i modelli potrebbero essere sbagliati;

3) gli esperimenti potrebbero non essere stati realistici;

4) il confronto potrebbe essere imperfetto.

Anche se il caso 4 si è verificato in passato per molti confronti satelliti-modelli, non è più un problema così rilevante. Peraltro, il caso 1 rimane una reale possibilità – e le revisioni in corso su questi dataset portano spesso a scostamenti sistematici nei trend. Anche il caso 2 è possibile – ma postulare che la questione debba essere collegata alla sensitività climatica è ingenuo. Il caso 3 è un problema ben noto – le simulazioni del CIMP5 non hanno abbastanza vulcani, e non hanno previsto il calo dell’attività solare negli ultimi decenni (Schmidt et al, 2014*). Ignorare i casi 1 e 3 e considerare solo il 2 vuol dire non fare buona scienza. Va sottolineato anche che per altre metriche i modelli sono validi, o si spostano meno rapidamente di com’è stato osservato (il ghiaccio marino, l’espansione della Cella di Hadley…) – discutere soltanto di questioni con un bias che va in un senso specifico è, ancora una volta, un approccio molto parziale.

* Schmidt et al. (2014) Reconciling warming trends, Nature Geoscience

[I modelli climatici oggi disponibili non vanno bene per individuare le cause del riscaldamento recente o per prevedere cambiamenti climatici globali o regionali su scale dai decenni ai secoli con un grado di certezza elevato.]

Judith Curry

Reto Knutti, Professore, ETH Zürich:

Questa affermazione è in contrasto con tutti gli studi di “detection and attribution”, con tutti modelli e con i principi fisici alla base dei budget globali dell’energia. Nel periodo 1950-2000 il trend delle forzanti naturali è praticamente pari a zero e di conseguenza non può spiegare il riscaldamento osservato. La variabilità naturale è molto inferiore al riscaldamento osservato. In uno studio pubblicato di recente* abbiamo scritto che “anche se dovesse risultare che i modelli sottostimano la variabilità naturale di un fattore 3, è comunque estremamente improbabile che la variabilità interna da sola basti a produrre un trend così marcato come quello effettivamente osservato”. La forzante antropogenica è quindi il driver primario, e sappiamo anche perché: si tratta della fisica dell’effetto serra, che conosciamo da più di un secolo.

Dal punto di vista delle proiezioni, abbiamo una confidenza elevata per i trend di crescita su larga scala delle temperature, per l’acidificazione degli oceani e per l’innalzamento del livello dei mari per periodi pluridecennali. Va comunque sottolineato che anche le proiezioni sviluppate decenni fa con modelli molto più semplificati si sono rivelate considerevolmente precise.

In un post recente, io e Kevin Trenberth abbiamo discusso di una cosa che mi sta a cuore, e cioè se alla la nostra società convenga disporre di previsioni imperfette o farne a meno. Se davvero vogliamo seguire un percorso probabile, penso sia più intelligente avere una mappa imperfetta che non averne alcuna.

Huber e Knutti (2012) Anthropogenic and natural warming inferred from changes in Earth’s energy balance, Nature Geoscience

Stouffer, Manabe (2017) Assessing temperature pattern projections made in 1989, Nature Climate Change

Fischer and Knutti (2016) Observed heavy precipitation increase confirms theory and early models, Nature Climate Change

Allen et al. (2013) Test of a decadal climate forecast, Nature Geoscience

[A dirla tutta, sono uno dei coautori di un report in cui abbiamo usato un modello statistico per riprodurre, in larga misura, i trend delle temperature atmosferiche senza bisogno di gas serra. In altre parole, sembrerebbe che Madre Natura possa causare questi trend nelle temperature da sola, cosa che non dovrebbe comunque destare sorprese.]

John Christy

Timothy Osborn, Professore, University of East Anglia, e Director of Research, Climatic Research Unit:

I modelli statistici usati da Christy e dagli altri coautori sono sbagliati e quindi non supportano la sua affermazione secondo cui Madre Natura potrebbe causare da sola i trend di riscaldamento osservati. Suggeriscono che questi trend sarebbero causati dall’accumulo delle anomalie riconducibili all’ENSO o alla radiazione solare, ma non forniscono basi fisiche rigorose a supporto di questa tesi. Non tengono conto del fatto che un clima più caldo aumenterebbe l’emissione di energia radiativa nello spazio, e neppure che uno più freddo la farebbe diminuire. Questo fenomeno è necessario per spiegare perché il clima è rimasto all’interno di una forbice ristretta di temperature medie per gran parte della storia geologica del pianeta. Tuttavia Christy e i suoi coautori postulano che un incremento delle temperature (dovuto, per esempio, a El Niño) rimarrebbe anche dopo che El Niño si è dissipato finito, perché usano un indice ENSO cumulativo. Inoltre, una variabile cumulativa deve avere una baseline definita dal punto di vista fisico a partire dalla quale definire le anomalie, e anche questa manca. Altrimenti, la baseline può essere cambiata per produrre un trend al rialzo o al ribasso della variabile cumulativa completamente arbitrario, e sostenere, falsamente, che la variabile cumulativa può causare il “trend” climatico.

Traduzione di Diego Tavazzi, con il contributo di Sylvie Coyaud.

3 responses so far

mah, che dire.

visto che ridurre le emissioni GHG in modo significativo appare ogni giorno che passa più utopico (e insieme ad esse, alleggerire la sempre più insostenibile impronta della sovrappopolazione umana) lasciateci almeno un briciolino di speranza che i modelli siano almeno un po’ sbagliati, e che sovrastimino, almeno un pochino, la sensibilità climatica … pure se non tanto come vorrebbe il pio Christy.

homoereticus

speriamo che “che i modelli siano almeno un po’ sbagliati” ma anche che riusciremo a ridurre le emissioni in modo più significativo di come sembra oggi 😉

[…] di rilevamento delle temperature in giro per il mondo sono troppo poche e troppo inaffidabili, i modelli non sono abbastanza precisi, […]