RealClimate US tradotto in italiano

–

Climalteranti traduce e pubblica i post di RealClimate US di maggiore interesse per il dibattito italiano.

Chi volesse segnalare la propria disponibilità a collaborare alle traduzioni può inviare una mail a segreteria@climalteranti.it

–

INDICE:

50 – Emissioni nette zero / non zero

48 – Perché le proiezioni del futuro aumento del livello del mare sono ancora così incerte?

47 – Non scommettere sul clima contro il banco

46 – Piantare alberi può salvare il clima?

45 – Le ondate di calore sono causate dal cambiamento climatico?

44 – Ulteriori prove dell’indebolimento del sistema della corrente del golfo

43 – Riscaldamento globale: aumento significativo, pausa o altro?

42 – L’inevitabilità dell’innalzamento del livello del mare

41 – Il riscaldamento globale è arrivato anche in Antartide Occidentale

40 – Le metriche degli eventi estremi

39 – Tanto rumore per… il metano

38 – Riscaldamento globale e contenuto di calore degli oceani

37 – La fusione dei ghiacci in Groenlandia

36 – Un inverno freddo in un mondo che si sta scaldando?

35 – Buon 35° compleanno, riscaldamento globale!

34 – A conclusione del 4° Anno Polare Internazionale

33 – Aggiornamenti sull’accumulo di calore negli oceani

32 – Il metano artico in movimento?

31 – SEALEVELGATE

30 – L’IPCC non è infallibile (incredibile!)

29 – Aggiornamenti dei confronti tra i dati modellistici

28 – Hey Ya! (mal)

27 – Servizi climatici

26 – La soluzione delle dispute tecniche in ambito scientifico

25 – Altre leggerezze

24 – Un avvertimento da Copenhagen

23 – Sull’ Over-fitting

22 – ACRIM vs PMOD

21 – Gli effetti degli Aerosol e il clima, seconda parte: il ruolo della nucleazione e dei raggi cosmici

20 – La formazione degli Aerosol e il clima, prima parte

19 – Con tutto il dovuto rispetto

18 – Il tempo di risposta tra temperatura e CO2. (Gore l’ha azzeccato)

17 – Consiglio per un giovane blogger del clima

16 – Incendi e calore estremo nell’Australia sudorientale

15 – Irreversibile non significa inarrestabile

14 – Un aggiornamento dell’indice globale dei ghiacciai

13 – Il mare raggiungerà “I livelli dell’ultima era glaciale”

12 – Lo stato dell’Antartide: più caldo o più freddo?

11 – Le sintesi e la manipolazione della temperatura del 2008

10 – Buchi dell’ozono e raggi cosmici

8 – Attenzione alla differenza!

7 – Greenspan, Einstein e Reich

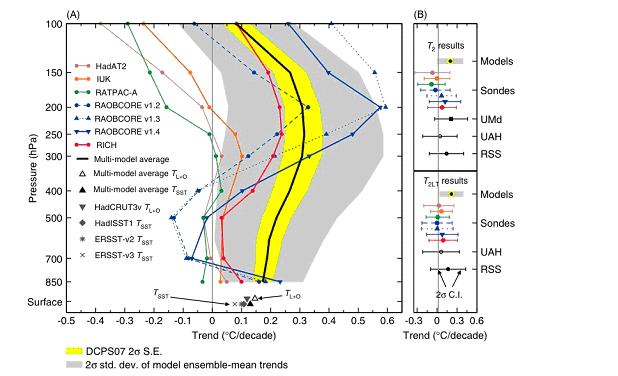

6 – Ancora i trends troposferici tropicali (ancora)

5 – Palin sul riscaldamento globale

4 – Quanto aumenterà il livello del mare?

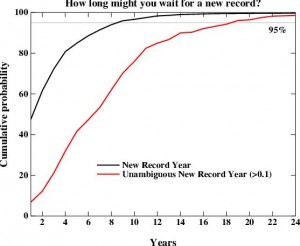

3 – La scommessa sul raffreddamento globale – II parte

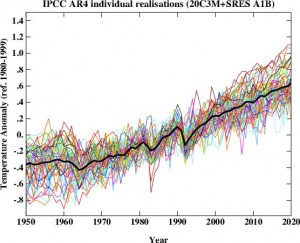

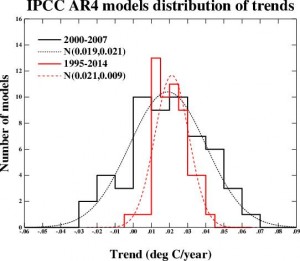

2 – Cosa dicono realmente i modelli dell‘IPCC

1 – Raffreddamento Globale – scommettiamo?

19 – Con tutto il dovuto rispetto

Alcuni anni fa c’era una bella commedia (la cui origine ci sfugge) che dava esempi di come gli inglesi userebbero la loro lingua mentre parlano con un forestiero per dire esattamente l’opposto di ciò che comunemente si intende. Questo permetteva agli inglesi di sentirsi superiori senza effettivamente danneggiare le relazioni internazionali. Un esempio era la frase “con il dovuto rispetto” che comunemente implica che chi parla ha un grande rispetto per la sua controparte, mentre in realtà chi la dice intende che non ha neppure il minimo rispetto per il suo interlocutore. Il dovuto rispetto è esattamente zero.

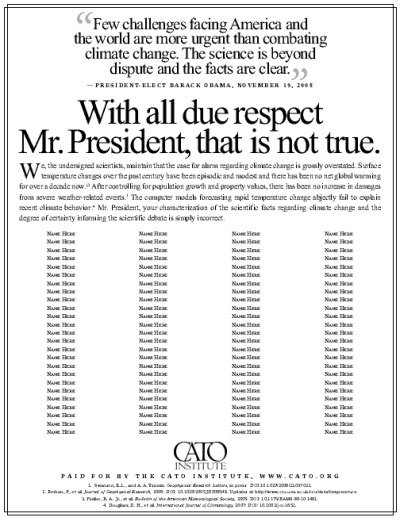

Questo pensiero ci è venuto in mente quando questa settimana alcuni di noi hanno aperto l’email per trovarci una bozza di pubblicità mandata dal Cato Institute (i.e. Pat Michaels) cercando dei sottoscrittori prima di essere pubblicata sui “maggiori quotidiani americani” al più presto:

Ci sono una serie di dettagli divertenti. Mentre siamo curiosi sulle credenziali di “Dr. N. Qui”, certamente comprendiamo perchè stiano cercando un pò più di assortimento nella lista. Più sorprendente (e alquanto ironicamente) la mailing list per le richieste di sottoscrizioni contiene un certo numero di scienziati che non concordano per nulla con queste opinioni. E’ come se Michaels e il Cato in realtà credessero che queste varie liste di scienziati “dissenzienti” derivino da accurate riflessioni finalizzate a supportare il loro ordine del giorno. Sembrano essere stati pilotati dalla loro stessa disinformazione.

Come esercizio per i nostri lettori, forse la gente vorrebbe speculare su chi finirà nella lista pubblicata? (Amesso che venga pubblicata). La Spice Girl Ginger sarà probabilmente fuori forma, ma potrebbero anche migliorare lo screening stavolta …

La cosa più divertente sono le note a piè di pagina che vengono utilizzate per sostenere le loro argomentazioni. Ce ne sono quattro: il nuovo Swanson e Tsonis (GRL, 2009), Brohan et al (JGR, 2006) (che è citato perché fornisce un collegamento con i dati delle temperature HadCRU), Pielke et al (BAMS, 2005), e lo spesso deriso Douglass et al. (IJoC, 2008).

In questi articoli, non si trovano le prove per supportare le frasi attribuite a loro nel testo principale. Vale a dire:

I cambiamenti della temperature di superficie nell’ultimo secolo sono stati episodici e modesti e ad oggi non c’è stato nessun riscaldamento globale netto da oltre un decennio.

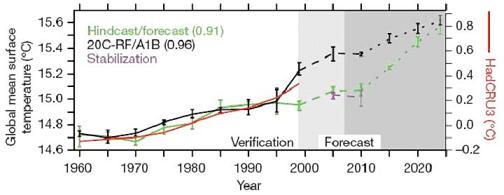

Bene, la prima parte della frase è esattamente quello che ci si aspetta, con un modesto trend di lungo periodo in presenza di variabilità interna e non è in contrapposizione con l’ultima parte della frase. Dire che “Il riscaldamento globale si è fermato” è particolarmente lacunoso dal momento che si basa su una finta ignoranza delle statistiche di breve periodo, e facendo attenzione alle serie di dati che si utilizzano. Inoltre richiede una scelta ad hoc dell’anno iniziale, essendo il periodo “esattamente un decennio” o 12 anni, quindi tutti i trend sono positivi.

L’uso del recente articolo di Swanson e Tsonis è semplicemente opportunismo. Quegli autori dicono specificatamente che i loro risultati non sono in nessun modo in contraddizione con l’idea di un trend di riscaldamento globale di lungo periodo. Al contrario, loro stanno cercando di caratterizzare la variabilità interna che tutti sanno che esiste.

Dopo aver controllato la crescita della popolazione e i valori immobiliari, non vi è stato nessun incremento nei danni dovuti a gravi fenomeni atmosferici

Questo riporta un breve commento nel BAMS che non presentava alcuna ricerca originale. Le ultime figure mostrano che i danni relativi al tempo atmosferico sono aumentati marcatamente, nonostante per la meteorologia ci sia una componente legata al cambiamento climatico difficile da evidenziare data la grande crescita di infrastrutture vulnerabili e la relativa carenza di dati. Il dato di fatto che non sia stato chiaramente dimostrato un netto trend relativo ai danni correlato con il riscaldamento globale non implica che si possa affermare definitivamente che non vi siano effetti correlati. Potrebbe essercene uno (o no), ma è difficile stabilire un’attribuzione formale. Comunque, qualsiasi attribuzione si concluda che ci sia, evidenziare che ci sono altri problemi nel mondo non implica che non valga la pena di preoccuparsi del cambiamento climatico antropogenico. Allo stesso modo, qualcuno potrebbe affermare che siccome gli infortuni al ginocchio sono aumentati sulle piste da sci nel tempo, non si dovrebbero curare i casi di influenza.

I modelli elaborati dai calcolatori, che prevedono un rapido cambiamento della temperatura, falliscono miseramente nel tentativo di spiegare il recente comportamento del clima..

Miseramente? Scelta di parole molto strana… e anche una strana scelta di riferimenti. Questo è di certo lo stesso articolo (Douglas et al.) che ha usato statistiche completamente incoerenti e ha deliberatamente fallito nell’evidenziare la strutturale incertezza nelle osservazioni. In modo non sorprendente Michaels non referenzia la demolizione piuttosto comprensibile della metodologia di Douglass pubblicata da Santer et al. (2008) (e della quale uno di noi è stato co-autore). Fondamentalmente, comunque, le temperature attuali sono ancora all’interno dell’intervallo di incertezza dei modelli anche se puoi scegliere ad hoc la tua data di partenza. Nessuno si aspetta che il mondo reale (una singola realizzazione) segua il trend medio forzato tutte le volte. Come si considera questo fatto, è un errore, una miseria o altrimenti?

E’ molto più interessante ciò che non è stato citato. L’affermazione del Presidente Obama “La scienza è oltre i dibattiti e i fatti sono chiari”, non può realisticamente riferirsi a ogni argomento nel mondo scientifico o ad ogni fatto potenziale. Invece egli probabilmente si riferisce ai fatti basilari e quasi del tutto incontestati che:

1) la CO2 e gli altri gas serra sono aumentati a causa dell’attività umana. Le emissioni di CO2 in particolare continuano a crescere con una velocità elevata;

2) l’effetto di questi gas serra è quello di scaldare il clima ed è molto probabile che la maggior parte del riscaldamento occorso negli ultimi 50 anni sia stato in effetti veicolata dalla loro crescita

3) la sensitività del clima è molto probabilmente ampia abbastanza da poter prevedere conseguenze gravi se le emissioni di carbonio continuano su questo passo.

Saremmo stupefatti se Michaels contestasse questo, dato che si sa che concorda sul fatto che la stima dell’intervallo di sensitività del clima dell’IPCC è probabile sia corretta e non ha mai dubitato sul contributo umano all’aumento della CO2 e degli altri gas serra. Lui e i suoi colleghi hanno persino condotto analisi che mostrano che, dopo aver corretto gli effetti di ENSO, non vi è assolutamente alcun segno di rallentamento del riscaldamento globale.

Invece questo è il classico diversivo: ignori i fatti che non contesti, ne selezioni altri che sono ambigui e insinui che, dato che sono soggetti ad un qualche dibattito, allora non ne conosciamo nulla. Presumibilmente, Michaels (e Cato) pensa che questo genere di non-senso sia politicamente utile e che possa essere corretto. Ma dovrebbe dichiararlo scientificamente difendibile, noi dovremmo rispondere:

“Con tutto il dovuto rispetto, Dr. Michaels, questo non è vero”

Articolo originale su Realclimate.org

Traduzione di: Federico Antognazza, Riccardo Reitano, Fabio Sferra

Revisione di: Simone Casadei

Pubblicato su Climalteranti il: 1/4/2009

18 – Il tempo di risposta tra temperatura e CO2 (Gore l’ha a

zzeccato)

Quando tengo delle conferenze sui cambiamenti climatici, la domanda che mi fanno più frequentemente è questa: “Il rapporto tra le emissioni di CO2 e la temperatura che risultano dai carotaggi glaciali [antartici] non mostra che sono le [variazioni di] temperatura a guidare quelle di CO2, e non viceversa?”.

Alla luce di tutto ciò, suona come una domanda ragionevole. Del resto, non si tratta di una sorpresa, perché questa è una delle più popolari affermazioni fatte dai negazionisti del riscaldamento globale. Inoltre, ha avuto un’alta risonanza circa due settimane fa, quando è stata fatta dal deputato Joe Barton nel suo tentativo di tentare di screditare la testimonianza al Congresso di Al Gore. Barton ha detto:

Nel suo film, mostra un andamento di temperatura e lo paragona ai livelli delle emissioni di CO2 nel corso di un periodo di 600.000 anni, come essi sono ricostruiti dai carotaggi glaciali. Lei afferma che questa è una prova del legame tra l’aumento delle emissioni di CO2 ed il riscaldamento globale. Tuttavia, un esame più attento di questi fatti rivela qualcosa di completamente diverso. Ho un articolo tratto dalla rivista Science, che mostrerò al momento opportuno, che spiega che, storicamente, un aumento delle concentrazioni di CO2 non è preceduto da un aumento delle temperature, ma in realtà lo segue con un ritardo da 200 a 1000 anni. I livelli di CO2 sono aumentati dopo che la temperatura è aumentata. La temperatura sembra guidare le emissioni di CO2, e non viceversa. Su questo punto, Signor Vice Presidente, lei non si sbaglia di poco. Sbaglia totalmente.

Naturalmente, coloro che sono stati attenti riconosceranno che Gore non ha sbagliato completamente. Infatti, questo tema è stato affrontato molto bene in molti posti. Infatti, Jeff Severinghaus ha affrontato questo argomento in uno dei nostri primi post di RealClimate già nel lontano 2004. La questione continua a tornare a galla, e Jeff ha recentemente ricevuto una lettera di richiesta al riguardo. La sua risposta allo scrittore della lettera è riprodotta integralmente alla fine di questo post. Qui di seguito c’è il mio pensiero sull’argomento.

Prima di tutto, dire “storicamente” è fuorviante, perché Barton sta in realtà parlando di cambiamenti di CO2 su tempi scala molto lunghi (glaciale-interglaciale). Su tempi scala storici, le emissioni di CO2 hanno sicuramente guidato, e non seguito, le temperature. Ma in ogni caso, non importa per quanto riguarda questo problema (il riscaldamento globale). Noi sappiamo perché le emissioni di CO2 stanno aumentando adesso, e le conseguenze dirette a livello di radiazione delle emissioni di CO2 sul clima sono note da più di 100 anni. In assenza di interventi umani, i livelli di CO2 aumentano e diminuiscono nel corso del tempo, a causa degli scambi di carbonio tra biosfera, atmosfera e oceani e, su tempi molto più lunghi, litosfera (vale a dire le rocce, le riserve di petrolio, carbone, le rocce di carbonato). I tassi di tali scambi sono ora completamente sopraffatti dalla velocità con cui stiamo estraendo carbonio da quest’ultima serie di serbatoi e convertendolo in CO2 atmosferica. Nessuna scoperta fatta con le carote di ghiaccio cambia questi fatti di base.

In secondo luogo, l’idea che ci potrebbe essere un ritardo delle concentrazioni di CO2 nei confronti dei cambiamenti di temperatura (durante i cambiamenti climatici glaciale-interglaciale), non è di certo una novità per la comunità scientifica del clima. Infatti, Claude Lorius, Jim Hansen e altri hanno essenzialmente previsto questo risultato già 17 anni fa, in un articolo di riferimento che ha affrontato la causa delle variazioni di temperatura osservate nelle registrazioni delle carote glaciali antartiche, ben prima che i dati mostrassero che le emissioni di CO2 potrebbero seguire in ritardo le temperature. In tale lavoro (Lorius et al., 1990), essi dicono che:

i cambiamenti nelle concentrazioni di CO2 e CH4 hanno svolto un ruolo significativo nelle variazioni glaciale-interglaciale del clima amplificando, insieme con la crescita e il decadimento delle coltri glaciali dell’emisfero settentrionale, la relativamente debole forzante orbitale

Quello di cui si parla qui è l’influenza del cambiamento della forzante radiativa stagionale dovuto all’oscillazione della Terra intorno al sole (la ben nota teoria di Milankovitch delle ere glaciali), combinato con il feedback positivo dell’albedo delle coltri glaciali (meno ghiaccio = meno riflessione della luce solare = temperature maggiori) e le concentrazioni dei gas a effetto serra (temperature più elevate = più CO2 = temperature maggiori). Pertanto, sia le emissioni di CO2 sia il volume dei ghiacci dovrebbero apparire un po’ in ritardo rispetto alle temperature, a seconda dei tempi di risposta caratteristici di queste diverse componenti del sistema climatico. Il volume dei ghiacci dovrebbe essere in ritardo rispetto alle temperature di circa 10000 anni, a causa del periodo di tempo relativamente lungo necessario per aumentare o ridurre le coltri glaciali. Ci si aspetta che le emissioni di CO2 siano in ritardo sulle temperature di circa 1000 anni, che è il tempo di scala atteso dalle variazioni nella circolazione oceanica e la forza della “pompa del carbonio” (cioè fotosintesi biologiche marine) che trasferisce il carbonio dall’atmosfera all’oceano profondo.

Diversi lavori recenti hanno infatti dimostrato che vi è ritardo di CO2 sulla temperatura. Non sappiamo realmente l’entità di tale ritardo, anche se Barton suppone di sì, perché è molto difficile porre le documentazioni delle emissioni di CO2 da carote glaciali allo stesso tempo di quelli di temperatura dalle stesse carote di ghiaccio, a causa del ritardo temporale nell’intrappolamento dell’atmosfera da quando la neve è compressa in ghiaccio (il ghiaccio, in qualsiasi momento, sarà sempre di età superiore alle bolle di gas che racchiude, e la differenza di età è di per sé incerta). Al momento, i migliori calcoli pubblicati mostrano valori simili a quelli citati da Barton (presumibilmente, presi da questo lavoro di Monnin et al. (2001), o da questo di Caillon et al. (2003)). Ma il calcolo può essere fatto bene solo quando la variazione di temperatura è molto elevata, in particolare nelle terminazioni glaciali (il graduale passaggio dal clima freddo glaciale al clima caldo interglaciale). Cosa importante, ci vogliono più di 5000 anni perché questo cambiamento si verifichi, e questo ritardo ne costituisce solo una piccola frazione (anzi, un lavoro recentemente presentato di cui sono a conoscenza suggerisce che il ritardo è addirittura minore di 200 anni). Quindi non è capitato che l’aumento della temperatura è terminato quando le emissioni di CO2 sono iniziate a salire. Piuttosto, vanno molto di pari passo, con la temperatura che continua a salire al crescere delle emissioni di CO2. In altre parole, le emissioni di CO2 si comportano come un amplificatore, come suggerito da Lorius, Hansen e colleghi.

Ora, se c’è una piccola critica che si potrebbe fare a Gore, è quella per come tratta questo tema nel film (come abbiamo già sottolineato nella nostra recensione). Come si può vedere, però, correggere questo punto effettivamente rafforza ulteriormente le affermazioni di Gore, invece di indebolirle. Ecco perché:

La registrazione delle temperature indicata nella carota glaciale non si riferisce al globo terrestre, ma si tratta di un archivio delle variazioni di temperatura locale in Antartide. Il resto del mondo in effetti segue da vicino le variazioni polari, ma le variazioni di temperatura media globale sono inferiori. Anche se non sappiamo esattamente il motivo per cui le variazioni delle emissioni di CO2 si verifichino a lungo termine (i meccanismi sono ben noti, i dettagli no), si sa che per comprendere l’entità delle variazioni della temperatura globale è necessario tener conto delle emissioni di CO2. Questo è un punto critico. Non siamo in grado di spiegare le osservazioni di temperatura senza considerare le emissioni di CO2. Tuttavia, le emissioni di CO2 da sole non spiegano tutte le variazioni, e la relazione tra temperature e CO2 non è quindi in alcun modo lineare. Cioè, ad un determinato quantitativo di incremento delle concentrazioni di CO2 come quello misurato nelle carote glaciali non deve necessariamente corrispondere una certa quantità di aumento della temperatura. Gore mostra la forte correlazione tra temperature e CO2 nei dati dalle carote di ghiaccio, e poi illustra il livello attuale di CO2 (384 ppm), lasciando all’occhio dello spettatore l’estrapolazione della curva di temperatura verso l’alto, in parallelo con l’aumento della CO2. Gore in realtà non fa l’errore di disegnare la curva della temperatura, ma la conseguenza è ovvia: le temperature saliranno molto. Ma, come illustrato nella figura qui sotto, la semplice estrapolazione di questa correlazione nel futuro pone la temperatura antartica a livelli alti, intorno a 10 °C più di oggi, nel prossimo futuro e non al termine ultimo del secolo come nella stragrande maggioranza delle proiezioni (come abbiamo discusso qui).

La temperatura media globale era inferiore durante i periodi glaciali per due motivi principali:

1) c’erano solo circa 190 ppm di CO2 in atmosfera, ed altri importanti gas ad effetto serra (CH4 e N2O) avevano concentrazioni anche inferiori;

2) la superficie della terra era più riflettente, a causa della presenza di molto ghiaccio e neve sul terreno, e molto più ghiaccio marino rispetto a oggi (cioé l’albedo era più elevata). Come discusso molto bene da Jim Hansen, nel suo recente articolo su Scientific American, la seconda di queste due influenze è la maggiore, rappresentando circa i 2/3 del totale della forzante radiativa, mentre CO2 e gli altri gas a effetto serra spiegano il rimanente 1/3. Anche in questo caso, ciò era già noto nel 1990, al momento dell’articolo di Lorius et al. precedentemente citato.

Quello che avrebbe dovuto fare Gore è estrapolare la curva di temperatura con un opportuno ridimensionamento di scala – tenendo conto che la CO2 rappresenta circa 1/3 della variazione totale – invece di lasciarlo fare ad occhio dal pubblico. Se avesse fatto così, avrebbe trasmesso l’informazione che solo 1/3 della variazione di temperatura è dovuta alla semplice correlazione con i valori di CO2 mostrati dalle carote glaciali. Questo avrebbe dato l’impressione che il punto di equilibrio per il riscaldamento dell’Antartide dovuto al raddoppio delle concentrazioni di CO2 dovrebbe superate le temperature attuali di circa 3 °C, in ottimo accordo con quanto è previsto da parte dello stato dell’arte dei modelli climatici (si noti che gli stessi modelli prevedono un significativo ritardo nel raggiungimento dell’equilibrio a causa della grande capacità termica del mare dell’emisfero meridionale, cosa che è in ottimo accordo con i dati, che mostrano un riscaldamento dell’Antartide molto più modesto negli ultimi 100 anni). Quindi, se si scalano le variazioni di temperatura in Antartide con quelle della temperatura globale, allora la sensitività del clima globale al raddoppio delle concentrazioni di CO2 diventa 2-3 °C, perfettamente in linea con la sensitività climatica dell’IPCC (nota dai calcoli di Arrhenius più di 100 anni fa).

In sintesi, i dati fondamentali delle carote glaciali non sono in alcun modo in contraddizione con la nostra comprensione della relazione tra le concentrazioni di CO2 ed i valori di temperatura, e non vi è nulla di fondamentalmente sbagliato in ciò che dice Gore nel film. Inoltre, Gore avrebbe potuto usare i dati delle carote glaciali per sottolineare e dare più forza ad un ulteriore punto: che questi dati forniscono un buon test indipendente della sensitività climatica, che dà un risultato in eccellente accordo con i risultati dei modelli.

Un ultimo punto: nelle critiche a Gore, Barton sottolinea anche che la CO2 è stata talvolta molto più elevata di quanto lo sia attualmente. Questo è vero: CO2 può aver raggiunto livelli di 1000 parti per milione (ppm) – forse anche molto più elevati – in un lontano passato geologico (ad esempio, nell’Eocene, circa 55 milioni di anni fa). Quello che Barton si è dimenticato di dire è che la Terra era molto, molto più calda in quell’epoca. In ogni caso, è più rilevante che la CO2 non ha mai superato circa 290 ppm nel corso degli ultimi 650.000 anni (almeno), fino all’aumento più recente, inequivocabilmente dovuto alle attività umane.

Eric Steig

Qui di seguito c’è la lettera scritta a Jeff Severinghaus, e la sua risposta:

Caro Jeff,

ho letto il tuo articolo “Che cosa ci racconta il ritardo della CO2 rispetto alle temperature nelle carote di ghiaccio sul riscaldamento globale?” Tu dici che la CO2 non avvia il riscaldamento, ma può amplificare i riscaldamenti già in corso. L’ovvia domanda che viene in mente è se i livelli di CO2 sono in ritardo, o no, anche nei periodi in cui inizia il raffreddamento dopo un ciclo di riscaldamento … anche in uno di 5000 anni?

Se i livelli di CO2 sul pianeta Terra sono in ritardo anche nei periodi di raffreddamento, allora come possono essere, i livelli di CO2, connessi in modo causale ai periodi di riscaldamento terrestre? Non sono sicuro di come le registrazioni delle carote di ghiaccio siano legate ai tempi di risposta di CO2 durante i periodi di raffreddamento. Se ci fosse un ritardo dei livelli di CO2 anche dopo l’inizio di un periodo di raffreddamento, quindi sembrerebbe che i livelli di CO2 non solo non avvierebbero i periodi di riscaldamento, ma sarebbero anche scorrelati con la comparsa dei periodi di raffreddamento. Sembrerebbe quindi che i livelli attuali di CO2 siano piuttosto impotenti come amplificatore in ogni caso… riscaldamento o raffreddamento. Stiamo parlando del pianeta Terra, dopo tutto, e non di Venere, su cui la pressione atmosferica è molte volte superiore a quella della Terra.

Se ci fosse un intervallo di tempo anche dopo l’inizio del raffreddamento, allora sembrerebbe che alcuni meccanismi aggiuntivi guidano attualmente le variazioni di temperatura. Quindi qual è la differenza temporale tra i livelli di CO2 all’inizio di un periodo di raffreddamento al termine di un periodo di riscaldamento e la storia temporale delle variazioni di temperatura nelle carote di ghiaccio?

Caro John,

I raffreddamenti sembrano essere causati principalmente ed inizialmente dall’aumento della distanza Terra-Sole durante l’estate boreale, a causa dei cambiamenti dell’orbita terrestre. Poiché l’orbita non è circolare, ma ellittica, la radiazione solare è inferiore in alcuni momenti dell’anno, rispetto ad altri. Questa è la cosiddetta ipotesi di Milankovitch [veramente si dovrebbe dire “teoria” – Eric], di cui forse hai sentito parlare. Proprio come durante i riscaldamenti, CO2 è in ritardo durante i raffreddamenti di un migliaio di anni, in alcuni casi anche di tremila anni.

Non commettiamo però l’errore di credere che questi riscaldamenti e raffreddamenti debbano avere una sola causa. È ben noto che vi sono coinvolti una molteplicità di fattori, tra cui il cambiamento dell’albedo planetaria, variazioni nella concentrazione di ossido di azoto, in quella di metano, ed in quella di CO2. So che sarebbe intellettualmente soddisfacente il fatto di identificare una singola causa per alcuni fenomeni osservati, ma purtroppo questo non è il modo in cui la natura funziona nella maggior parte dei casi.

Né vi è alcun obbligo per cui una sola causa operi nell’intero periodo di tempo del riscaldamento, lungo 5000 anni, ed in quello di raffreddamento, lungo 70000 anni.

Pertanto, non è logico sostenere che, poiché CO2 non provoca riscaldamento o raffreddamento nei primi mille anni o giù di lì, allora non può aver causato riscaldamento neanche nelle molte migliaia di anni del periodo compreso tra i due.

Pensa alle malattie del cuore – uno potrebbe essere tentato di sostenere che una determinata condizione cardiaca del paziente è stata causata esclusivamente dal fatto che ha mangiato patatine fritte a pranzo ogni giorno per 30 anni. Ma in realtà il periodo di 10 anni di mancato esercizio fisico a causa del lavoro sedentario, nel mezzo di questo intervallo di tempo, potrebbe aver avuto un peso decisivo. Solo perché uno stile di vita sedentario non ha causato l’inizio né la fine della formazione delle placche, tu escluderesti che la vita sedentaria possa avere un ruolo di contributo causale?

C’è una ricca letteratura su questo argomento. Se sei veramente interessato, ti esorto a leggerla.

Il contributo di CO2 ai raffreddamenti e riscaldamenti glaciale-interglaciale ammonta a circa un terzo dell’ampiezza completa, o circa la metà se si includono il metano e l’ossido di azoto.

Pertanto non si può asserire che i gas a effetto serra siano la principale causa delle ere glaciali. Nessuno scienziato credibile ha mai sostenuto questa posizione (anche se nel film di Al Gore era abbastanza implicita). Il contributo guida fondamentale è stato studiato a lungo, e continua ad esserlo, ed è la modifica da parte delle variazioni orbitali della distribuzione dell’irraggiamento solare sulla superficie terrestre, come si è modificata da variazioni orbitali. Questa ipotesi è stata proposta da James Croll nel 19° secolo, raffinata matematicamente da Milankovitch nel 1940, e continua a superare numerosi test critici ancora oggi.

I gas a effetto serra sono considerati più come un feedback biogeochimico, avviato dalle variazioni orbitali, e poi di nuovo retro-alimentato ad amplificare il riscaldamento una volta che è già in corso. Peraltro, il ritardo di CO2 di circa 1000 anni corrisponde abbastanza strettamente al tempo atteso necessario a far “sfiatare” l’eccesso di CO2 derivante dalla respirazione fuori dalle profondità oceaniche attraverso le correnti oceaniche naturali. Così lo sfasamento è abbastanza vicino a quello che ci si aspetterebbe, se CO2 agisse come un feedback.

Il tempo di risposta di metano ed ossido di azoto alle variazioni climatiche si misura in decenni. Quindi questi feedback operano molto più rapidamente.

Il contributo quantitativo di CO2 ai raffreddamenti e riscaldamenti delle ere glaciali è pienamente coerente con l’attuale comprensione delle proprietà di riscaldamento della CO2, come è evidente nelle proiezioni dell’IPCC sul futuro riscaldamento di 3±1,5 °C in seguito ad un raddoppio della concentrazione di CO2. Quindi non vi è alcuna incoerenza tra [la teoria di] Milankovitch e l’attuale riscaldamento globale.

Spero che questo [discorso] sia illuminante.

Jeff

Articolo originale su Realclimate.org

Traduzione di: Claudio Cassardo

Pubblicato su Climalteranti il: 25/3/2009

17 – Consiglio per un giovane blogger del clima

Congratulazioni! Hai appena compiuto il primo passo nel tentativo di comunicare le tue competenze e i tuoi pensieri al mondo esterno, che viene superficialmente servito dalle sue fonti tradizionali di informazione quando si tratta di questioni complesse e rilevanti socialmente, come i cambiamenti climatici. Il tuo obiettivo di chiarificare la scienza (o le opzioni politiche, le considerazioni etiche o semplicemente esporre i tuoi punti di vista) è uno sforzo nobile e ti auguriamo buona fortuna e un ampio numero di lettori. Tuttavia sii conscio che stai infilando il tuo blog in acque a volte insidiose. Le cose peggiori possono accadere ai migliori blogger. Quindi, in uno spirito di blog-cameratismo, e in luce della nostra esperienza e osservazione, ti offriamo qualche consiglio che potrebbe aiutarti a navigare nel clima politico relativamente indenni.

Sii onesto con te stesso e con i tuoi lettori. Se il tuo obiettivo è di educare, dillo. Se di spingere per maggiori fondi per i tuoi progetti, o sostenere una determinata politica, sii diretto su questo. Non essere in ogni caso sorpreso se le persone spendono il loro tempo cercando secondi fini in quello che fai. Esiste una scuola di pensiero per la quale ogni discorso pubblico dev’essere diretto verso l’azione pubblica e un apporto puro di informazioni è una cosa che non esiste. Comunque, questo viene spesso interpretato nel senso che tutti i discorsi pubblici debbano essere pro o contro una specifica proposta, e questo non ha senso. Si può criticare l’uso improprio della scienza del clima da parte di George Will o di Alexander Cockburn senza essere d’accordo o meno, o addirittura senza aver neanche letto le loro proposte politiche pubbliche. Ovviamente il corollario di questa posizione, ovvero che ognuna di queste critiche delle tue affermazioni deve essere essa stessa diretta a supporto dell’azione politica opposta, è raramente apprezzata. D’altra parte, dare per scontato che la critica delle tue affermazioni deve essere politicamente motivata è spesso un errore: a volte è vero, ma ci sono un buon numero di eccezioni che confermano che questo non andrebbe fatto.

Sappi che ci sono persone che ti traviseranno. Viene percepito che la scienza del clima abbia implicazioni politiche, economiche ed etiche. Buona parte di ció che viene discusso in realtà non ha alcuna di tali implicazioni, ma la “scientifizzazione” di discorsi politici su questo tema conferma che fare microanalisi di un lavoro pubblicato o postare su blog è una pratica comune. Sostenitori di tutte le parti (anche se con una predominanza di quelle al di fuori della corrente principale) esamineranno se un nuovo risultato o commento sembra inserirsi nel loro specifico interesse, e lo strombazzeranno in giro se è così. Le motivazioni possono spaziare da specificamente politiche fino al desiderio di pubblicità o di una posizione, anche se i motivi precisi sono spesso oscuri e nella maggior parte dei casi non vale neanche la pena discuterne. Così gli anelli degli alberi del XV secolo diventano uno spunto contro il Protocollo di Kyoto, come i flagelli batterici vengono chiamati in causa quando si parla del ruolo della religione nella vita pubblica.

Nel mondo specifico dei blog legati al clima ci sono numerosi canali entro i quali le esposizioni erronee ottengono ampia diffusione. Matt Drudge, ad esempio, spende una quantità straordinaria di tempo nel cercare storie pazze sulla climatologia nelle fonti d’informazione borderline ed evidenziandole nel molto letto Drudge Report. Marc Morano (il quale sembra stia lasciando il suo posto di membro dello staff del senatore Inhofe) è un lettore molto diligente dei blogs climatici (Pielke2, WUWT, RC etc.) e qualsiasi esposizione erronea trovata o critiche che possono essere male interpretate, è prontamente segnalata in moltissime e-mail. Da lì, ad essere fortunati, ulteriori errate interpretazioni potrebbero trovare spazio nello show di Rush Limbaugh (tramite Roy Spencer), o da Glenn Beck come argomentazioni da scartare che confermano (a loro) la perfidia della corrente principale della climatologia.

Fai attenzione che l’impatto che hai potrebbe essere molto differente dall’impatto che pensi dovresti avere. Fino ad oggi, se ti ritrovi costantemente citato erroneamente o segnalato nel supportare idee e posizioni che non condividi, pensa al motivo di tutto ciò. Probabilmente sarai accusato di ‘difesa nascosta’ cioè di appoggiare segretamente coloro che ti citano erroneamente. Se non fosse effettivamente così, ricorda che l’abbandono della responsabilità per le tue parole (cioè “come potevo sapere che sarei stato citato erroneamente così spesso?”) non è una opzione che ti lascia molta integrità. Essere mal citato una volta potrebbe essere una sfortuna, esserlo più volte puzza di negligenza.

Non aspettarti che il mondo sia equo. Leggi “Bambi contro Godzilla” di Mamet, e in particolare la sezione che contiene questa frase:

“In queste competizioni di menzogne, la parte che realmente subisce la mistificazione, la parte con un vero programma realizzabile, o che possegga un prodotto effettivamente utile, è in grave svantaggio; è bloccata in una posizione che non può abbandonare, e, così, non può usare le sue qualità in elucubrazioni, distrazioni, drammi e sotterfugi.”

Poichè sei presumibilmente legato ad un complesso coerente di idee, non sarai in grado di usare dieci argomenti inconsistenti mutuamente contradittori nello stesso paragrafo, o di impegnarti in una selezione artificiosa, in una distorsione o in intenzionali cattive citazioni. Tuttavia occasionalmente è istruttivo mostrare cosa avresti potuto affermare se non avessi avuto questi principi etici.

Non lasciare che critiche del tutto infondate ti infastidiscano. Se parli nella sfera pubblica, sicuro come la notte segue il giorno, verrai criticato. Alcune critiche sono costruttive e ti aiuteranno a identificare la tua voce. Molte non lo sono. Se avrai successo, inizierai a confrontarti con un simulacro online di te stesso che porta il tuo nome e posto di lavoro ma che non condivide nessuna delle tue idee, non ha alcun tratto caratteriale da mantenere e sarebbe del tutto estraneo a chiunque ti abbia effettivamente conosciuto. Ignoralo o ignorala. Ci sono persone che saranno sempre più contente di demonizzare gli oppositori che di interagire onestamente con persone vere.

Non diffamare le persone. Questo non dovrebbe essere necessario dirlo, ma accusare banalmente gli scienziati di disonestà, furto, cattiva pratica accademica e frode ti esclude con buona probabilità dai discorsi seri. Invece servirà a marginalizzarti – sebbene potresti guadagnare dei seguaci devoti in uno specifico ambito. Non sorprenderti se, come conseguenza, altre persone inizieranno a reagire negativamente ai tuoi commenti.

Correggi gli errori. Ancora, dovrebbe essere ovvio che mantenere dell’integrità richiede che gli errori di fatto siano corretti il prima possibile.

Rammenta che, sebbene parli per te stesso, se prendi le posizioni della principale corrente di pensiero, sarai percepito come se parlassi per l’intera comunità della scienza del clima. Perciò non criticare anonimi “scienziati” in generale quando vuoi essere specifico, e non assumere che il contesto in cui stai parlando sia immediatamente ovvio per la comprensione di lettori occasionali.

Evita l’uso di un linguaggio che può essere facilmente frainteso. Questo è difficile.

Non usare alcuna metafora da Seconda Guerra Mondiale. Mai. Questo rende troppo facile per le persone far ricorso alla retorica e al falso oltraggio. Comunque tieni saldamente in pugno i tuoi punti di vista, l’appropiatezza di queste immagini è sempre difficile da vendere, e non ti sarà data alcuna occasione di promuovere la tua argomentazione. Questo è perciò quasi semprecontroproducente e può essere esteso a qualunque tipo di linguaggio manicheo.

Se sarai additato dai propagandisti, fai tua quella attenzione come se indossassi una medaglia d’onore. Sarai in una compagnia davvero buona.

Se vieni coinvolto in una “tempesta da blog”, sappi che anche questa passerà. Essere individuati come bersaglio non è molto divertente (chiedi a Heidi Cullen). Ma il ciclo di vita di una schermaglia legata ai blog dura generalmente pochi giorni, e il mondo dei blog nell’insieme soffre di estremo disordine dovuto alla mancanza di attenzione. Dopo aver scoperto che lunedì il tuo post e i tuoi commenti erano l’argomento di cui tutti parlavano, probabilmente giovedì non verrà più neanche citato.

Riconosci che l’umorismo è di gran lunga più efficiente dell’offesa. Ma tenta ed elevati al di sopra del livello del camposcuola. Pensa a Jon Stewart piuttosto che a Rodney Dangerfield.

Se tutto quello detto sopra non ti dissuade completamente dall’idea, benvenuto nel mondo dei blog! La tua voce è sicuramente necessaria!

Articolo originale su Realclimate.org

Traduzione di: Federico Antognazza, Riccardo Reitano, Martino Salvaro, Lighea Speziale

Revisione di: Simone Casadei

Pubblicato su Climalteranti il: 21/3/2009

16 – Incendi e calore estremo nell’Australia sudorientale

Sabato 7 febbraio 2009, l’Australia ha vissuto il suo peggiore disastro naturale da oltre 100 anni, quando incendi disastrosi hanno ucciso più di 200 persone e distrutto più di 1800 case nello stato di Victoria, Australia. Questi incendi hanno avuto luogo in un giorno di temperature elevate a livelli senza precedenti nel Sud dell’Australia, parte di un’ondata di calore iniziata 10 giorni prima, e di un periodo record di siccità.

Questo è stato scritto a Melbourne, Australia, esattamente una settimana dopo gli incendi, appena il tempo sufficiente di fermarsi e riflettere su questa tragedia e le condizioni meteorologiche estreme che hanno portato a questo. Per prima cosa, vorrei esprimere la mie sincera solidarietà per tutti coloro che hanno perso delle persone care o amici e a tutti coloro che hanno sofferto per questo disastro.

A livello globale i media hanno dato ampio spazio a questo disastro naturale e, naturalmente, speculazioni sul possibile ruolo del cambiamento climatico su questi incendi. Quindi, è il cambiamento climatico ad aver causato questi incendi? La risposta semplice è “No!” Il cambiamento climatico non ha dato vita agli incendi. Sfortunatamente, sembra che uno o più incendi possano essere stati accesi da piromani, altri possono essere stati causati accidentalmente ed altri ancora dalla caduta di linee elettriche, fulmini o altre cause naturali.

Forse c’è un modo diverso di esporre la questione: in che modo, se esiste una relazione, il cambiamento climatico può aver influito su questi incendi?

Per rispondere a questa domanda, dobbiamo andare a vedere la storia degli incendi e del clima torrido avvenuti negli ultimi 100 anni circa. Gli incendi avvengono regolarmente nel SudEst dell’Australia con precedenti disastrosi incendi nel “Mercoledì delle Ceneri”, il 16 febbraio 1983, e il “Venerdi Nero”, il 13 gennaio 1939, ed entrambi hanno portato a significative perdite di vite umane e proprietà immobiliari. Per fortuna un report recente “Condizioni meteorologiche favorevoli agli incendi nel SudEst dell’Australia: tendenze recenti e impatti del cambiamento climatico previsto” (rif. 1) nel 2007 ha fornito una valutazione esauriente su questo argomento. Inoltre l’Ufficio Meteorologico Australiano con la sua “Dichiarazione Speciale sul Clima” (rif 2) descrive l’ondata di calore straordinaria e le condizioni di siccità al momento degli incendi.

A seguito degli incendi del Venerdì Nero, è stato creato negli anni ‘60 l’indice MacArthur sul pericolo di incendio delle foreste (FFDI), che è un indicatore empirico delle condizioni meteorologiche associate con un pericolo alto o estremo di incendio, e con la difficoltà di spegnimento dell’incendio. L’indice FFDI è il prodotto di termini relativi agli esponenziali di temperatura massima, umidità relativa, velocità del vento, e aridità del combustibile (misurata usando un fattore di siccità). Ognuno di questi termini è relativo a fattori ambientali che influenzano la gravità delle condizioni dell’incendio. La formula del FFDI è fornita nel report sulle Condizioni meteorologiche favorevoli agli incendi nel SudEst dell’Australia. La scala FFDI è usata per classificare la pericolosità dell’incendio e la dichiarazione dei giorni di divieto totale di accensione fuochi in Victoria

Classificazione pericolosità di incendio Intervallo FFDI

Alto da 12 a 25

Molto alto da 25 a 50

Estremo >50

La scala FFDI è stata creata in modo tale che il disastroso incendio del Venerdì Nero del 1939 abbia un valore FFDI pari a 100.

Per capire le condizioni ambientali associate al disastroso incendio del 7 febbraio 2009 dobbiamo considerare ogni singolo fattore e il possibile ruolo che ha avuto il cambiamento climatico nel determinarlo.

Temperatura massima: questo è il fattore più semplice da considerare. Il 7 febbraio sono state registrate temperature massime elevate sia a Melbourne sia in gran parte di Victoria (rif. 2). A Melbourne, sulla base di una serie storica di osservazioni lunga più di 100 anni, è stato registrato un nuovo record di temperatura massima pari a 46.4°C, 0.8°C più elevato del precedente record assoluto, registrato durante il Venerdì Nero (Black Friday) del 1939 e di 3°C superiore al precedente massimo di febbraio, registrato l’8 febbraio 1983 (lo stesso giorno in cui una terribile tempesta di polvere colpì Melbourne). Ma forse l’isola di calore della città di Melbourne ha influenzato questi nuovi records. Questo può essere vero per Melbourne, ma numerose altre stazioni nello stato di Victoria hanno misurato il 7 febbraio temperature massime da record di tutti i tempi, tra cui anche il sito rurale di particolare qualità ambientale di Laverton, vicino Melbourne, in cui è stata misurata una temperatura massima pari a 47.5°C, ben 2.5°C superiore rispetto al massimo precedente del 1983. L’ondata di calore estrema del 7 febbraio è arrivata dopo un’altra ondata di calore da record 10 giorni prima, durante la quale Melbourne ha vissuto per tre giorni di fila con temperature massime superiori ai 43°C tra il 28 e il 30 gennaio; un episodio simile non si era mai verificato nei 154 anni di osservazioni disponibili per Melbourne. Un’immagine impressionante delle anomalie di temperatura al suolo associate a questa ondata di calore è disponibile sul sito dell’Osservatorio Terrestre della NASA.

Gli aumenti della temperatura media e della temperatura massima media in Australia sono stati attribuiti ai cambiamenti climatici di origine antropica, come riportato nel Quarto Rapporto dell’IPCC, in cui viene data una migliore stima del contributo antropogenico agli aumenti della temperatura massima media di circa 0.6°C dal 1950 al 1999 (Karoly and Braganza, 2005). In una recente analisi degli eventi estremi osservati e modellizzati in Australia è stata trovata una tendenza all’aumento dei valori estremi di temperatura e un significativo incremento della durata delle ondate di calore dal 1957 al 1999 (Alexander e Arblaster, 2009). Pertanto, il cambiamento climatico di origine antropica costituisce probabilmente un importante fattore che ha contribuito alle temperature massime senza precedenti misurate il 7 febbraio 2009.

Umidità relativa: valori di umidità relativa bassi a livelli record sono stati misurati a Melbourne e in altri siti dello stato di Victoria il 7 febbraio, con valori minimi del 5% nel tardo pomeriggio. Anche se non sono disponibili lunghe serie storiche di dati di umidità di alta qualità per l’Australia, il bassissimo tasso di umidità è probabilmente associato alla eccezionale scarsità di precipitazioni verificatasi dall’inizio dell’anno a Melbourne e alla prolungata onda di calore. Non ci sono studi specifici che hanno attribuito la riduzione dell’umidità relativa in Australia ai cambiamenti climatici di origine antropica, tuttavia questo è consistente con l’aumento delle temperature e la diminuzione delle precipitazioni, attesi a causa dei cambiamenti climatici nel Sud dell’Australia.

Velocità del vento: i pericolosi ed eccezionali incendi nel Sud Est dell’Australia sono associati a forti venti settentrionali che portano con loro aria calda e secca dall’Australia centrale. Le condizioni meteorologiche ed i venti settentrionali il 7 febbraio erano simili a quelli in occasione del Mercoledì delle Ceneri (Ash Wednesday) e del Venerdì Nero (Black Friday), e i venti davvero sostenuti non sembrano né essere eccezionali né collegati al cambiamento climatico.

Il fattore siccità: come precedentemente menzionato, la città di Melbourne e buona parte dello stato di Victoria hanno subito il record di scarsità di pioggia relativamente al primo periodo dell’anno. Melbourne ha registrato 35 giorni consecutivi senza piogge misurabili fino al 7 Febbraio, il secondo periodo più lungo di sempre senza pioggia, ed il periodo fino all’8 Febbraio, con un totale di soli 2.2 mm, è stato il più secco inizio d’anno per Melbourne in più di 150 anni (rif. 2). Questa situazione fu preceduta da 12 anni di precipitazioni medie molto al di sotto della media su buona parte del Sud Est dell’Australia, con un record di scarsità di pioggia sui 12 anni nel sud dello stato di Victoria (rif. 2). Questo ha contribuito al valore estremamente basso di umidità (3-5 %) rilevato il 7 febbraio 2009. Mentre si prevede che il Sud Est dell’Australia verrà interessato da minori precipitazioni e più siccità a causa deii cambiamenti climatici antropogenici, risulta difficile quantificare i contributi relativi della variabilità naturale e del cambiamento climatico per la siccità dell’inizio del 2009.

Sebbene studi specifici che quantificano l’influenza del cambiamento climatico sulla cresciuta probabilità di pericolo di incendi estremi nel Sud Est dell’Australia non siano ancora stati realizzati, è molto probabile che tale influenza ci sia stata. Gli incrementi a lungo termine nella temperatura massima sono stati attribuiti al cambiamento climatico antropogenico. L’FFDI per un numero di siti nello stato di Victoria il 7 febbraio ha registrato valori mai raggiunti prima, variando tra 120 e 190, molto maggiore delle condizioni meteorologiche del “Mercoledì delle Ceneri” e del “Venerdì Nero” ed abbastanza al di sopra del livello “catastrofico” nella scala del pericolo d’incendi (rif. 1).

Certamente, gli impatti dei cambiamenti climatici antropogenici sugli incendi nel Sud Est dell’Australia o in qualsiasi altra parte del mondo non sono nuovi o inaspettati. Nel 2007, il Quarto Rapporto dell’IPCC nel capitolo del WGII “Australia e Nuova Zelanda” concluse:

Un incremento del pericolo d’incendi in Australia è probabilmente associato ad un ridotto intervallo tra un incendio e l’altro, ad una cresciuta intensità del fuoco, ad una diminuzione degli spegnimenti e ad una maggiore velocità di propagazione del fuoco. Nel Sud Est dell’Australia la frequenza di giornate con pericolo molto alto o estremo di incendi è probabilmente destinato a salire tra il 4 e il 25% entro il 2020 e tra il 15 e il 70% entro il 2050.

In maniera simile al caso australiano, incrementi osservati e previsti negli incendi delle foreste sono stati legati al cambiamento climatico nell’Ovest degli Stati Uniti, in Canada ed in Spagna (Westerling et al, 2006; Gillett et al, 2004; Pausas, 2004). Mentre risulta difficile separare le influenze della variabilità climatica, del cambiamento climatico e delle modifiche nelle strategie di gestione degli incendi a fronte degli osservati aumenti dell’attività degli incendi, è chiaro che il cambiamento climatico stia aumentando la probabilità di condizioni ambientali associate all’estremo pericolo di incendi nel Sud Est dell’Australia ed in numerose altre parti del mondo.

Riferimenti e ulteriori pubblicazioni:

(1) Bushfire Weather in Southeast Australia: Recent Trends and Projected Climate Change Impacts, C. Lucas et al, Consultancy Report prepared for the Climate Institute of Australia by the Bushfire CRC and CSIRO, 2007.

(2) Special Climate Statement from the Australian Bureau of Meteorology “The exceptional January-February 2009 heatwave in south-eastern Australia”

Karoly, D. J., and K. Braganza, 2005: Attribution of recent temperature changes in the Australian region. J. Climate, 18, 457-464.

Alexander, L.V., and J. M. Arblaster, 2009: Assessing trends in observed and modelled climate extremes over Australia in relation to future projections. Int. J Climatol., available online.

Hennessy, K., et al., 2007: Australia and New Zealand. Climate Change 2007: Impacts, Adaptation and Vulnerability. Contribution of Working Group II to the Fourth Assessment Report of the Intergovernmental Panel on Climate Change, M.L. Parry, et al., Eds., Cambridge University Press, Cambridge, UK, 507-540.

Westerling, A. L., et al., 2006: Warming and Earlier Spring Increase Western U.S. Forest Wildfire Activity. Science, 313, 940.

Gillett, N. P., et al., 2004: Detecting the effect of climate change on Canadian forest fires. Geophys. Res. Lett., 31, L18211, doi:10.1029/2004GL020876.

Pausas, J. G., 2004: Changes In Fire And Climate In The Eastern Iberian Peninsula (Mediterranean Basin). Climatic Change, 63, 337–350.

Articolo originale su Realclimate.org

Traduzione di: Giulia Fiorese, Martino Salvaro, Fabio Sferra

Revisione di: Simone Casadei

Pubblicato su Climalteranti il: 25/2/2009

15 – Irreversibile non significa inarrestabile

Susan Solomon, luminare per le tematiche legate al buco dell’ozono, membro dell’IPCC vincitrice del Premio Nobel, e i suoi colleghi, hanno appena pubblicato un articolo intitolato “Cambiamenti climatici irreversibili a causa delle emissioni di anidride carbonica” nei Proceedings della Accademia Nazionale delle Scienze. Noi di realclimate abbiamo ricevuto molte chiamate da parte di giornalisti per quanto riguarda questo articolo e, qualcuno di loro sembra aver inteso che l’apocalisse stia per colpirci. Qualche anno fa, Dennis Avery e Fred Singer hanno usato la parola “inarrestabile” come vessillo di battaglia per quanto riguarda il fatto che il riscaldamento osservato sia un processo naturale e perciò non ci sia nulla che l’umanità possa fare per cercare di cambiarne il corso. Quindi, secondo la retorica visione della loro associazione si potrebbe affermare Inarrestabile = brucia baby brucia! Attenzione, non confondiamo “irreversibile” con “inarrestabile”. Uno significa che non si torna indietro, mentre l’altro significa che non si può fermare. Sono aggettivi molto diversi. Non disperiamo!

Solomon e colleghi sottolineano che le continue e non limitate emissioni di CO2 nell’atmosfera avrebbero conseguenze climatiche che persisterebbero per un migliaio di anni, che loro operativamente definiscono come “per sempre”, nel senso di “irreversibile”. Non è esattamente una novità scientifica che la concentrazione atmosferica della CO2, dopo un’immissione nel ciclo del carbonio di nuova CO2 da combustibili fossili, permanga per migliaia di anni più elevata rispetto ai livelli naturali. La concentrazione atmosferica della CO2 presenterà una netta impennata in corrispondenza della fine dell’era dei combustibili fossili, quindi, una volta che l’umanità sarà divenuta indipendente dal carbonio (immaginate!) la concentrazione di CO2 incomincerà a calare, rapidamente all’inizio ma dopo pochi secoli si stabilizzerà in una “lunga coda” che persisterà per centinaia di migliaia di anni.

Questa “lunga coda” è stata prevista per la prima volta da un modello del ciclo del carbonio realizzato da Walzer e Kasting nel 1992. Il mio primissimo post su Realclimate era intitolato “Fino a quando durerà il riscaldamento globale?”, riguardava proprio questa lunga “coda”. Ecco qui un articolo tratto dalla rivista Climatic Change che fa il punto sui modelli del ciclo del carbonio riportati in letteratura, modelli che mostrano tutti la lunga coda. Un certo numero di noi sostenitori della lunga coda si sono riuniti (elettronicamente) per realizzare il “Progetto di Intercomparazione dei Modelli a Lunga Coda”, LTMIP, come per gli altri modelli PMIP e OCMIP (i primi risultati appariranno presto nell’Annual Reviews di Earth and Planetary Sciences). Vi ho anche scritto un libro a proposito.

Le molecole che realmente contengono carbonio nei combustibili fossili si diffondono negli altri serbatoi di carbonio nelle parti rapide del ciclo del carbonio, dissolvendosi negli oceani ed entrando nel ciclo fotosintetico delle piante terrestri. La diffusione del carbonio è analoga ad una piccola quantità d’acqua che viene versata in un punto di un lago: essa si diffonde rapidamente nel resto del lago, piuttosto che rimanere bloccata là dove è stata versata, e il livello del lago cresce di un po’ in ogni sua parte. Fuor di metafora, nel ciclo del carbonio, il contenuto di CO2 atmosferica aumenta insieme al contenuto degli altri serbatoi di carbonio.

In definitiva, la frazione atmosferica di CO2 emessa è determinata in larga parte dal volano chimico degli oceani; si può ottenere una buona stima con un semplice calcolo basato su un oceano ben miscelato, ignorando tutte le complicazioni come le differenze di temperatura, la circolazione e la biologia. L’oceano decide che la frazione atmosferica di un rilascio di CO2, dopo la sua diffusione negli altri comparti veloci del ciclo del carbonio, sarà nell’ordine del 10 – 30 %. Il solo modo a lungo termine per accelerare la rimozione di CO2 nella lunga coda sarebbe di rimuovere attivamente la CO2 dall’aria, la qual cosa personalmente ritengo, in prospettiva, sarà necessaria. Ma in questo caso l’effetto volano dell’oceano lavorerebbe contro di noi, rilasciando CO2 per “compensare” i nostri sforzi.

Come risultato della lunga coda, qualsiasi impatto climatico originato da una maggiore CO2 nell’aria sarà essenzialmente irreversibile. A questo punto la domanda è: quali sono gli impatti della CO2 sul clima? Diventa più caldo, questo è chiaro, e il livello dei mari aumenta. L’aumento del livello dei mari è una conseguenza profonda della lunga coda del riscaldamento globale, perchè la risposta nel passato, su scale temporali geologiche, è stata di decine di metri per °C di cambiamento nella temperatura media globale, circa 100 volte più forte della previsione IPCC per il 2100 (circa 0,2 metri per °C). Il terzo impatto che guadagna l’immortalità grazie alla lunga coda sono le precipitazioni. In questo caso la storia convenzionale è stata che i modelli climatici non sono molto in accordo tra loro nel prevedere i cambiamenti di precipitazioni su scala regionale in risposta ad un aumento della CO2. Apparentemente ciò sta cambiando con la suite AR4 delle corse dei modelli, come Solomon et al hanno dimostrato nella loro Figura 3. Inoltre, c’è un quadro degli impatti da siccità consistente con il riscaldamento in alcuni luoghi, per esempio nel Sud Ovest degli Stati Uniti, sia negli ultimi decenni che nel Medioevo. Le specifiche di una previsione sui fenomeni di siccità dovuti al riscaldamento globale stanno iniziando a essere approfondite.

Forse la disperazione che abbiamo sentito nelle domande dei nostri intervistatori è derivata dall’osservazione, nell’articolo, che la temperatura continuerà ad aumentare anche se le emissioni di CO2 fossero fermate oggi. Ma dovete ricordare che i cambiamenti intervenuti nel clima fino ad adesso, sia osservati che attribuiti, sono minori se paragonati alla previsione business-as-usual per la fine del secolo. Sono le emissioni ulteriori di cui dobbiamo preoccuparci. Il cambiamento climatico è come un ingranaggio, che carichiamo emettendo CO2. Una volta che giriamo la manovella, non è facile tornare indietro al clima naturale. Ma possiamo ancora decidere di smettere di girare la manovella, e prima lo faremo meglio sarà.

Walker JCG, Kasting JF. 1992. Effects of fuel and forest conservation on future levels of atmospheric carbon dioxide. Palaeogeogr. Palaeoclimatol. Palaeoecol. (Glob. Planet. Change Sect.) 97:151–89

Articolo originale su Realclimate.org

Traduzione di: Emanuele Eccel, Riccardo Mancioli, Tania Molteni

Revisione di: Simone Casadei

Pubblicato su Climalteranti il: 10/2/2009

14 – Un aggiornamento dell’indice globale dei ghiacciai

Per le serie delle temperature globali abbiamo a disposizione GISTEMP, NCDC e HadCRUT. Ognuno di questi gruppi di ricerca ha lavorato sodo per assimilare i dati delle temperature globali in indici di temperatura globale accurati e affidabili. L’equivalente per i ghiacciai alpini è il World Glacier Monitoring Service (WGMS) ovvero il Servizio Mondiale di Monitoraggio dei Ghiacciai, che registra il bilancio di massa e il comportamento della fronte dei ghiacciai. Fin dal 1986, WGMS ha mantenuto e pubblicato una raccolta di informazioni sui cambiamenti dei ghiacciai in corso che iniziarono nel 1960 con il Permanent Service on Fluctuations of glaciers (Servizio Permanente sulle Fluttuazioni dei Ghiacciai). Questo programma negli ultimi 10 anni si è sforzato di acquisire, pubblicare e verificare le misure di variazione frontale e quelle di bilancio di massa dei ghiacciai montani provenienti da tutto il mondo e organizzati su base temporale. Guidato da Wilfried Haeberli con l’assistenza di Isabelle Roer, Michael Zemp, Martin Hoelzle dell’Università di Zurigo, il gruppo di lavoro ha sviluppato una recente pubblicazione, “Global Glacier Changes: facts and figures” (Cambiamenti Globali dei Ghiacciai: fatti e dati) pubblicata congiuntamente con l’UNEP. Questa pubblicazione riassume le informazioni raccolte e conferite dai corrispondenti nazionali del WGMS e raffigura la risposta globale dei ghiacciai ai cambiamenti climatici, così come la risposta regionale.

La salute di un ghiacciaio montano è solitamente determinata monitorando il comportamento della fronte e/o del suo bilancio di massa. Il bilancio di massa di un ghiacciaio è la differenza fra l’accumulo e l’ablazione (fusione e sublimazione) e può essere alterato dalle variazioni di temperatura e delle precipitazioni nevose causate dai cambiamenti climatici. Un ghiacciaio con un continuo bilancio negativo è in disequilibrio e si ritirerà. Un ghiacciaio con un

continuo bilancio positivo è in disequilibrio e avanzerà per ristabilire il suo equilibrio. L’avanzata di un ghiacciaio aumenta l’estensione del ghiacciaio stesso alle quote inferiori dove l’ablazione è più alta, compensando l’incremento dell’accumulo. Il ritiro di un ghiacciaio consta nella perdita dei settori più bassi del ghiacciaio stesso. Siccome le alte quote sono più fredde, la scomparsa della parte più bassa del ghiacciaio riduce l’ablazione totale, incrementando il bilancio di massa e, potenzialmente, ristabilendo l’equilibrio. Se un ghiacciaio è privo di un consistente accumulo è in disequilibrio (stato non stazionario) con il clima e si ritirerà inesorabilmente finchè non si realizzerà un cambiamento climatico verso condizioni più fredde e più nevose (Pelto, 2006; Paul et al., 2007).

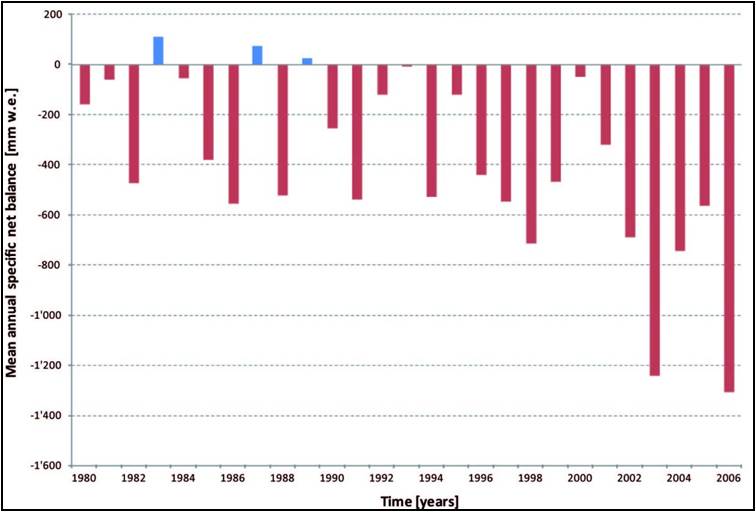

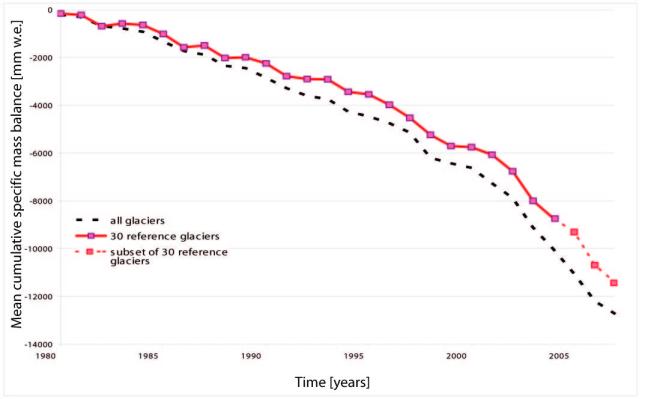

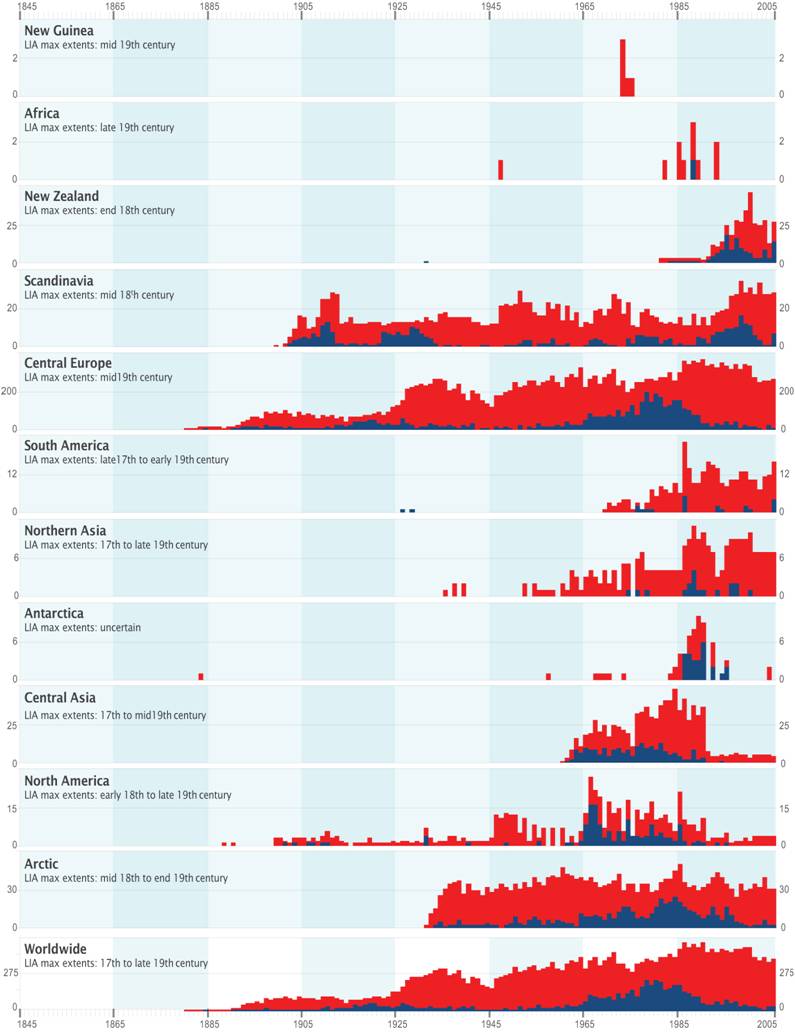

In termini di bilancio di massa i due grafici riportati indicano la media annuale del bilancio di massa dei  ghiacciai considerati dal WGMS e la media del bilancio cumulato dei ghiacciai monitorati con più di 30 anni di dati e di tutti i ghiacciai monitorati. I trend dimostrano perché i ghiacciai montani si stiano attualmente ritirando: i bilanci di massa sono significativamente e consistentemente negativi. Il bilancio di massa è espresso in cambiamenti di spessore in termini di equivalente d’acqua. Una perdita di 0.9 m di equivalente d’acqua è la stessa cosa di una perdita di 1.0 m di spessore del ghiacciaio, siccome la densità del ghiaccio è minore della densità dell’acqua. La perdita cumulata degli ultimi 30 anni equivale a tagliare una spessa fetta dal ghiacciaio medio. La tendenza è molto coerente fra una regione e l’altra. La figura a destra è l’indice annuale del bilancio di massa glaciale dal WGMS (se questo fosse un bilancio aziendale sarebbe già ora in bancarotta). L’indice cumulato del bilancio di massa, basato su 30 ghiacciai con 30 anni di dati e su tutti i ghiacciai non è apprezzabilmente diverso (la linea tratteggiata è per un sottoinsieme di 30 ghiacciai di riferimento, siccome non tutti i 30 ghiacciai hanno fornito i dati complessivi per tutti gli ultimi anni):

ghiacciai considerati dal WGMS e la media del bilancio cumulato dei ghiacciai monitorati con più di 30 anni di dati e di tutti i ghiacciai monitorati. I trend dimostrano perché i ghiacciai montani si stiano attualmente ritirando: i bilanci di massa sono significativamente e consistentemente negativi. Il bilancio di massa è espresso in cambiamenti di spessore in termini di equivalente d’acqua. Una perdita di 0.9 m di equivalente d’acqua è la stessa cosa di una perdita di 1.0 m di spessore del ghiacciaio, siccome la densità del ghiaccio è minore della densità dell’acqua. La perdita cumulata degli ultimi 30 anni equivale a tagliare una spessa fetta dal ghiacciaio medio. La tendenza è molto coerente fra una regione e l’altra. La figura a destra è l’indice annuale del bilancio di massa glaciale dal WGMS (se questo fosse un bilancio aziendale sarebbe già ora in bancarotta). L’indice cumulato del bilancio di massa, basato su 30 ghiacciai con 30 anni di dati e su tutti i ghiacciai non è apprezzabilmente diverso (la linea tratteggiata è per un sottoinsieme di 30 ghiacciai di riferimento, siccome non tutti i 30 ghiacciai hanno fornito i dati complessivi per tutti gli ultimi anni):

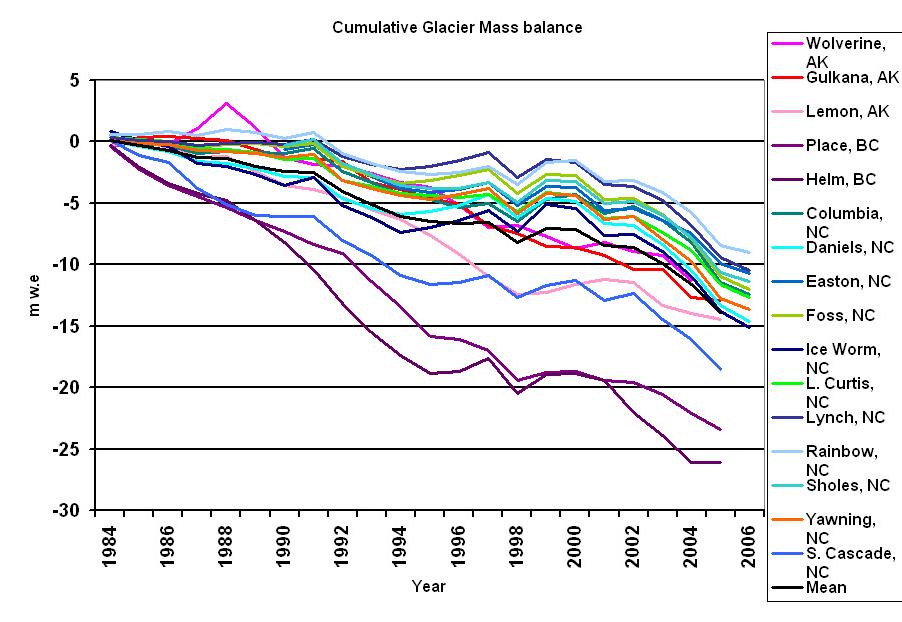

Il grafico per i ghiacciai del Nord America non è molto diverso, individualmente o collettivamente. La prossima figura mostra il bilancio cumulato annuale dei ghiacciai del Nord America che afferiscono al WGMS con almeno 15 anni di registrazione:

Il secondo parametro riportato dal WGMS è il comportamento della fronte del ghiacciaio. I valori per i  ghiacciai sono generalmente esaminati su base annuale (molti altri ghiacciai aggiuntivi sono esaminati periodicamente). Il campione mostra una netta prevalenza dei ghiacciai delle Alpi Europee, ma il complesso globale e regionale delle registrazioni è simile, ad eccezione della Nuova Zelanda. Il numero di ghiacciai che avanzano rispetto ai ghiacciai che si ritirano nel diagramma sottostante del WGMS mostra nel 2005 un minimo nella percentuale dei ghiacciai in avanzata in Europa, Asia e nord America. In Asia e in Alaska, sono state effettuate indagini estese sulle fronti mediante immagini satellitari e fotografie aeree che mostrano trend di ritiro a lungo termine. Questi risultati indicano che il 95% dei ghiacciai si sta ritirando, ma non rispecchiano pienamente il ritiro annuale della fronte che emerge dall’archivio dei dati del WGMS. Nel 2005 sono stati controllati 442 ghiacciai: 26 avanzavano, 18 erano stazionari e 398 si ritiravano, risulta così che “solo” il 90% dei ghiacciai si sta ritirando. Sempre nel 2005, per la prima volta non si sono osservati in Svizzera ghiacciai in avanzata. Dei 26 ghiacciai in avanzata, 15 erano in Nuova Zelanda. Complessivamente c’è però stata una sostanziale perdita dell’11% del volume dei ghiacciai della Nuova Zelanda dal 1975 al 2005 (Salinger et al), ma il numero di ghiacciai in avanzamento è ancora significativo.

ghiacciai sono generalmente esaminati su base annuale (molti altri ghiacciai aggiuntivi sono esaminati periodicamente). Il campione mostra una netta prevalenza dei ghiacciai delle Alpi Europee, ma il complesso globale e regionale delle registrazioni è simile, ad eccezione della Nuova Zelanda. Il numero di ghiacciai che avanzano rispetto ai ghiacciai che si ritirano nel diagramma sottostante del WGMS mostra nel 2005 un minimo nella percentuale dei ghiacciai in avanzata in Europa, Asia e nord America. In Asia e in Alaska, sono state effettuate indagini estese sulle fronti mediante immagini satellitari e fotografie aeree che mostrano trend di ritiro a lungo termine. Questi risultati indicano che il 95% dei ghiacciai si sta ritirando, ma non rispecchiano pienamente il ritiro annuale della fronte che emerge dall’archivio dei dati del WGMS. Nel 2005 sono stati controllati 442 ghiacciai: 26 avanzavano, 18 erano stazionari e 398 si ritiravano, risulta così che “solo” il 90% dei ghiacciai si sta ritirando. Sempre nel 2005, per la prima volta non si sono osservati in Svizzera ghiacciai in avanzata. Dei 26 ghiacciai in avanzata, 15 erano in Nuova Zelanda. Complessivamente c’è però stata una sostanziale perdita dell’11% del volume dei ghiacciai della Nuova Zelanda dal 1975 al 2005 (Salinger et al), ma il numero di ghiacciai in avanzamento è ancora significativo.

Che i ghiacciai si stiano riducendo in termini di volume (bilancio di massa) e di lunghezza (comportamento della fronte) non sono novità. La notizia è lo sviluppo di un significativo indice globale del comportamento dei ghiacciai. Come fornitore di dati al WGMS, posso riferire che il controllo di qualità e il livello di dettaglio richiesto nel presentare i dati è in aumento. Anche il grado di partecipazione ai programmi glaciologici è in aumento. Entrambi sono importanti e porteranno ad un ulteriore miglioramento dell’indice glaciologico, con più dati rappresentativi da tutto il mondo.

Addendum:

i dati di bilancio di massa per il ghiacciaio Ciardoney, nel massiccio del Gran Paradiso sono disponibili qui.

“Il ghiacciaio Pasterze presso il massiccio del Grossglockner, Austria: una serie di cartelli mostra chiaramente l’inesorabile ritiro del ghiacciaio, che perde ogni anno mediamente 15 metri di lunghezza e dai 3 ai 5 m di spessore (riduzione di massa 1990-2000 pari a 140 milioni di metri cubi). Foto Luca Lombroso, 2 agosto 2007”

Articolo originale su Realclimate.org

Traduzione di: Luca Lombroso

Revisione di: Luca Mercalli, Simone Casadei

Pubblicato su Climalteranti il: 3/2/2009

13 – Il mare raggiungerà “I livelli dell’ultima era glaciale”

Il tabloid britannico Daily Mirror ha recentemente titolato che “il mare si innalzerà ai livelli dell’ultima era glaciale”. Certamente molti dei nostri lettori comprendono quanto terrificante possa essere tale previsione: il livello dei mari durante l’ultima era glaciale era fino a 120 m più basso di oggi. Le nostre spiagge preferite, come Coogee a Sydney o Darß sulla costa baltica tedesca, diverrebbero alte e asciutte, e porti come Rotterdam o Tokyo si ritroverebbero ben lontani dal mare. Provate ad immaginare…

Il tabloid britannico Daily Mirror ha recentemente titolato che “il mare si innalzerà ai livelli dell’ultima era glaciale”. Certamente molti dei nostri lettori comprendono quanto terrificante possa essere tale previsione: il livello dei mari durante l’ultima era glaciale era fino a 120 m più basso di oggi. Le nostre spiagge preferite, come Coogee a Sydney o Darß sulla costa baltica tedesca, diverrebbero alte e asciutte, e porti come Rotterdam o Tokyo si ritroverebbero ben lontani dal mare. Provate ad immaginare…

Ma guardando oltre la stupidità del titolo (un altro caso di sciatteria nel riportare le notizie scientifiche), qual è la vera storia che ci sta dietro? L’articolo del Mirror (come molti altri) faceva riferimento a un articolo di Grinsted, Moore and Jevrejeva pubblicato su Climate Dynamics (vedi l’articolo e i materiali multimediali). Gli autori concludono nell’articolo che entro il 2100 il livello globale del mare potrebbe innalzarsi tra 0.7 e 1.1 m per lo scenario di emissione B1, e tra 1.1 e 1.6 m per lo scenario A1FI.

La metodologia con cui gli autori stimano tali cifre si basa sulla formula semi-empirica che connette il livello marino globale alla temperatura globale, adattata ai dati osservati. Essa assume che, a seguito di un cambio nella temperatura globale, il livello dei mari si avvicinerà esponenzialmente ad un nuovo livello di equilibrio con una scala temporale ?. In questo modo si estende il metodo semi-empirico che avevo proposto in Science nel 2007. Io assumevo che i dati del passato ci indicassero il tasso iniziale di innalzamento (e questo tasso iniziale è utile per proiezioni se la scala temporale ? è lunga in confronto all’orizzonte temporale in esame). Il nuovo articolo cerca di ottenere sia la scala temporale ? che il cambiamento del livello del mare all’equilibrio finale adattando il modello ai dati del passato.

Quindi, il mio approccio è un caso speciale del modello più generale di Grinsted, come si può vedere inserendo la loro equazione (1) in (2): precisamente si tratta del caso speciale di lunghi tempi di risposta (? >> 100 anni circa). E’ quindi di conforto e anche piacevole ricevere la conferma che gli autori ottengono lo stesso mio risultato per il loro caso “storico” (dove si ricava ? = 1200 anni), così come i loro calcoli con ? = infinito, nonostante essi abbiano usato un diverso archivio di dati di livello marino (fino al 1850 all’indietro, laddove io avevo usato i dati di Church&White 2006 che iniziano nel 1880) ed un’analisi statistica più elaborata.

Comunque, trovo che la loro determinazione di t abbia una base piuttosto vacillante dato che le serie di dati usate sono troppo brevi per determinare con attendibilità una scala temporale così lunga. Ciò che le loro statistiche suggeriscono, d’altra parte, non può essere giusto – si vede dal fatto che ottengono risultati contraddittori per differenti serie di dati (per esempio, 1200+/- 500 anni per il caso “Historical” e 210 +/- 70 anni per il caso “Moberg”). Non possono essere entrambi corretti, quindi gli intervalli ristretti di incertezza sono probabilmente una sottostima dell’incertezza.

Il problema diventa ancor più lampante quando si guarda al livello del mare all’equilibrio previsto dall’integrazione dei loro dati. Dai dati paleoclimatici (vedi Figura) ci aspettiamo che per ogni grado di variazione di temperatura il cambiamento del livello del mare all’equilibrio finale sia tra i 10 e i 30 metri (come ho discusso nel mio articolo in Science – questa era la mia base per considerare che t debba essere molto lunga). Grinsted et al. ottengono dall’integrazione dei loro dati, invece, che il cambiamento dovrebbe rimanere solo sui 1.3 +/- 0.4 metri (per il caso “Moberg”, che secondo loro è il più probabile) – vedi Figura. Ciò vuol dire che per portare il livello del mare ad abbassarsi di circa 120 metri, livello ben definito per l’Ultimo Massimo Glaciale, si sarebbe dovuto verificare secondo il loro modello un raffreddamento globale di circa 90° C.

E per il futuro, il modello prevederebbe che lo scioglimento di tutto il ghiaccio in Groenlandia e nell’Antartico (corrispondente a 65 metri di aumento del livello del mare) avrebbe bisogno di 50° C di riscaldamento globale. Questa carenza di realismo conta, perchè è direttamente collegata con la t breve: l’aumento del livello del mare, osservato nel secolo scorso, può essere o integrato su una t breve e un aumento piccolo all’equilibrio, oppure su una t lunga e un aumento elevato all’equilibrio (valutato per ogni grado). Io considero l’ultimo caso come quello realistico.

La temperatura media globale e il livello del mare (riferito ad oggi) in tempi diversi nella storia della Terra, con la proiezione per l’anno 2100 (che non è una variazione ad equilibrio raggiunto!). La linea rossa mostra l’equilibrio “più probabile” secondo Grinsted et al. [Modificato dopo Archer (2006) e WBGU 2006; si veda pagina 33 per riferimenti e commento).

Grinsted et al. hanno applicato alcuni vincoli sui dati paleoclimatici, ma si basano su un fraintendimento dei dati stessi. Assumono (il loro vincolo 3) che l’ultima era interglaciale sia stata globalmente 3-5° C più calda del presente- anche se il riferimento citato a supporto (il capitolo sul paleoclima dell’IPCC, di cui io sono co-autore) spiega che si tratta di temperature estive artiche. Questo riscaldamento estivo dell’Artico è dovuto a cambiamenti orbitali che provocano un raffreddamento in ogni altra parte del pianeta, come risulta nei cambiamenti medi globali che sono molto piccoli (vedi per esempio Kubatzki et al. 2000).

Grinsted et al. commettono lo stesso errore per il clima glaciale (il loro vincolo 4), in cui assumono che le temperature massime glaciali furono globalmente di 17° C più basse del presente- il riferimento citato spiega già nell’abstract è da applicarsi solo alle latitudini comprese tra 40° N e 80° N. Il raffreddamento glaciale è stato altamente disomogeneo, con un raffreddamento globale medio stimato tra i 4 e i 7° C (vedi Schneider et al. 2006, “Quanto fu freddo l’Ultimo Massimo Glaciale?”).

Questi paleo-vincoli malmessi portano Grinsted et al. a limitare l’aumento all’equilibrio del livello del mare ad una frazione di ciò che i dati mostrano nella Figura sovrastante, e questo esclude una buona integrazione dei dati per t su lunghe scale temporali.

Per questi motivi, non sono convinto del breve t trovato (o assunto) da Grinsted et al., che costituisce la principale differenza rispetto al mio precedente studio, e continuerei a sostenere che un tempo di equilibrio molto lungo sia un’ipotesi più robusta. Si noti che (a differenza di Gristed et al.) questo non significa che ci si avvicini all’equilibrio in modo esponenziale con un’unica scala temporale, cosa che è in se stessa discutibile visti i diversi processi coinvolti. Si assume solo che il tasso iniziale di aumento sia in scala con la temperatura e che sia rilevante sulle scale temporali di interesse. Guardando i lati positivi, Gristed et al. hanno mostrato che i dati integrati e l’innalzamento del livello del mare nel caso di t grande è robusto rispetto al metodo statistico e al data set scelti.

Miglioramenti dell’approccio semi-empirico sono benvenuti – io stesso avevo auspicato che il mio articolo stimolasse la ricerca in quella direzione. Anche se gli approcci empirici non ci daranno risposte definitive sul futuro livello del mare, visto che il passato non può mai essere un perfetto analogo del futuro, tuttavia queste analisi possono essere utili per comprendere come il livello del mare si sia comportato in passato e, quindi, cosa questo possa implicare per i comportamenti futuri. Una cosa però è certa: non mi preoccuperei troppo che il livello del mare possa scendere ai livelli glaciali durante questo secolo.

Articolo originale su Realclimate.org

Traduzione di: Emanuele Eccel, Giulia Fiorese, Lighea Speziale

Revisione di: Simone Casadei

Pubblicato su Climalteranti il: 5/2/2009

10 – Buchi dell’ozono e raggi cosmici

Navigando recentemente nella blogosfera, mi sono imbattuto in un interessante trafiletto sul metodo e sul

La storia è venuta fuori all’inizio del 2008, quando il ricercatore Q.B. Lu previde che, questo anno, il buco di ozono Antartico sarebbe stato il più grande mai verificatosi a causa dell’azione di un maggiore flusso di raggi cosmici galattici (GCR), perché ci troviamo in un minimo di attività solare ed i GCR sono correlati inversamente all’attività solare. Il picco del buco dell’ozono di quest’anno ora si è già verificato, e la previsione può quindi essere confermata o smentita. Sfortunatamente per il Dr. Lu, quest’anno il buco dell’ozono è stato solo nella media del decennio: un risultato non troppo favorevole per la sua teoria.

Questa storia mi ha fatto un po’ incuriosire anche su questo aspetto. In primo luogo, non ho capito il motivo per cui i raggi cosmici dovrebbero avere un ruolo nella riduzione dello strato di ozono: la maggior parte degli effetti dei raggi cosmici di cui si discute abitualmente ruotano attorno alle connessioni nubi-aerosol, ma non ci sono molte nubi nella stratosfera dove si forma il buco dell’ozono, e quelle che ci sono (le nubi stratosferiche polari, PSC) sono molto più sensibili agli sbalzi di temperatura e vapore acqueo che non agli aerosol di fondo. Facendo ulteriori indagini, si scopre che questa idea è in voga da alcuni anni (qui i riferimenti in merito) ed è già stata discussa nella letteratura dedicata all’ozono.

Quindi cominciamo con la teoria di fondo. La chimica della stratosfera standard (vincitrice di un premio Nobel) collega la riduzione dello strato di ozono al crescente carico di cloro (Cl) nella stratosfera, che distrugge cataliticamente l’ozono e proviene dalla dissociazione per fotolisi dei cloro-fluoro-carburi (CFC) di origine umana, i cui valori sono alti in stratosfera. Nella notte polare, la presenza di PSC consente ad una specifica classe di reazioni eterogenee coinvolgenti Cl di verificarsi sulla superficie delle particelle di nube, cosa che risulta molto efficiente nella distruzione dell’ozono. Di qui si comprende come mai vi sia un buco di ozono nel vortice polare antartico, molto freddo. Poiché I PSC sono molto sensibili alla temperatura, il freddo vortice invernale spesso preannuncia una grande riduzione dello strato di ozono nella primavera successiva (si noti che la riduzione polare dello strato di ozono si verifica soltanto in presenza di radiazione solare, quindi è un fenomeno tipico della primavera in entrambi gli emisferi). Questa spiegazione non è messa in dubbio, a tutt’ora (beh, almeno dagli scienziati seri). Anche noi di RealClimate abbiamo usato questa relazione per prevedere (con successo) un evento di riduzione dello strato di ozono Artico particolarmente grande nel 2005.

La teoria del Dr. Lu presuppone un ulteriore meccanismo di rilascio di Cl dai CFC, attraverso l’effetto dei GCR. In particolare, Lu suggerisce che l’azione dei GCR sui CFC connessi ai PSC provochi un maggior rilascio di Cl, quindi immettendo potenzialmente più Cl proprio dove questo potrebbe causare in modo più efficace la riduzione polare dell’ozono. Le prove di questa asserzione provengono dalle correlazioni tra la perdita di ozono ed i GCR (su un paio di cicli solari) e da alcuni suggestivi esperimenti di laboratorio. Si noti che questo non mette in discussione la fonte di Cl di origine antropica, che proviene ancora dai CFC.